人体关键点检测1:人体姿势估计数据集

人体关键点检测1:人体姿势估计数据集

目录

1.人体姿态估计

人体关键点检测(Human Keypoints Detection)又称为人体姿态估计2D Pose,是计算机视觉中一个相对基础的任务,是人体动作识别、行为分析、人机交互等的前置任务。一般情况下可以将人体关键点检测细分为单人/多人关键点检测、2D/3D关键点检测,同时有算法在完成关键点检测之后还会进行关键点的跟踪,也被称为人体姿态跟踪。

本篇是人体关键点检测(人体姿势估计)项目系列文章之人体姿势估计数据集;主要介绍了COCO数据集和MPII数据集。

【尊重原创,转载请注明出处】https://blog.csdn.net/guyuealian/article/details/134703548

?更多项目《人体关键点检测(人体姿势估计)》系列文章请参考:

- 人体关键点检测1:人体姿势估计数据集(含下载链接)?https://blog.csdn.net/guyuealian/article/details/134703548

- 人体关键点检测2:Pytorch实现人体关键点检测(人体姿势估计)含训练代码和数据集?https://blog.csdn.net/guyuealian/article/details/134837816

- 人体关键点检测3:Android实现人体关键点检测(人体姿势估计)含源码 可实时检测?https://blog.csdn.net/guyuealian/article/details/134881797

- 人体关键点检测4:C/C++实现人体关键点检测(人体姿势估计)含源码 可实时检测?https://blog.csdn.net/guyuealian/article/details/134881797

- 手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)https://blog.csdn.net/guyuealian/article/details/133277630

- 手部关键点检测2:YOLOv5实现手部检测(含训练代码和数据集)https://blog.csdn.net/guyuealian/article/details/133279222

- 手部关键点检测3:Pytorch实现手部关键点检测(手部姿势估计)含训练代码和数据集https://blog.csdn.net/guyuealian/article/details/133277726

- 手部关键点检测4:Android实现手部关键点检测(手部姿势估计)含源码 可实时检测https://blog.csdn.net/guyuealian/article/details/133931698

- 手部关键点检测5:C++实现手部关键点检测(手部姿势估计)含源码 可实时检测https://blog.csdn.net/guyuealian/article/details/133277748

??

2.人体姿势估计数据集

(1)COCO数据集

下载地址:https://cocodataset.org/#download

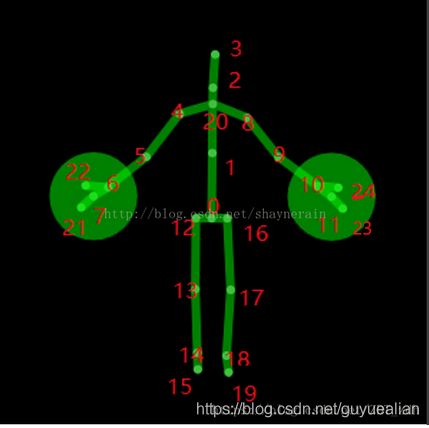

COCO人体关键点标注,最多标注全身的17个关键点,平均一幅图像2个人,最多有13个人;人体关键点标注,每个人体关键点个数的分布情况,其中11-15这个范围的人体是最多的,有接近70000人,6-10其次,超过40000人,后面依次为16-17,2-5,1.

COCO数据集比较大,还请耐心下载?

| 数据集 | 下载链接 |

|---|---|

| 2017 Train images? | http://images.cocodataset.org/zips/train2017.zip |

| 2017 Val images | http://images.cocodataset.org/zips/val2017.zip |

| 2017 Test images | http://images.cocodataset.org/zips/test2017.zip |

| 2017 Train/Val annotations? | http://images.cocodataset.org/annotations/annotations_trainval2017.zip |

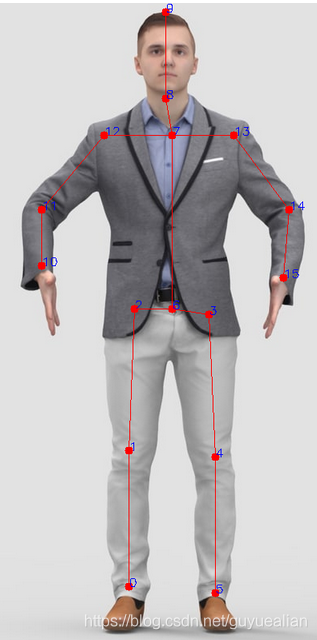

(2)MPII数据集

下载地址:http://human-pose.mpi-inf.mpg.de/#download

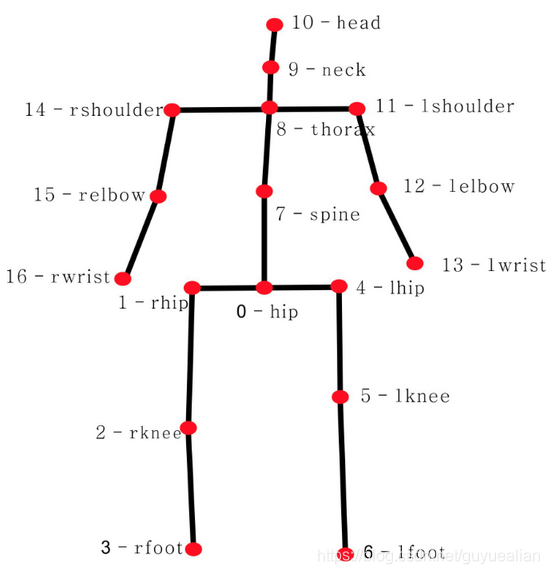

MPII人体关键点标注了全身16个关键点及其是否可见的信息,人数:train有28821,test有11701,有409种人类活动;使用mat的struct格式;行人框使用center和scale标注,人体尺度关于200像素高度,也就是除过了200。

(3)Human3.6M

下载地址:Human3.6M Dataset

Human3.6M?是一个用于 3D 人体位姿估计研究的大型公开数据集,在?paperswithcode?中可以看到在此数据集上提出的各种?SOTA?算法及模型,是目前基于多视图的 3D 人体位姿研究最为重要的一个数据集。

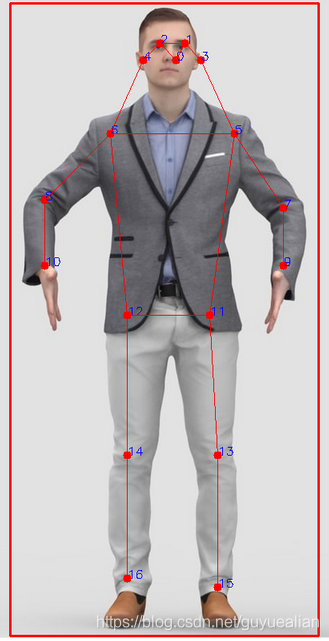

(4)关键点示意图

| 数据集 | 关键点示意图 | 关键点说明 |

| COCO |  | # 图像左右翻转时,成对的关键点(训练时用于数据增强) flip_pairs=[[1, 2], [3, 4], [5, 6], [7, 8],[9, 10], [11, 12], [13, 14], [15, 16]] # 关键点连接线序号(用于绘制图像) skeleton =[[15, 13], [13, 11], [16, 14], [14, 12], [11, 12], [5, 11], [6, 12], [5, 6], [5, 7], [6, 8], [7, 9], [8, 10], [0, 1], [0, 2], [1, 3], [2, 4]] # 每个关键点序号对应人体关键点的意义 "keypoints": { 0: "nose", 1: "left_eye", 2: "right_eye", 3: "left_ear", 4: "right_ear", 5: "left_shoulder", 6: "right_shoulder", 7: "left_elbow", 8: "right_elbow", 9: "left_wrist", 10: "right_wrist", 11: "left_hip", 12: "right_hip", 13: "left_knee", 14: "right_knee", 15: "left_ankle", 16: "right_ankle" } |

| MPII |  | # 图像左右翻转时,成对的关键点(训练时用于数据增强) # 关键点连接线序号(用于绘制图像) skeleton=[[0, 1], [1, 2], [3, 4], [4, 5], [2, 6], [6, 3], [12, 11], [7, 12], [11, 10], [13, 14], [14, 15], [8, 9], [8, 7], [6, 7], [7, 13]] # 每个关键点序号对应人体关键点的意义 |

| human3.6M |  | |

| kinect |  | |

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!