探索TVM:深度学习模型编译与部署的前沿与实践【文末送书-14】

文章目录

🚡前言

TVM是一个开源的机器学习编译器栈,旨在将深度学习模型部署到各种硬件设备上,包括CPU、GPU和各种加速器。它的工作原理和实践如下:

🚜工作原理:

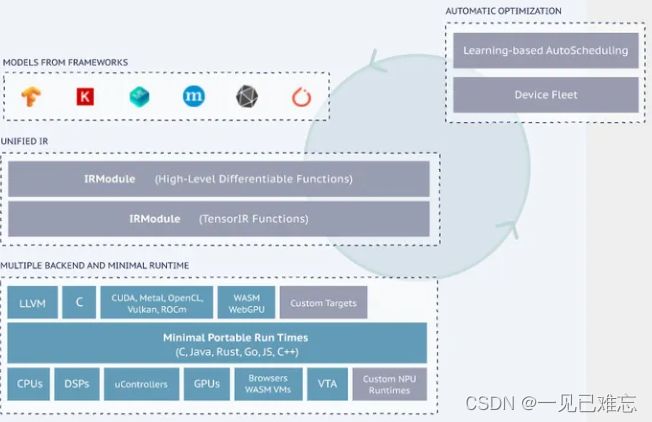

TVM采用模块化设计,将编译器分为前端、中端和后端三个部分。前端负责将深度学习模型从各种框架(如TensorFlow、PyTorch等)转换为TVM的中间表示(Intermediate Representation,IR),中端负责在中间表示上进行一系列的优化,如算子融合、减枝等,以减少计算量并提高运行速度,后端则负责将优化后的中间表示转换为针对特定硬件设备的低级代码。

TVM的独特之处在于它采用了图级别的优化和算子级别的优化相结合的方式。在图级别,TVM通过图变换对计算图进行优化,以减少冗余计算和内存访问;在算子级别,TVM通过对每个算子进行精细优化,充分利用硬件的计算能力。

TVM还采用了一种基于学习的成本建模方法,用于快速搜索和自动优化代码,以适应不同的硬件特性。这种方法通过学习硬件的运行时数据,自动识别出影响性能的关键因素,并针对性地进行优化。

🚗实践:

使用TVM进行模型部署的一般步骤如下:

模型载入:首先,使用TVM的接口将深度学习模型从各种框架载入到TVM中。

模型转换:然后,使用TVM的IR将模型转换为中间表示形式。在这个过程中,TVM会对模型进行一系列的图级别和算子级别的优化。

代码生成:接下来,TVM会根据不同的硬件后端生成对应的低级代码。这个过程包括对每个算子的精细优化和对整个计算图的调度优化。

部署:最后,生成的代码可以直接部署到各种硬件设备上,包括CPU、GPU和各种加速器。

TVM的实践优势在于它能够自动为大多数计算硬件生成可部署优化的代码,其性能可与当前最优的供应商提供的优化计算库相比。此外,TVM还支持多种深度学习框架和硬件后端,使得它能够方便地部署到各种不同的环境中。

总的来说,TVM是一个强大的深度学习编译器栈,它通过自动化的方式解决了深度学习模型在不同硬件设备上的部署问题,使得深度学习能够更容易地应用到各种实际场景中。

🌐拓展应用

虽然TVM在深度学习领域取得了显著的成功,但其实它的应用不仅限于此。以下是一些TVM在不同领域的拓展应用:

🏭工业自动化

在工业自动化领域,对实时性和低延迟的需求非常关键。TVM的自动化优化能力使得深度学习模型可以在工业控制系统中部署,提高生产效率和质量。通过将TVM集成到工业自动化流程中,可以实现对生产数据的实时分析和预测,从而更好地支持决策制定和生产优化。

🎮游戏开发

在游戏开发领域,对图形处理单元(GPU)和其他加速硬件的高效利用是关键挑战之一。TVM的图级别和算子级别优化能力使得它成为游戏开发人员的有力工具。通过将TVM整合到游戏引擎中,开发者可以更轻松地实现图形效果的实时渲染和复杂模型的快速加载。

🌐跨平台移植性

TVM的跨框架、跨硬件的特性使得它成为一个理想的跨平台移植工具。不论是在云端服务器还是边缘设备,不论是在深度学习框架的选择上,TVM都能够提供一致的、高效的部署解决方案。这种跨平台的移植性使得深度学习应用可以更加灵活地适应不同的计算环境。

🛠?开发者社区和生态系统

随着TVM的不断发展,一个庞大的开发者社区和生态系统正在形成。开发者们通过贡献优化算法、硬件后端支持以及整合其他开源项目,共同推动着TVM的发展。这个强大的社区为用户提供了更多选择和支持,使得TVM在不断演进的计算环境中保持了卓越的适应性。

在未来,TVM有望继续拓展其应用领域,为更多领域的开发者提供高效、灵活的深度学习模型部署解决方案。随着技术的进步和社区的壮大,TVM将在人工智能和计算领域发挥越来越重要的作用。

🌈未来展望

TVM作为一个开源、灵活且强大的深度学习编译器栈,未来有望迎来更广泛的应用和进一步的发展。以下是TVM未来可能的展望:

🚀支持更多硬件架构

随着硬件技术的不断演进,新的硬件架构不断涌现。TVM可以通过扩展其支持的硬件后端,使得它能够适配更多种类的处理器、加速器和其他硬件设备。这将使TVM在未来更好地适应不断变化的计算硬件环境,为用户提供更多的选择。

🌐深度学习模型融合

未来的深度学习应用往往需要同时部署多个模型,以完成更复杂的任务。TVM可以进一步优化支持模型融合和模型组合,使得在同一硬件设备上运行多个模型时更加高效。这有望提高系统整体性能,为用户提供更灵活的深度学习解决方案。

🛠?更智能的学习和优化

TVM当前采用基于学习的成本建模方法,未来有望进一步发展为更智能、自适应的学习和优化系统。通过深度学习技术的引入,TVM可以更好地理解不同硬件架构的特性,并在运行时动态调整优化策略。这将使得TVM能够更好地适应未来硬件的变化和创新。

🌍全球合作与标准化

随着深度学习在全球范围内的应用不断扩大,TVM有望参与到国际标准化的进程中,推动深度学习模型部署的统一标准。通过与业界、学术界和标准组织的合作,TVM可以为不同领域的开发者提供更加统一和互操作的解决方案,促进深度学习技术的全球推广。

🌱生态系统扩展

TVM的生态系统将继续扩大,吸引更多开发者和组织加入。这将带来更多的硬件支持、优化算法和工具集成,进一步提升TVM的性能和适应性。一个繁荣的生态系统将使得TVM成为深度学习领域的核心工具之一,推动整个生态系统的发展。

综合来看,TVM在未来有望通过持续的创新和开放合作,成为深度学习模型部署领域的领导者之一。其灵活性、性能和自适应性将为广大开发者提供强大的工具,促使深度学习技术更广泛地应用于各行各业。

🏈TVM编译器原理与实践【文末送书-14】

购书链接-京东:https://item.jd.com/13978563.html

适读人群 :从事AI算法,软件,AI芯片,编译器开发工程技术人员

人工智能(Artificial Intelligence,AI)已经在全世界信息产业中获得广泛应用。深度学习模型推动了AI技术革命,如 TensorFlow、PyTorch、MXNet、Caffe等。大多数现有的系统框架只针对小范围的服务器级 GPU进行过优化,因此需要做很多的优化努力,以便在汽车、手机端、物联网设备及专用加速器(FPGA、ASIC)等其他平台上部署。随着深度学习模型和硬件后端数量的增加,TVM构建了一种基于中间表示 (IR)的统一解决方案。TVM不仅能自动优化深度学习模型,还提供了跨平台的高效开源部署框架。大模型的热度逐渐上升,将人工智能理论及算法框架转为落地项目实现,TVM是一个很好的桥梁。因此,本书将得到广大读者的喜爱。

内容简介

TVM(Tensor Virtual Machine, 张量虚拟机)是一种开源的模型编译框架,旨在将机器学习模型自动编译成可供下层硬件执行的机器语言,从而利用多种类型的算力。其工作原理是,先将深度学习模型进行优化推理、内存管理与线程调度,再借用LLVM框架将模型部署在CPU、GPU、FPGA、ARM等硬件设备上。

本书全面解析TVM的主要功能,帮助读者理解TVM工作原理,以及使用 TVM对深度学习与机器学习进行优化与部署。

本书结合作者多年的工作与学习经验,力求将TVM基础理论与案例实践融合在一起进行详细讲解。全书共9章,包括TVM基本知识,使用TVM开发,算子融合与图优化,TVM量化技术,TVM 优化调度,Relay IR,代码生成,后端部署与OpenCL(Open Computing Language,开放运算语言),自动调度、自动搜索与成本模型。各章除了包含重要的知识点和实践技能外,还配备了精心挑选的典型案例。

本书适合从事AI算法、软件、编译器开发以及硬件开发等专业的工程技术人员、科研工作人员、技术管理人员阅读,也可以作为编译器相关专业高校师生的参考用书。

作者简介

吴建明,上海交通大学模式识别与智能系统专业博士毕业。长期从事人工智能芯片设计,尤其擅长TVM/LLVM编译器、AI框架、自动驾驶、芯片制造,嵌入式系统等领域的理论研究与技术创新。长期在一线工作,包括产品设计与代码实现等,主持和参与过30多项产品的研发。还参与过国家自然科学基金、上海市科委项目,并在核心期刊公开发表过8篇论文,其中6篇是第一作者。

前言/序言

人工智能(Artificial Intelligence,AI)已经在全世界信息产业中获得广泛应用。深度学习模型推动了AI技术革命,如 TensorFlow、PyTorch、MXNet、Caffe等。大多数现有的系统框架只针对小范围的服务器级 GPU进行过优化,因此需要做很多的优化努力,以便在汽车、手机端、物联网设备及专用加速器(FPGA、ASIC)等其他平台上部署。随着深度学习模型和硬件后端数量的增加,TVM构建了一种基于中间表示 (IR)的统一解决方案。TVM不仅能自动优化深度学习模型,还提供了跨平台的高效开源部署框架。

有了TVM的帮助,只需要很少的定制工作,就可以轻松地在手机、嵌入式设备甚至浏览器上运行深度学习模型。TVM 还为多种硬件平台上的深度学习计算提供了统一的优化框架,包括一些有自主研发计算原语的专用加速器。TVM是一个深度学习编译器,所有人都能随时随地使用开源框架学习研发。围绕TVM形成了多元化社区,社区成员包括硬件供应商、编译器工程师和机器学习研究人员等,共同构建了一个统一的可编程软件堆栈,丰富了整个机器学习技术生态系统。

TVM是一个新型的AI编译器,广泛应用于各种产品研发中,在企业与学术研究中有很大的影响。但是,目前市面上有关TVM的书还很少,本书试图弥补这个空缺。全书的特点总结如下:

第一,从TVM的概念入手,分析了TVM的基本原理和关键支撑技术。

第二,从TVM的环境搭建到案例实践逐步展开,分析如何使用TVM进行实战开发。

第三,介绍了TVM的重要关键技术,如算子与图融合、量化技术、Relay IR(中间表示)、优化调度、编译部署等,分析了这些模块的理论与案例实践。

第四,TVM对后端相关的技术进行了分析与实践,包括代码生成、自动调度、自动搜索与成本模型等。

本书的写作过程中,得到了家人的全力支持,在此,对他们表示深深的感谢。也感谢机械工业出版社的编辑们,因为有他们的辛勤劳作和付出,本书才得以顺利出版。由于编者技术能力有限,书中难免存在纰漏,还望广大读者不吝赐教。

?粉丝福利:文末推荐与福利免费包邮送书!

?参与方式:必须关注博主、点赞。(采取随机算法程序在满足关注、点赞的用户中随机抽取~)【评论不做硬性要求,但评论会增加获奖权重哦!】

??本次送书1~3本【取决于阅读量,阅读量越多,送的越多】

📆 活动截止时间:2024-1-10 21:00:00 | 由博主公布抽奖结果

送书名单:

待更新

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!