Spark与Hive的集成与互操作

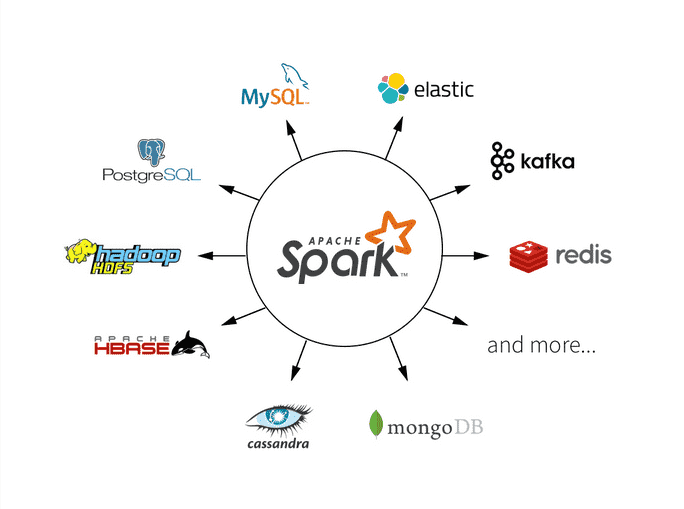

Apache Spark和Apache Hive是大数据领域中两个非常流行的工具,用于数据处理和分析。Spark提供了强大的分布式计算能力,而Hive是一个用于查询和管理大规模数据的数据仓库工具。本文将深入探讨如何在Spark中集成和与Hive进行互操作,以充分利用它们的强大功能。

Spark与Hive的基本概念

在深入了解集成和互操作之前,首先了解一下Spark和Hive的基本概念。

-

Apache Spark:Spark是一个快速、通用的分布式计算引擎,具有内存计算能力。它提供了高级API,用于大规模数据处理、机器学习、图形处理等任务。Spark的核心概念包括弹性分布式数据集(RDD)、DataFrame和Dataset等。

-

Apache Hive:Hive是一个基于Hadoop的数据仓库工具,它提供了类似SQL的查询语言(Hive SQL)来查询和管理大规模数据。Hive将数据存储在HDFS上,并通过元数据存储在元数据库中。它还支持用户自定义函数(UDF)和用户自定义聚合函数(UDAF)等扩展功能。

集成Spark与Hive

集成Spark与Hive允许您在Spark应用程序中使用Hive表,以及在Hive中查询Spark生成的数据。以下是一些常见的集成方法:

1. 使用Hive数据仓库

Spark可以通过Hive访问存储在Hive数据仓库中的数据。要实现这种集成,首先需要在Spark应用程序中配置Hive支持:

from pyspark.sql import SparkSession

# 创建Spark会话并启用Hive支持

spark = SparkSession.builder.appName("SparkHiveIntegration").config("spark.sql.warehouse.dir", "/user/hive/warehouse").enableHiveSupport().getOrCreate()

上述代码创建了一个Spark会话,并启用了Hive支持。需要注意的是,需要设置正确的Hive仓库目录。

2. 使用Hive表

一旦启用了Hive支持,就可以在Spark应用程序中使用Hive表。假设在Hive中有一个表mytable,可以使用以下方式在Spark中使用它:

# 在Spark中使用Hive表

df = spark.sql("SELECT * FROM mytable")

df.show()

这样,就可以在Spark中查询并处理Hive表中的数据。

3. 将Spark数据保存到Hive表

还可以将Spark生成的数据保存到Hive表中。假设有一个Spark DataFrame df,可以使用以下方式将其保存到Hive表中:

# 将Spark DataFrame 保存到Hive表

df.write.saveAsTable("mytable")

这将会创建一个名为mytable的Hive表,并将DataFrame的数据存储在其中。

Hive UDF与Spark

在Spark中,可以使用Hive用户自定义函数(UDF)来扩展Spark的功能。要使用Hive UDF,首先需要注册它们,然后可以在Spark SQL查询中使用它们。

以下是一个示例:

# 注册Hive UDF

spark.sql("CREATE TEMPORARY FUNCTION myudf AS 'com.example.MyUDF'")

# 在Spark SQL查询中使用Hive UDF

result = spark.sql("SELECT myudf(column) FROM mytable")

这里,首先注册了一个名为myudf的Hive UDF,然后在Spark SQL查询中使用它来处理数据。

性能优化

在集成和互操作时,性能是一个重要的考虑因素。以下是一些性能优化的建议:

-

避免数据移动:尽量避免在Spark和Hive之间频繁移动数据,可以通过将数据存储在共享文件系统上来实现。

-

使用分区表:在Hive中使用分区表可以显著提高查询性能,同时在Spark中也可以利用分区信息来进行查询优化。

-

使用合适的数据格式:选择合适的数据存储格式,如Parquet或ORC,可以提高数据读取和查询性能。

-

调整资源配置:根据工作负载的需求,调整Spark和Hive的资源配置,以确保合理的性能。

示例代码:在Spark中使用Hive表

以下是一个示例代码片段,演示了如何在Spark中使用Hive表:

from pyspark.sql import SparkSession

# 创建Spark会话并启用Hive支持

spark = SparkSession.builder.appName("SparkHiveIntegration").config("spark.sql.warehouse.dir", "/user/hive/warehouse").enableHiveSupport().getOrCreate()

# 在Spark中使用Hive表

df = spark.sql("SELECT * FROM mytable")

df.show()

在这个示例中,首先创建了一个启用了Hive支持的Spark会话,然后在Spark中查询并显示了名为mytable的Hive表中的数据。

总结

Apache Spark和Apache Hive是强大的大数据工具,通过它们的集成和互操作,可以更好地处理和分析大规模数据。本文介绍了如何在Spark中集成和与Hive进行互操作,包括使用Hive数据仓库、使用Hive表、将Spark数据保存到Hive表、使用Hive UDF以及性能优化的建议。希望本文能够帮助大家更好地利用这两个工具来处理和分析数据。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!