翻译: LLMs关于人工智能的担忧 Concerns about AI

在短时间内,获取生成人工智能的能力已经在全球范围内传播,使许多人能够生成高质量的文章、图片和音频。随着这些惊人的能力的出现,也带来了许多关于人工智能的担忧。我认为即使在生成人工智能兴起之前,我们就已经生活在许多焦虑之中。对环境的担忧,对权威的合法性、无能为力的担忧,对社会公平对待人们的能力的担忧,甚至对我们所有人的未来是什么样的担忧。作为一种非常强大的技术,人工智能继承了很大一部分这种焦虑。在这个视频中,让我们看看一些特别与人工智能相关的焦虑和担忧。

关于人工智能的一个广泛担忧是它是否可能放大人类最糟糕的冲动。LLM(大型语言模型)是在互联网文本上训练的,这反映了人类最好的品质,但也反映了我们最糟糕的一些品质,包括我们的偏见、仇恨和误解。LLM也学会了这些负面品质。那么它会放大我们最糟糕的冲动吗?在第一周,我们已经看到了一个例子,即LLM在判断外科医生或护士更可能是男性还是女性时表现出的性别偏见。再举一个可能稍微简单一些的例子,如果你在最初训练后要求一个LLM填写空白,空白是一个CEO,许多模型会倾向于选择“男人”这个词。

当然,这是一种社会偏见,扭曲了所有性别的人都可以成功领导公司的事实。互联网上的文本代表了我们的现在和过去。因此,LLM从这些数据中学习,反映了我们过去和现在的一些偏见,也许并不令人惊讶。但也许我们希望LLM代表一个更公平、更少偏见、更公正的充满希望的未来,而不仅仅是我们过去的数据。幸运的是,通过微调,LLM正在变得不那么有偏见,我们在第二周讨论过这一点。以及更高级的技术,如基于人类反馈的强化学习 Reinforcement learning from human feedback(RLHF)。

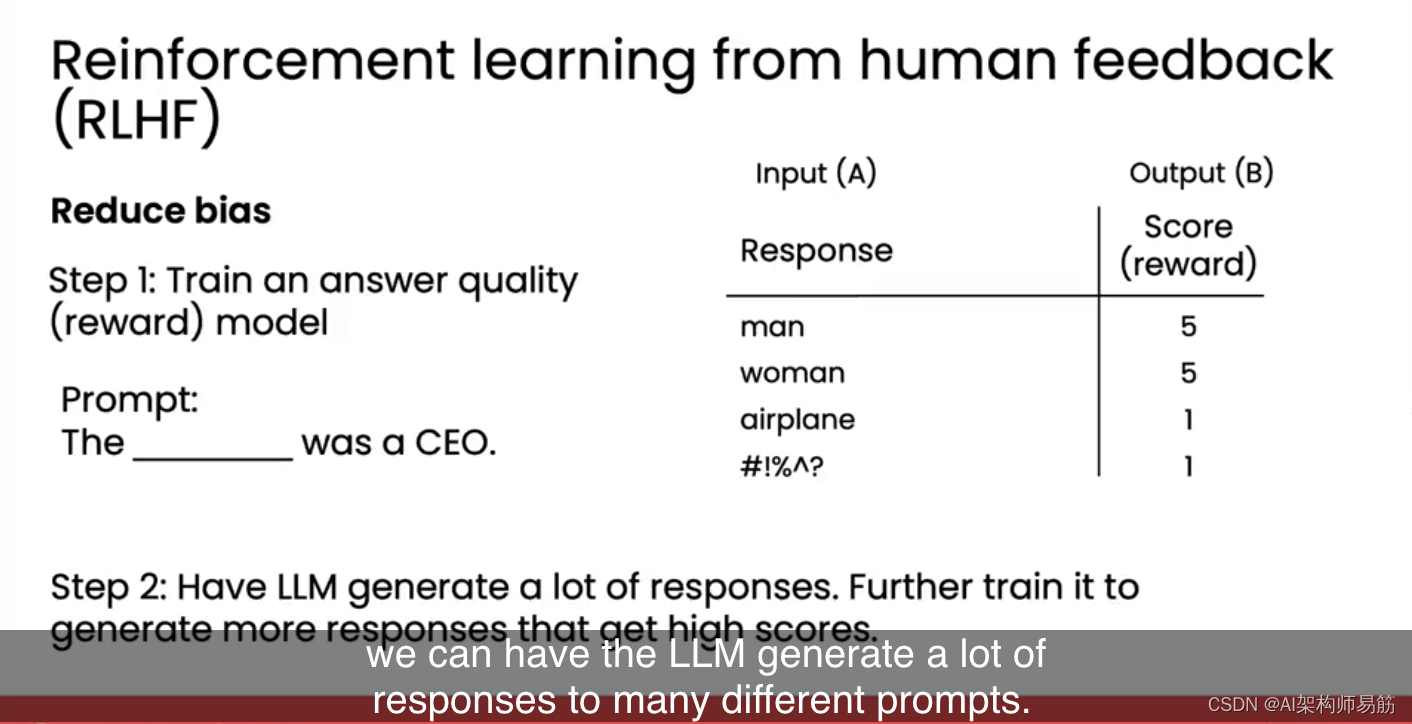

第二周有一个关于RLHF的可选视频。无论您是否观看了那个视频,我想简要描述RLHF如何帮助使LLM变得不那么有偏见。RLHF是一种训练LLM生成与人类偏好更一致的回答的技术。RLHF的第一步是训练一个称为奖励模型的答案质量模型,该模型可以自动评分回答。因此,在RLHF的这一步中,我们会用许多类似的查询提示LLM,例如“空白是一个CEO”,并收集LLM的不同回答。然后我们会请人类对这些答案进行评分。所以在一到五的评分尺度上,我们会给像“男人”或“女人”这样的高度可取答案一个高分,而给像“飞机”这样的无意义答案一个低分。任何包含性别偏见或种族偏见,或包含性别或种族侮辱的答案都会得到非常低的分数。

使用提示、回答和人类分配的分数作为数据,我们会使用监督学习来训练一个可以输入回答并对其评分的奖励模型。我们这样做是因为请人类评分回答是昂贵的。但一旦监督学习算法学会了自动评分回答,我们就可以自动且便宜地评分大量回答。最后,现在LLM有了一个学会的奖励模型来评分它想要的任何回答,我们可以让LLM对许多不同的提示生成大量回答。并让它进一步训练自己生成得到高分的更多回答,因此,反映出人类认为更可取的答案。

RLHF已被证明可以使LLM在性别、种族、宗教和其他人类特征方面展示出的偏见大大减少。它使LLM不太可能传播有害信息,也使其对人们更加尊重和充满希望。今天,LLM的输出已经比互联网上的平均文本更安全、更少偏见。但像这样的技术正在继续改进,因此LLM放大人类最糟糕品质的程度正在继续减少,因为它们正在更好地与未来保持一致。我认为我们都希望LLM反映出一个更公平、更少偏见、更公正的世界。

第二个主要担忧是,当人工智能能比任何人更快更便宜地完成我们的工作时,我们中谁能维持生计?人工智能会让我们许多人失业吗?为了了解这是否可能发生,让我们看看放射学。2016年,很多年前,深度学习的先驱、我的朋友杰夫·辛顿(Geoff Hinton)说,人工智能在分析X射线图像方面变得如此出色,以至于在五年内,它可能会取代放射科医师的工作。他做了这样惊人的声明:如果你是一名放射科医师,你就像已经越过悬崖边缘的土狼,但还没有向下看。所以还没有意识到他们脚下没有地面。现在应该停止培训放射科医师。

很明显,在五年内,深度学习将比放射科医师做得更好。但我们现在已经过了这个声明五年多,人工智能远未取代放射科医师。我所有的放射科医师朋友中,没有一个人因为人工智能失去了工作。

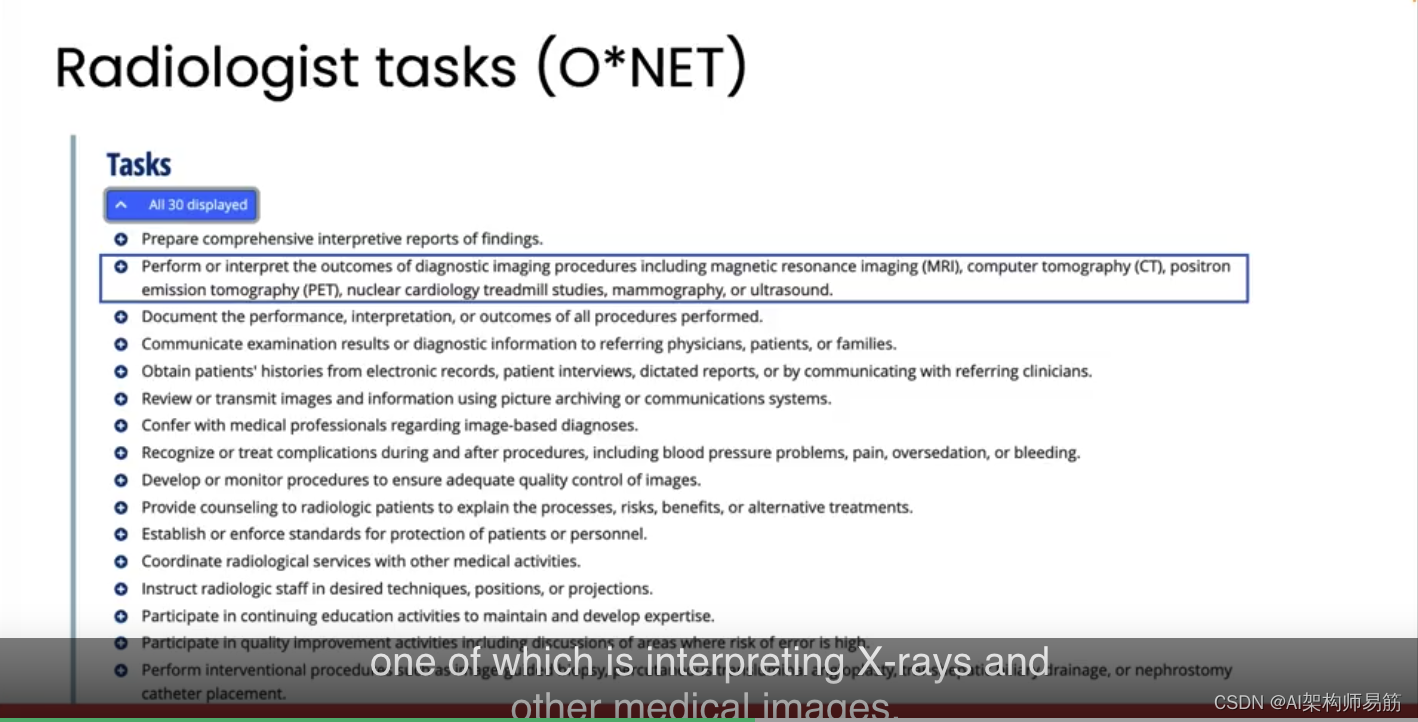

为什么会这样?两个原因。首先,解释X射线证明比当时看起来更困难,尽管我们正在取得快速进展。但更重要的是,放射科医师的工作远不止解释X射线图像。根据O*NET的数据,放射科医师有大约30种不同的任务,其中之一是解释X射线和其他医学图像,但他们还做许多其他任务。

到目前为止,人工智能很难在人类水平上完成所有这些任务。

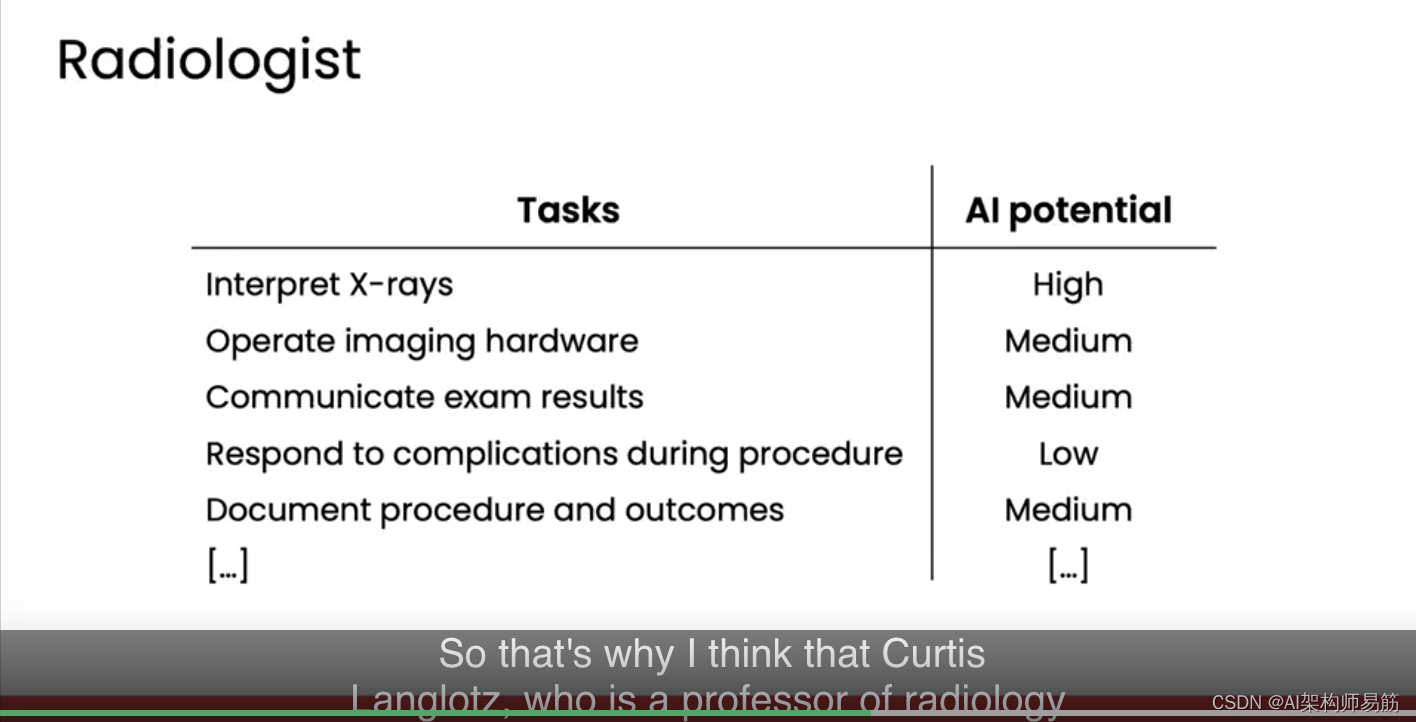

除了解释X射线,放射科医师还执行其他一些任务,包括操作成像硬件、与患者或其他利益相关者沟通检查结果。在程序中应对并发症,例如如果患者在成像过程中发生恐慌。他们记录程序和结果,以及许多其他任务。我认为人工智能确实有很高的潜力来增强或协助解释X射线。在技术上,这主要是通过监督学习而不是生成人工智能来完成的。

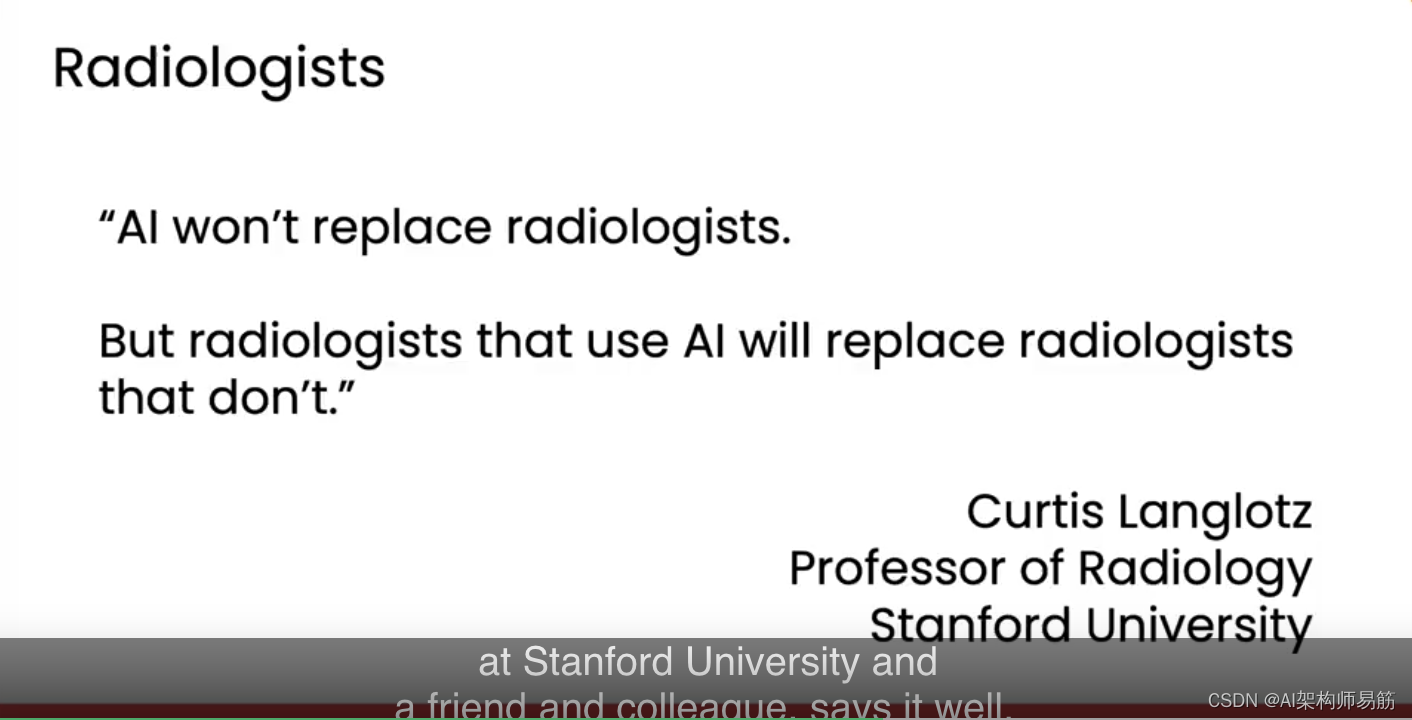

但要让人工智能完全自动化所有这些任务仍然遥远。这就是为什么我认为斯坦福大学放射科教授、我的朋友和同事库尔蒂斯·朗洛茨(Curtis Langlotz)说得很好。他说,人工智能不会取代放射科医师,但使用人工智能的放射科医师将取代不使用人工智能的放射科医师。我认为我们将在许多其他职业中看到这种效应。

请注意,我并不是要减少帮助许多人采用人工智能的挑战,或者那些工作将消失的少数人的苦难。或者我们确保受影响的人们有安全网和学习新技能的机会的责任。但从蒸汽机到底盘再到电脑,每一波技术都创造了远比它摧毁的更多的工作。正如我本周早些时候提到的,在大多数创新浪潮中,企业最终专注于增长,这是无限潜力的,而不是成本节约。所以人工智能将带来巨大的增长,并在这个过程中创造许多新的工作。

这就引出了可能是最大的焦虑:人工智能会杀死我们所有人吗?我们知道人工智能可能会失控。

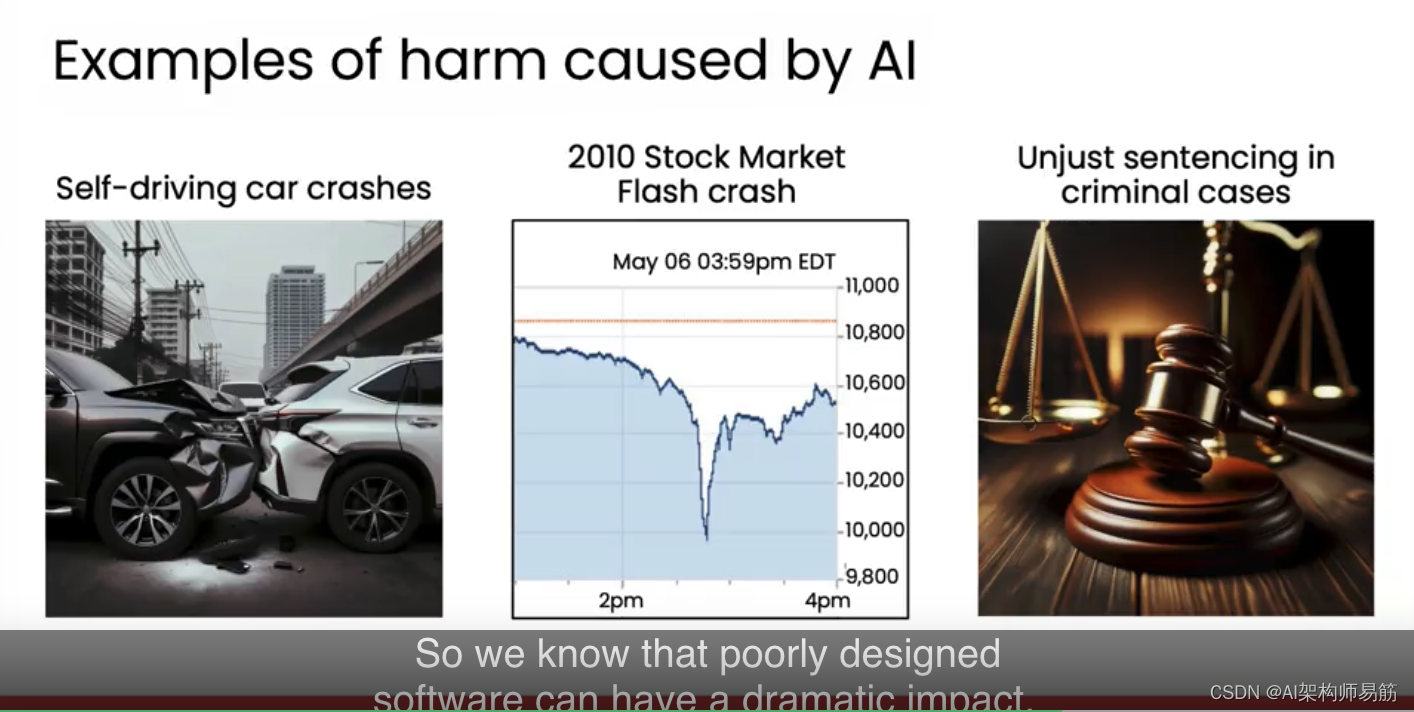

自动驾驶汽车已经发生了撞车事故,导致悲剧性的生命损失。2010年,一个自动交易算法导致了股市崩盘。在司法系统中,人工智能导致了不公平的判决决定。所以我们知道设计不良的软件会有巨大的影响。但它能导致人类灭绝吗?我看不出来。我知道对此有不同的看法,但最近,我寻找了一些对这个问题感到担忧的人,并与我认识的一些最聪明的人工智能人士进行了交谈。

有些人担心坏人使用人工智能来摧毁人类,比如通过创建生物武器。其他人则担心人工智能无意中导致人类灭绝。类似于人类如何通过简单地没有意识到我们的行为可能导致这种结果,从而使许多其他物种灭绝。我试图评估这些论点的现实性,但我发现它们不具体,也不具体说明人工智能如何导致人类灭绝。大多数论点归结为它可能发生。有些人会补充说,这是一种新型技术,所以这次可能会有所不同。但这种说法适用于人类发明的每一种新型技术。而证明人工智能不会导致人类灭绝就像证明一个否定命题一样。我无法证明人工智能超级智能不会消灭人类,但似乎没有人确切知道它如何做到。

但我确实知道这一点,人类有充分的经验控制比任何单个人更强大的许多事物,如公司和国家。还有许多我们无法完全控制但仍然有价值和安全的事物。例如,飞机,直到今天,我们仍然无法完全控制,因为风和湍流会把飞机推来推去,或者飞行员可能犯错。在航空早期,飞机杀死了许多人。但我们从这些经验中学到了东西,制造了更安全的飞机,并且设计了更好的操作规则。如今,许多人可以走进飞机而不用担心自己的生命。

对于人工智能来说,我们正在学习更好地控制它,它每天都变得更安全。最后,如果我们看看对人类真正的风险,例如气候变化导致地球部分地区大规模减少人口,或者希望不会是下一次大流行。甚至更低的可能性,但另一个小行星撞击地球,像恐龙一样消灭我们。我认为人工智能将是我们应对这些挑战的关键部分。

所以我知道目前对此有不同的看法。但我的观点是,如果我们想让人类在未来一千年内生存并繁荣,人工智能会增加我们成功到达那里的几率。

计算机在某些狭窄的维度上已经比任何人更聪明。但人工智能的改进速度如此之快,以至于许多人很难准确预测几年后它会是什么样子。我认为这些担忧的根本原因,包括灭绝风险,是许多人不确定人工智能何时会达到人工通用智能(AGI),即能够执行任何人类能做的智力任务的人工智能。让我们在下一个视频中更深入地了解AGI。

参考

https://www.coursera.org/learn/generative-ai-for-everyone/lecture/BD3mt/concerns-about-ai

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!