P40Recurrent Neural Network

2023-12-18 18:50:02

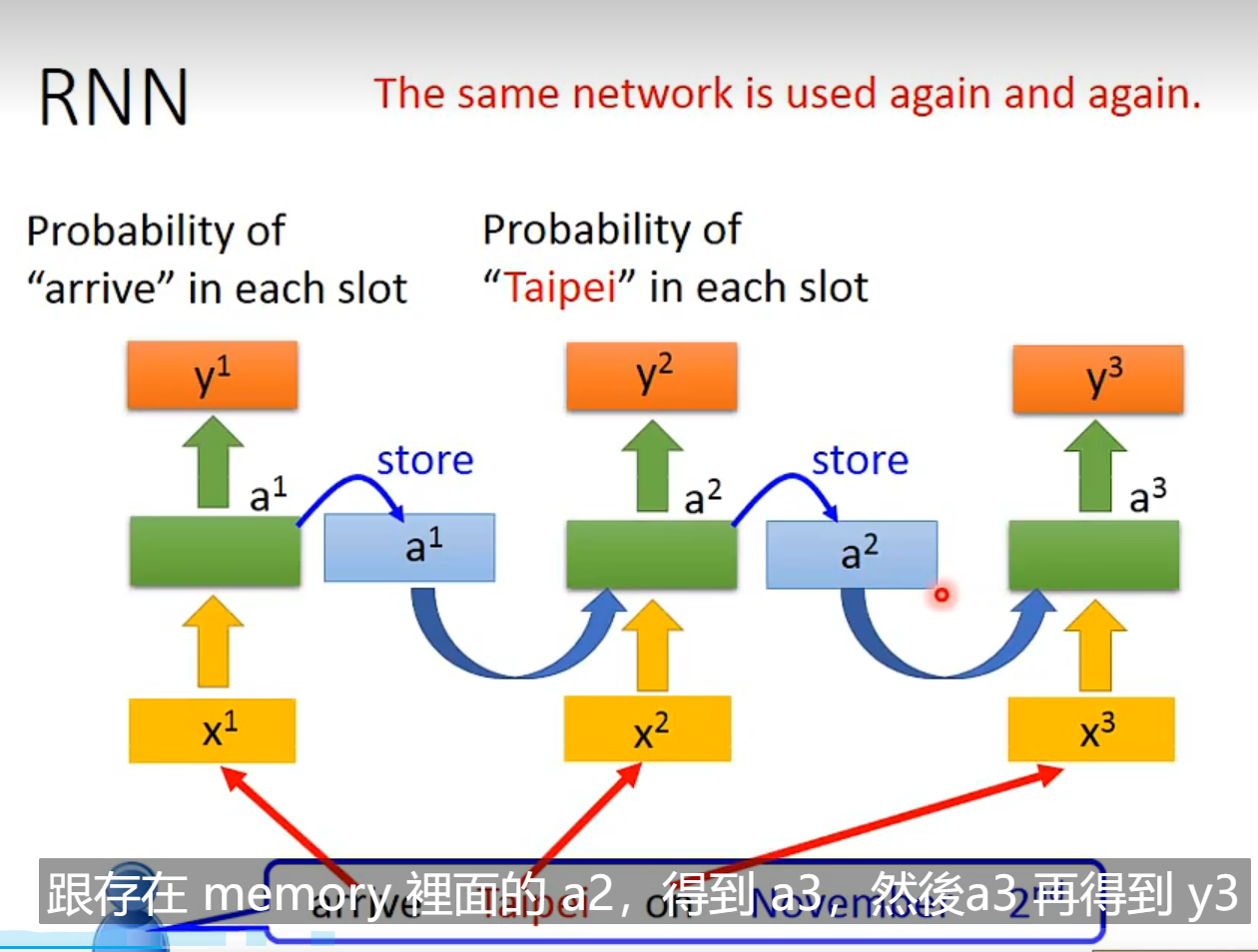

- 将之前的输出存在memory 中,在下一轮输入网络中

# 将之前的输出存在memory 中,在下一轮输入网络中

# 将之前的输出存在memory 中,在下一轮输入网络中

the same network is used again and again

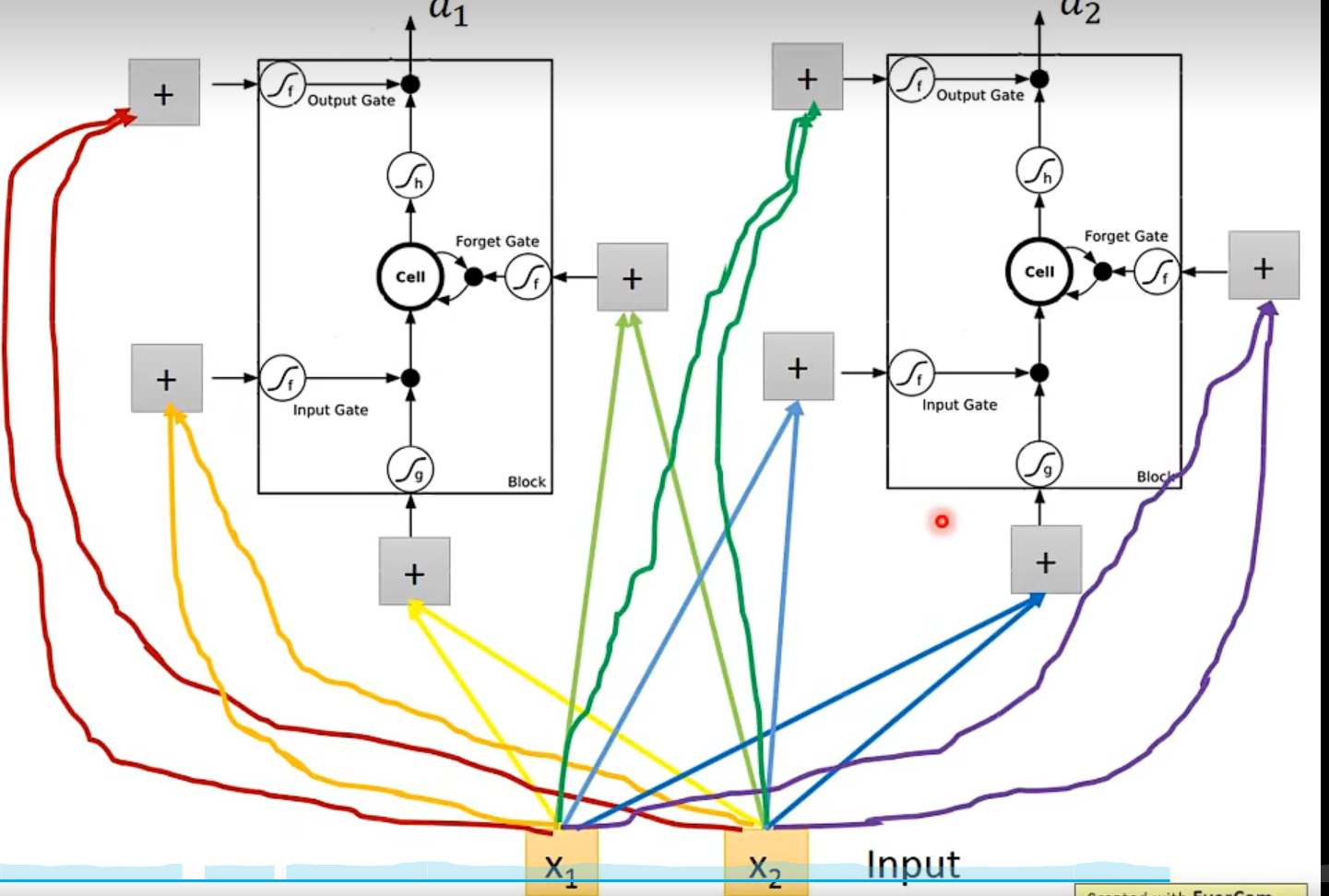

deep RNN

rnn 的变形

-

- 隐藏层的输出作为下一个时间点的输入

-

- 上一个时间点的输出作为下一个时间点的输入

- 传说后者效果更好

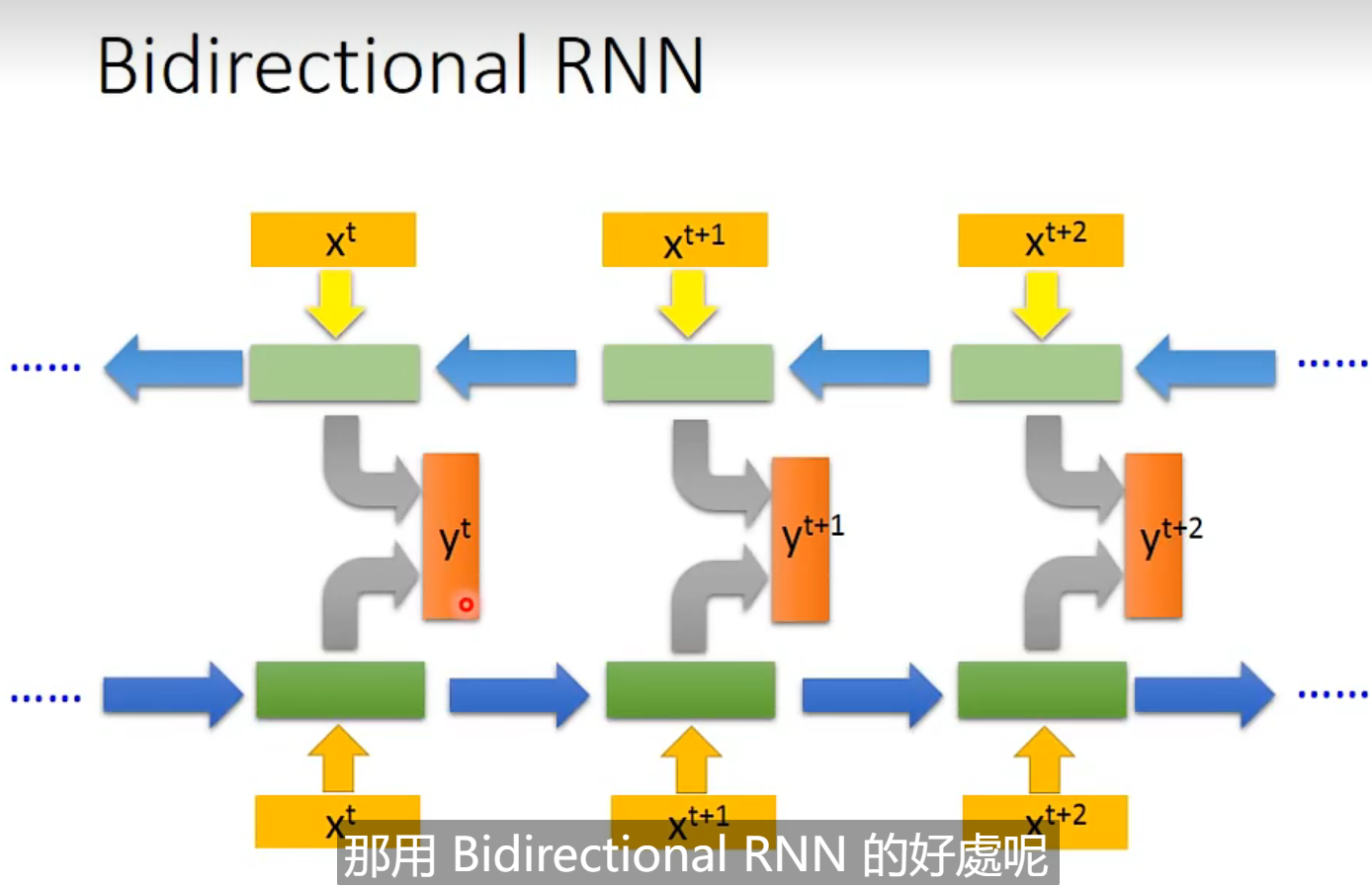

双向RNN

正向和反向的输出结果,都扔到输出层

好处: 比单向的看的范围看的更广

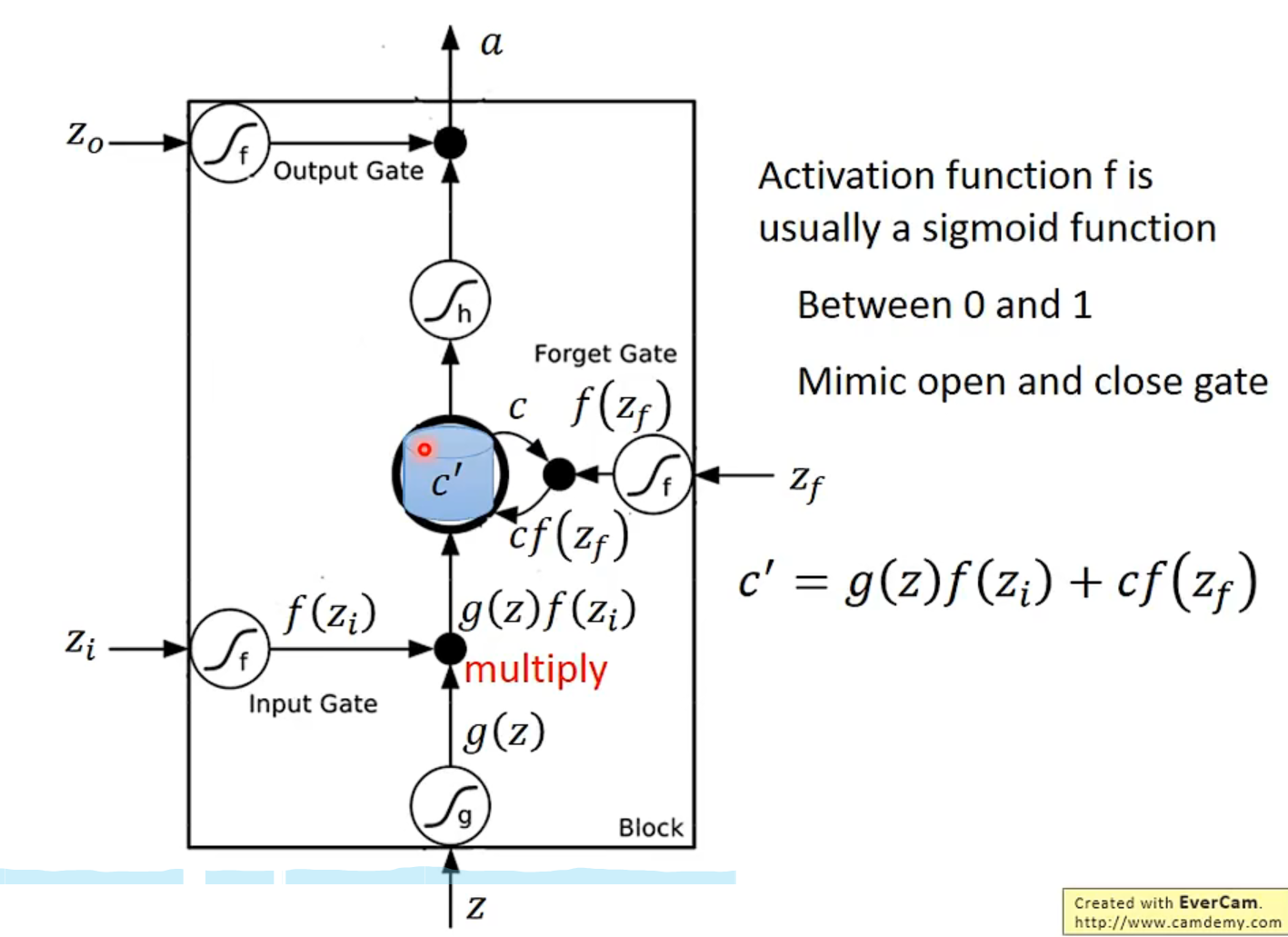

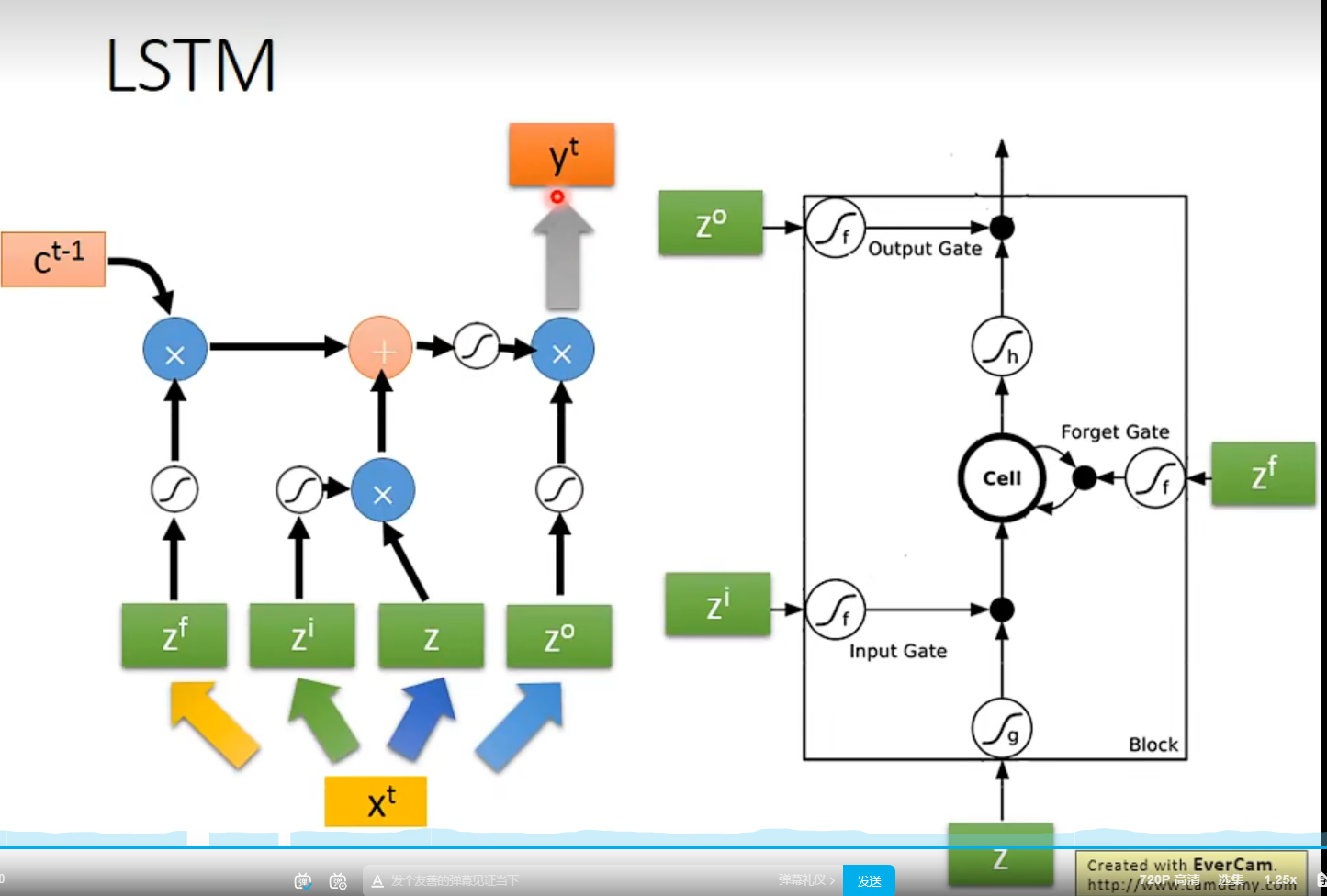

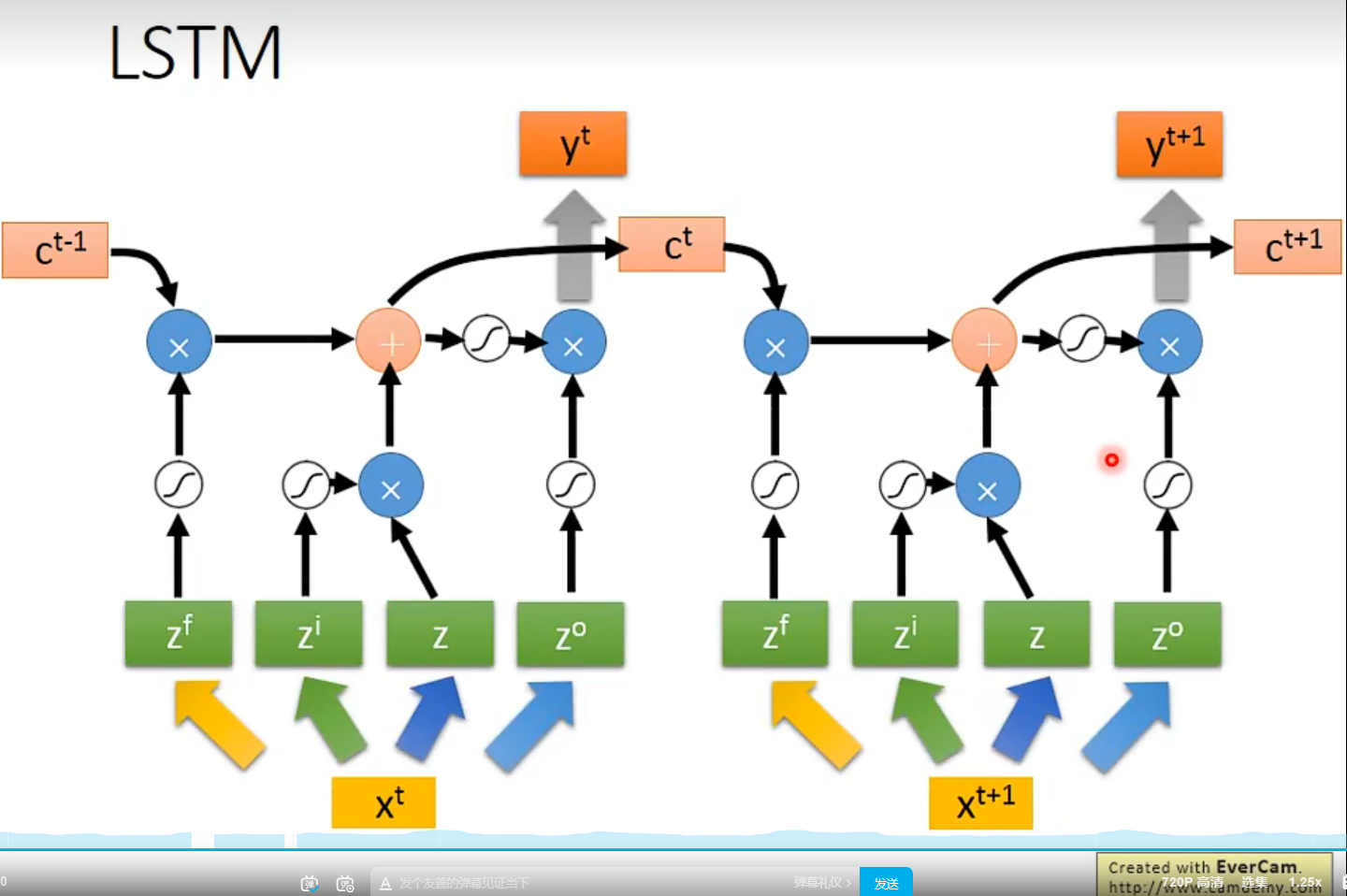

LSTM LONG SHORT-TERM Memory

input gate 控制输入是否能够传递进去,当 input gate 为0时, f*g 为零,没有能够输入进去

forget gate 是相反的,为0时代表遗忘,为1时代表能够通过

- 数据一直累计记录在 c’ memory 中

- output gate=1 时,存在memory 中的值会被输出

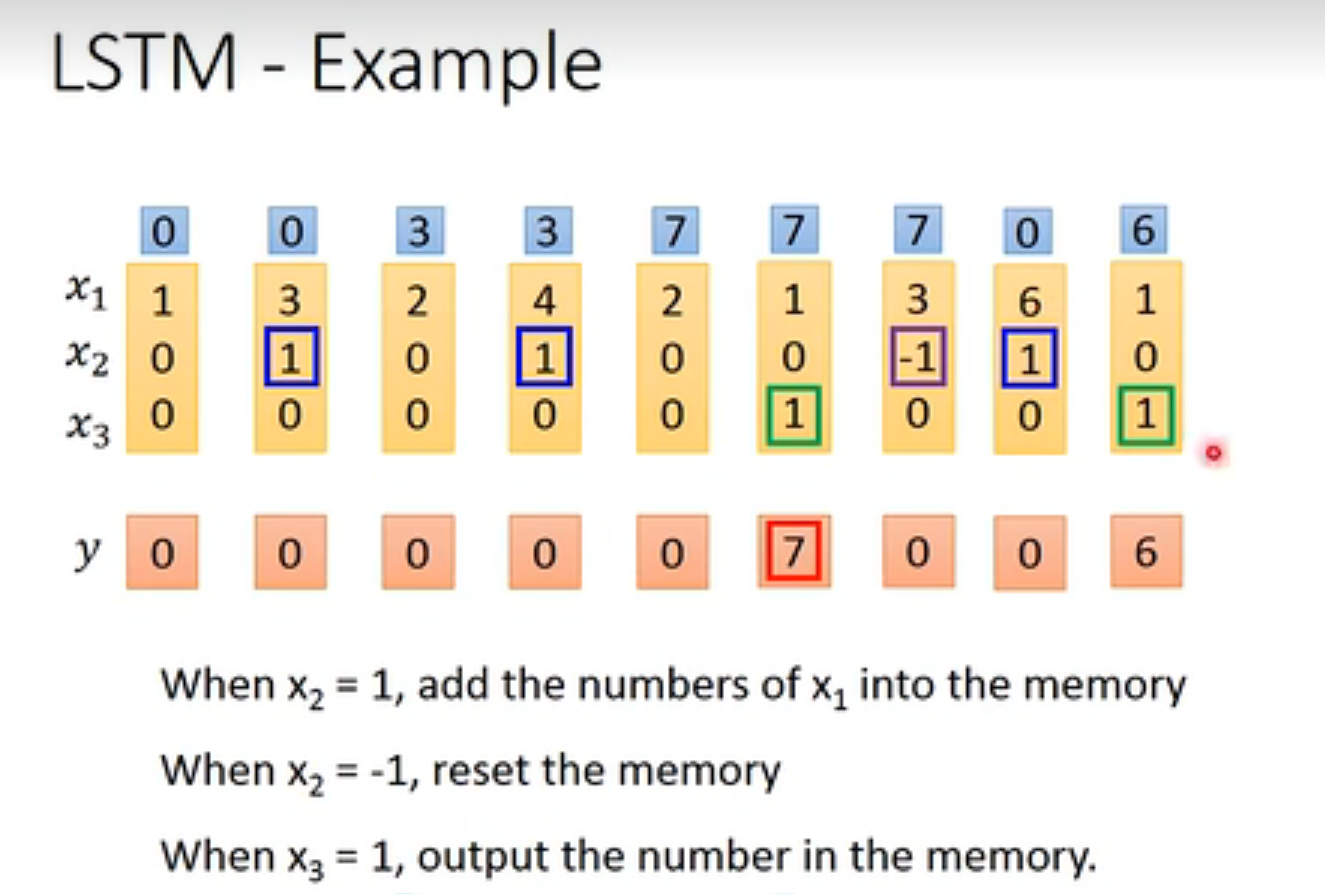

LSTM example

输入:3维

输出:1维

4个input 和1个output

输入*weight = 各个gate输入值

c 代表memory 中的值

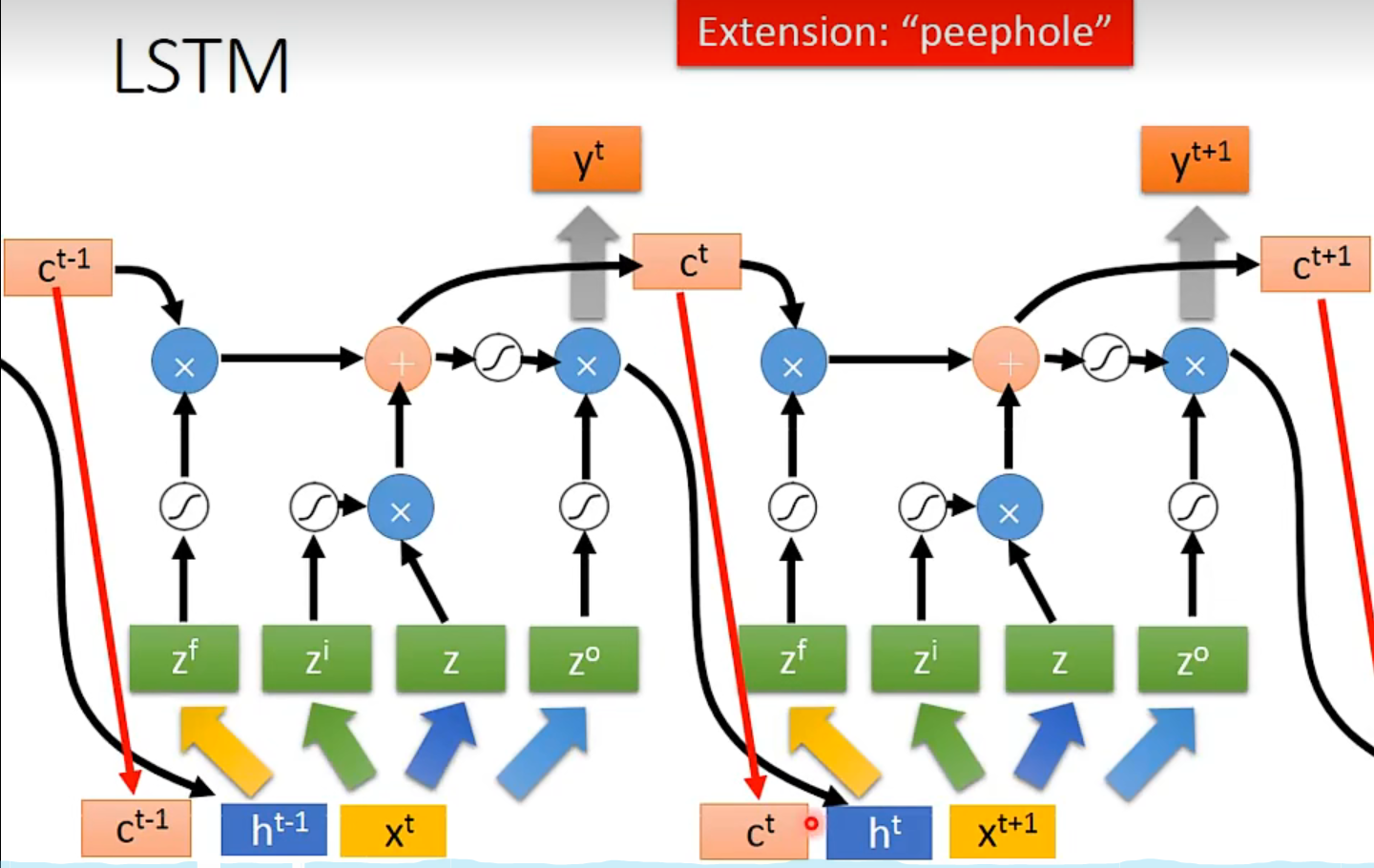

终极形态:

输入同时考虑 c h x

文章来源:https://blog.csdn.net/weixin_39107270/article/details/135065605

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!