某查查请求头参数加密分析(含JS加密算法与Python爬虫源码)

【作者主页】:吴秋霖

【作者介绍】:Python领域优质创作者、阿里云博客专家、华为云享专家。长期致力于Python与爬虫领域研究与开发工作!

【作者推荐】:对JS逆向感兴趣的朋友可以关注《爬虫JS逆向实战》,对分布式爬虫平台感兴趣的朋友可以关注《分布式爬虫平台搭建与开发实战》

还有未来会持续更新的验证码突防、APP逆向、Python领域等一系列文章

1. 写在前面

??先前写过一篇关于APP端自动化方案的文章,对于基础数据获取的话相对还是比较稳定的,当时单台设备测试一天数据量在1W+,单账号未被风控!感兴趣的可以移步阅读:使用Python爬取某查查APP端(Appium自动化篇)

如果除了基础数据想要获取更多类型的数据(风险信息、知识产权、法律诉讼…)可以直接从Web端入手,请求头参数加密!Web的话主要还是对账号的全方面风控策略~

2. 请求分析

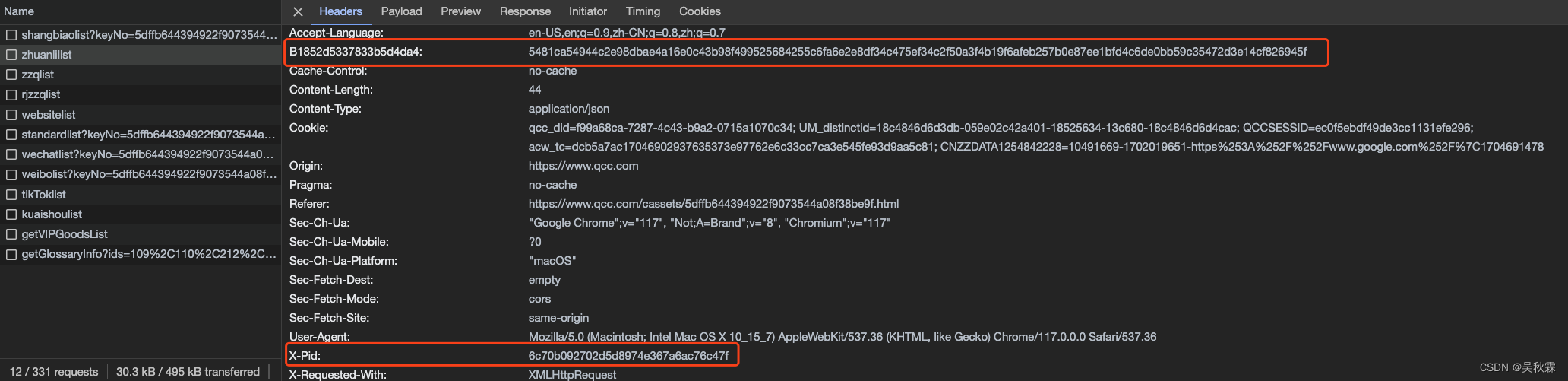

抓包分析,大部分需要VIP权限,所以我这里找了一个非VIP数据项查看的接口(经营风险信息)。请求可以看到在Headers里面有两个参数是密文,如下所示:

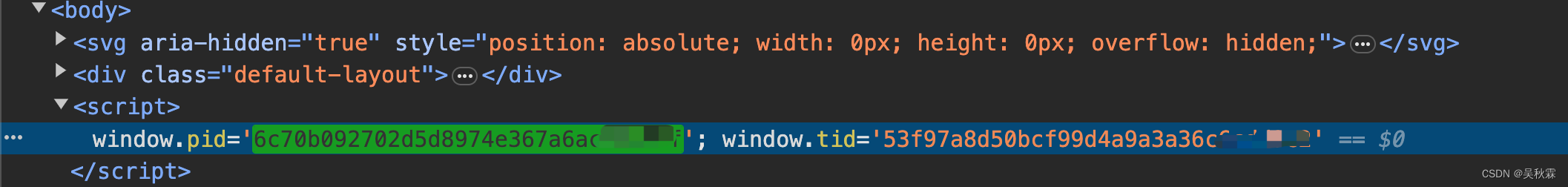

X-Pid参数的值在网页源代码即可获取,无需分析,如下所示:

3. 断点分析

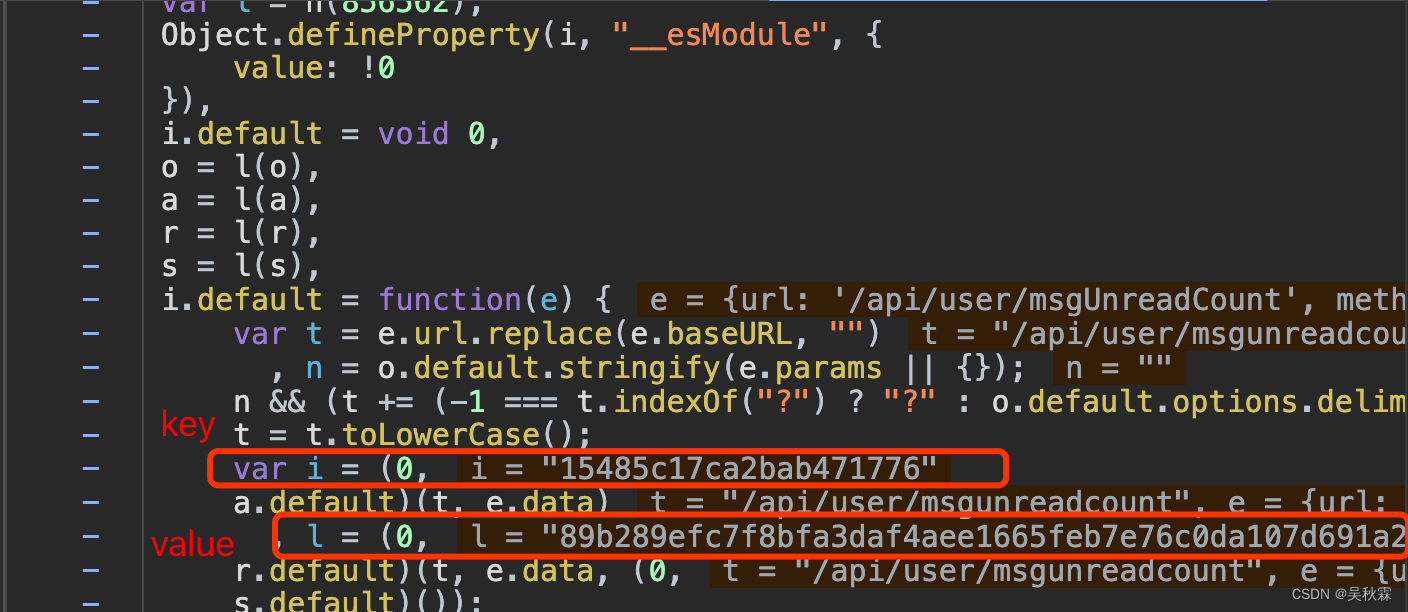

分析另一个加密参数,是一个键值对的数据,Key跟Value都是密文,这里通过XHR跟堆栈以及全距搜索的方式都可以定位到Headers处理部分的JS代码,如下所示:

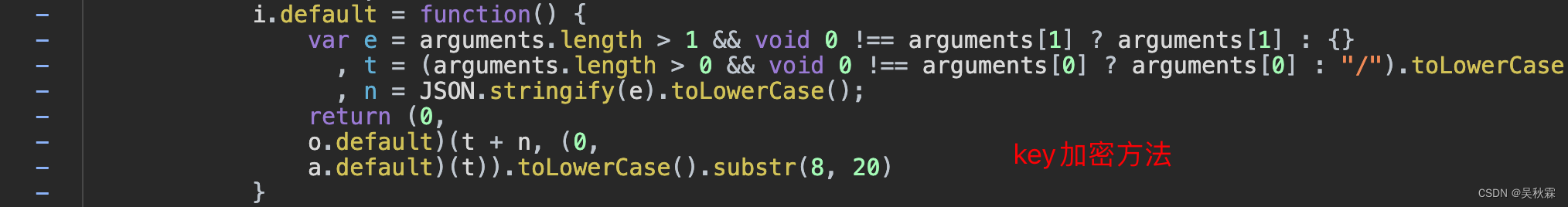

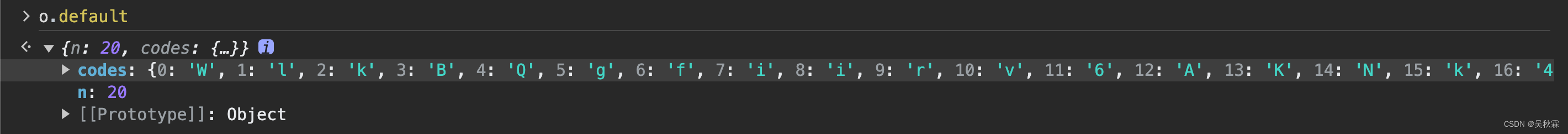

如上图点击a.default跳转到请求头Key的加密具体方法:

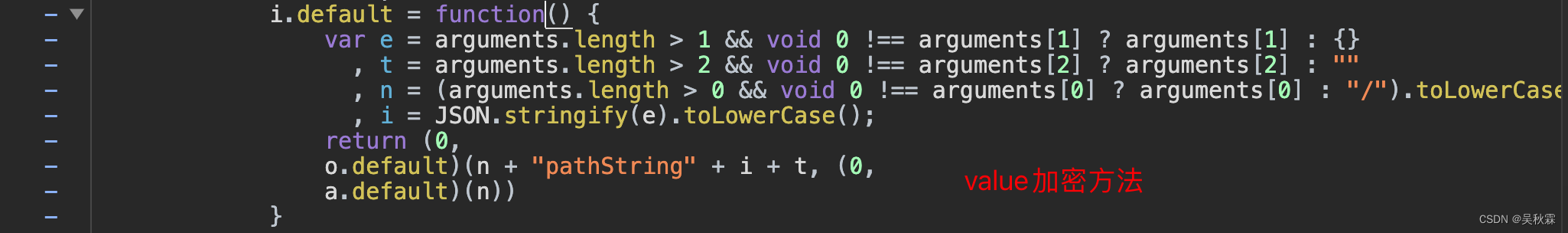

点击r.default跳转到请求头Value的加密具体方法:

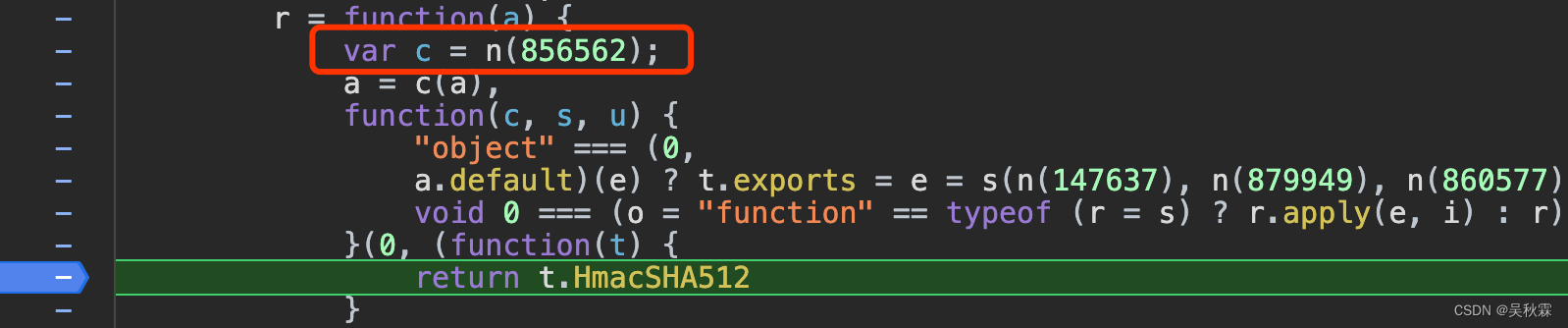

其中o.default是加密算法!先分析Key跟Value的加密算法o.default,在JS中可以看到WebPack加载了856562,跟着断点继续走,o.default的加密如下所示:

SHA512的加密函数,借助JS内CryptoJS一行代码即可实现,如下所示:

// HMAC SHA512加密函数

function hmacSHA512(data, key) {

return CryptoJS.HmacSHA512(data, key).toString();

}

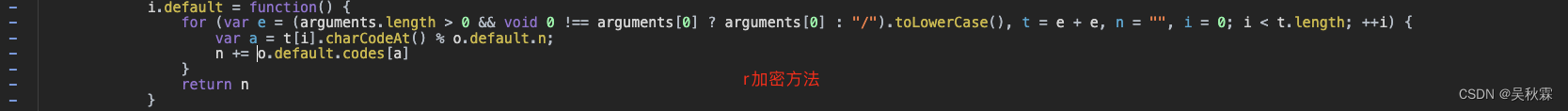

a.default是干啥的?是数据处理,JS代码如下所示:

如上代码o.default.n跟o.default.codes取值字典内字段,内容如下:

如上显示这里的o.default是一个字典,定义实现如下:

o = {}

o.default = {

"n": 20,

"codes": {

"0": "W",

"1": "l",

"2": "k",

"3": "B",

"4": "Q",

"5": "g",

"6": "f",

"7": "i",

"8": "i",

"9": "r",

"10": "v",

"11": "6",

"12": "A",

"13": "K",

"14": "N",

"15": "k",

"16": "4",

"17": "L",

"18": "1",

"19": "8"

}

}

4. 扣加密JS

通过上面断点分析,找到了Headers请求头内Key、Value的加密实现代码以及加密代码内的其他调用方法,最终加密算法如下:

const CryptoJS = require('crypto-js');

// HMAC SHA512加密函数

function hmacSHA512(data, key) {

return CryptoJS.HmacSHA512(data, key).toString();

}

// 默认的配置和编码映射

const config = {

"n": 20,

"codes": {

"0": "W", "1": "l", "2": "k", "3": "B", "4": "Q",

"5": "g", "6": "f", "7": "i", "8": "i", "9": "r",

"10": "v", "11": "6", "12": "A", "13": "K", "14": "N",

"15": "k", "16": "4", "17": "L", "18": "1", "19": "8"

}

};

// 根据给定的字符串生成编码

function generateCode(str) {

let result = "";

for (let char of str) {

const code = char.charCodeAt() % config.n;

result += config.codes[code];

}

return result;

}

// 生成密钥

function generateKey(path, data = {}) {

const encodedPath = encodeURIComponent(path).toLowerCase();

const encodedData = JSON.stringify(data).toLowerCase();

const hashedPathData = hmacSHA512(encodedPath + encodedData, generateCode(encodedPath)).toLowerCase();

return hashedPathData.substr(8, 20);

}

// 生成值

function generateValue(path, data = {}, tid = "") {

const encodedPath = encodeURIComponent(path).toLowerCase();

const encodedData = JSON.stringify(data).toLowerCase();

return hmacSHA512(encodedPath + "pathString" + encodedData + tid, generateCode(encodedPath)).toLowerCase();

}

// 主函数运行

function run(path, tid, data = {}) {

const headers = {};

headers[generateKey(path, data)] = generateValue(path, data, tid);

return headers;

}

// 测试数据

const tid = '53f97a8d50bcf99d4a9a3a36c6cdd9c2'; //企业加密ID

// 数据接口

const path = 'https://www.qcc.com/api/datalist/zhuanlilist';

const jsonData = {

"keyNo": "6b242b475738f45a4dd180564d029aa9",

};

console.log(run(path, tid, jsonData));

上述JS加密算法代码中generateCode函数实现的是a.default的数据操作处理,hmacSHA512函数实现的是o.default的加密方法

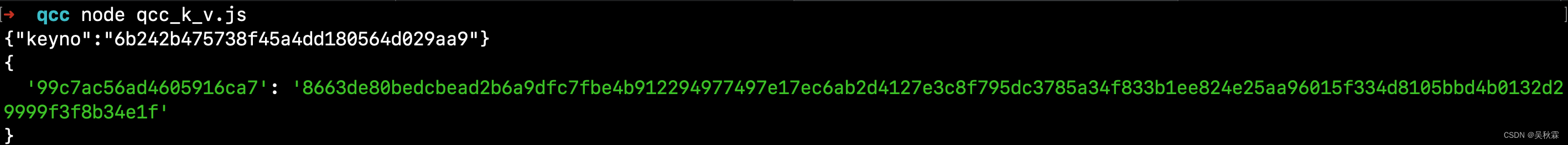

运行测试上面Key、Value的加密算法程序,结果如下所示:

5. Python爬虫代码实现

import re

import execjs

import requests

# cookies信息自行设定

cookies = {

'qcc_did': '',

'UM_distinctid': '',

'acw_tc': '',

'QCCSESSID': '',

'_uab_collina': '',

'CNZZDATA1254842228': ''

}

def load_javascript_function():

with open('./qcc_k_v.js', 'r', encoding='utf-8') as file:

js_code = file.read()

return execjs.compile(js_code)

def generate_headers(url, pid, tid, json_data=None):

headers = {'x-pid': pid} # 其他headers请求头信息自行补充

path = re.findall(r'(/api.*)', url)[0]

js_ctx = load_javascript_function().call('run', path, tid, json_data)

for key, value in js_ctx.items():

headers[key] = value

return headers

def make_post_request(url, pid, tid, json_data=None):

headers = generate_headers(url, pid, tid, json_data)

return requests.post(url, cookies=cookies, headers=headers, json=json_data)

def make_get_request(url, pid, tid):

headers = generate_headers(url, pid, tid)

return requests.get(url, cookies=cookies, headers=headers)

if __name__ == '__main__':

# 企业加密唯一ID(自行选择测试)

key_no = '3f603703d59a04cbe427e5825099a565'

pid = '' # HTML中搜索并自行填充

tid = '' # HTML中搜索并自行填充

# 示例GET请求

get_url = 'https://www.qcc.com/api/datalist/guarantorlist?keyNo=3f603703d59a04cbe427e5825099a565'

print(make_get_request(get_url, pid, tid).json())

# 示例POST请求

post_url = 'https://www.qcc.com/api/datalist/zhuanlilist'

json_data = {'keyNo': '3f603703d59a04cbe427e5825099a565'}

print(make_post_request(post_url, pid, tid, json_data).json())

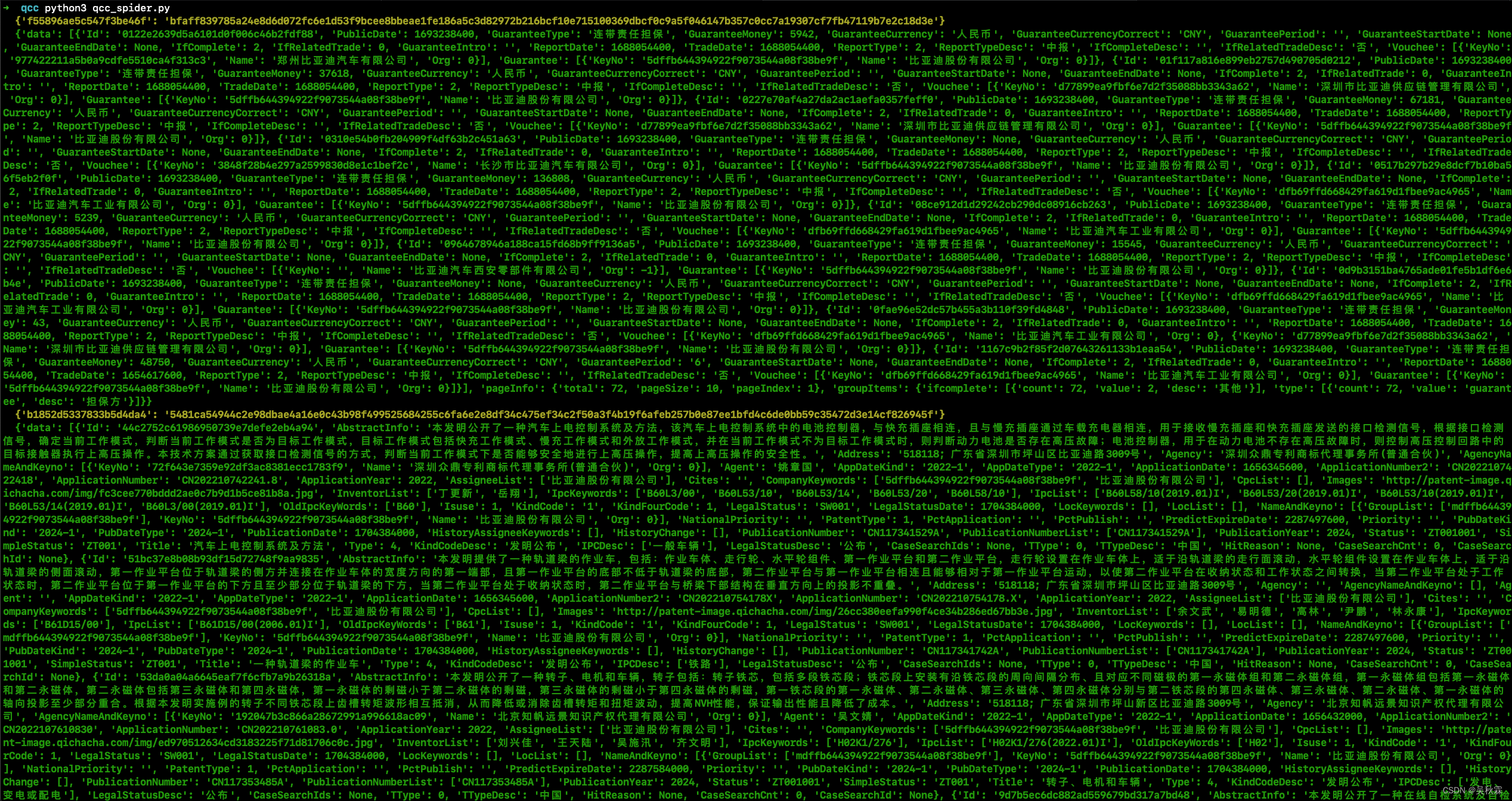

以上是最终的爬虫代码,根据注释完善即可!测试(经营风险|信息、知识产权)接口如下:

??好了,到这里又到了跟大家说再见的时候了。创作不易,帮忙点个赞再走吧。你的支持是我创作的动力,希望能带给大家更多优质的文章

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!