本科生学深度学习-Attention机制

2023-12-13 04:07:57

很久没有写了,今天想学习下Bert ,发现其中一个很重要的机制是self-Attention,在查self-attention的时候又回归到Attention机制,记录下。

1、Attention 是什么

Attention(注意力)机制核心逻辑就是「从关注全部到关注重点」。

attention机制是模仿人类注意力而提出的一种解决问题的办法,简单地说就是从大量信息中快速筛选出高价值信息。主要用于解决LSTM/RNN模型输入序列较长的时候很难获得最终合理的向量表示问题,做法是保留LSTM的中间结果,用新的模型对其进行学习,并将其与输出进行关联,从而达到信息筛选的目的。

2、小故事讲解

以下引用自:一文看懂 Attention(本质原理+3大优点+5大类型) - 产品经理的人工智能学习库

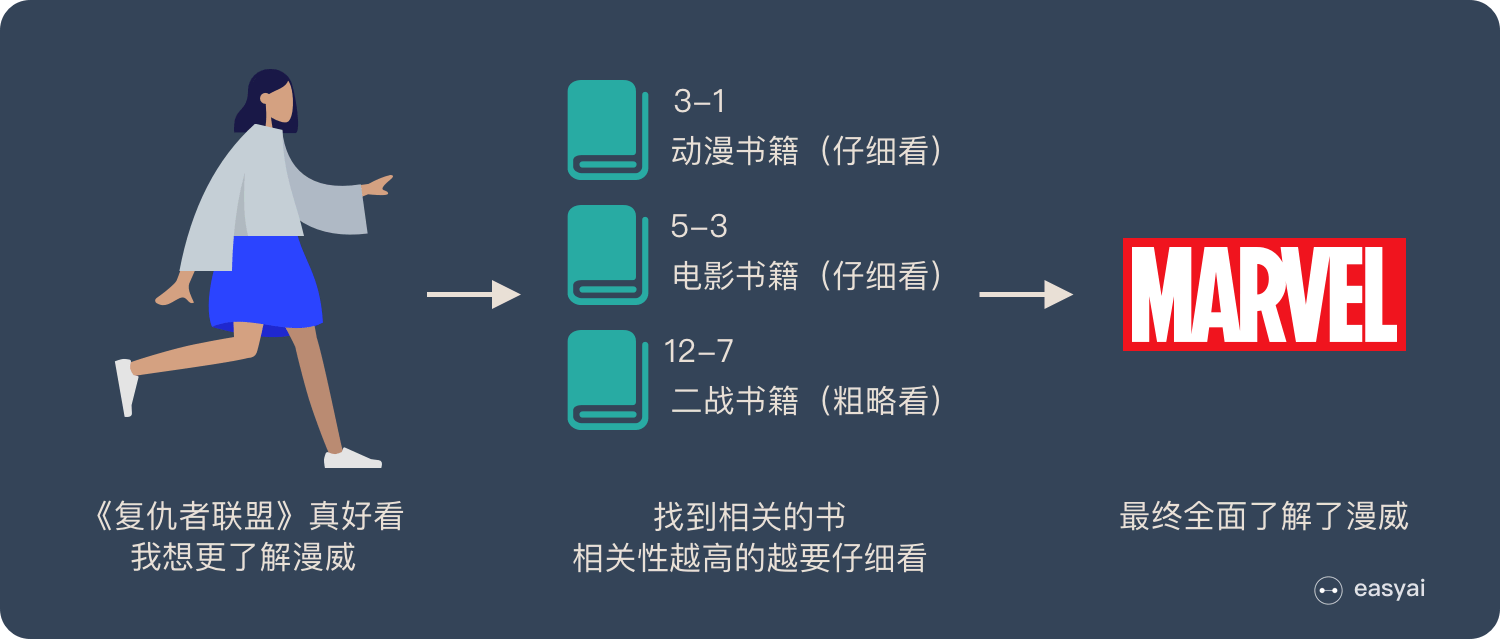

上面的图看起来比较抽象,下面用一个例子来解释 attention 的原理:

图书管(source)里有很多书(value),为了方便查找,我们给书做了编号(key)。当我们想要了解漫威(query)的时候,我们就可以看看那些动漫

文章来源:https://blog.csdn.net/perfect2011/article/details/134124169

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!