多任务学习(Multi-Task Learning)和迁移学习(Transfer Learning)的详细解释以及区别(系列1)

文章目录

前言

多任务学习(Multi-Task Learning)和迁移学习(Transfer Learning)是机器学习中的两个重要概念,它们在解决不同的学习任务和应用场景下起着不同的作用。

一、多任务学习(Multi-Task Learning)是什么?

多任务学习指的是在一个模型中同时训练和优化多个相关任务,通过共享模型的参数和表示来提高整体性能。这意味着一个模型可以同时学习多个任务,而不是单独为每个任务训练一个独立的模型。多任务学习的目标是通过任务之间的相互促进和共享信息来提高整体性能,特别是在数据集较小的情况下。

二、多任务学习(Multi-Task Learning)对数据的要求

-

相关性:多任务学习的任务之间应该存在一定的相关性。这意味着任务之间共享的信息或特征应该对任务的解决有帮助。如果任务之间没有足够的相关性,多任务学习可能无法提供性能的提升。 -

平衡性:每个任务的数据集应该相对平衡,即每个任务的样本数量应该相对均衡。如果某些任务的数据量远大于其他任务,模型可能会在训练中偏向于处理数量较多的任务,从而影响其他任务的性能。 -

分布一致性:任务之间共享的特征在不同任务的数据集中应该有一定的分布一致性。这意味着特征在不同任务中的统计特性应该相似。如果不同任务的数据分布差异较大,多任务学习可能无法有效共享信息。

三、迁移学习是什么?

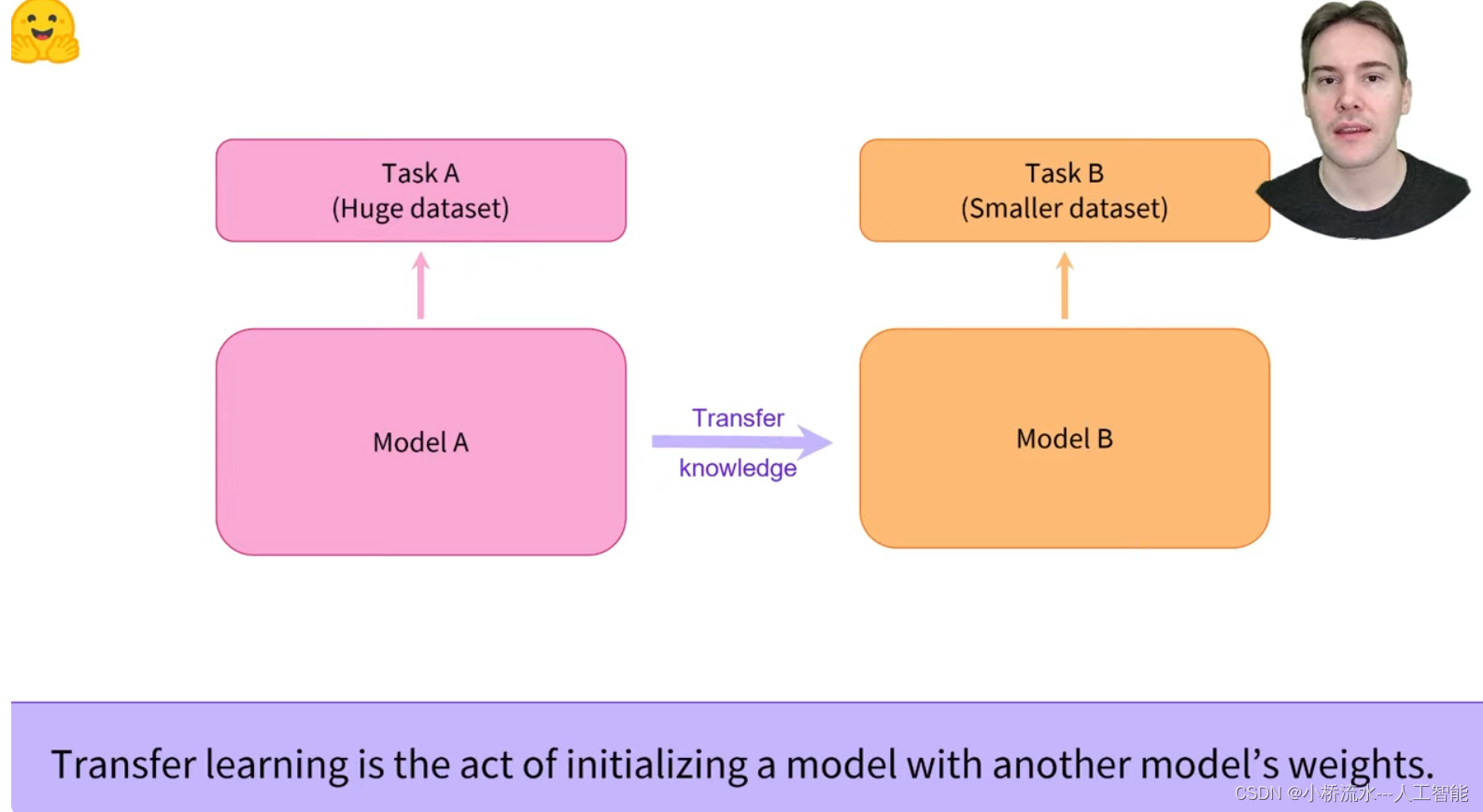

迁移学习则是指将在一个任务上学习到的知识应用于另一个相关或类似任务上的过程。

通常情况下,一个预训练好的模型(称为源任务)的参数和表示会被用于初始化并加速另一个任务(称为目标任务)的训练过程。迁移学习的目标是利用已有的知识和模型,在目标任务上获得更好的性能,尤其是当目标任务的数据集较小或不足时。

四,迁移学习对数据的要求

-

目标领域数据的可用性:迁移学习假设源任务和目标任务之间存在一定的相似性,即源任务的知识可以迁移到目标任务中。因此,目标领域的数据应该是可用的,以便进行模型的迁移和调整。 -

数据偏移:迁移学习假设源任务和目标任务之间的数据分布具有一定的偏移,即目标任务的数据在某些方面与源任务的数据不同。为了有效迁移,模型需要能够适应这种分布差异。

五,多任务学习与迁移学习的区别是什么?

区别在于多任务学习关注如何同时学习多个任务并共享信息,而迁移学习关注如何将已有的知识应用于新的任务。

多任务学习的应用范围广泛,适用于多个相关任务之间存在一定关联的情况。

当目标任务的数据较少时,迁移学习可以通过利用源任务的知识和经验来提高性能。

总结

总之,多任务学习对数据分布的要求主要关注任务之间的相关性和平衡性,迁移学习关注源任务和目标任务之间的相似性和数据分布的差异。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!