【大模型】LLM显存占用对比:Qwen-7B-Chat,Qwen-14B-Chat-Int8,chatglm3-6b

2023-12-22 21:21:48

显存占用对比:

显卡:NVIDIA GeForce RTX 4090

系统环境:ubuntu 22.04LTS

-

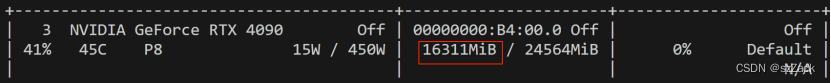

Qwen-14B-Chat-Int8

模型:qwen/Qwen-14B-Chat-Int8

GPU占用:

-

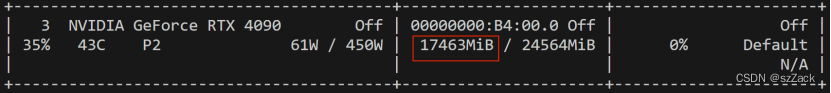

Qwen-7B-Chat

模型:qwen/Qwen-7B-Chat(bf16, fp16)

GPU占用:

-

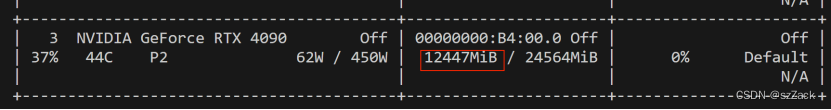

chatglm3-6b

模型:ZhipuAI/chatglm3-6b(bf16, fp16)

GPU占用:

总结

总结下来就是能用fp16就用fp16,能用Int8就用Int8,能用int4就用int4。

量化对降低显存占用还是非常不错。

参考

文章来源:https://blog.csdn.net/zengNLP/article/details/135160073

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!