DETR++: Taming Your Multi-Scale Detection Transformer论文解读

文章目录

前言

今天查看了一篇DETR++论文,本想网络上找博客大概浏览一下,不料网上对DETR++资料较少。无奈,我只有自己查看原文,了解其方法。为此,本篇博客将介绍DETR++论文内容,也希望我的解读会快速让朋友们了解其论文方法。

论文链接:https://arxiv.org/pdf/2206.02977v1.pdf

一、摘要

自从AlexNet在图像分类网络出现,目标检测使用CNN结构已占主导地位。随着transformer在自然邻域广泛使用,Carmethod引入DETR来处理目标检测。然而,由于self-attention存在平方计算复杂都,DETR不能狗处理多尺度特征交互,导致小目标检测效果较差。为了克服这个问题和进一步改善DETR性能。在这篇研究中,我们研究了多尺度特征交互的不同方法,并发现BIFPN在DETR中最有效,并提升检测性能。介于此发现,我们提出DETR++模型,一个新架构,改善检测结果。我们在coco2017测试提升了1.9%的AP,RICO icon测试11.5%的AP,我们提升了9.1%AP。

二、引言

列举众所周知基于CNN的检测模型方法,有anchors、grid、pointcetres等模式,也被cocohuopascal数据证明了有效性,当然后处理也是影响性能部分。而后作者介绍了DERT相关原理与框架。紧接着,作者提出DETR弊端,就是slow,其原因在于一个self-attention机制,特别对于视觉特征需sapn over thousands of token(简单说就是维度拉大了),另一个原因二分匹配也是耗时的。提到若是在增加多尺度特征到DETR中,就存在更大调整。因此,本文研究多个multi-level features方式加入DETR架构去改善性能,而不导致self-attention的二次方复杂度与二分匹配。作者又说了其困难,①在资源和时间限制下运行多层特征头几乎是不可能的,②transformer的encoder结构在解码detector模块是非常重要的额,也是不可能去除的,③使用滑动窗口思路是不work的,④dert头对不同目标尺度改善效果也不佳,⑤BIFPN结构嵌入DETR是有效果的,且不增加计算复杂度。

三、相关研究

作者介绍了基于CNN的模型,随后介绍多尺度特征文献回顾,解释使用多尺度特征如FPN确实改善小目标检测,并列举了一些模型。紧接着,作者说了,由于DETR计算的复杂度,原始模型不容易合并多尺度特征。这导致缺乏多尺度特征,是模型在小目标效果表现不佳。

四、模型方法

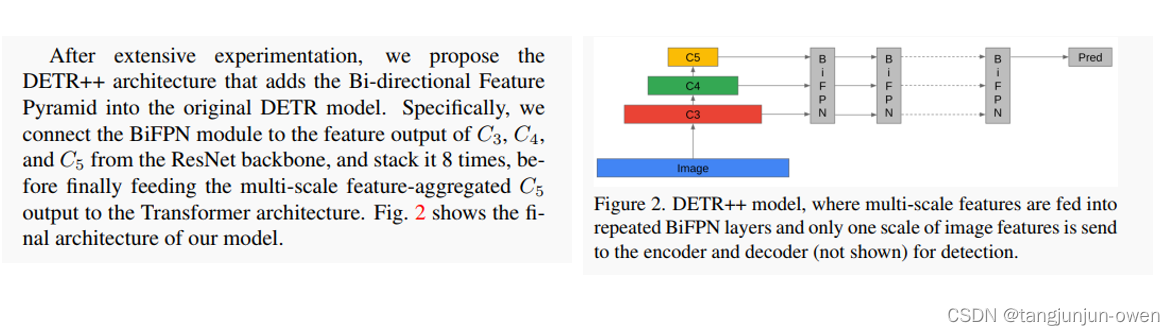

本文方式实际是介绍使用不同模块,重在neck中实现多尺度特征融合方式,探究原始DETR改进效果。最终作者选择BIFPN方法嵌入DETR,发现其效果最好。当然,我额外说下,作者说了DETR因其自身原因,添加多尺度特征模块嵌入于DETR是比较困难的,这个可能需要结合代码查看。当然,我在下面会给出作者原文对每个方法原文,读者可自行查看。

1、Removing the Encoder方法

2、Multi-Head方法

3、Shifted Windows方法

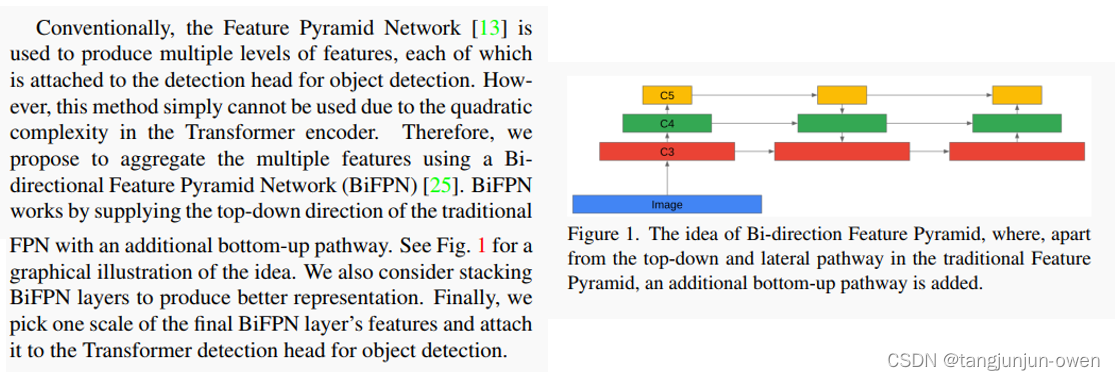

4、Bi-directional Feature Pyramid方法

5、DETR++方法

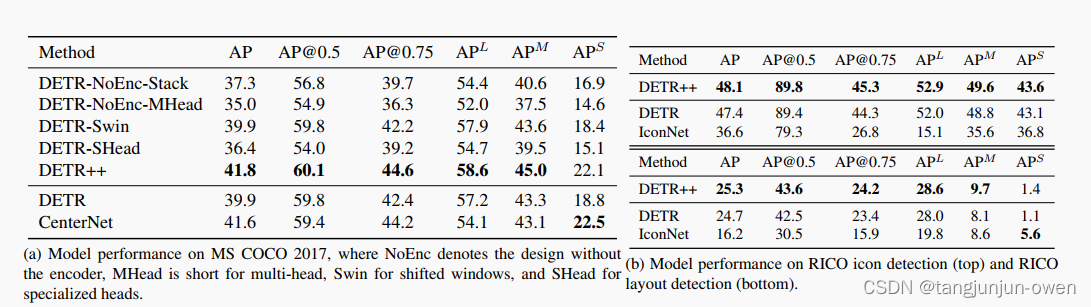

五、实验结果

作者实验也是基于coco2017数据集,上面是使用不同模块预测结果,下面是其它网络预测结果。但你会发现某些模块添加DETR模型效果会差,如stack方法的AP是37.3而DETR是39.9,反而降低了。具体详情如下:

总结

DETR++论文核心是想实现类似FPN的多尺度特征融合技术,尝试了很多种方法,最终使用BIFPN靠谱。与此同时,DETR++模型也解决transformer的attention引起slow问题,并找到如何将多尺度特征嵌入DETR模型方法(作者说嵌入DETR本身困难)。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!