LangChain+Fine-tune实现模型定制化

2024-01-02 20:52:45

目录

前言

接上次的AI初步了解,继续探索一下大模型。LangChain+Fine-tune实现模型定制化。

1 Prompt Engineering

--如何适应大模型

?

?

?

?

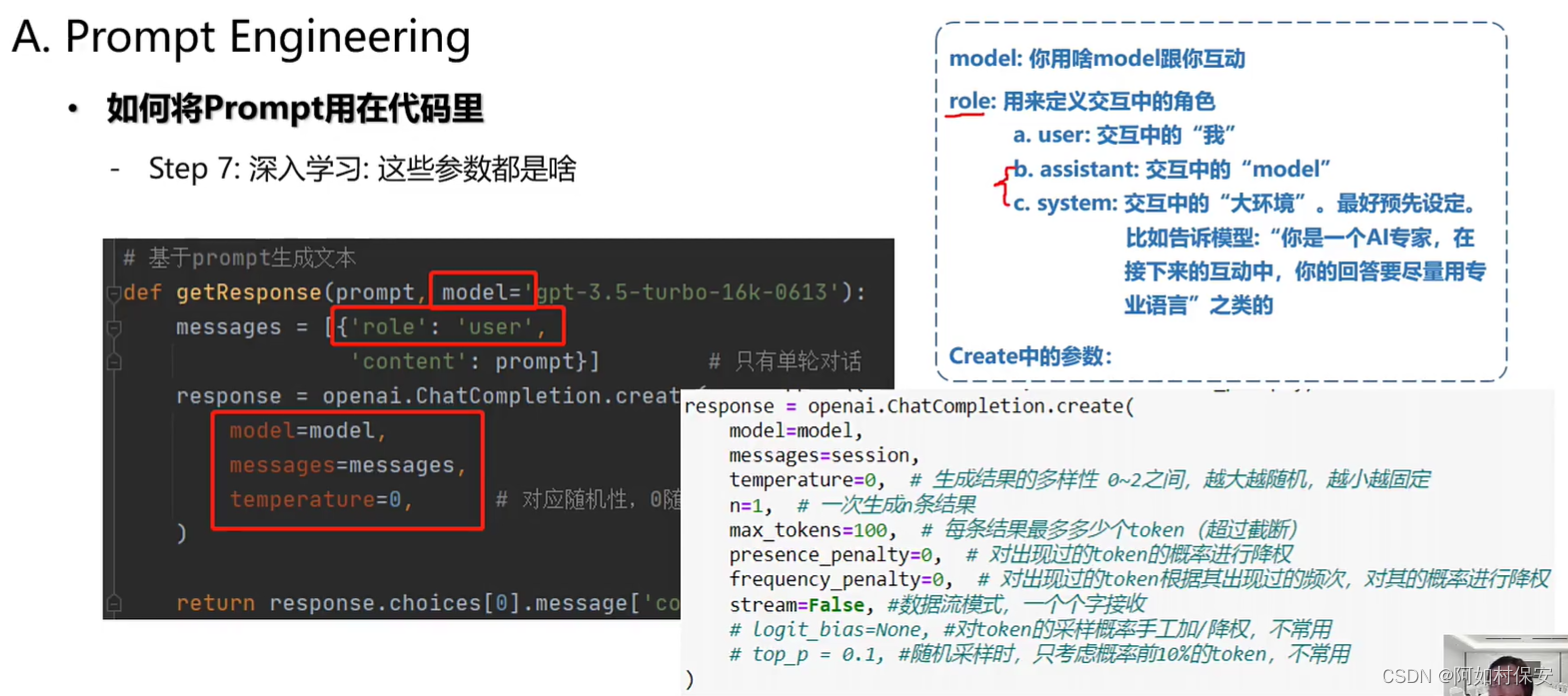

?这里的model=gpt-3.5....这是默认的gpt模型(openai其实有很多大模型)。

messages就是输入的提问,temperature对应随机性,每次回答不一样。

多轮交互除了输入user的内容,也还要输入每轮model的回答。

大环境可以设定安全性问题等问题。

2 LangChain

--如何使用大模型

这里的i就是prompts输入,归一化 ;

根据要求选择不同的model;

解析结果,提取信息。

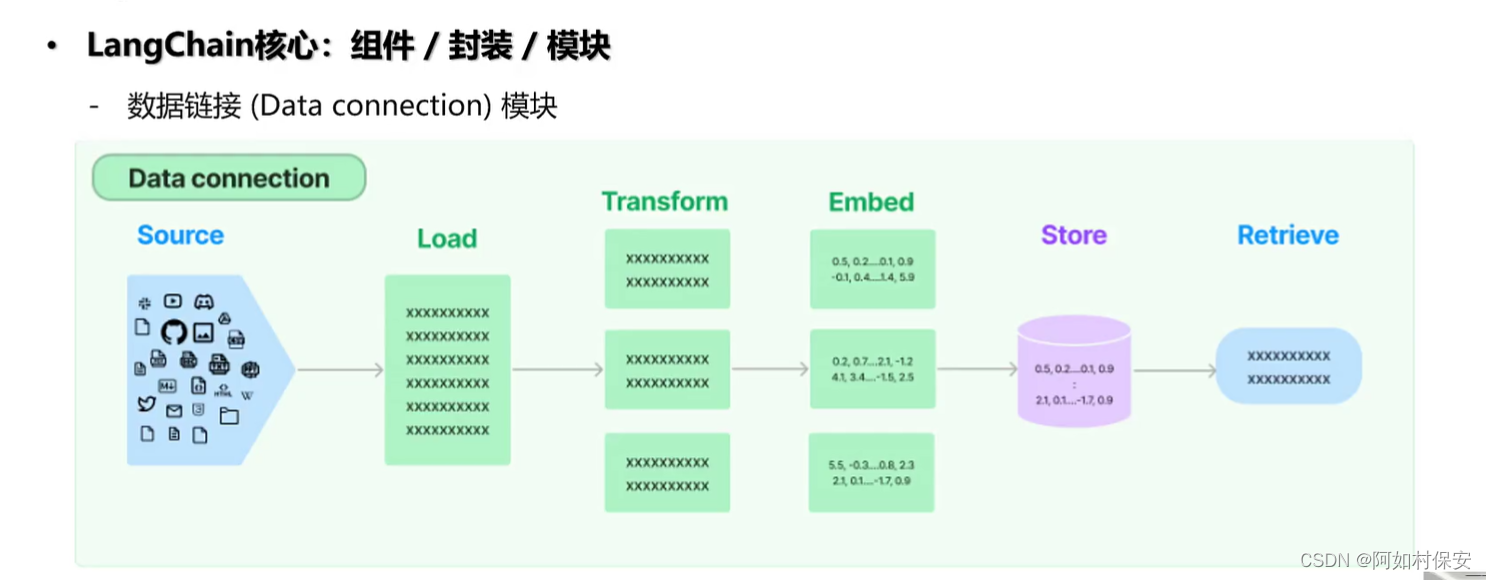

原始的数据有很多(source)

也有很多loaders,下图是一些文档类的loaders

?数据的预处理:

到这一步也不能直接使用,都还是人类语言,还需要处理(回溯算法),变成模型看懂的“特征”(feather),也就是张量 (tensor)。

?之后,

retrieve就是检索

3 Fine-tuning

--如何改变大模型

?太贵了

有全参数量和小参数量的分别。?

LoRA:

理智到大师。

理智到大师。

?

?

总结

其实还是迷迷糊糊的,但大致了解了一下大模型的分类以及如果想要研究的话应该从哪些方面入手。之后有机会可以玩玩吧。

文章来源:https://blog.csdn.net/m0_66076989/article/details/135346212

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!