StreamPark生产集群搭建

1.环境准备

1.1 介绍

在使用 Flink&Spark 时发现从编程模型, 启动配置到运维管理都有很多可以抽象共用的地方, 目前streampark提供了一个flink一站式的流处理作业开发管理平台, 从流处理作业开发到上线全生命周期都做了支持, 是一个一站式的流出来计算平台。

未来spark开发也在规划范围内,目前还不支持

1.2 下载

StreamPark安装包下载:https://streampark.apache.org/download

StreamPark官网:https://streampark.apache.org/docs/intro

最新版为2.1.2,本次安装为2.1.2版本

1.3 环境要求

| 要求 | 版本 | 是否必须 | 其他事项 |

|---|---|---|---|

| 操作系统 | Linux | 是 | 不支持Window系统 |

| JAVA | 1.8+ | 是 | |

| MySQL | 5.6+ | 是 | 默认使用H2数据库,推荐使用 MySQL |

| Flink | 1.12.0+ | 是 | Flink version >= 1.12 |

| Hadoop | 2+ | 否 | 可选,如果部署flink on yarn 则需要hadoop环境. |

目前 StreamPark 对 Flink 的任务发布,同时支持 Flink on YARN 和 Flink on Kubernetes 两种模式。本次使用yarn模式

2.安装

2.1 修改application.yml

spring:

#用mysql作元数据管理

profiles.active: mysql #[h2,pgsql,mysql]

application.name: StreamPark

streampark:

proxy:

# knox process address https://cdpsit02.example.cn:8443/gateway/cdp-proxy/yarn

yarn-url:

# lark alert proxy,default https://open.feishu.cn

#飞书配置

lark-url: https://open.feishu.cn

hadoop-user-name: hadoop #要和你的hdfs操作用户名称一致

workspace:

local: 自定义本地工作目录

remote: 自定义远程工作目录 # support hdfs:///streampark/ 、 /streampark 、hdfs://host:ip/streampark/

2.2 修改application-mysql.yml

server:

#默认端口号为10000,被hive占用,调整为10003

port: 10003

spring:

datasource:

username: xxx

password: xxxx

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://xxxx:3306/streampark?useSSL=false&useUnicode=true&characterEncoding=UTF-8&allowPublicKeyRetrieval=false&useJDBCCompliantTimezoneShift=true&useLegacyDatetimeCode=false&serverTimezone=GMT%2B8

2.3 配置mysql

ips: 由于Apache 2.0许可与Mysql Jdbc驱动许可的不兼容,用户需要自行下载驱动jar包并放在 $STREAMPARK_HOME/lib 中,推荐使用8.x版本,下载地址apache maven repository

#将安装包中的mysql-schema.sql和mysql-data.sql复制到mysql所在的机器上执行

source /data/software/apache-streampark_2.12-2.1.2-incubating-bin/script/schema/mysql-schema.sql

source /data/software/apache-streampark_2.12-2.1.2-incubating-bin/script/data/mysql-data.sql

3 启动登录

进入到 bin 下直接执行 startup.sh 即可启动项目,默认端口是10000,如果没啥意外则会启动成功,打开浏览器 输入http://$host:10003 即可登录

cd streampark-console-service-1.0.0/bin

bash startup.sh

相关的日志会输出到streampark-console-service-1.0.0/logs/streampark.out 里

经过以上步骤,即可部署完成,可以直接登录系统

默认密码: admin / streampark

4.系统配置

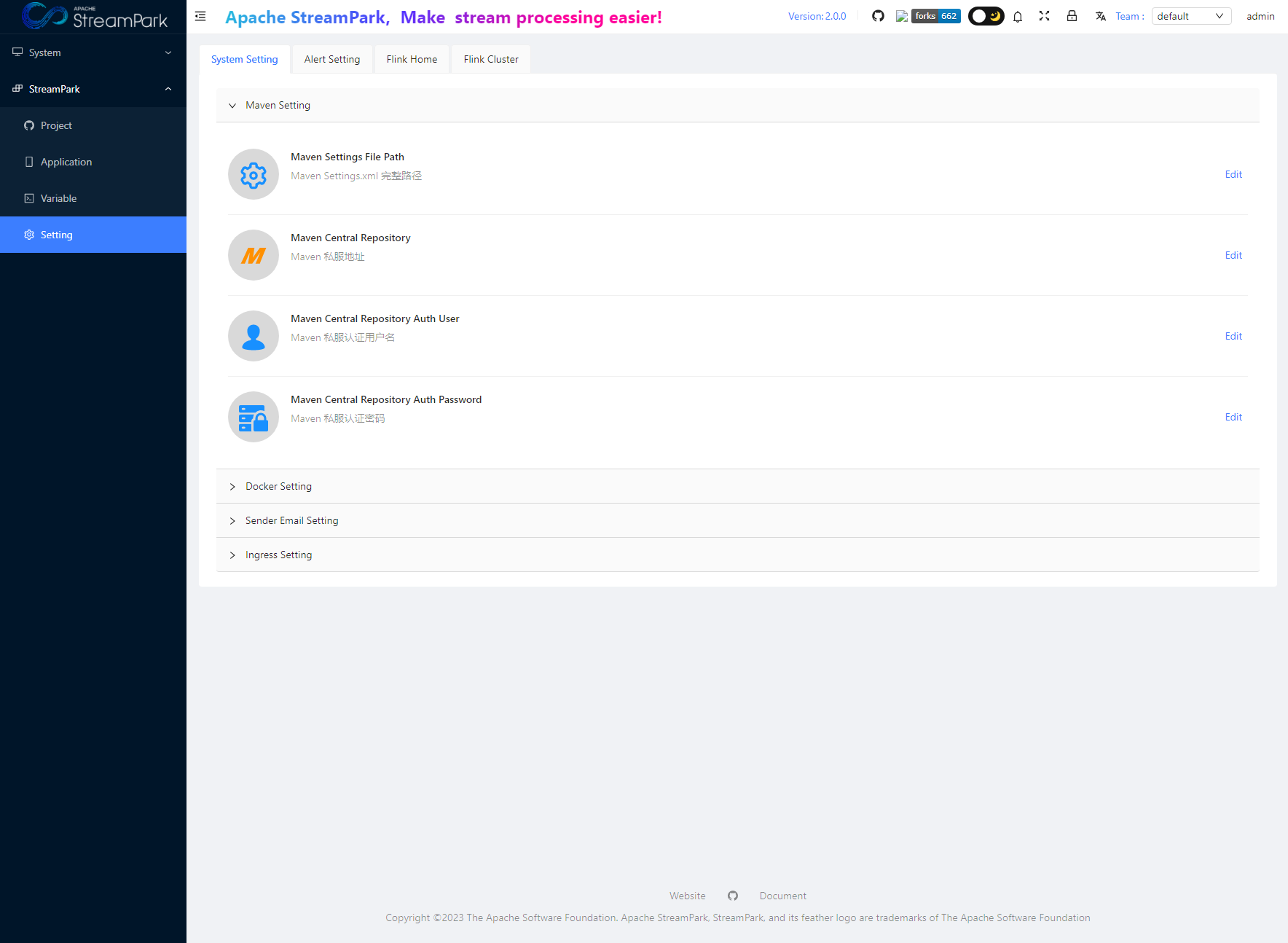

进入系统之后,第一件要做的事情就是修改系统配置,在菜单/StreamPark/Setting 下,操作界面如下:

主要配置项分为以下几类

- System Setting

- Alert Setting

- Flink Home

- Flink Cluster

4.1 System Setting

当前系统配置包括:

- Maven配置

- Docker环境配置

- 警告邮箱配置

- k8s Ingress 配置

4.2 Alert Setting

Alert Email 相关的配置是配置发送者邮件的信息,具体配置请查阅相关邮箱资料和文档进行配置

4.3 Flink Home

这里配置全局的 Flink Home,此处是系统唯一指定 Flink 环境的地方,会作用于所有的作业

提示

特别提示: 最低支持的 Flink 版本为 1.12.0, 之后的版本都支持

4.4 Flink Cluster

Flink 当前支持的集群模式包括:

- Standalone 集群

- Yarn 集群

- Kubernetes 集群

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!