每天五分钟计算机视觉:通过残差块搭建卷积残差神经网络Resnet

2023-12-13 17:36:01

本文重点

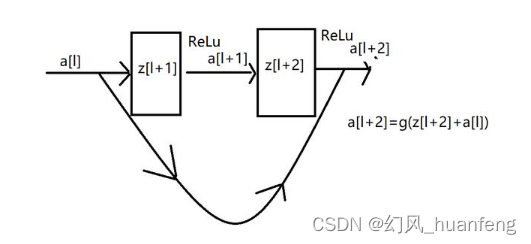

随着深度神经网络的层数的增加,神经网络会变得越来越难以训练,之所以这样就是因为存在梯度消失和梯度爆炸问题。本节课程我们将学习跳跃连接方式,它可以从某一网络层获取激活a,然后迅速反馈给另外一层,甚至是神经网络的更深层,从而解决梯度消失的问题。

传统的连接方式

这是一个两层的网络,我们来看一下它从a[l]到a[l+2]的前向传播过程是什么样的?

z[l+1] = W[l+1]a[l] + b[l+1]

a[l+1] = g(z[l+1])

z[l+2] =W[l+2]a[l+1] + b[l+2]

a[l+2] = g(z[l+2])

残差块的连接方式

上面就是传统的神经网络的前向传播的方式,而在残差块中有一点变化,我们将a[l]直接向后拷贝到神经网络的深层,在ReLU非线性激活函数前加上a[l]。a[l]的信息直接到达神经网络的深层。

这就意味着最后这个等式(a[l+2] = g(z[l+2]))去掉了,取而代之的是另一个 R

文章来源:https://blog.csdn.net/huanfeng_AI/article/details/134843820

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!