一张图片组合一组动作就可以生成毫无违和感的视频!

你敢信,1张人物图片 + 1张动作动画,就可以生成一段视频。网友直呼:“主播/视频UP主可能快要下岗了!”

(模型视频来源于网络)

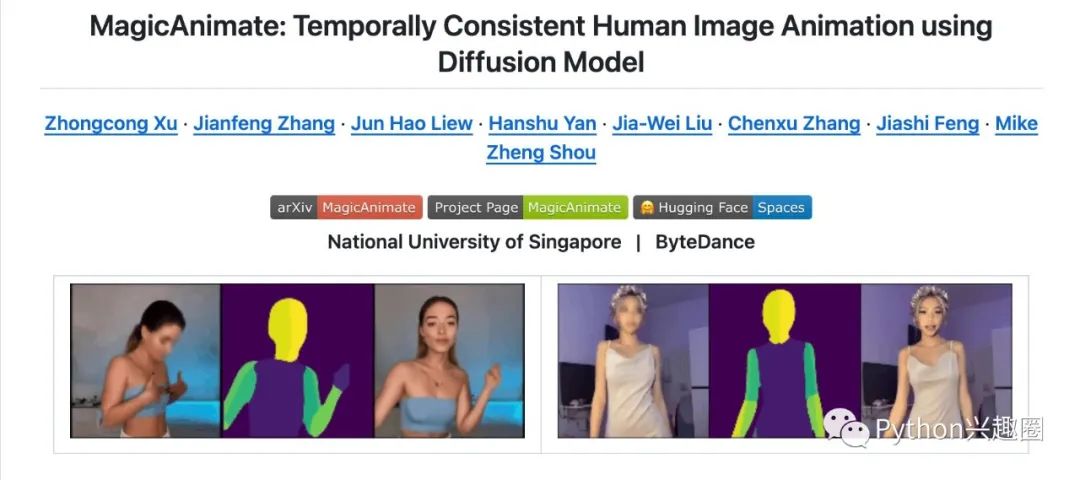

本周,字节跳动联合新加坡国立大学发布了一款开源项目 MagicAnimate,在GitHub开源网站上发布不到4天,就收揽了 6.4k Star!受到了一大批科技大佬和互联网从业者的关注,并有网友在抖音上发布了试用效果,简直杠杠的!

接下来小编带大家一起来看一看这一款由字节跳动、新加坡国立大学合作研发的宝藏AI视频工具。

项目介绍

MagicAnimate 是一款使用扩散模型实现的时域一致的人体图像动画工具。

它可以通过对人体图像进行扩散模型的运算,实现高质量、自然流畅的人体动画效果。MagicAnimate 具有高度的可控性和灵活性,可以通过微调参数来实现不同的动画效果。

它适用于人体动画创作、虚拟角色设计等领域。

你可以可以采用任何具体人像的图像照片+动作视频,去生成一个具有自己风格的人物动作,以下是网友采用网络上一张照片再加上跑步动作生成的。

(效果图来源于网络)

在线体验

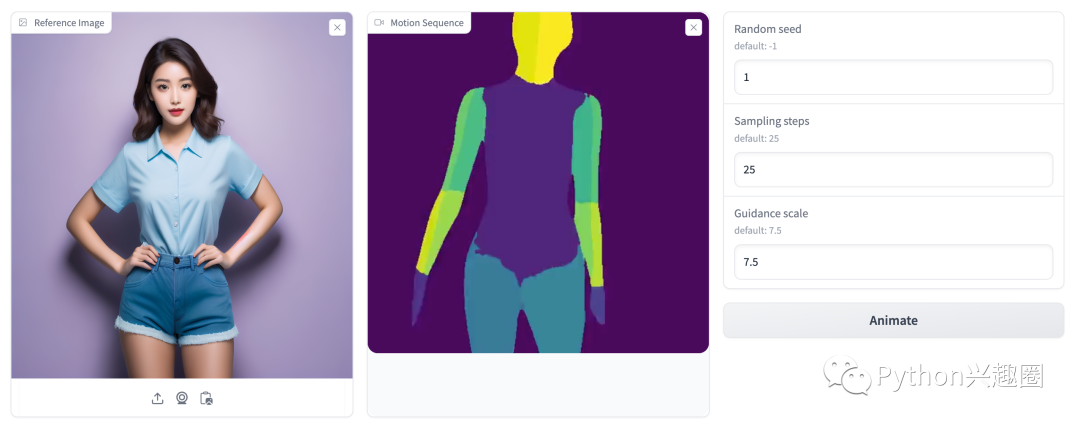

官方团队在HuggingFace中开放了在线体验的模型Spaces。

模型在线体验地址:https://huggingface.co/spaces/zcxu-eric/magicanimate

具体使用步骤也非常简单,只需3个步骤即可:

-

先上传一张静态人物图片

-

在上传想要生成的动作demo视频

-

最后调整参数,点击“Animate”即可生成

本地搭建使用

如果想要在本地计算机搭建模型使用,需要先下载以下 2 个预训练基础模型和 1 个MagicAnimate模型。

-

stable-diffusion-v1-5;

-

sd-vae-ft-mse;

-

MagicAnimate

Python 语言依赖需要python版本在3.8及以上, CUDA>=11.3, ffmpeg音视频处理工具

快捷安装命令:

pip install -r requirements.txt

在单个 GPU 上运行推理:

bash scripts/animate.sh

使用多个 GPU 运行推理:

bash scripts/animate_dist.sh

在单 GPU 上启动本地 gradio 演示:

python3 -m demo.gradio_animate

如果您有多个 GPU,请启动本地 gradio 演示:

python3 -m demo.gradio_animate_dist

然后在本地浏览器中打开gradio demo即可体验。

总结

MagicAnimate 的主要应用领域:

1、未知领域动画:MagicAnimate可以为油画和电影角色等未知领域图像制作跑步或做瑜伽的动画。

2、结合T2I扩散模型:将MagicAnimate与DALLE-3生成的参考图像结合,制作各种动作的动画。

3、多人动画:根据给定的运动,为多个人制作动画。

MagicAnimate 产品的主要特色之一是它的高质量和自然流畅的动画效果。使用扩散模型处理人体图像,能够生成逼真的人体动动效果,使得动画更加栩栩如生。

另一个重要特点是MagicAnimate的可控性和灵活性。用户可以根据需要微调参数,实现不同的动画效果,使其适应不同的创作需求和风格。

与阿里的Animate Anyone相比,画面质量,人物一致性上、手部和面部动作 MagicAnimate 差一些,但MagicAnimate支持多人。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!