4.10 构建onnx结构模型-Softmax

2023-12-14 04:25:49

前言

构建onnx方式通常有两种:

1、通过代码转换成onnx结构,比如pytorch —> onnx

2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构,

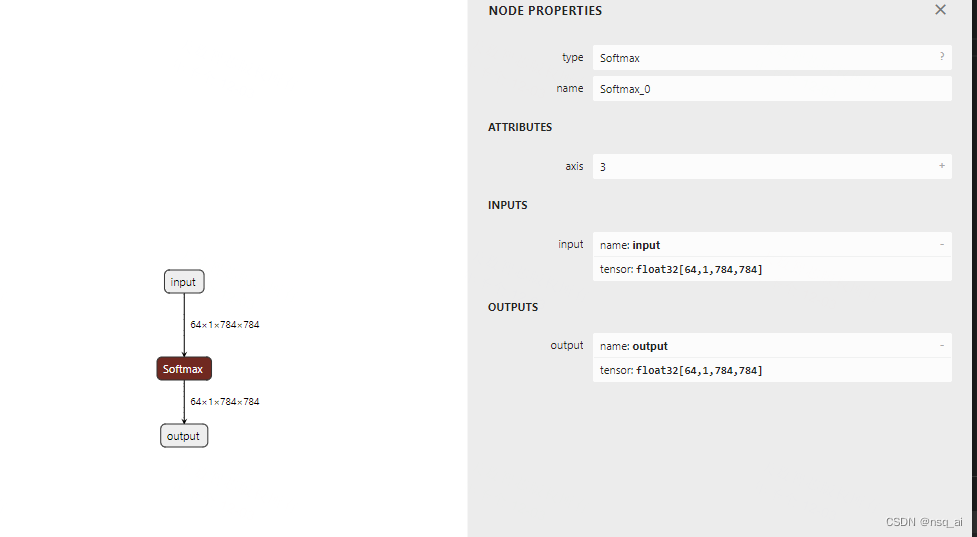

下面以 Softmax 结点进行分析

方式

方法一:pytorch --> onnx

暂缓,主要研究方式二

方法二: onnx

import onnx

from onnx import TensorProto, helper, numpy_helper

def run():

print("run start....\n")

attribtes = {}

attribtes["axis"] = 3

Softmax = helper.make_node(

"Softmax",

name="Softmax_0",

inputs=["input"],

outputs=["output"],

**attribtes,

)

graph = helper.make_graph(

nodes=[Softmax],

name="test_graph",

inputs=[helper.make_tensor_value_info(

"input", TensorProto.FLOAT, [64, 1, 784,784]

)],

outputs=[helper.make_tensor_value_info(

"output",TensorProto.FLOAT, [64, 1, 784,784]

)],

)

op = onnx.OperatorSetIdProto()

op.version = 11

model = helper.make_model(graph, opset_imports=[op])

# model.ir_version = onnx.IR_VERSION

onnx.checker.check_model(model)

print("run done....\n")

return model

if __name__ == "__main__":

model = run()

onnx.save(model, "./test_softmax.onnx")

run

import onnx

import onnxruntime

import numpy as np

# 检查onnx计算图

def check_onnx(mdoel):

onnx.checker.check_model(model)

# print(onnx.helper.printable_graph(model.graph))

def run(model):

print(f'run start....\n')

session = onnxruntime.InferenceSession(model,providers=['CPUExecutionProvider'])

input_name1 = session.get_inputs()[0].name

input_data1= np.random.randn(64,1,784,784).astype(np.float32)

print(f'input_data1 shape:{input_data1.shape}\n')

output_name1 = session.get_outputs()[0].name

pred_onx = session.run(

[output_name1], {input_name1: input_data1})[0]

print(f'pred_onx shape:{pred_onx.shape} \n')

print(f'run end....\n')

if __name__ == '__main__':

path = "./test_softmax.onnx"

model = onnx.load("./test_softmax.onnx")

check_onnx(model)

run(path)

文章来源:https://blog.csdn.net/weixin_45063703/article/details/134839805

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!