大模型结合推荐系统,发论文创新点怎么找?附14篇会议论文&代码

在推荐系统中,大型语言模型可以用于个性化推荐、解释推荐和多样性推荐等多个方面。具体来讲,大模型可以通过对用户的历史行为、兴趣偏好等信息进行建模,从而预测用户可能感兴趣的项目或物品。同时,还可以根据用户的反馈信息,自动生成解释和摘要,帮助用户更好地理解推荐结果。除此之外,还可以通过引入额外的知识库或数据集,提高推荐的多样性和新颖性...

作为一个具有挑战性的研究方向,大模型推荐系统已经受到了更多研究者的关注,并且随着大模型的发展,未来可能会有更多的研究和应用成果涌现。

为了方便想发论文的同学,我今天就整理了一些大模型推荐相关的会议论文,都是今年最新,有其他优秀论文也欢迎大家在评论区分享~

论文和代码看文末

1.Recommender Systems in the Era of Large Language Models (LLMs)

大型语言模型时代的推荐系统

「简述:」推荐系统在电子商务和网络应用中非常重要,它根据用户的兴趣提供个性化建议。虽然深度神经网络已经通过建模用户和物品的交互以及合并文本信息增强了推荐系统,但它们仍面临一些挑战。与此同时,大型语言模型(LLMs)如ChatGPT和GPT4已经彻底改变了自然语言处理和人工智能领域,因为它们具有出色的语言理解和生成能力以及强大的泛化和推理能力。因此,最近的研究试图利用LLM的力量来增强推荐系统。本文从预训练、微调和提示等方面对LLM驱动的推荐系统进行了全面的回顾,并讨论了未来的发展方向。

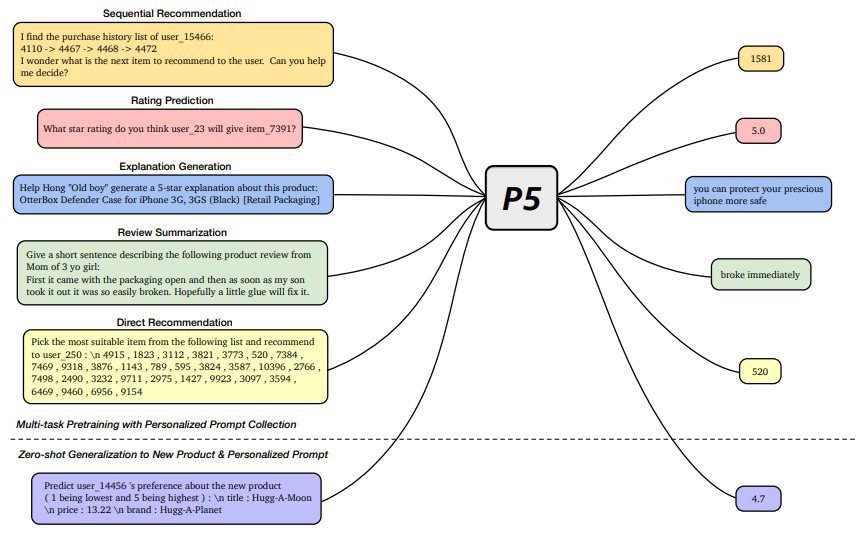

2.Recommendation as Language Processing (RLP):A Unified Pretrain, Personalized Prompt & Predict Paradigm (P5)

统一的预训练、个性化提示和预测范式

「简述:」P5是一种灵活且统一的文本到文本范式,用于推荐任务。它将各种推荐任务统一在一个共享框架中,通过预训练、个性化提示和预测来学习不同任务。P5将推荐系统从浅层模型提升到深层模型,并允许与其他模态轻松集成,从而实现通用推荐引擎。

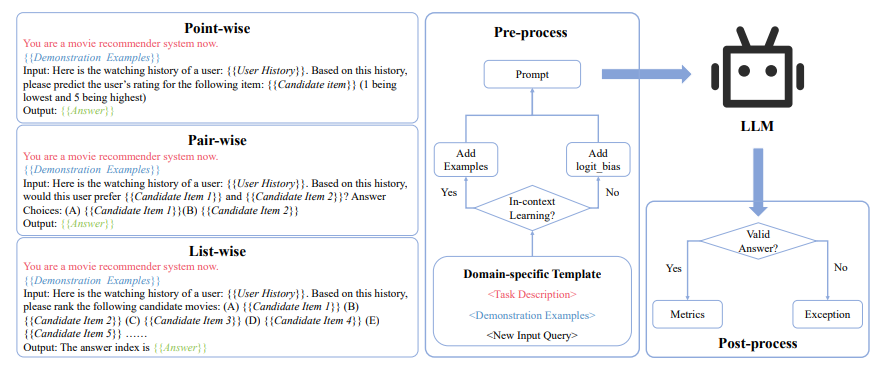

3.Uncovering ChatGPT's Capabilities in Recommender Systems

揭示ChatGPT在推荐系统中的潜力

「简述:」论文旨在通过将ChatGPT与传统的信息检索(IR)排名能力对齐来增强其推荐能力。通过对不同领域的数据集进行实验,作者发现当配备列表式排名时,ChatGPT在成本和性能之间实现了最佳平衡。这项研究为将ChatGPT与推荐任务对齐指明了一个有前途的方向。

4.ls ChatGPT Fair for Recommendation? Evaluating Fairness in Large Language Model Recommendation

评估大型语言模型推荐中的公平性

「简述:」大型语言模型(LLM)在推荐系统中的应用带来了新的范式。然而,LLM可能包含社会偏见,因此需要评估其推荐的公平性。作者提出了一种新的基准(FaiRLLM),用于评估通过LLM进行推荐的公平性。这种基准包括精心设计的指标和涵盖多个敏感属性的数据集。使用FaiRLLM基准,作者发现ChatGPT在生成推荐时对某些敏感属性仍然表现出不公平。

5.ls ChatGPT a Good Recommender? A Preliminary Study

ChatGPT是一个好推荐器吗?

「简述:」本文探索了ChatGPT作为通用推荐模型,将其从大规模语料库中获得的知识转移到推荐场景中的潜力。通过设计提示,评估了ChatGPT在五个推荐场景中的性能,发现它在某些任务中表现良好,能够达到基准水平。此外,人类评估表明ChatGPT可以真正理解提供的信息并生成更清晰、更合理的结果。

6.A First Look at LLM-Powered Generative News Recommendation

首次探索基于LLM的生成式新闻推荐

「简述:」论文介绍了一种基于LLM的生成式新闻推荐框架GENRE,利用预训练语言模型中的语义知识来丰富新闻数据。该框架旨在提供灵活和统一的新闻推荐解决方案,包括个性化新闻生成、用户画像和新闻摘要。实验表明,GENRE具有很高的效果。

7.Chat-REC:Towards Interactive and Explainable LLMs-Augmented Recommender System

面向交互式和可解释的LLM增强推荐系统

「简述:」论文提出了一种名为Chat-Rec的新范式,通过将用户个人资料和历史交互转换为提示,增强了LLMs,用于构建对话式推荐系统。Chat-Rec能够有效地学习用户偏好,并通过上下文学习建立用户与产品之间的联系,使推荐过程更具交互性和可解释性。实验结果表明,Chat-Rec提高了前k个推荐的精度,并在零射击评级预测任务中表现更好。

8.ONCE: Boosting Content-based Recommendation with Both Open- and Closed-source Large Language Models

利用开源和闭源大型语言模型增强基于内容的推荐

「简述:」论文探索了使用大型语言模型(LLM)来增强基于内容的推荐系统。利用开源的LLM,作者将它们的深层用作内容编码器,以丰富内容的表示。对于闭源的LLM,作者使用提示技术来丰富训练数据。通过实验,作者证明了这两种类型的LLM的高效性,并展示了它们之间的协同关系。

9.Large Language Model Augmented Narrative Driven Recommendations

大型语言模型增强叙事驱动推荐

「简述:」论文探讨了使用大型语言模型(LLM)进行数据增强的方法来训练叙事驱动推荐(NDR)模型。作者使用LLM从用户-物品交互中通过少样本提示生成合成叙述查询,并在合成查询和用户-物品交互数据上训练检索模型。实验结果表明,这种方法对于训练小型参数检索模型是有效的,其性能优于其他检索和LLM基线方法。

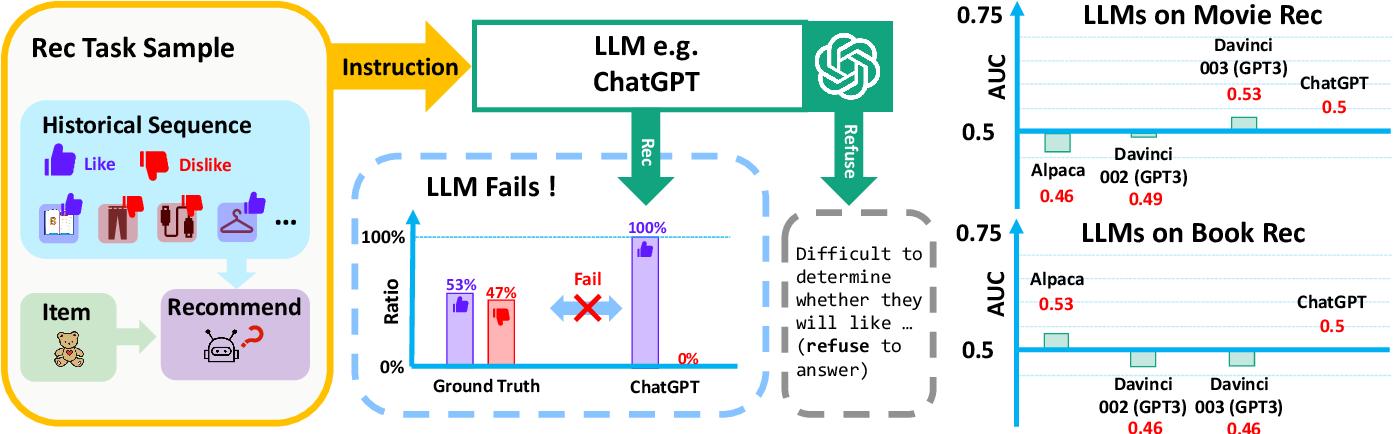

10.TALLRec: An Effective and Efficient Tuning Framework to Align Large Language Model with Recommendation

用于将大型语言模型与推荐系统对齐的有效且高效的调优框架

「简述:」论文介绍了一种名为TALLRec的框架,用于将大型语言模型与推荐系统对齐。作者认为,由于训练任务和推荐任务之间存在差异以及缺乏足够的推荐数据,导致LLMs在推荐任务中表现不佳。因此,作者提出了通过调优LLMs来构建大型推荐语言模型的方法。实验证明,TALLRec框架可以显著提高LLMs在电影和图书领域的推荐能力,并且具有高效的执行速度和跨领域泛化能力。

11.Large Language Models as Zero-Shot Conversational Recommenders

大型语言模型作为零样本对话推荐器

「简述:」论文介绍了使用大型语言模型进行对话推荐任务的实证研究,主要贡献有以下三点:(1)构建了一个与推荐相关的对话数据集;(2)发现即使没有微调,大型语言模型也可以优于现有的微调后的对话推荐模型;(3)提出了探测任务来研究大型语言模型在对话推荐中出色表现的背后机制。

12.LlamaRec: Two-Stage Recommendation using Large Language Models for Ranking

使用大型语言模型进行两阶段推荐排名

「简述:」论文介绍了一种名为LlamaRec的两阶段框架,使用大型语言模型进行基于排名的推荐系统。作者提出了一种使用小型序列推荐器根据用户交互历史检索候选项的方法,然后将历史和检索到的项目通过精心设计的提示模板以文本形式输入到LLM中。该框架不生成长文本,而是将输出转换为候选项目的概率分布,从而高效地对项目进行排名。

13.RecMind: Large Language Model Powered Agent For Recommendations

基于大型语言模型的推荐代理

「简述:」论文介绍了一种名为RecMind的基于大型语言模型的自主推荐代理,能够通过仔细的计划、使用获取外部知识的工具和利用个人数据来提供精确的个性化推荐。作者提出了一种新的算法Self-Inspiring,以提高LLM代理的规划能力。实验表明,RecMind在不同的推荐任务中优于现有的基于LLM的推荐方法,并在与最近需要完全预训练的P5模型竞争的任务中取得了有竞争力的性能。

14.LLMRec: Large Language Models with Graph Augmentation for Recommendation

用于推荐的大语言模型与图增强

「简述:」论文提出了一种新的推荐系统框架LLMRec,利用大型语言模型的丰富知识和强大推理能力,增强推荐系统的性能。作者采用了三种简单而有效的LLM基于图的增强策略,包括强化用户-物品交互、增强对物品的理解和用户分析。此外,作者还开发了一种去噪数据机制,以确保增强的数据质量和可靠性。实验结果表明,LLMRec优于现有技术。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“LLM推荐”领取论文原文及源码

码字不易,欢迎大家点赞评论收藏!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!