部署yoloV8

2024-01-02 19:42:17

直接运行

import torch

model = torch.load('models/yolov8n.pt')

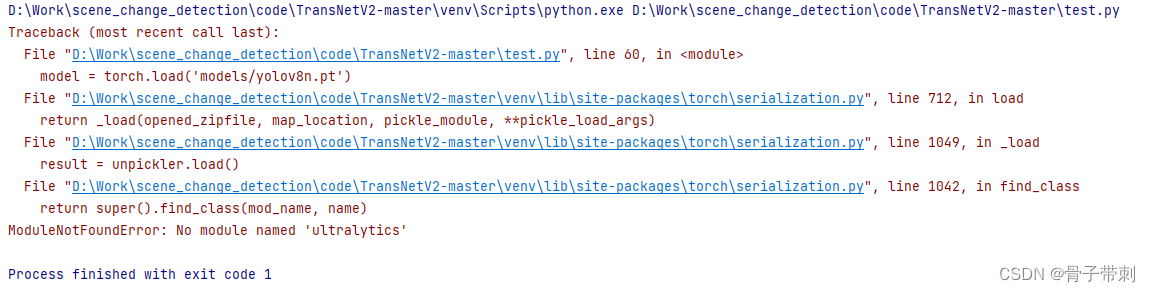

报错

解决

pip install ultralytics

加了个

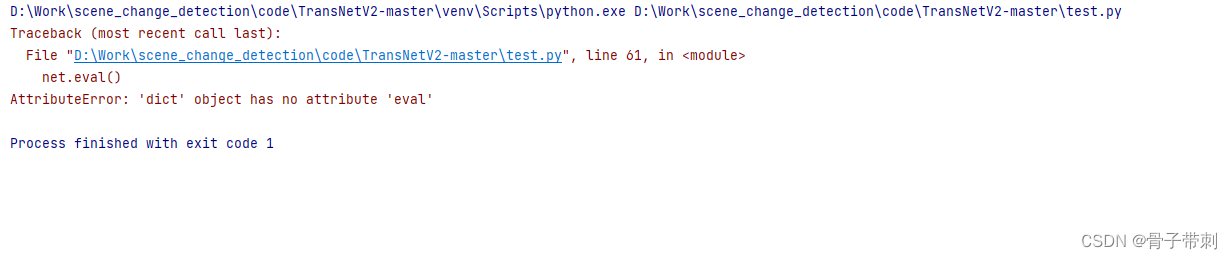

model.eval()

又报错了

原因是因为pt文件里面不包含网络结构,只有参数权重。

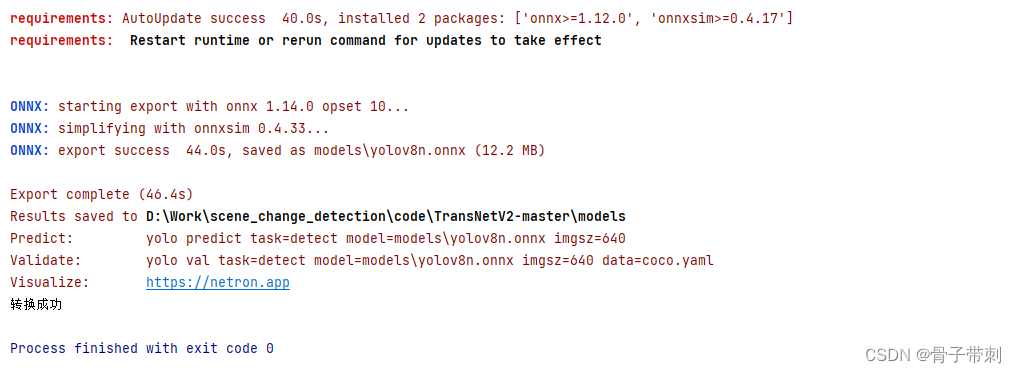

根据yolov8官网来做是这样

from ultralytics import YOLO

# Load a model

model = YOLO('models/yolov8n.pt') # load an official model

success = model.export(format="onnx", simplify=True) # export the model to onnx format

assert success

print("转换成功")

如果正常pt转成onnx的话,应该是这样的流程

import torch

net = torch.load('yolov8n.pt', map_location='cpu')

net.eval()

dummpy_input = torch.randn(1, 3, 640, 640)

torch.onnx.export(net, dummpy_input, 'yolov8n.onnx', export_params=True,

input_names=['input'],

output_names=['output'])

到现在的话,是有了onnx文件了。

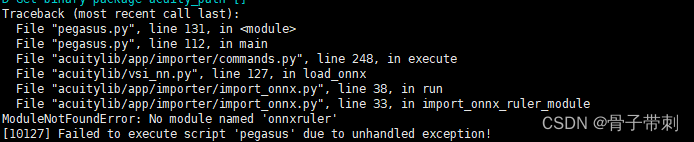

然后到板子上,使用acuity-toolkit-binary-6.9.1

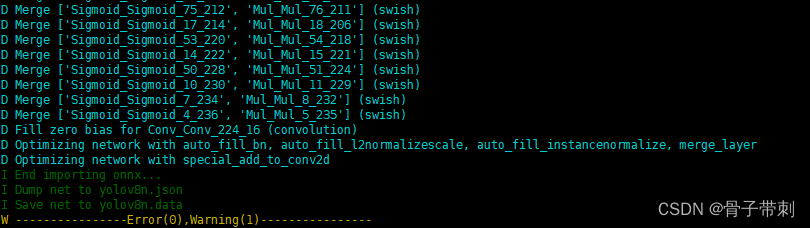

pegasus import onnx --model yolov8n.onnx --output-data yolov8n.data --output-model yolov8n.json

一直报错

这样修改,添加完整pegasus的路径

/home/yx/supernova/acuity/acuity-toolkit-binary-6.9.1/bin/pegasus import onnx --model yolov8n.onnx --output-data yolov8n.data --output-model yolov8n.json

/home/yx/supernova/acuity/acuity-toolkit-binary-6.9.1/bin/pegasus export ovxlib --model yolov8n.json --model-data yolov8n.data --dtype quantized --model-quantize yolov8n_uint8.quantize --batch-size 1 --save-fused-graph --target-ide-project 'linux64' --with-input-meta yolov8n_inputmeta.yml --postprocess-file yolov8n_postprocess_file.yml --output-path ovxlib/yolov8n/

文章来源:https://blog.csdn.net/weixin_36971177/article/details/131812258

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!