书生·浦语大模型全链路开源体系 学习笔记 第二课

2024-01-08 23:00:13

基础作业:

- 使用 InternLM-Chat-7B 模型生成 300 字的小故事(需截图)。

- 熟悉 hugging face 下载功能,使用

huggingface_hubpython 包,下载InternLM-20B的 config.json 文件到本地(需截图下载过程)。

进阶作业(可选做)

- 完成浦语·灵笔的图文理解及创作部署(需截图)

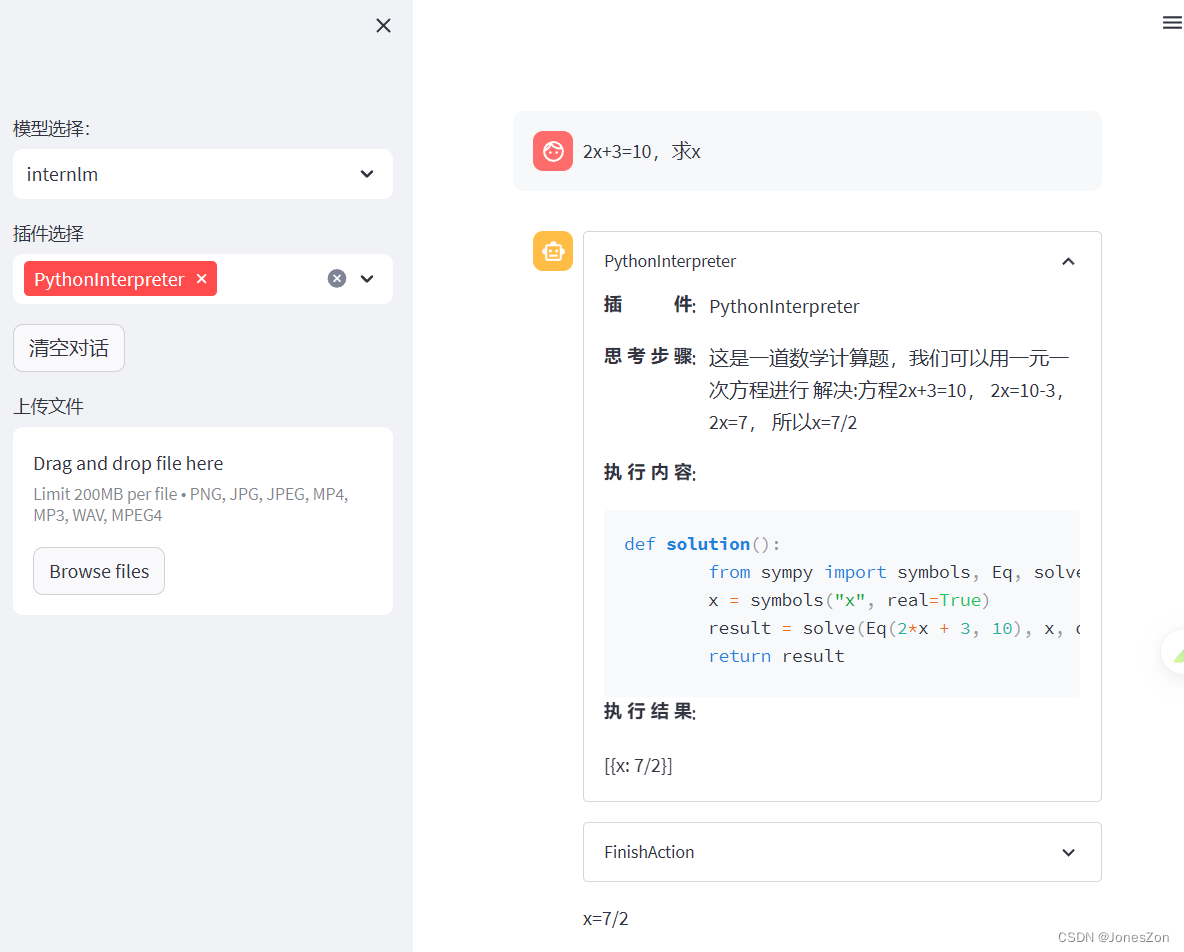

- 完成 Lagent 工具调用 Demo 创作部署(需截图)

课程文档与视频讲解,对应操作即可

?https://github.com/InternLM/tutorial/blob/main/helloworld/hello_world.md

轻松玩转书生·浦语大模型趣味Demo_哔哩哔哩_bilibili

轻松玩转书生·浦语大模型趣味 Demo (yuque.com)【github转载】

(1)InternLM-Chat-7B 模型生成 300 字的小故事

不知为何融入了字节跳动,无关大雅。大概几分钟即可生成

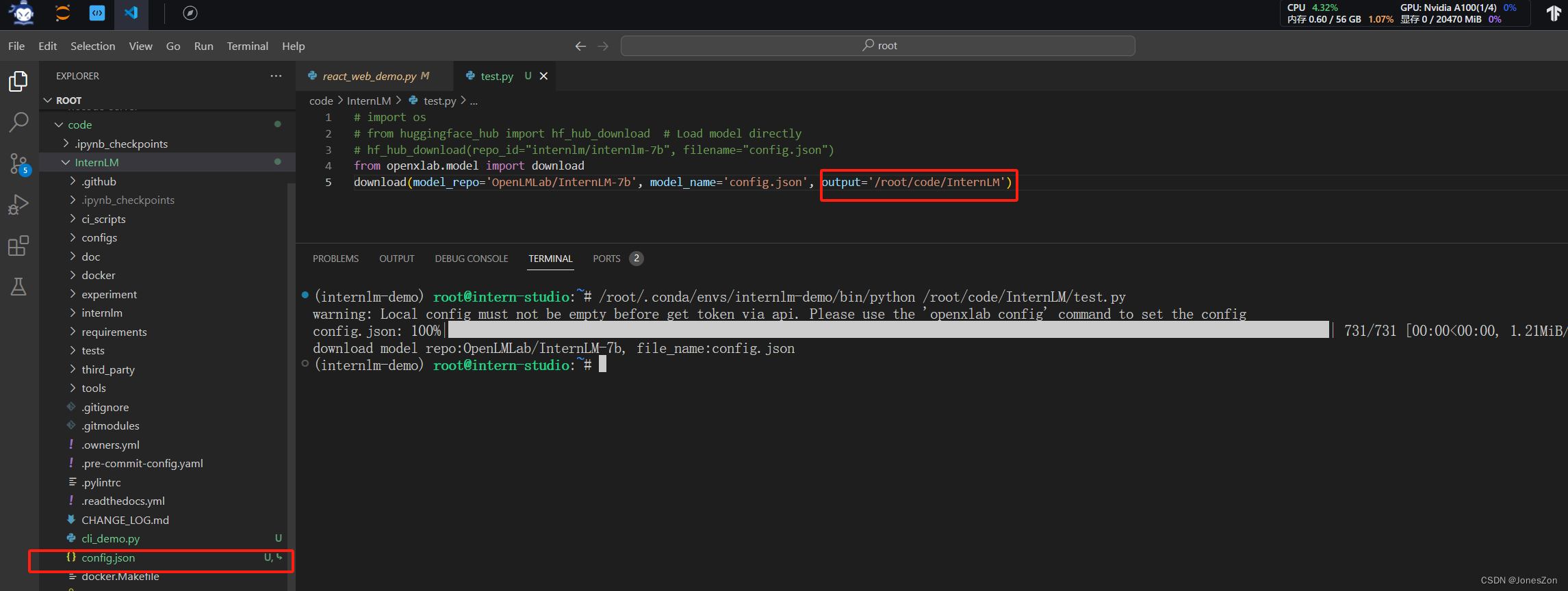

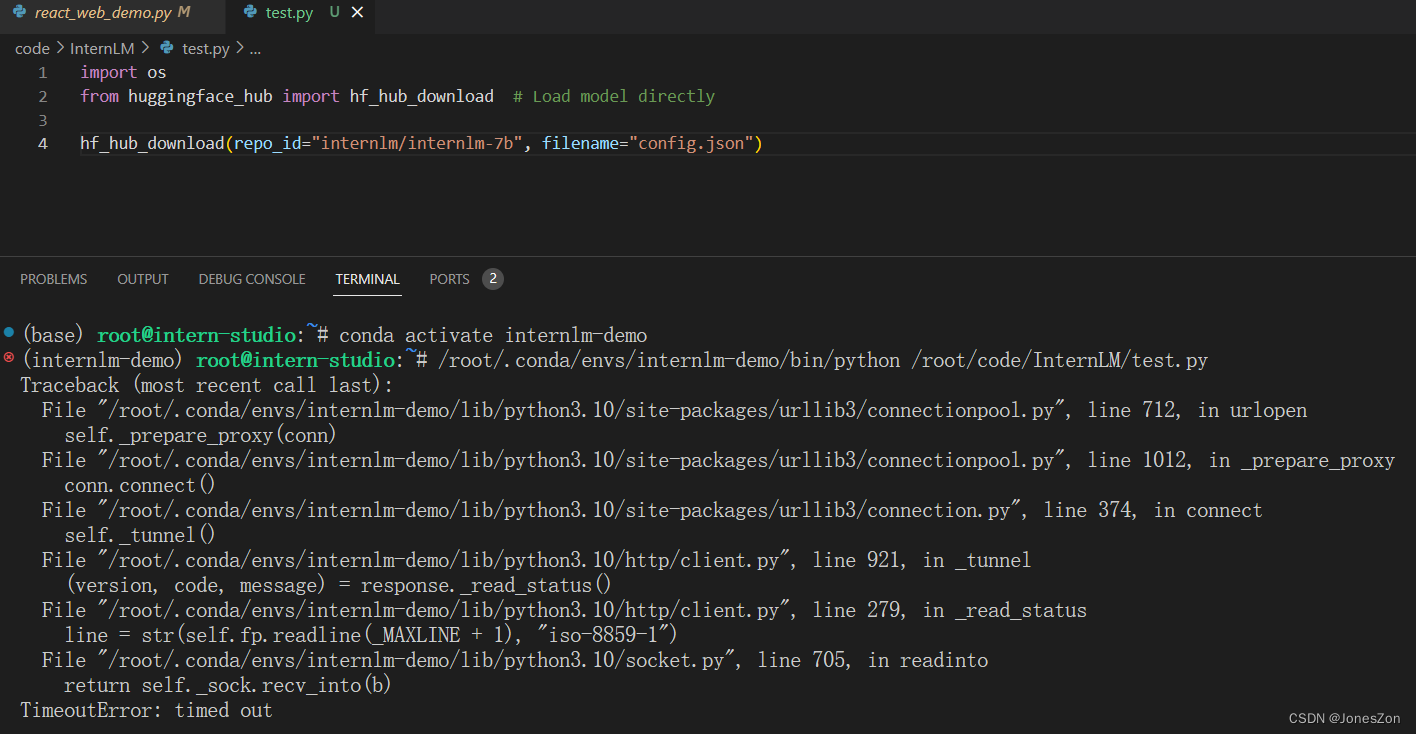

(2)熟悉 hugging face 下载功能

补充参考文章

hf-mirror.com - Huggingface 镜像站

报错,timeout,可能是没有选择镜像的原因。

根据其他同学的笔记,采用另外一种方式:使用OpenXLab库进行下载

【书生·浦语大模型实战营学习笔记】第 2 节 轻松玩转书生·浦语大模型趣味Demo - 知乎 (zhihu.com)

from openxlab.model import download

download(model_repo='OpenLMLab/InternLM-7b', model_name='config.json', output='/root/code/InternLM')(3)完成浦语·灵笔的图文理解及创作部署

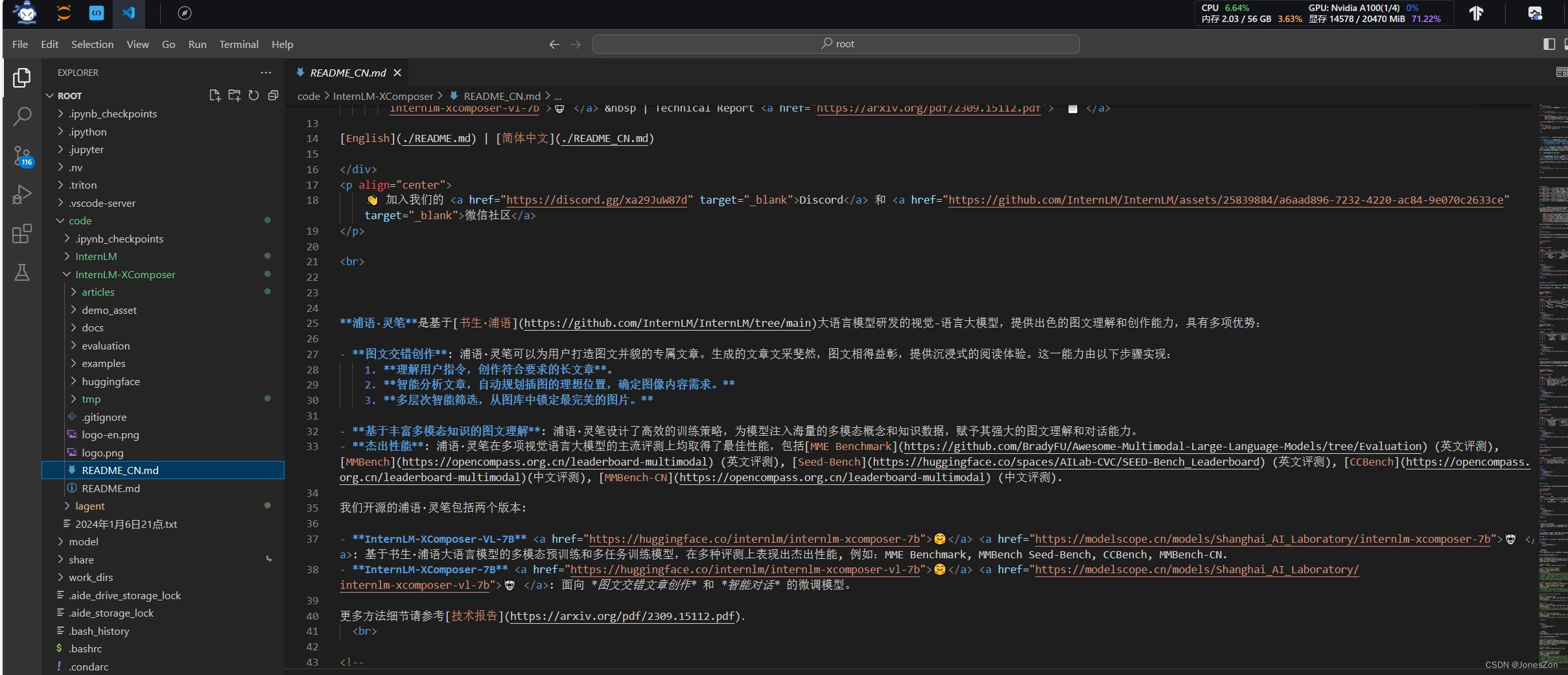

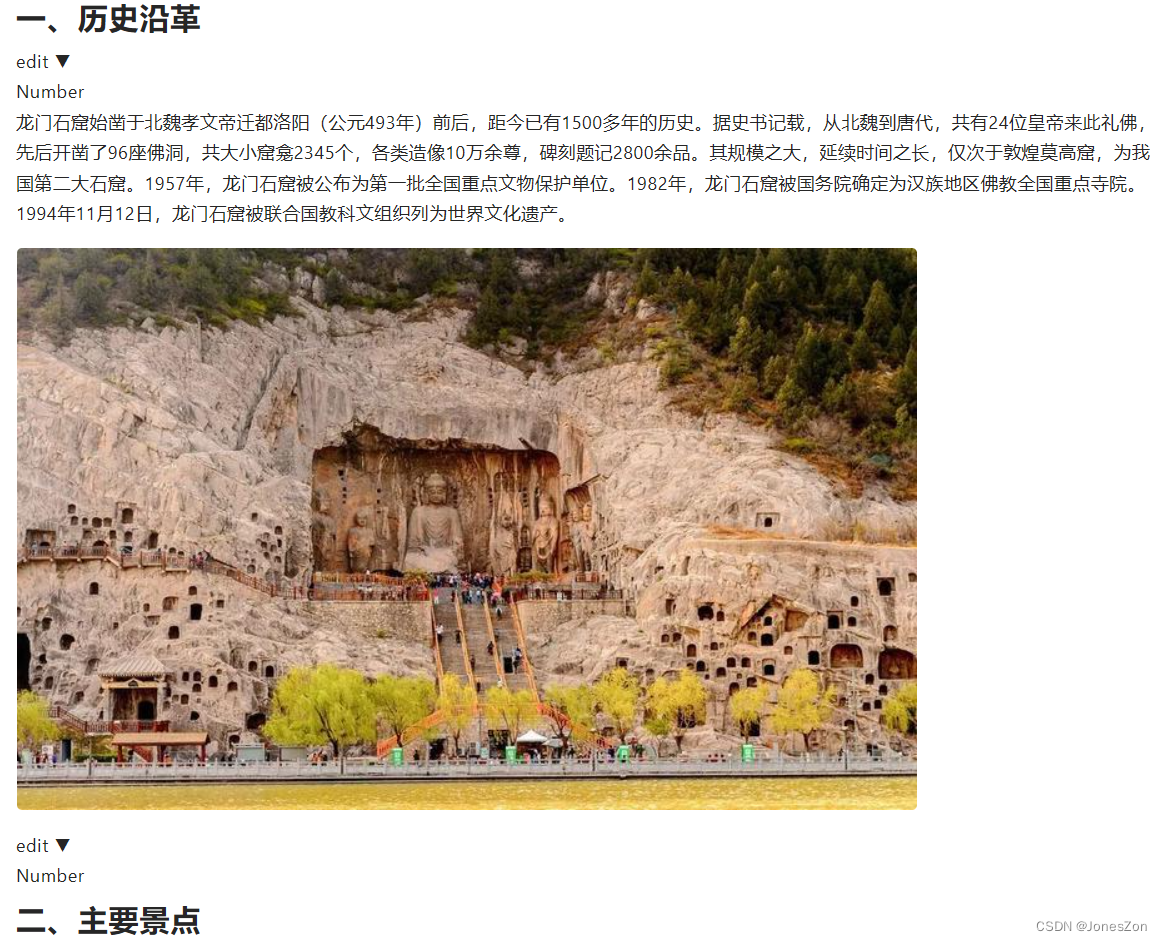

模型:internlm-xcomposer-7b

指令:生成关于龙门石窟的图文介绍。

webdemo:可以配置生成几个段文字,默认为5。先生成文字,再匹配图片。大概几分钟即可生成。

应用internlm-xcomposer-7b模型,图文生成过程中,显存占用最高可到90%以上

图文理解:

上传一张图片,可以让模型识别,并基于图片内容反馈用户提出的问题。暂时未尝试

(4)完成 Lagent 工具调用 Demo 创作部署

Python Interpreter可以理解为Python解释器,是一种将Python代码转化成计算机可执行代码的工具。每个Python版本都有其对应的Interpreter。通过配置Interpreter,我们可以确保我们的工作环境中使用的Python版本是正确的,并且可以方便地管理不同版本的Python。

可以体验更多的基于python的功能

文章来源:https://blog.csdn.net/sinat_41838539/article/details/135466375

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!