Spark中使用DataFrame进行数据转换和操作

Apache Spark是一个强大的分布式计算框架,其中DataFrame是一个核心概念,用于处理结构化数据。DataFrame提供了丰富的数据转换和操作功能,使数据处理变得更加容易和高效。本文将深入探讨Spark中如何使用DataFrame进行数据转换和操作,包括数据加载、数据筛选、聚合、连接和窗口函数等方面的内容。

DataFrame简介

DataFrame是一种分布式数据集,它以表格形式组织数据,每一列都有名称和数据类型。DataFrame是强类型的,这意味着它可以在编译时捕获错误,提供更好的类型安全性。可以将DataFrame视为关系型数据库表或Excel表格,但它具有分布式计算的能力。

数据加载

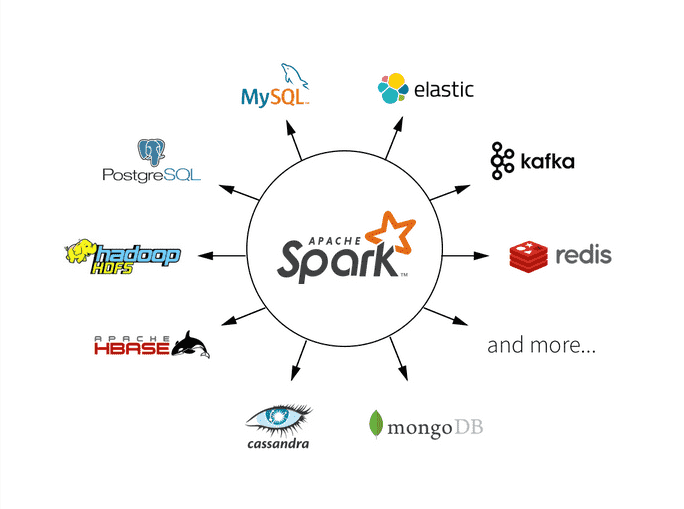

在使用DataFrame进行数据转换和操作之前,首先需要加载数据。Spark支持多种数据源,包括文本文件、JSON文件、Parquet文件、CSV文件、关系型数据库、Hive表等。以下是一些常见的数据加载示例:

1 从文本文件加载数据

from pyspark.sql import SparkSession

# 创建SparkSession

spark = SparkSession.builder.appName("DataLoadingExample").getOrCreate()

# 从文本文件加载数据

text_data = spark.read.text("data.txt")

# 显示数据

text_data.show()

2 从JSON文件加载数据

# 从JSON文件加载数据

json_data = spark.read.json("data.json")

# 显示数据

json_data.show()

3 从Parquet文件加载数据

# 从Parquet文件加载数据

parquet_data = spark.read.parquet("data.parquet")

# 显示数据

parquet_data.show()

4 从关系型数据库加载数据

# 配置数据库连接信息

jdbc_url = "jdbc:mysql://localhost:3306/mydb"

connection_properties = {

"user": "username",

"password": "password",

"driver": "com.mysql.jdbc.Driver"

}

# 从数据库加载数据

db_data = spark.read.jdbc(url=jdbc_url, table="mytable", properties=connection_properties)

# 显示数据

db_data.show()

数据转换和操作

一旦加载了数据,可以使用DataFrame进行各种数据转换和操作。以下是一些常见的数据转换和操作示例:

1 数据筛选

可以使用filter方法筛选满足条件的数据行:

# 筛选年龄大于30的数据

filtered_data = df.filter(df["age"] > 30)

# 显示筛选结果

filtered_data.show()

2 列选择

可以使用select方法选择要保留的列:

# 选择"name"和"age"列

selected_data = df.select("name", "age")

# 显示选择的列

selected_data.show()

3 列重命名

可以使用withColumnRenamed方法为列重命名:

# 将"name"列重命名为"full_name"

renamed_data = df.withColumnRenamed("name", "full_name")

# 显示重命名后的数据

renamed_data.show()

4 数据聚合

可以使用groupBy和聚合函数进行数据聚合:

from pyspark.sql import functions as F

# 按性别分组,并计算每组的平均年龄

aggregated_data = df.groupBy("gender").agg(F.avg("age").alias("average_age"))

# 显示聚合结果

aggregated_data.show()

5 数据连接

可以使用join方法连接不同的DataFrame:

# 连接两个DataFrame

joined_data = df1.join(df2, "id", "inner")

# 显示连接结果

joined_data.show()

6 窗口函数

窗口函数可以在DataFrame中执行聚合计算,同时保留原始行的信息。以下是一个窗口函数的示例:

from pyspark.sql.window import Window

# 定义窗口规范

window_spec = Window.partitionBy("department").orderBy("salary")

# 计算每个部门中工资最高的员工

max_salary_employee = df.withColumn("max_salary", F.max("salary").over(window_spec)) \

.filter(df["salary"] == df["max_salary"]) \

.drop("max_salary")

# 显示结果

max_salary_employee.show()

数据保存

在对数据进行转换和操作后,通常需要将结果保存回不同的数据源或文件中。Spark支持多种数据保存方式,以下是一些常见的数据保存方式:

1 保存数据到文本文件

# 保存数据到文本文件

text_data.write.text("output.txt")

2 保存数据到JSON文件

# 保存数据到JSON文件

json_data.write.json("output.json")

3 保存数据到Parquet文件

# 保存数据到Parquet文件

parquet_data.write.parquet("output.parquet")

4 保存数据到关系型数据库

# 保存数据到数据库

db_data.write.jdbc(url=jdbc_url, table="newtable", mode="overwrite", properties=connection_properties)

性能优化和注意事项

在使用DataFrame进行数据转换和操作时,性能优化是一个重要的考虑因素。以下是一些性能优化和注意事项:

1 数据分区

合理分区数据可以提高数据操作的并行性和性能。

# 重新分区数据

data.repartition(4)

2 数据缓存

对于频繁使用的DataFrame,可以使用cache或persist方法将数据缓存到内存中,以避免重复计算。

# 缓存数据到内存中

data.cache()

3 合并转换操作

合并多个数据转换操作可以减少数据扫描和计算开销,提高性能。

总结

Spark中的DataFrame是一个强大的工具,用于处理结构化数据,并提供了丰富的数据转换和操作功能。本文深入探讨了DataFrame的基本概念、数据加载、数据筛选、列选择、数据聚合、数据连接、窗口函数、数据保存以及性能优化和注意事项等方面的内容。

希望本文能够帮助大家更好地理解和使用DataFrame,在数据处理和分析任务中取得更好的效果和性能。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!