卷积神经网络18种有效创新方法汇总,涵盖注意力机制、空间开发等7大方向

作为深度学习中非常重要的研究方向之一,卷积神经网络(CNN)的创新不仅表现在提升模型的性能上,还更进一步拓展了深度学习的应用范围。

具体来讲,CNN的创新架构和参数优化可以显著提高模型在各种任务上的性能。例如,深度CNN使用多个非线性特征提取阶段从数据中自动学习分层表征,从而在各种竞赛基准上取得了当前最优结果。另外,CNN的创新也推动了科学研究和实际应用的发展,其创新不仅局限于网络结构,还包括损失函数设计、分类器设计等多个方面。

为让大家更好的掌握这些创新思路,以便将它们运用到自己的文章中,今天我就来和大家分享一些CNN的创新方法,主要涉及七大方向:基于空间开发、深度、多路径、宽度、特征映射、通道和注意力。

每种创新思路的配套论文及代码也都整理好了,需要的同学看文末

基于CNNs的空间开发

1.LeNet

论文:Gradient-Based Learning Applied to Document Recognition

基于梯度学习的文档识别

「简述:」神经网络和基于梯度的学习算法是处理高维数据如手写字符和文档的有效方法。通过设计适当的网络结构和训练方法,可以合成复杂的决策表面来分类这些数据,而无需太多预处理。特别是卷积神经网络,它特别适合处理二维形状的变化,因此在手写字符识别等任务中表现最好。此外,图变换网络是一种新的训练范式,可以使多个模块组成的系统进行全局训练,以实现更高的性能。

2.Alexnet

论文:ImageNet Classification with Deep Convolutional Neural Networks

使用深度卷积神经网络进行ImageNet分类

「简述:」作者训练了一个很大的深度卷积神经网络,用来把120万张高分辨率图片分成1000类。这个网络有6千万个参数和65万个神经元,包括五个卷积层、一些最大池化层和三个全连接层,最后是一个1000层的softmax。作者用非饱和神经元和高效的GPU实现来让它训练得更快,还用了称为“dropout”的新正则化方法来防止过拟合。这个模型在ILSVRC-2012竞赛中获得了top-5错误率为15.3%的好成绩,而第二名的错误率是26.2%。

3.ZfNet

论文:Visualizing and Understanding Convolutional Networks

可视化和理解卷积网络

「简述:」大型卷积神经网络模型在ImageNet基准测试中表现出色,但原因和改进方式不明确。本文通过一种新的可视化技术,让我们了解特征层和分类器的工作方式,并找到更好的模型架构。作者还研究了不同模型层对性能的贡献,发现模型可以很好地推广到其他数据集。当重新训练分类器时,它在Caltech-101和Caltech-256数据集上取得了最佳成绩。

4.VGG

论文:VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION

用于大规模图像识别的非常深的卷积网络

「简述:」本文研究了卷积神经网络深度对其在大规模图像识别设置中的准确性的影响。作者的主要贡献是使用具有非常小的(3×3)卷积滤波器的架构对增加深度进行全面的评估,表明通过将深度推到16-19个权重层可以对先前的艺术配置进行重大改进。

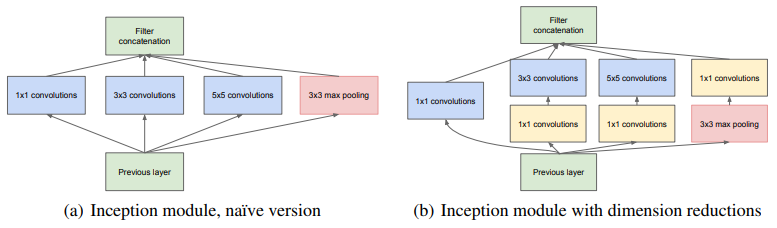

5.GoogleNet

论文:Going deeper with convolutions

深入探索卷积神经网络

「简述:」论文提出了一个名为Inception的深度卷积神经网络架构,它打破了ImageNet大规模视觉识别挑战赛中的分类和检测纪录。这个架构的特点是更有效地利用了网络内部的计算资源。通过精心设计,我们可以在保持计算预算不变的同时增加网络的深度和宽度。这个架构的设计基于Hebbian原理和多尺度处理的直观性,以提高质量。在ILSVRC14挑战赛中,作者使用了一种特定变体,称为GoogLeNet,这是一个22层深的网络,其分类和检测效果都非常出色。

基于深度的CNNs

1.Highway Networks

论文:Highway Networks

高速神经网络

「简述:」神经网络的深度对其成功至关重要,但训练深度增加会变得更难。论文介绍了一种新架构,称为高速神经网络,旨在简化深度网络的训练。这种网络允许信息在多层次之间顺畅流动,由门控单元调节。这种架构允许使用随机梯度下降法直接训练数百层网络,并使用各种激活函数,从而开辟了研究深度高效网络的可能性。

2.ResNet

论文:Deep Residual Learning for Image Recognition

用于图像识别的深度残差学习

「简述:」本文介绍了一种名为残差学习框架的方法,可以更容易地训练深度神经网络。通过重新定义层为学习残差函数,这些网络可以更优化且具有更高的准确性。在ImageNet数据集上,评估了深度达152层的残差网络,并获得了第一名。此外,作者还对CIFAR-10进行了分析。该方法的深度表示对于许多视觉识别任务非常重要,并在COCO对象检测数据集上获得了28%的相对改进。

3.Inception V4

论文:Inception v4, Inception-ResNet and the Impact of Residual Connections on Learning

Inception v4、Inception-ResNet和残差连接对学习的影响

「简述:」深度卷积神经网络和Inception架构在图像识别方面有很大进步。使用残差连接可以加速Inception网络的训练并提高性能。新型流线型架构可提高识别性能,适当的激活缩放有助于稳定训练。通过集成三个残差架构和一个Inception-v4,作者在ImageNet挑战的测试集上实现了3.08%的top-5错误率。

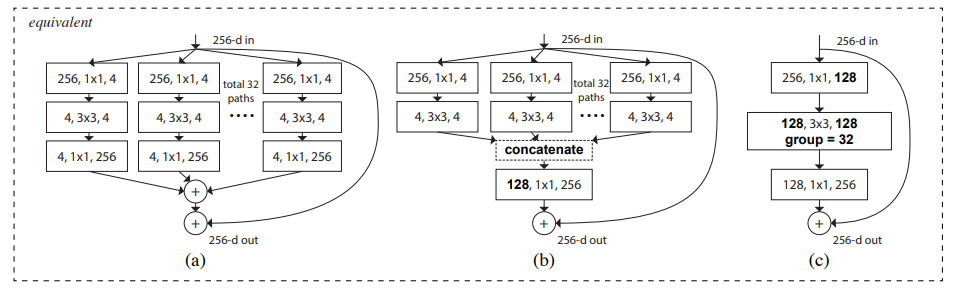

4.ResNext

论文:Aggregated Residual Transformations for Deep Neural Networks

深度神经网络的聚合残差变换

「简述:」本文介绍了一种简单、高度模块化的用于图像分类的网络架构。该网络通过重复一组具有相同拓扑的变换来构建,形成一个同构的多分支架构,只需要设置很少的超参数。在ImageNet-1K数据集上,作者发现增加基数能够提高分类准确性。该模型名为ResNeXt,在ILSVRC 2016分类任务中获得了第二名。作者还进一步研究了ResNeXt在ImageNet-5K集和COCO检测集上的表现,也显示出比其对应的ResNet更好的结果。

基于多路径的CNNs

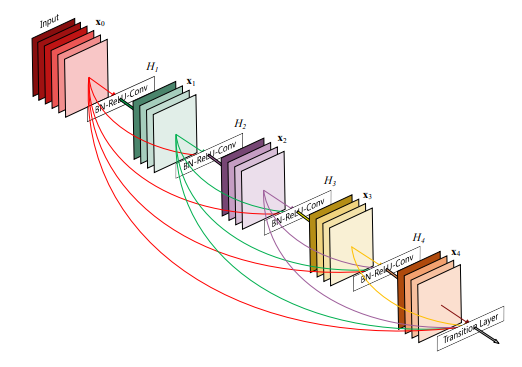

1.DenseNet

论文:Densely Connected Convolutional Networks

稠密连接神经网络

「简述:」DenseNet是一种新的卷积神经网络架构,它将每一层都直接连接到其他所有层。这使得网络在训练时更加深入、准确和高效。与传统的卷积神经网络相比,DenseNet具有几个优点:它可以缓解梯度消失问题,增强特征传播,鼓励特征重用,并减少参数数量。在四个基准测试任务中,DenseNet表现出了显著优于现有技术的性能,同时需要的计算量更少。

基于宽度的多连接CNNs

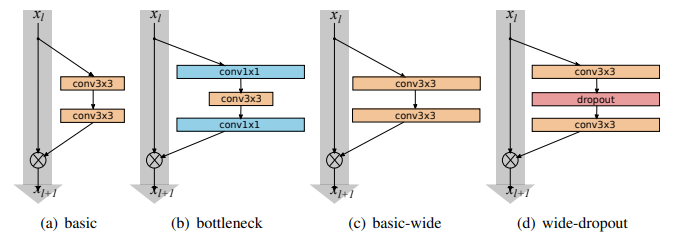

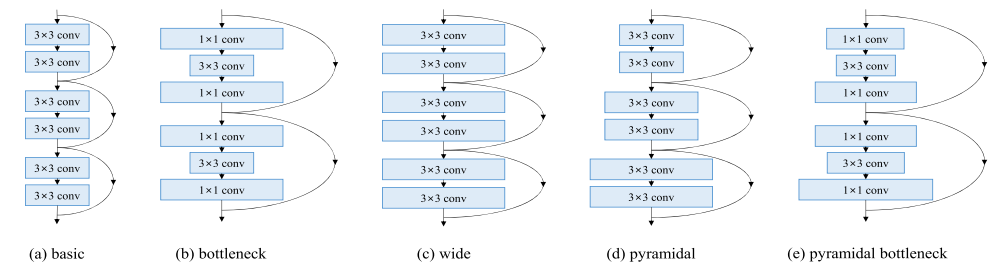

1.WideResNet

论文:Wide Residual Networks

宽残差网络

「简述:」宽残差网络(WRN)是一种新型的深度残差网络架构,通过减少深度并增加宽度来优化网络结构。相比传统的深度残差网络,WRN具有更高的准确率和更快的训练速度。实验证明,即使是16层深的WRN也比以前所有深度残差网络表现更好,并在多个数据集上取得了最佳结果。

2.Pyramidal Net

论文:Deep Pyramidal Residual Networks

深度金字塔残差网络

「简述:」深度卷积神经网络在图像分类上表现优秀。通常,这种网络包含很多卷积层,并在空间维度上进行下采样以减少内存使用。然而,这样会导致特征图维度(通道数)在采样点突然增加,有助于提高性能。另一种叫残差网络也与此相关。但这里,作者没有在下采样部分突然增加特征图维度,而是让所有部分逐渐增加,这样能提升网络的泛化能力。作者还提出了一种新的残差单元,能让分类更准确。

3.Xception

论文:Xception: Deep Learning with Depthwise Separable Convolutions

深度可分离卷积的深度学习

「简述:」论文解释了Inception模块是卷积和深度可分离卷积之间的中间步骤。深度可分离卷积被理解为具有最多塔的Inception模块。因此,作者提出了一种新的架构,用深度可分离卷积替换Inception模块,称为Xception。它在ImageNet数据集上略优于Inception V3,并在更大的图像分类数据集上显著优于Inception V3。由于参数数量相同,性能提升是由于更有效地利用了模型参数。

基于特征映射的CNN开发

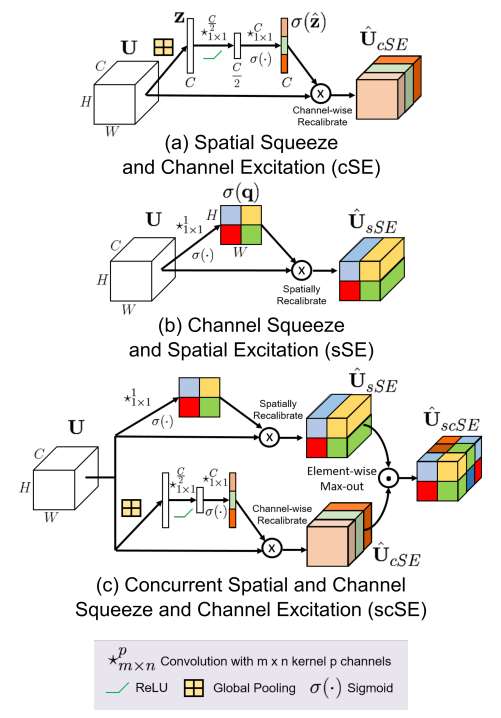

1.Squeeze and Excitation

论文:Squeeze-and-Excitation Networks

挤压和激励网络

「简述:」卷积神经网络通过融合空间和通道信息来构建特征。本文提出了一种新的建筑单元“挤压-激励”块,通过建模通道之间的相互依赖关系来重新校准通道特征响应,从而显著提高性能。SENet架构泛化效果非常好,稍微增加计算成本就能带来显著的性能提升。

基于(输入)通道利用的 CNN

1.Channel Boosted CNN using TL

论文:A New Channel Boosted Convolutional Neural Network using Transfer Learning

使用迁移学习的一种新的通道增强卷积神经网络

「简述:」论文提出了一种新的技术,称为“通道增强”,用于增强深度卷积神经网络(CNN)的性能。该技术利用了CNN的通道维度和迁移学习思想。在两个不同阶段应用了迁移学习:通道生成和通道利用。作者使用已经训练好的深度神经网络来获取各种通道,并添加到原始通道中,以增强深度CNN的性能。

基于注意力的CNNs

1.Residual Attention Neural Network

论文:Residual Attention Network for Image Classification

用于图像分类的残差注意力网络

「简述:」论文提出了“残差注意力网络”,这是一种使用注意力机制的深度卷积神经网络,可以结合最先进的馈送网络架构进行训练。该网络可以自适应地改变注意力感知特征,随着层数的增加,特征会发生变化。每个注意力模块都有自下而上和自上而下的前馈和反馈结构,将前馈和反馈过程合并为单一前馈过程。作者还提出了注意力残差学习,以训练非常深的网络。

2.Convolutional Block Attention

论文:CBAM: Convolutional Block Attention Module

卷积块注意力模块

「简述:」论文提出了一种叫做CBAM的注意力模块,可以增强卷积神经网络的表现。这个模块能够同时关注通道和空间两个维度,对输入特征图进行细化。这个模块轻量级且通用,可以无缝集成到任何CNN架构中,并可以进行端到端的训练。在多个数据集上的实验结果表明这个模块可以提高分类和检测的性能。

3.Concurrent Squeeze and Excitation

论文:Recalibrating Fully Convolutional Networks with Spatial and Channel 'Squeeze & Excitation' Blocks

使用空间和通道“压缩-激励”块重新校准全卷积网络

「简述:」全卷积神经网络(F-CNN)是用于语义分割任务的一种成功模型。论文提出了一种新的方法,通过重新校准学到的特征图来改进它。这涉及到增强重要特征并抑制较弱特征。为此,作者引入了“挤压和激励”(SE)模块,它是一种简单且有效的计算块,可以轻松集成到F-CNN架构中。作者在三个最先进的F-CNN模型中实施了这些SE模块,并在三个具有挑战性的基准数据集上进行了测试,结果显示分割精度得到了显著提高。

?

关注下方《学姐带你玩AI》🚀🚀🚀

回复“CNN创新”获取全部论文+开源代码

码字不易,欢迎大家点赞评论收藏

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!