深度学习记录--随机初始化

2023-12-17 15:30:56

权重

权重,指的是变量系数w,决定了变量的变化率

它会改变dw,进而改变下一轮的w(改变更新)

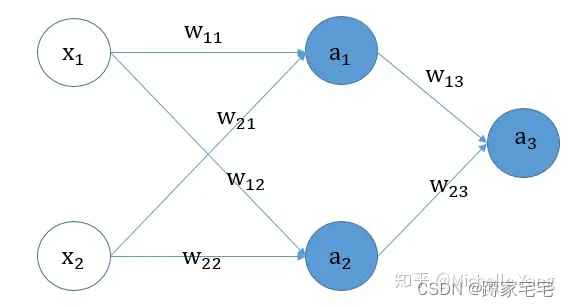

神经网络的权重

对于神经网络(含隐藏层)

由于权重的对称性,我们的隐层的神经单元输出始终不变,出现隐藏神经元的对称性

这种对称性会导致a值和w值无法进行正常的迭代更新,导致每层的节点作用式微,神经网络也就失去其作用了

?

一般来说,模型所有的权重w随机初始化,所有偏置b初始化为0

这种方法,在反向传播的过程中所有权重的导数都不相同,所以权重和偏置b都能得到更新

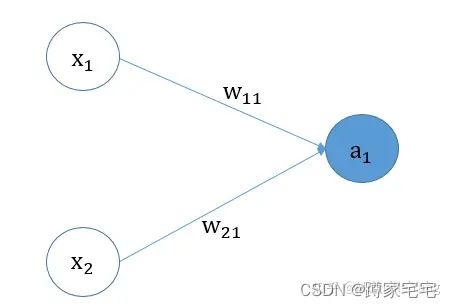

logistic回归的权重

下图是logistic回归的示例图

尽管当w1,w2为0时,依然可以有x1,x2不同使dw1,dw2不同,重新改变w1,w2,起到不断迭代的作用

同理,当b为0时,也是可以依照同样的过程使b重新改变,起到不断迭代的作用

辨析

总体来说,节点权重的对称性与权重的初始化对于迭代更新有着巨大的作用

一般都要将权重w随机初始化,同时附上一个适当小的常量系数(对于tanh激活函数可以让更新率变快)

更多细节详见参考文章谈谈神经网络权重为什么不能初始化为0 - 知乎 (zhihu.com)

文章来源:https://blog.csdn.net/Xudong_12345/article/details/135038381

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!