scikit-learn文档中的数据生成器

2023-12-28 10:39:21

目录

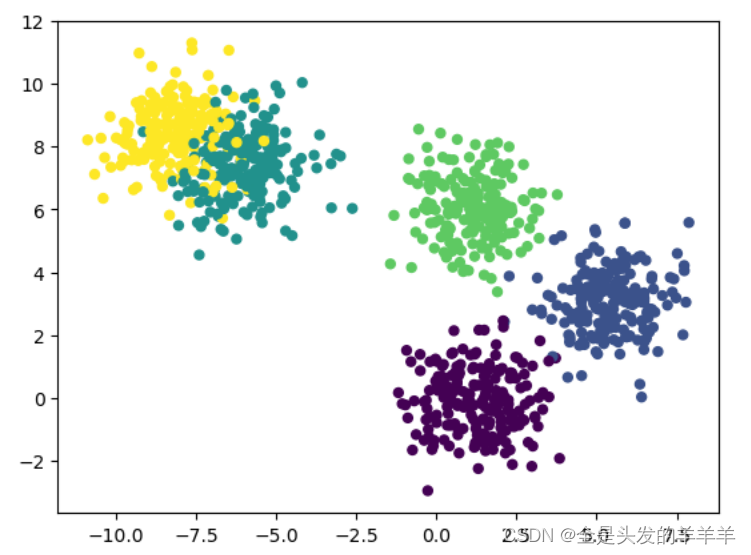

1. make_classification:

这是一个用于生成复杂二维数据的函数,通常用于可视化分类器的学习过程或者测试机器学习算法的性能。

from sklearn.datasets import make_classification

X, y = make_classification(n_samples=1000, n_features=20, n_classes=3)

make_classification的主要参数包括:

- n_samples:生成的样本数。

- n_features:每个样本的特征数。这个参数决定了生成的数据集的维度。

- n_informative:具有信息量的特征的数量。这个参数决定了特征集中的特征有多少是有助于分类的。

- n_redundant:冗余特征的数量。这个参数决定了特征集中的特征有多少是重复或者没有信息的。

- random_state:随机数生成器的种子。这确保了每次运行代码时生成的数据集都是一样的。

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

X, Y = make_classification(n_samples=100, n_classes=4, n_clusters_per_class=1)

plt.scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

plt.show()?

可以看出它生成的各类数据交织在一起,很难做线性的分类。

2. make_regression:

生成一个随机的回归问题数据集,可以设置特征数量、噪声等级等。示例:

from sklearn.datasets import make_regression

X, y = make_regression(n_samples=100, n_features=2)

make_regression的主要参数包括:

- n_samples:生成的样本数。

- n_features:每个样本的特征数。通常为一个较小的值,表示我们生成的是一维数据。

- noise:噪音的大小。它为数据添加一些随机噪声,以使结果更接近现实情况。

from sklearn.datasets import make_regression

fig, ax = plt.subplots(1, 3)

fig.set_size_inches(9, 3)

X, y = make_regression(n_samples=100, n_features=1, noise=20)

ax[0].scatter(X[:, 0], y, marker="o")

ax[0].set_title("noise=20")

X, y = make_regression(n_samples=100, n_features=1, noise=10)

ax[1].scatter(X[:, 0], y, marker="o")

ax[1].set_title("noise=10")

X, y = make_regression(n_samples=100, n_features=1, noise=1)

ax[2].scatter(X[:, 0], y, marker="o")

ax[2].set_title("noise=1")

plt.show()?

3. make_blobs:

生成一组聚类问题的数据集,可以设置聚类数量、中心点数量、特征数量等。示例:

from sklearn.datasets import make_blobs

X, y = make_blobs(n_samples=300, centers=4, n_features=2)

make_blobs的主要参数包括:

- n_samples:生成的样本数。

- n_features:每个样本的特征数。通常为2,表示我们生成的是二维数据。

- centers:聚类的数量。即生成的样本会被分为多少类。

- cluster_std:每个聚类的标准差。这决定了聚类的形状和大小。

- shuffle:是否在生成数据后打乱样本。

- random_state:随机数生成器的种子。这确保了每次运行代码时生成的数据集都是一样的。

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

X, Y = make_blobs(n_samples=1000, centers=5)

plt.scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

plt.show()?

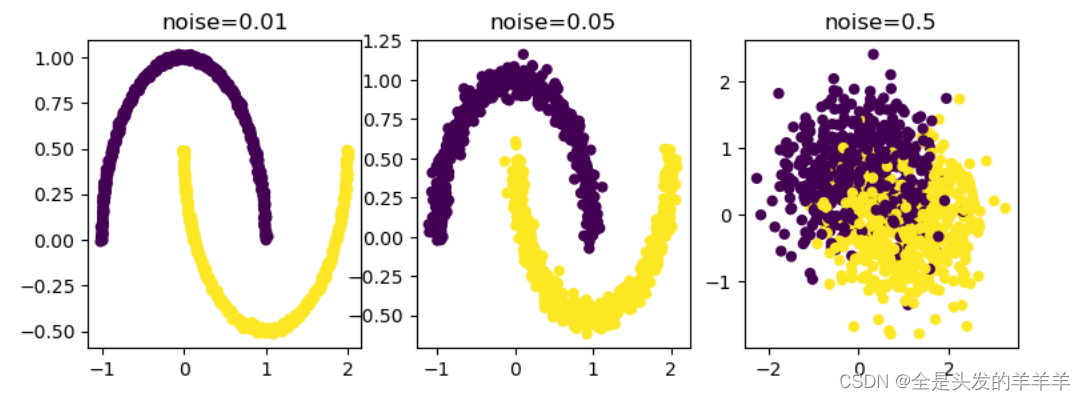

4.?make_moons:

和函数名称所表达的一样,它是一个用于生成形状类似于月牙的数据集的函数,通常用于可视化分类器的学习过程或者测试机器学习算法的性能。

from sklearn.datasets import make_moons

X2, y2 = make_moons(n_samples=1000, noise=0.1)

make_moons的主要参数包括:

- n_samples:生成的样本数。

- noise:在数据集中添加的噪声的标准差。这个参数决定了月牙的噪声程度。

- random_state:随机数生成器的种子。这确保了每次运行代码时生成的数据集都是一样的。

from sklearn.datasets import make_moons

fig, ax = plt.subplots(1, 3)

fig.set_size_inches(9, 3)

X, Y = make_moons(noise=0.01, n_samples=1000)

ax[0].scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

ax[0].set_title("noise=0.01")

X, Y = make_moons(noise=0.05, n_samples=1000)

ax[1].scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

ax[1].set_title("noise=0.05")

X, Y = make_moons(noise=0.5, n_samples=1000)

ax[2].scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

ax[2].set_title("noise=0.5")

plt.show()?

?noise越小,数据的分类越明显。

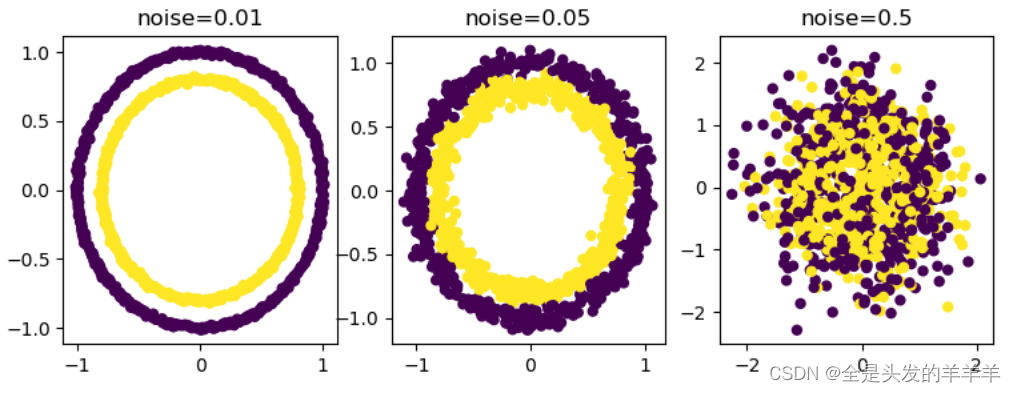

5.make_circles?

from sklearn.datasets import make_circles

X1, y1 = make_circles(n_samples=1000, noise=0.05)

参数和上面一样

from sklearn.datasets import make_circles

fig, ax = plt.subplots(1, 3)

fig.set_size_inches(9, 3)

X, Y = make_circles(noise=0.01, n_samples=1000)

ax[0].scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

ax[0].set_title("noise=0.01")

X, Y = make_circles(noise=0.05, n_samples=1000)

ax[1].scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

ax[1].set_title("noise=0.05")

X, Y = make_circles(noise=0.5, n_samples=1000)

ax[2].scatter(X[:, 0], X[:, 1], marker="o", c=Y, s=25)

ax[2].set_title("noise=0.5")

plt.show()?

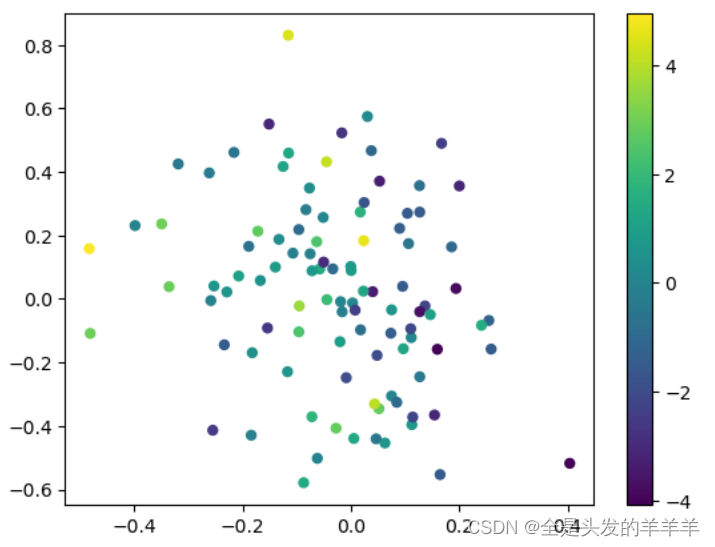

6. make_sparse_coded_signal:

生成一个稀疏编码信号数据集,用于稀疏信号恢复问题。示例:

from sklearn.datasets import make_sparse_coded_signal

X, y, w = make_sparse_coded_signal(n_samples=100, n_components=20)

?

make_sparse_coded_signal的主要参数包括:

n_samples(int):生成的样本数量。默认值为 100。

n_components(int):生成的信号的原子数量(即特征数)。默认值为 10。

n_features(int):样本的特征数。默认值为 100。

n_nonzero_coefs(int):每个样本中非零系数的数量。默认值为 10。

random_state(int或RandomState实例,可选):用于随机数生成器的种子。默认值为 None。

normalize_dictionary(boolean):是否对生成的字典进行归一化处理。默认值为 True。

该函数返回三个值:

X:生成的稀疏信号数据集,包含了

n_samples个样本和n_features个特征。y:样本的目标值或标签。

dictionary:用于生成信号的字典或基向量。

from sklearn.datasets import make_sparse_coded_signal

import matplotlib.pyplot as plt

X, y, dictionary = make_sparse_coded_signal(n_samples=100, n_components=20, n_features=100, n_nonzero_coefs=5, random_state=42)

plt.scatter(X[:, 0], X[:, 1], marker="o", c=X.sum(axis=1), cmap='viridis', s=25) # 使用样本特征值的和来作为颜色的映射

plt.colorbar() # 添加颜色条

plt.show()?

文章来源:https://blog.csdn.net/qq_55552561/article/details/135180988

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!