九州未来大模型一体机,加速AI应用落地

2023年已接近尾声,对于中国人工智能产业而言,这一年注定成为一个重要的转折点。在不同行业中,人工智能的应用不断涌现,众多大模型如雨后春笋般涌现。然而,在这一发展过程中也不可避免地出现了一系列问题,包括数据隐私与安全、安全性和滥用以及模型迭代速度快但推理性能不佳等。

但是这远不能阻止人工智能的大力发展,拥抱人工智能是势在必行的选择。缺少AI能力的企业,也需要“只有先上车后补票”方能乘上AI的东风。

九州未来大模型一体机就如同一辆奔驰在AI赛道的快车,一个U盘即可快速启动一体机服务。

五大特性

九州未来大模型一体机具备以下五大特性:

- 高性能训练和推理:基于优秀的虚拟化、NVIDIA AI Enterprise实现强大的微调和推理能力。

- 私有化部署:私有化部署到客户现场,实时备份数据。

- 极简运维:一键部署大模型相关服务,内置大模型支持持续升级。

- 需求快速落地:提供丰富的可定制化功能如知识库、提示词工程;内置稳定基础模型和行业大模型。

- 支持国产信创:天然支持国产硬件和国产操作系统。

整体而言,九州未来大模型一体机是一款“硬件+软件+服务”一体式的AIGC解决方案。

丰富的产品功能

九州未来大模型一体机承载了诸多优质的大模型精选体验,用户能够更好地学习、评估模型。点击进入某模型的详情页,即可与大语言模型进行丝滑交互。对于选择好基础模型的用户,提供全流程的向导式服务,训练过程中的训练数据实时可查,用户可轻松基于数据集、使用最好的超参数完成微调任务。

在大模型的应用方面,当前版本的一体机支持两种产品模式完成AI生成式内容。

首先是提示词工程,通过预设的多种提示模板,用户能够快速生成高质量的内容:以测试工程师为例,测试工程师通过大模型快速生成高质量的测试用例、测试脚本、测试计划、测试数据和测试场景。

第二种形式是基于向量数据库的知识库服务,用户无需数据清洗,将各类文档如TXT、PDF、Docs上传至知识库,向量解析完成后,即可通过自然语言轻松调用上传物料中的内容。

产品架构

九州未来大模型一体机的整体架构如下图所示,硬件层支持各型号NVIDIA GPU,并通过上层的九州未来Animbus智算平台实现自动识别底层硬件并适配显卡驱动。基于NVIDIA AI Enterprise开发平台提供了强大的大模型微调推理能力,如ChatGLM、LLma2,相较于大模型推理框架有显著提升。

性能对比

对于终端用户而言,只需打开浏览器,就能迅速开启AI体验。在推理服务上,九州未来大模型一体机搭载了NVIDIA AI Enterprise并完成了深度的定制化开发,实现了强大的性能提升。我们来看一组对照组实验:

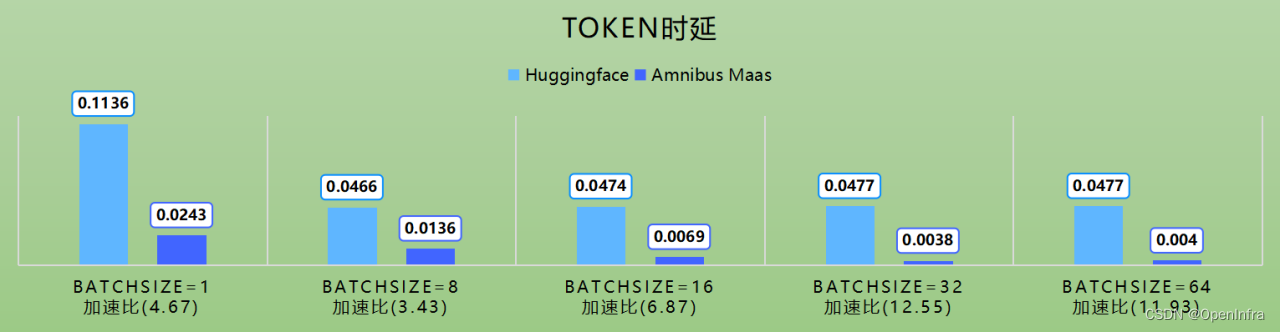

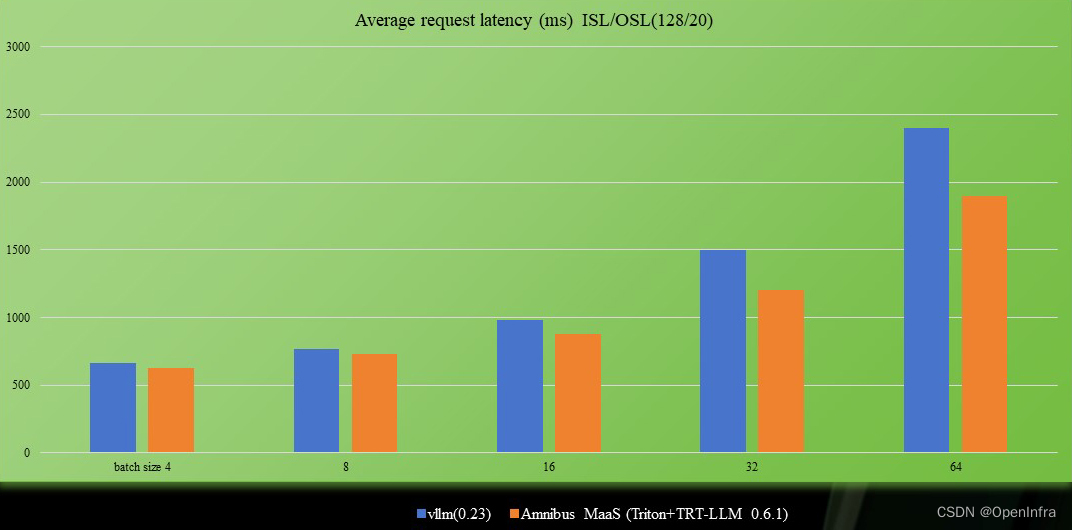

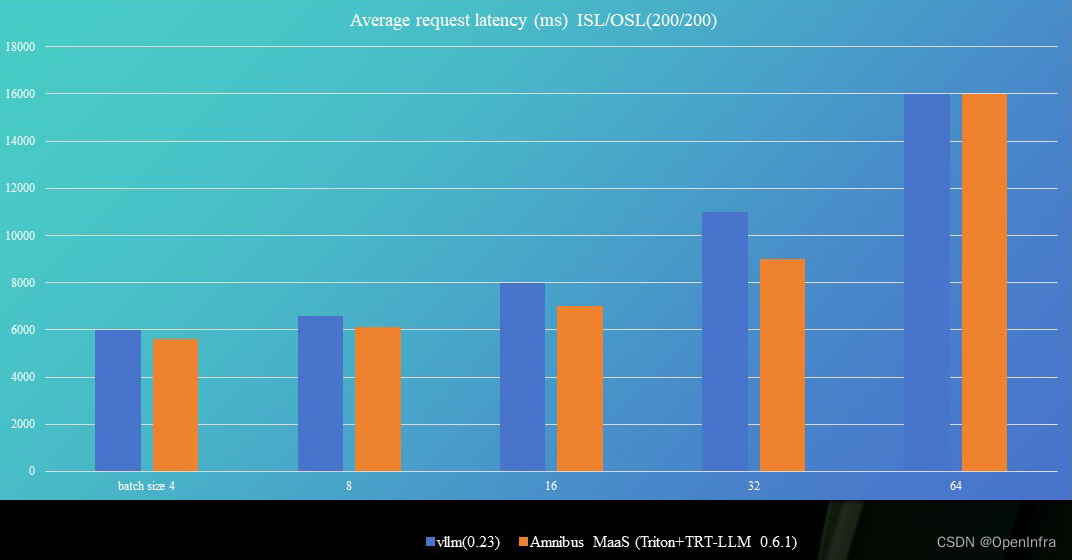

- 大模型一体机通过Tensorrt-LLM+Triton作为推理套件,与Huggingface的accelerate fastapi uvicorn transformers进行对比,整体推理加速比性能提升1200%左右。

- 多个关键参数如Tokens per second ISL/OSL(128/20)、Average request latency (ms) ISL/OSL(128/20)、Tokens per second ISL/OSL(200/200)都有显著提升。

强大的推理能力能够实现效率的提升,性能将持续优化,推理能力将持续升级。

九州未来大模型一体机也将持续演进,为更多领域的用户提供更智能、更强大的解决方案。拥抱人工智能的浪潮,不仅意味着跟随时代的步伐,更是为了在竞争激烈的市场中保持领先地位。只要我们始终保持对技术创新的热忱,相信未来将会有更多令人振奋的人工智能应用场景得以实现。

九州未来大模型一体机,助力你在人工智能的未来赛道上奔驰。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!