EfficientNet

2023-12-28 22:31:33

时间:2019

EfficicentNet网络简介

EfficientNet:Rethinking Model Scaling for Convolutional Neural Networks![]() https://arxiv.org/abs/1905.11946,这篇论文是Google在2019年发表的文章。

https://arxiv.org/abs/1905.11946,这篇论文是Google在2019年发表的文章。

EfficientNet这篇论文,作者同时关于输入分辨率,网络深度,宽度对准确率的影响,在之前的文章中是单独增加图像分辨率或增加网络深度或单独增加网络的宽度,来试着提升网络的准确率。在EfficientNet这篇论文中,作者使用了网络搜索技术NAS去同时探索输入分辨率,网络深度、宽度的影响。

EfficientNet的效果究竟如何呢?

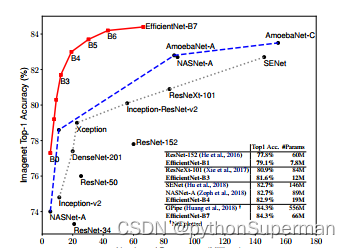

这幅图是原论文作者给出的关于Efficient以及当时主流的一系列分类网络的Top-1的准确率,我们发现EfficientNet不仅在参数数量上比很多主流模型要小以外,准确率明显也要更好。

- 论文中提到,本文提出的

EfficientNet-B7在ImageNet top-1达到了当年最高的准确率84.3%,与之前准确率最高的GPipe相比,参数数量仅为其1/8.4,推理速度提升了6.1倍

网络对比(宽度、深度、分辨率)

- 根据以往的经验,增加网络的深度depth能够得到更加丰富、复杂的特征并且能够很好的应用到其他任务中。但网络的深度过深会面临梯度消失,训练困难的问题。

- 增加网络的width能够获得更细粒度的特征并且也更容易训练,但对于width很大而且深度较浅的网络往往很难学习到更深层次的特征。

- 增加输入网络的图像分辨率能够潜在得获得更高细粒度的特征模板,但对于非常高的输入分辨率,准确度的增益也会减少。并且大分辨率图像会增加计算量。

从上图可以看出,scale by width,scale by depth,scale by resolution,发现这三条虚线基本上在准确率达到80%以后基本上就饱和了不在增加了。对于红色的线,我们同时增加网络的宽度、深度、分辨率,我们发现它达到了80%的准确率后并没有出现饱和的现象,并且还可以继续增长上去。这就说明了我们同时增加网络的深度、宽度、分辨率的话,我们是可以得到一个更好的结果的.

性能对比

- EfficientNet-B0对比的是我们ResNet-50以及我们DenseNet-169,我们可以看到它的准确率是最高的,参数量是最少的,它的理论上的计算量是最低的。同样B1~B7都对一系列网络进行了对比

- 不过在实际使用过程中,首先它的准确率确实是挺高的,然后它的参数个数确实也很少,这是毋庸置疑的。但是有个问题网络训练时非常占GPU的显存,因为在我们EfficientNet中像B4,B5,B6,B7这些模型,它的输入图片的分辨率非常大导致我们每一个层结构输出特征矩阵的高和宽都要相应的增加。所以对于我们显存的占用也会增加。

- 而且对于速度直接对比Flops是不完全对的,真实情况下我们所关注的速度其实是在设备上的推理的速度;真实的推理速度和Flops其实不是直接相关的,它还有很多其他因素的影响,所以如果你能给出在某些设备上它的推理时间的话会更加有意义

文章来源:https://blog.csdn.net/llf000000/article/details/135278618

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!