书生·浦语大模型实战营第一次课堂笔记

2024-01-08 17:00:46

书生·浦语大模型全链路开源体系。大模型是发展通用人工智能的重要途径,是人工通用人工智能的一个重要途径。书生·浦语大模型覆盖轻量级、重量级、重量级的三种不同大小模型,可用于智能客服、个人助手等领域。还介绍了书生·浦语大模型的性能在多个数据集上全面超过了相似量级或相近量级的模型

微调:

增量续训

使用场景: 让基座模型学习到一些新知识,如某个垂类领域知识

等训练数据:文章、书籍、代码

有监督微调

使用场景:让模型学会理解和遵循各种指令,或者注入少量领域知识

训练数据:高质量的对话、问答数据

全量参数微调

部分参数微调

指令微调

工具类指令微调

QloRA微调

LoRA微调

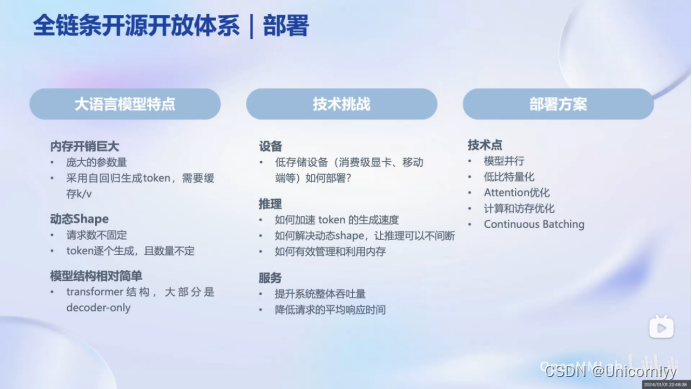

LMDeploy提供大模型在GPU上部署的全流程解决方案,包括模型轻量化、推理和服务

高效推理引擎:

持续批处理技巧,深度优化的低比特计算Kernel,模型并行,高效的k/v缓存管理机制

大语言模型的局限性:

最新信息和知识的获取,回复的可靠性,数学计算,工具的使用和交互

文章来源:https://blog.csdn.net/m0_68165821/article/details/135408611

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!