k8s快速搭建

搭建完一个镜像 关机 拍摄一个快照,克隆两个作为子节点

0. 环境准备

在开始之前,部署Kubernetes集群机器需要满足以下几个条件:

- 一台或多台机器,操作系统 CentOS7.x-86_x64

- 硬件配置:2GB或更多RAM,2个CPU或更多CPU,硬盘30GB或更多

- 可以访问外网,需要拉取镜像,如果服务器不能上网,需要提前下载镜像并导入节点

- 禁止swap分区

| 角色 | IP |

| — | — |

| master | 192.168.235.128 |

| node1 | 192.168.235.129 |

| node2 | 192.168.235.130 |

原文: CentOS7部署K8s集群

视频教程: CentOS7部署K8s集群

有一些补充,按照这个顺序复制黏贴

1. 安装依赖

yum install -y \

curl \

wget \

systemd \

bash-completion \

lrzsz

这个命令使用yum包管理器在系统上安装了以下软件包

- curl: 用于在命令行中进行网络数据传输的工具,支持多种协议。

- wget: 另一个用于从网络下载文件的命令行工具。

- systemd: Linux系统的初始化和系统管理系统,它提供了一种更先进的系统和服务管理方式。

- bash-completion: Bash自动补全的支持包,增强了Bash shell的交互性。

- lrzsz: 用于在Unix系统中进行ZModem文件传输的工具,通常用于通过串口传输文件。

2. 安装前准备

- 同步服务器时间

#设置系统时区为亚洲/上海时区

timedatectl set-timezone Asia/Shanghai && timedatectl set-local-rtc 0

#重新启动rsyslog服务

systemctl restart rsyslog

#重新启动cron服务

systemctl restart crond

2.修改主机名

方便通过主机名访问对于的服务器

# 主节点 在主节点输入

hostnamectl set-hostname k8s-master

# 从节点 在从节点输入

hostnamectl set-hostname k8s-node1

hostnamectl set-hostname k8s-node2

修改hosts

cat >/etc/hosts <<EOF

192.168.235.128 k8s-master

192.168.235.129 k8s-node1

192.168.235.130 k8s-node2

EOF

3.开启必要的端口

systemctl disable firewalld.service && systemctl stop firewalld.service

3. 容器运行时

1.转发IPv4并让iptables看到桥接流量

#注释里的不用复制

#写入 /etc/modules-load.d/k8s.conf 文件 加载两个内核模块:overlay 和 br_netfilter

cat >/etc/modules-load.d/k8s.conf <<EOF

overlay

br_netfilter

EOF

# 运行 overlay 内核模块

modprobe overlay

# 运行 br_netfilter 内核模块

modprobe br_netfilter

#写入 /etc/sysctl.d/k8s.conf 文件 确保容器环境中的网络功能正常工作

cat >/etc/sysctl.d/k8s.conf <<EOF

net.bridge.bridge-nf-call-iptables=1

net.bridge.bridge-nf-call-ip6tables=1

net.ipv4.ip_forward=1

EOF

#net.bridge.bridge-nf-call-iptables=1: 允许 iptables 处理桥接的数据包。

#net.bridge.bridge-nf-call-ip6tables=1: 允许 ip6tables 处理桥接的 IPv6 数据包。

#net.ipv4.ip_forward=1: 启用 IPv4 数据包的转发。

#重新加载系统范围的 sysctl 配置文件

sysctl --system

2.安装容器运行时

注意:k8s v1.24及以后不在支持Docker Engine

- 安装Docker

#安装了 yum-utils 软件包 yum-utils 是一个包含各种实用工具的集合

yum install -y yum-utils

# 设置阿里云镜像

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

#创建了一个目录 /etc/docker

mkdir -p /etc/docker

# 设置阿里云镜像/日志/cgroup驱动

cat >/etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2",

"storage-opts": [

"overlay2.override_kernel_check=true"

],

"registry-mirrors":["https://hub-mirror.c.163.com","https://docker.mirrors.ustc.edu.cn","https://registry.docker-cn.com"]

}

EOF

#更新缓存

yum makecache fast

#安装docker

yum install -y docker-ce-20.10.23 docker-ce-cli-20.10.23 containerd.io

#配置刷新

systemctl daemon-reload

#开机自启docker

systemctl enable docker && systemctl restart docker

4.安装k8s

- 关闭swap分区或者禁用swap文件

swapoff -a && sed -ri 's/.*swap.*/#&/' /etc/fstab

2.关闭selinux

setenforce 0 && sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

3.安装k8s

# 使用阿里云k8s源

cat >/etc/yum.repos.d/kubernetes.repo <<EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# 安装工具kubelet、kubeadm、kubectl

yum install -y kubelet-1.23.17 kubeadm-1.23.17 kubectl-1.23.17 --disableexcludes=kubernetes

# 设置驱动方式为systemd

cat >/etc/sysconfig/kubelet <<EOF

KUBELET_EXTRA_ARGS="--cgroup-driver=systemd"

EOF

# kubelet开机自启

systemctl enable --now kubelet

# 查看kubelet状态

systemctl status kubelet

# 如果报错,查询错误信息

journalctl -xe

5. 运行k8s

#新建一个放k8s日志的目录

mkdir -p /k8sdata/log/

#初始化k8s 这里需要把192.168.235.128这个服务器ip地址 换成自己的主节点IP 其余的不用管

kubeadm init \

--apiserver-advertise-address=192.168.235.128 \

--image-repository=registry.cn-hangzhou.aliyuncs.com/google_containers \

--kubernetes-version=v1.23.17 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16 | tee /k8sdata/log/kubeadm-init.log

最后一行出现以下内容就是k8s初始化成功了,等下安装k8s-node1的时候把这行命令把node加入到子节点中

#node 节点加入秘钥

kubeadm join 192.168.235.128:6443 --token nq7g0y.ez2rqf1oqvjs4ujh \

--discovery-token-ca-cert-hash sha256:6f8523927dc483ffc8854288c7ea0f01b70a26395a35438a8fc26401b0da3e2c

#最后输入这三行命令

mkdir -p "$HOME"/.kube

cp -i /etc/kubernetes/admin.conf "$HOME"/.kube/config

chown "$(id -u)":"$(id -g)" "$HOME"/.kube/config

提示:

- 如果是搭建的服务器是主节点,则服务器至少2核2G,如果没有达到该配置但是仍想安装,则可以在kubeadm init命令行中使用–ignore-preflight-errors=CpuNum即可忽略报错。

- 如果初始化失败,通过kubeadm reset进行重设

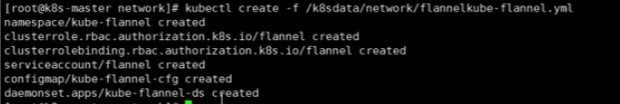

6. 安装网络系统

- flannel

# 创建目录 /k8sdata/network/,用于存放 Flannel 配置文件。

mkdir -p /k8sdata/network/

#下载 Flannel 的 Kubernetes 配置文件

wget --no-check-certificate -O /k8sdata/network/flannelkube-flannel.yml https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

#使用 kubectl 工具创建 Kubernetes 资源,将 Flannel 插件部署到集群中

kubectl create -f /k8sdata/network/flannelkube-flannel.yml

把这个拷贝到网址

- https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

- 把内容拷贝下来保存到桌面文件命名为flannelkube-flannel.yml

- 然后使用rz 命令来上传这个文件 这样快一点

- 然后在 kubectl create -f /k8sdata/network/flannelkube-flannel.yml

创建成功!

7. k8s命令行补全

! grep -q kubectl "$HOME/.bashrc" && echo "source /usr/share/bash-completion/bash_completion" >>"$HOME/.bashrc"

! grep -q kubectl "$HOME/.bashrc" && echo "source <(kubectl completion bash)" >>"$HOME/.bashrc"

! grep -q kubeadm "$HOME/.bashrc" && echo "source <(kubeadm completion bash)" >>"$HOME/.bashrc"

! grep -q crictl "$HOME/.bashrc" && echo "source <(crictl completion bash)" >>"$HOME/.bashrc"

source "$HOME/.bashrc"

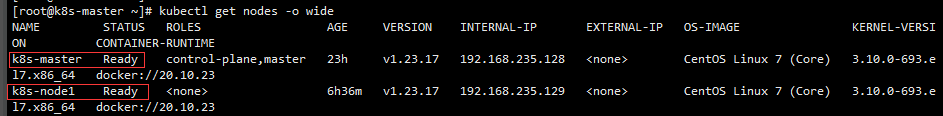

8. k8s常用命令

# 获取节点

kubectl get nodes -o wide

# 实时查询nodes状态

watch kubectl get nodes -o wide

# 获取pod

kubectl get pods --all-namespaces -o wide

# 查看镜像列表

kubeadm config images list

# 节点加入集群

kubeadm token create --print-join-command

# 描述node

kubectl describe node k8s-master

# 描述pod

kubectl describe pod kube-flannel-ds-hs8bq --namespace=kube-flannel

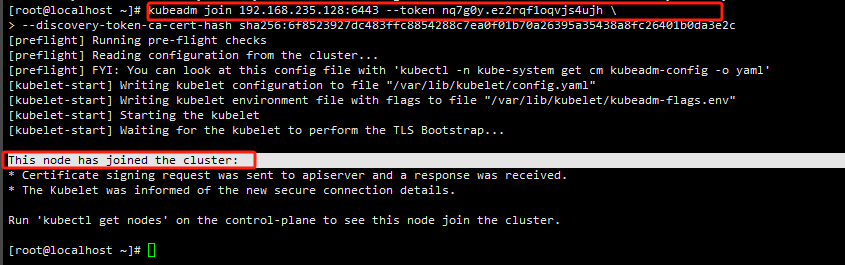

9.加入子节点:重复步骤到第4步,不需要运行k8s

在子节点192.168.235.129 (Node)执行。

- 子节点不需要安装网络系统

- 主节点会自动给子节点安装网络系统

- 最后加入这行命令 node加入到master,通过master来管理node

#node 节点加入秘钥

kubeadm join 192.168.235.128:6443 --token nq7g0y.ez2rqf1oqvjs4ujh \

--discovery-token-ca-cert-hash sha256:6f8523927dc483ffc8854288c7ea0f01b70a26395a35438a8fc26401b0da3e2c

默认token有效期为24小时,当过期之后,该token就不可用了。这时就需要重新创建token,操作如下:

kubeadm token create --print-join-command

#获取节点

#获取pod

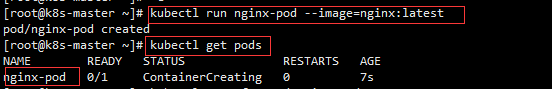

10. 测试kubernetes集群

在Kubernetes集群中创建一个pod,验证是否正常运行:

#创建一个名为 nginx-pod 的 Pod,并使用最新的 NGINX 镜像

kubectl run nginx-pod --image=nginx:latest

2.分配端口

kubectl expose deployment nginx --port=80 --type=NodePort

- kubectl: Kubernetes 命令行工具。

- expose: 用于将一个已有的资源(这里是 Deployment)暴露为一个新的 Kubernetes Service。

- deployment nginx: 指定要暴露的 Deployment 名称为 “nginx”。

- –port=80: 指定 Service 对外暴露的端口为 80。这表示外部客户端可以通过这个端口访问该服务。

- –type=NodePort: 指定 Service 类型为 NodePort,这意味着 Service 将在每个节点上分配一个随机的端口,并通过该端口暴露服务。

创建一个名为 “nginx” 的 Service,该 Service 使用 NodePort 类型,在每个节点上都会分配一个端口,允许通过节点的 IP 地址和分配的端口来访问该服务。例如,如果某个节点的 IP 地址是 192.168.1.100,分配的 NodePort 是 32000,那么可以通过 192.168.1.100:32000 访问到该服务

3.获取 Kubernetes 中名为 “nginx-service” 的 Service 的详细信息

kubectl get service nginx-service

访问地址:http://NodeIP:Port

http:192.168.235.128:30004

11.Metrics Server安装

说明

-

个人镜像:https://framagit.org/xuxiaowei-com-cn/k8s.sh/-/tree/main/mirrors/kubernetes-sigs/metrics-server

-

Metrics Server 是一个 Kubernetes 组件,用于收集群集中的容器和节点的资源度量指标,并将这些指标提供给用户和其他组件。Metrics Server 采集的指标包括CPU使用率、内存使用率、网络流量等。这些指标可以帮助用户了解应用程序、服务以及它们所在的节点和容器的健康情况,帮助用户优化资源使用和应用程序性能。

-

Metrics Server 可以通过 Kubernetes API Server 提供度量指标查询接口,以支持其他组件、工具和应用程序对度量指标进行查询、监控、告警等操作。Metrics Server 还支持自动横向扩展,以适应更大规模的 Kubernetes 集群。总之,Metrics Server 可以帮助用户更好地管理和优化Kubernetes集群中的资源使用和应用程序性能。

-

未安装 Metrics Server 查看 pod 内存、CPU 将报错

[root@k8s ~]# kubectl top pods --all-namespaces

error: Metrics API not available

[root@k8s ~]#

- 未安装 Metrics Server 时,Kubernetes Dashboard 无法查看资源(内存、CPU)使用情况

一、使用阿里云的components.yaml配置文件

aliyun-components.yaml

[root@k8s-master ~]# rz

[root@k8s-master ~]# ls

aliyun-components.yaml anaconda-ks.cfg

#查看文件

[root@k8s-master ~]# cat aliyun-components.yaml

二、执行安装命令

[root@k8s-master ~]# kubectl apply -f aliyun-components.yaml

执行完输出内容:

serviceaccount/metrics-server created

clusterrole.rbac.authorization.k8s.io/system:aggregated-metrics-reader created

clusterrole.rbac.authorization.k8s.io/system:metrics-server created

rolebinding.rbac.authorization.k8s.io/metrics-server-auth-reader created

clusterrolebinding.rbac.authorization.k8s.io/metrics-server:system:auth-delegator created

clusterrolebinding.rbac.authorization.k8s.io/system:metrics-server created

service/metrics-server created

deployment.apps/metrics-server created

apiservice.apiregistration.k8s.io/v1beta1.metrics.k8s.io created

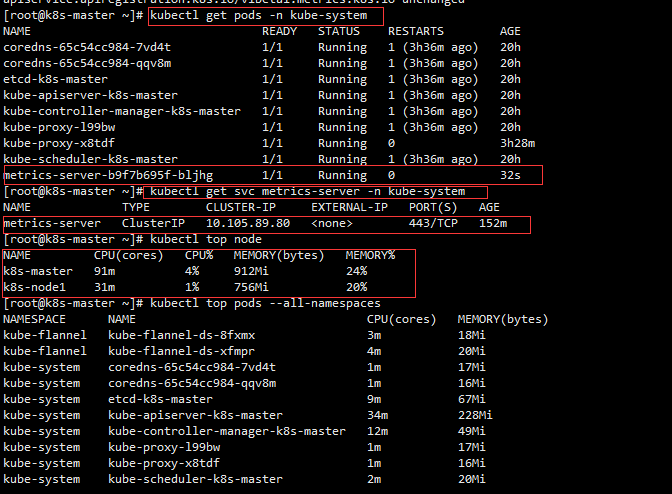

三、查看效果,验证是否安装成功

[root@k8s-master ~]# kubectl get svc metrics-server -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

metrics-server ClusterIP 10.105.89.80 <none> 443/TCP 152m

[root@k8s-master ~]# kubectl top node

NAME CPU(cores) CPU% MEMORY(bytes) MEMORY%

k8s-master 91m 4% 912Mi 24%

k8s-node1 31m 1% 756Mi 20%

[root@k8s-master ~]# kubectl top pods --all-namespaces

NAMESPACE NAME CPU(cores) MEMORY(bytes)

kube-flannel kube-flannel-ds-8fxmx 3m 18Mi

kube-flannel kube-flannel-ds-xfmpr 4m 20Mi

kube-system coredns-65c54cc984-7vd4t 1m 17Mi

kube-system coredns-65c54cc984-qqv8m 1m 16Mi

kube-system etcd-k8s-master 9m 67Mi

kube-system kube-apiserver-k8s-master 34m 228Mi

kube-system kube-controller-manager-k8s-master 12m 49Mi

kube-system kube-proxy-l99bw 1m 17Mi

kube-system kube-proxy-x8tdf 1m 16Mi

kube-system kube-scheduler-k8s-master 2m 20Mi

kube-system metrics-server-b9f7b695f-bljhg 3m 20Mi

12.dashboard部署

参考文章: 原文连接如

Kubernetes Dashboard 安装

Linux高级—dashboard部署

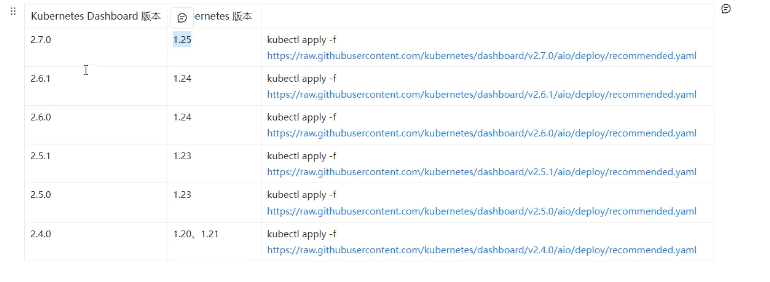

1.找到对应版本的dashboard 这里使用的是2.50

2.根据提供的配置文件,部署 Kubernetes Dashboard 到您的 Kubernetes 集群中

kubectl apply -f https://framagit.org/mirrors-github/kubernetes/dashboard/-/raw/v2.5.0/aio/deploy/recommended.yaml

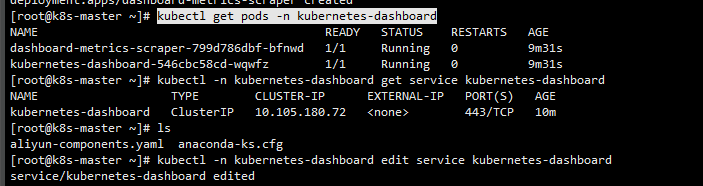

3.查看是否创建完成

kubectl get pods -n kubernetes-dashboard -o wide

kubectl -n kubernetes-dashboard get service kubernetes-dashboard

4.修改 kubernetes-dashboard 服务,使其支持远程访问

kubectl -n kubernetes-dashboard edit service kubernetes-dashboard

将 type: ClusterIP 修改成 type: NodePort 即可

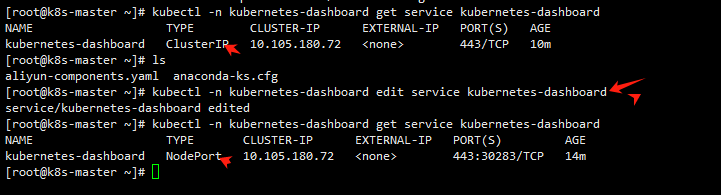

5.修改完成后,再次查看 kubernetes-dashboard 服务

kubectl -n kubernetes-dashboard get service kubernetes-dashboard

[root@centos-7-9-14 ~]# kubectl -n kubernetes-dashboard get service kubernetes-dashboard

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes-dashboard NodePort 10.108.225.163 <none> 443:30320/TCP 54m

[root@centos-7-9-14 ~]#

5.访问

由上一步执行的结果可以得出,使用 30283 即可访问 kubernetes-dashboard 服务 假如集群的IP为 192.168.235.128,访问地址为 https://192.168.235.128:30283

三、创建访问用户,获取token

# 创建账号

[root@master-1 ~]# kubectl create serviceaccount dashboard-admin -n kubernetes-dashboard

# 授权

[root@master-1 ~]# kubectl create clusterrolebinding dashboard-admin-rb --clusterrole=cluster-admin --serviceaccount=kubernetes-dashboard:dashboard-admin

# 获取账号token

[root@master ~]# kubectl get secrets -n kubernetes-dashboard | grep dashboard-admin

dashboard-admin-token-mfs2w kubernetes.io/service-account-token 3 2m35s

[root@master dashboard]# kubectl describe secrets dashboard-admin-token-mfs2w -n kubernetes-dashboard

Name: dashboard-admin-token-mfs2w

Namespace: kubernetes-dashboard

Labels: <none>

Annotations: kubernetes.io/service-account.name: dashboard-admin

kubernetes.io/service-account.uid: 8f657592-6328-4884-bb8a-a50a2d277ed5

Type: kubernetes.io/service-account-token

Data

====

namespace: 20 bytes

token: eyJhbGciOiJSUzI1NiIsImtpZCI6IlJCanJyMTluLWliRXF3aVA1LWRXcWtZbVlxdnhQa1Q5Y1EzT01nY3E1dGMifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJrdWJlcm5ldGVzLWRhc2hib2FyZCIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VjcmV0Lm5hbWUiOiJkYXNoYm9hcmQtYWRtaW4tdG9rZW4tbWZzMnciLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC5uYW1lIjoiZGFzaGJvYXJkLWFkbWluIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQudWlkIjoiOGY2NTc1OTItNjMyOC00ODg0LWJiOGEtYTUwYTJkMjc3ZWQ1Iiwic3ViIjoic3lzdGVtOnNlcnZpY2VhY2NvdW50Omt1YmVybmV0ZXMtZGFzaGJvYXJkOmRhc2hib2FyZC1hZG1pbiJ9.s-g33KYjVWemyAccZ1zY6qNIrtBjuVPZ4bcDnyKiphkfvxD_dHhfljFY_OMGzNZcxanls9ujL_WlQ76au_lGzDrrIx2dRTw4gaHTnP3-c-lywn-deydOB5KC7Rgb7IRag8IShjWyqVSvImhW443Tf12CWEV3EhGx8pXUKrzx03Xytg-uuABbGSevQi1UXR31_iB15Jf_zKxeHcLZjffF8cEKyFPEKwSVFSNg_L3CwgcREGoB1GPplARrDeH0-Bm-x5kyoQljVHcR-KFdLFpnmnkI9p8TJR6Idrc3TP9-TF3xjX6z_W8Xccamz0gFgzi_6h2jvOTfVNTFUBN3ONRtnw

ca.crt: 1099 bytes

[root@master dashboard]#

四、测试访问

https://192.168.235.128:30283

输入上面获得的token,然后登录即可

在空白地方输入thisisunsafe就可以了

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!