【大模型知识库】(4):本地环境运行dity+fastchat的ChatGLM3模型,可以使用chat/completions接口调用chatglm3模型

2023-12-19 00:09:15

1,视频演示地址

https://www.bilibili.com/video/BV18i4y1a78u/?vd_source=4b290247452adda4e56d84b659b0c8a2

【大模型知识库】(4):本地环境运行dity+fastchat的ChatGLM3模型,可以使用chat/completions接口调用chatglm3模型

2,关于 dify

https://github.com/langgenius/dify/blob/main/README_CN.md

Dify 是一个 LLM 应用开发平台,已经有超过 10 万个应用基于 Dify.AI 构建。它融合了 Backend as Service 和 LLMOps 的理念,涵盖了构建生成式 AI 原生应用所需的核心技术栈,包括一个内置 RAG 引擎。使用 Dify,你可以基于任何模型自部署类似 Assistants API 和 GPTs 的能力。

3,项目启动脚本

发布gitee代码:

https://gitee.com/fly-llm/dify-docker-compose

4,启动成功配置本地模型:

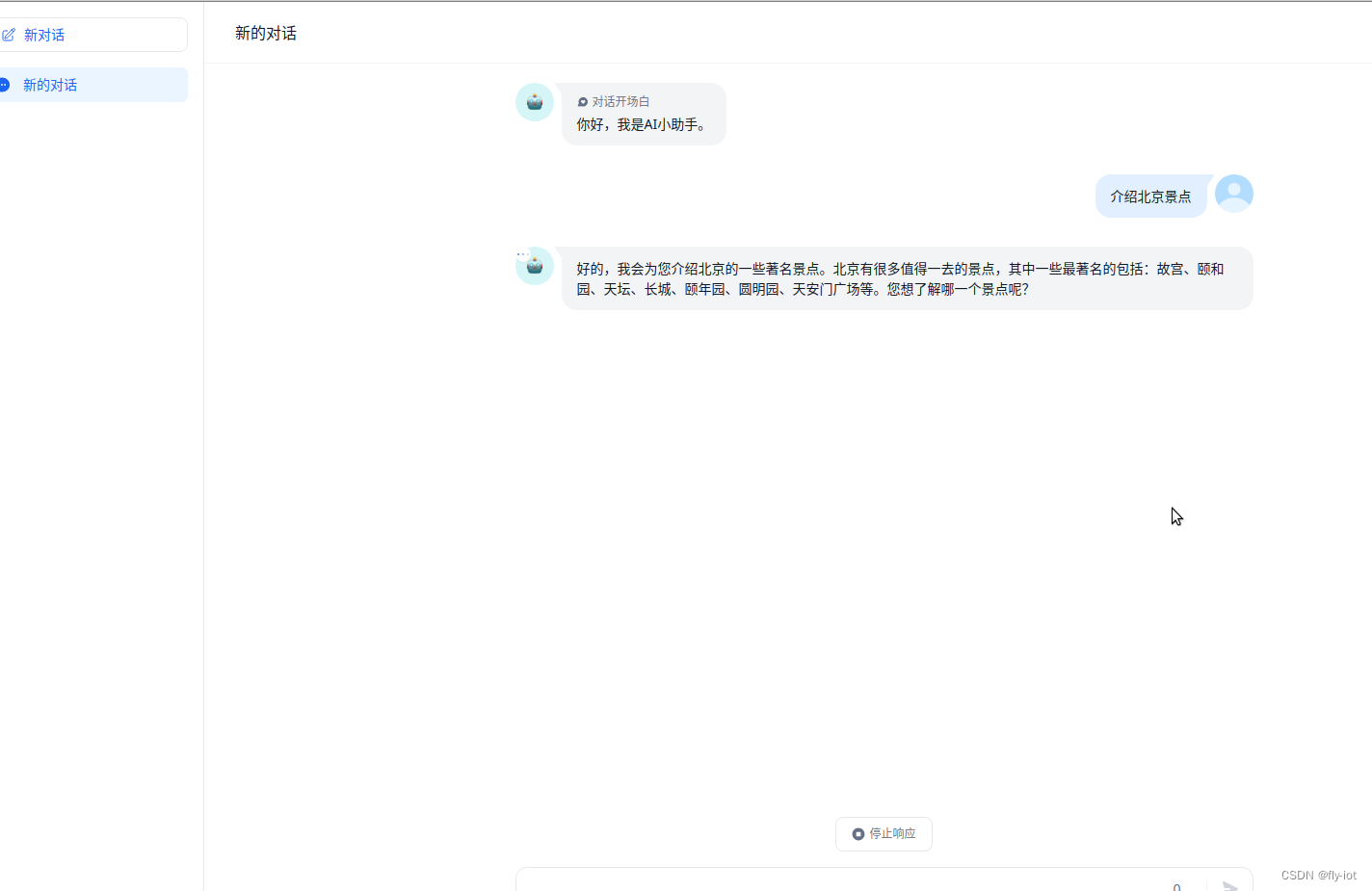

然后就可以聊天了:

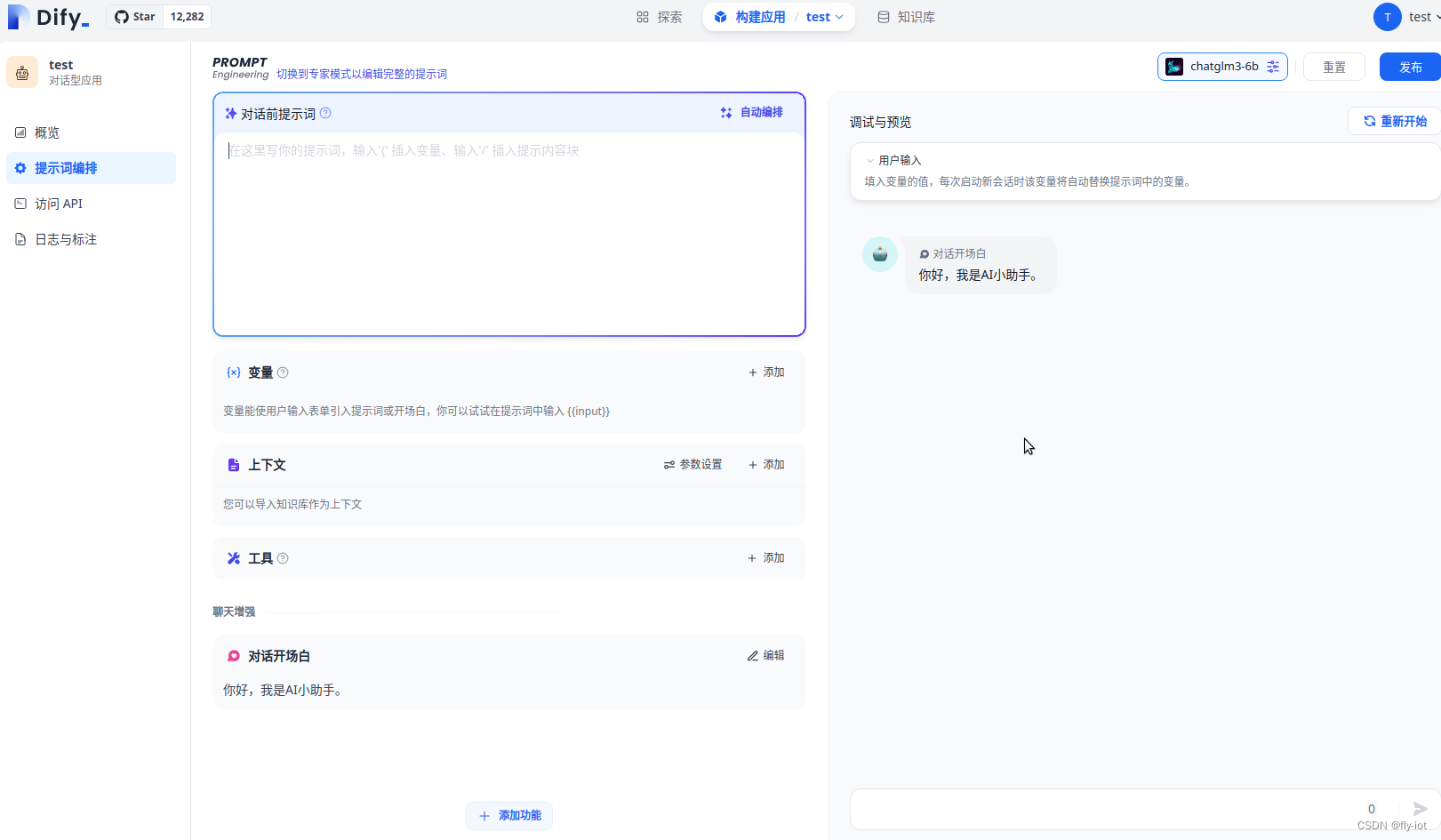

还可以快速的配置提示词,然后进行测试,测试完成直接发布即可:

5,总结

dify 已经是非常完善的产品了,可以快速的进行配置开发一个聊天应用。

同时支持配置提示词。非常方便。还有知识库可以配置使用。

文章来源:https://blog.csdn.net/freewebsys/article/details/135072438

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!