Pytorch中Group Normalization的具体实现

2023-12-13 05:46:54

Group Normalization (GN) 是一种用于深度神经网络中的归一化方法,它将每个样本划分为小组,并在每个小组内进行标准化。与批归一化(Batch Normalization)不同,Group Normalization 不依赖于小批量数据,因此在训练和推断过程中的性能更加稳定。

下面是 Group Normalization 的具体实现步骤:

-

输入:

- 输入张量 x,形状为 (N, C, H, W, D),其中:

- N?是批次大小(batch size),

- C?是通道数(channels),

- H、W、D?是空间维度。

- 输入张量 x,形状为 (N, C, H, W, D),其中:

-

小组划分:

- 将通道维度 C?分成 G?个小组(groups),其中 G?是 Group Normalization 中的一个超参数。

- 每个小组包含 C/G?个通道。

-

计算均值和方差:

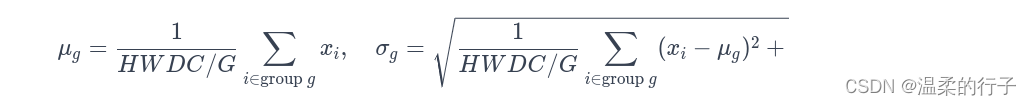

- 对于每个小组 g,计算该小组内的均值 mu_g?和方差 sigma_g:

其中 epsilon?是一个小的正数,用于稳定计算。

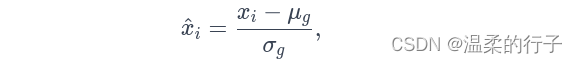

其中 epsilon?是一个小的正数,用于稳定计算。 - 标准化:?对于每个通道 i?和小组 g,使用计算得到的均值和方差对输入进行标准化:

-

缩放和平移:?对于每个通道 i?和小组 g,引入可学习的缩放因子 gamma_i?和平移因子 beta_i,通过线性变换调整标准化后的值:

其中 gamma_i?和 beta_i?是与通道相关的可学习参数。

其中 gamma_i?和 beta_i?是与通道相关的可学习参数。 -

输出:输出张量 y?是经过 Group Normalization 处理后的结果。

-

在 PyTorch 中,可以通过

nn.GroupNorm模块来实现 Group Normalization。以下是一个简化的例子:import torch import torch.nn as nn # 输入张量 x 的形状为 (N, C, H, W, D) x = torch.randn((32, 64, 128, 128, 128)) # Group Normalization,其中 G=4 gn = nn.GroupNorm(num_groups=4, num_channels=64) y = gn(x)在这个例子中,

num_groups指定了小组的数量,即 G,而num_channels指定了输入张量的通道数 C。 Group Normalization 的具体实现在 PyTorch 内部进行了高效计算。

- 对于每个小组 g,计算该小组内的均值 mu_g?和方差 sigma_g:

文章来源:https://blog.csdn.net/qq_42536162/article/details/134945408

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!