FCN——第二课

语义分割中的全卷积网络

一、引言和相关工作

在以往的分割方法中,主要有两大类缺点:

1.基于图像块的分割虽然常见,但是效率低,且往往需要前期或者后期处理(例如超像素、检测框局部预分类等)

2. 语义分割面临着语义和位置信息不可兼得的问题。全局信息解决的“是什么”,而局部信息解决的是“在哪里”

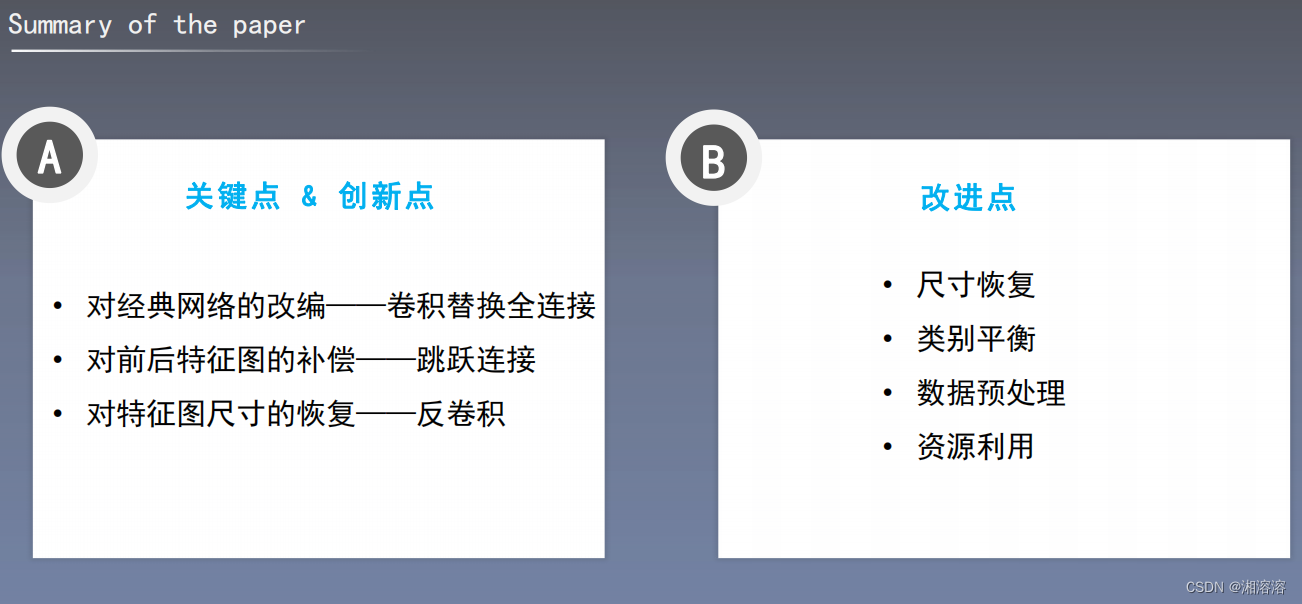

为了解决上面这两个问题,本文主要有三个创新点

1.将分类网络改编为全卷积神经网络,具体包括全连接层转化为卷积层以及通过反卷积进行上采样

2.使用迁移学习的方法进行微调

3.使用跳跃结构使得语义信息可以和表征信息相结合,产生准确而精细的分割

语义信息和表征信息 == 全局信息和局部信息

二、全卷积网络

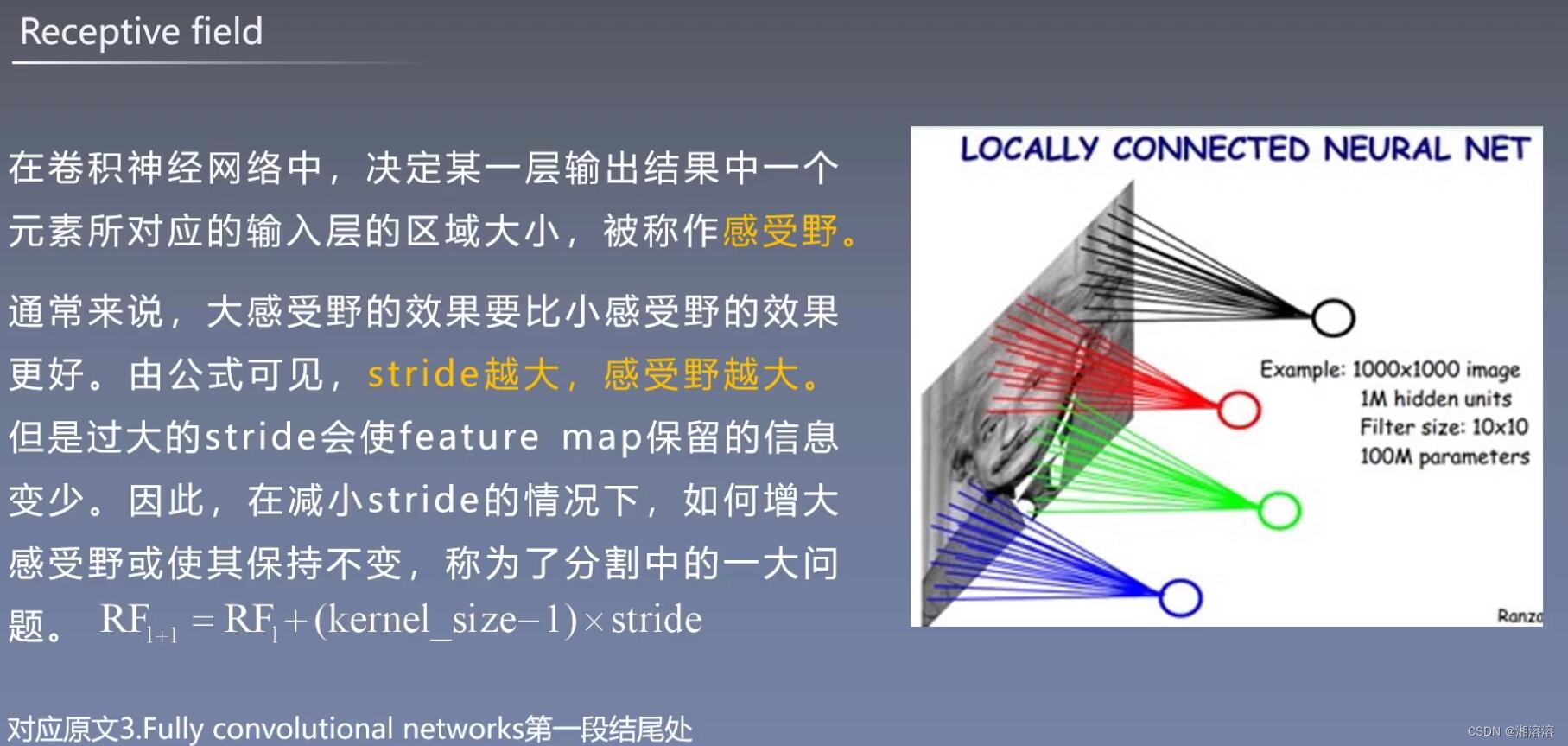

感受野 receptive fields

hwd hw是宽高 d是通道维数或者是特征 输入图像d是三通道的

每一个节点对应原图的区域,叫做节点的感受域,区域的大小就是感受域的大小。例如图上黑色的区域是33 感受野的大小就是3,一个点对应一个区域,区域的大小就是感受野的大小

大感受野尽可能保留语义信息,不忽略重要线索,提高分割准确度

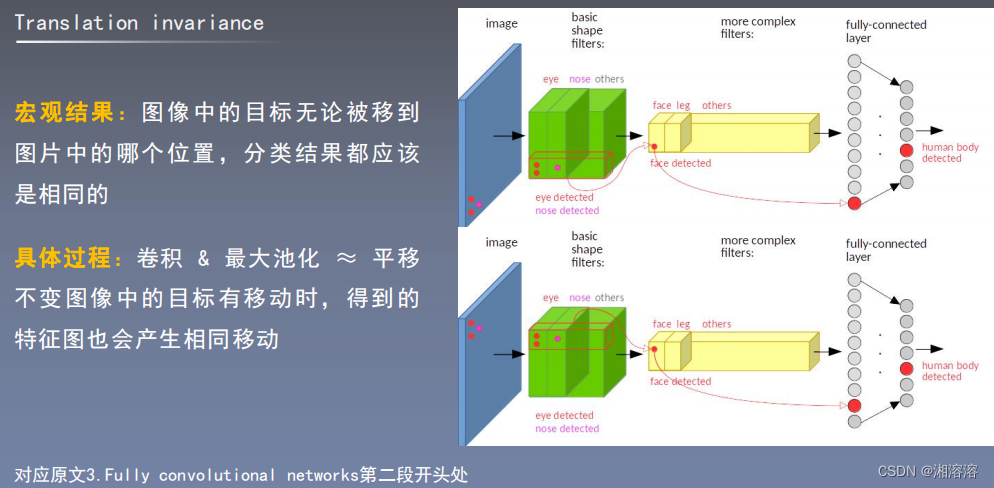

平移不变性

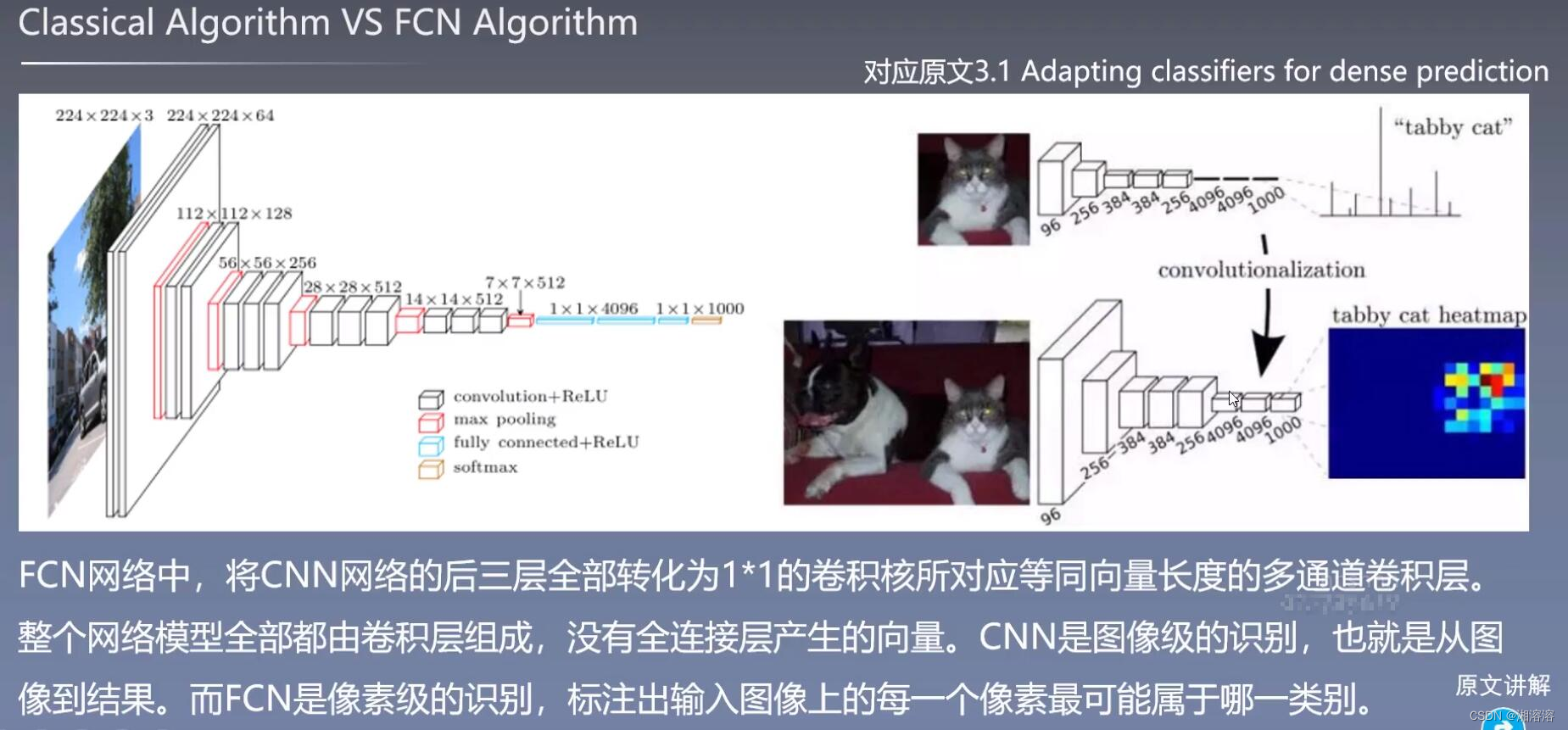

经典算法和FCN算法

CNN是图像级别的识别,例如VGG中的图像将该张图像标注为汽车。FCN是像素级的识别,是密集的像素任务,标注出输入图像上的每一个像素最可能属于哪一类别。

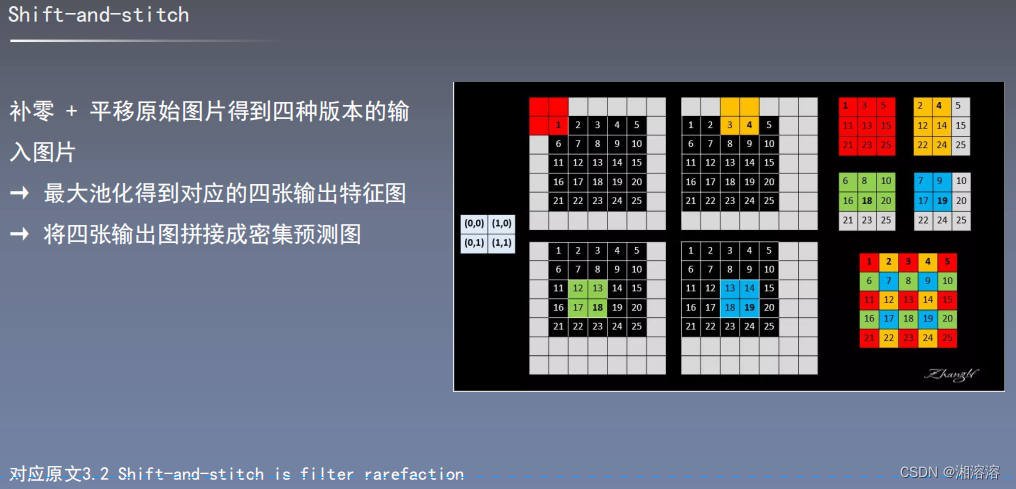

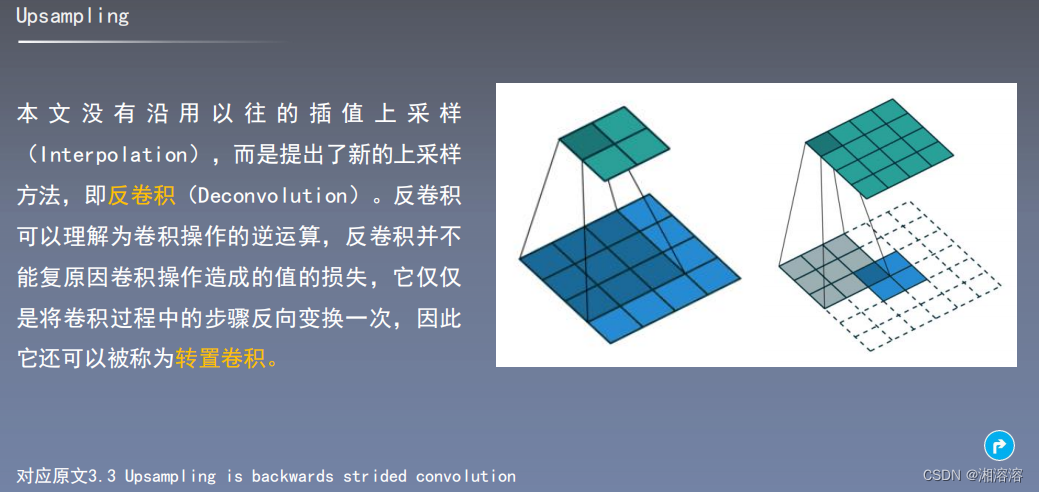

上采样

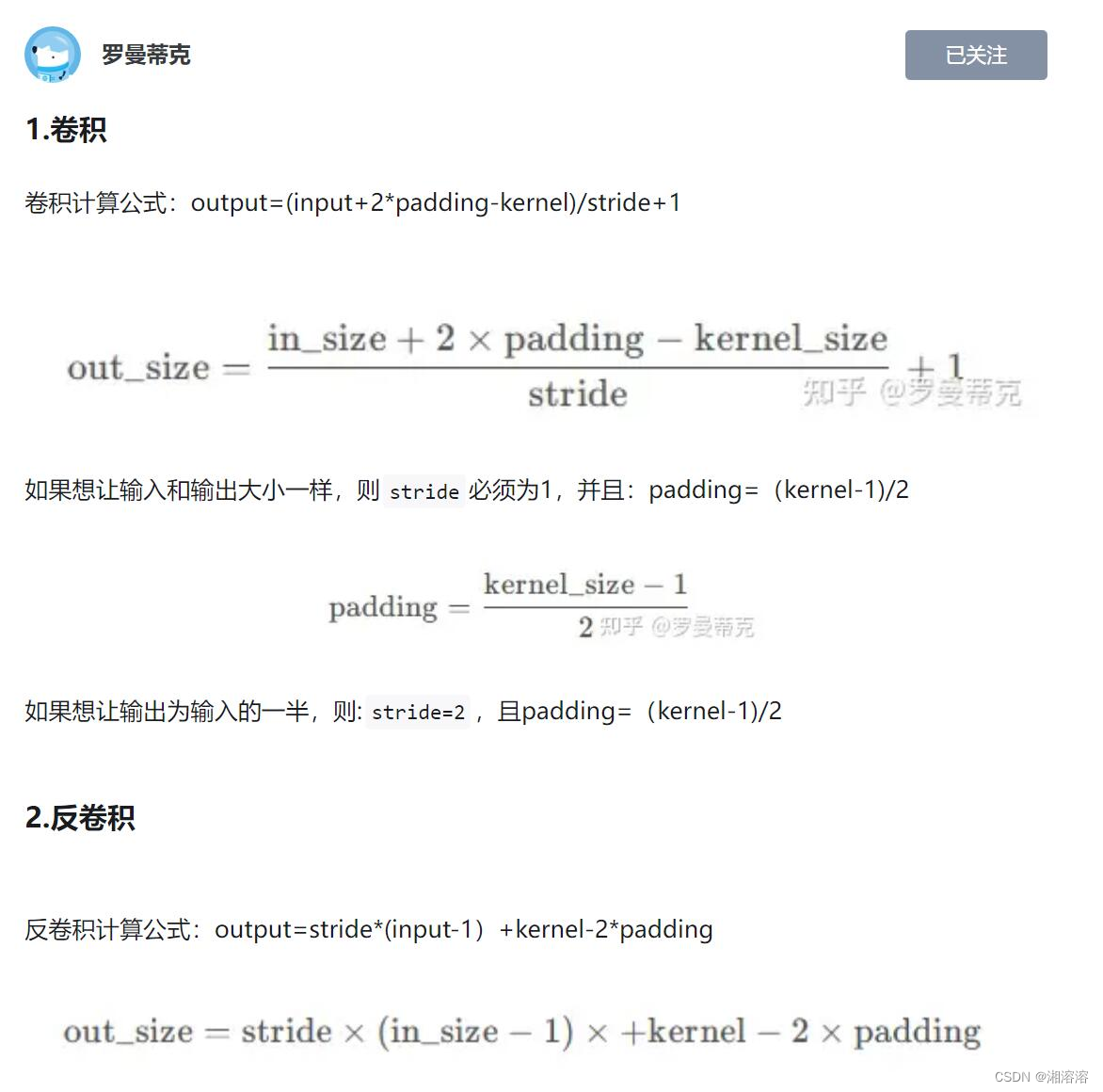

卷积和反卷积公式

三、论文算法模型详解

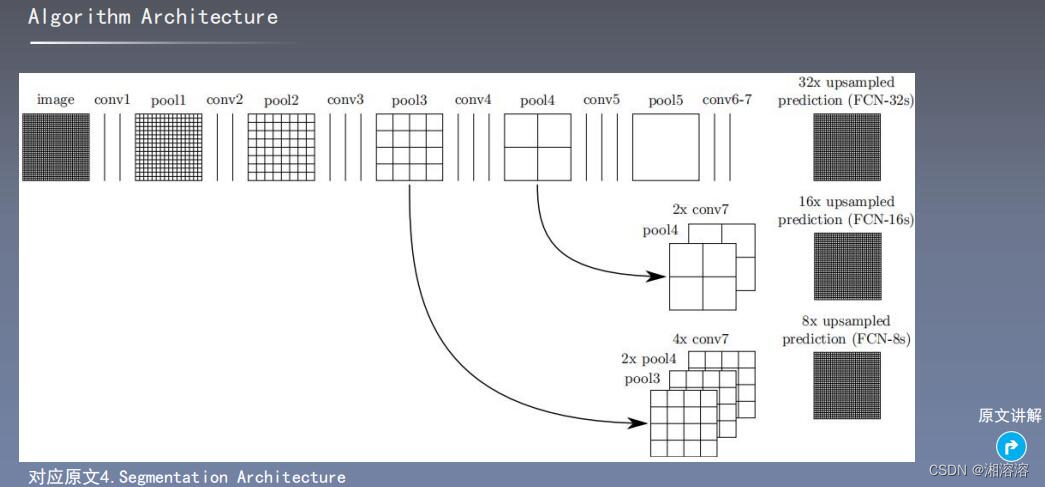

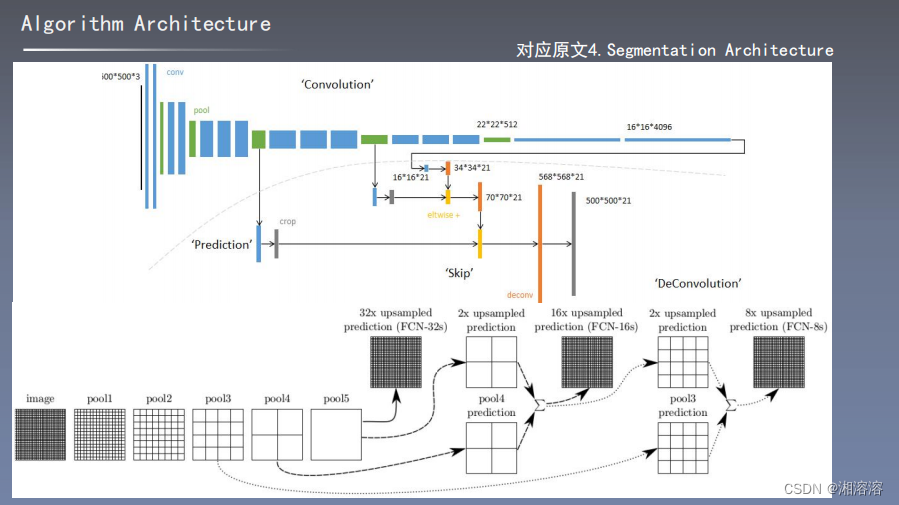

算法架构

①输入图像经过卷积、池化(1)得到的特征图是原图大小的1/2

②再经过卷积池化(2)得到的特征图是原图大小的1/4

③继续卷积池化(3)得到的特征图是原图大小的1/8

④重复卷积池化(4)得到的特征图的原图大小的1/16

⑤卷积池化(5)得到的特征图是1/32

反卷积:

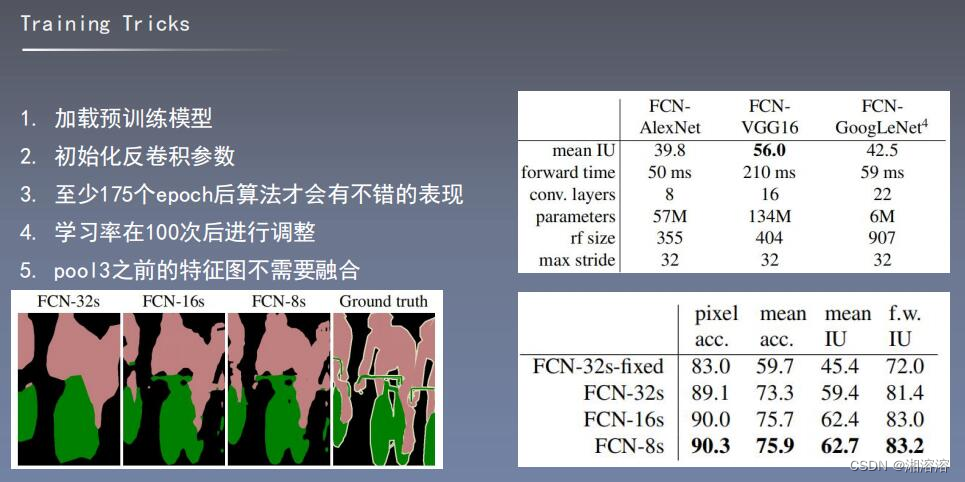

1/32的特征图经过反卷积得到FCN-32s

1/16的特征图经过2倍反卷积得到的特征图与第四步的特征图进行融合,然后反卷积得到FCN-16s

1/16的特征图经过2倍反卷积得到的特征图与第四步的特征图进行融合,再经过2倍反卷积得到1/8的特征图,与第三步的特征图进行融合,最后反卷积8倍得到FCN-8s

这个架构的主要思想是通过反卷积操作将低分辨率的特征图上采样到原始图像的分辨率,并在不同层次融合信息,以获取更全局和语义的特征。这对于语义分割等任务非常有用。

四、论文算法模型细节

训练技巧

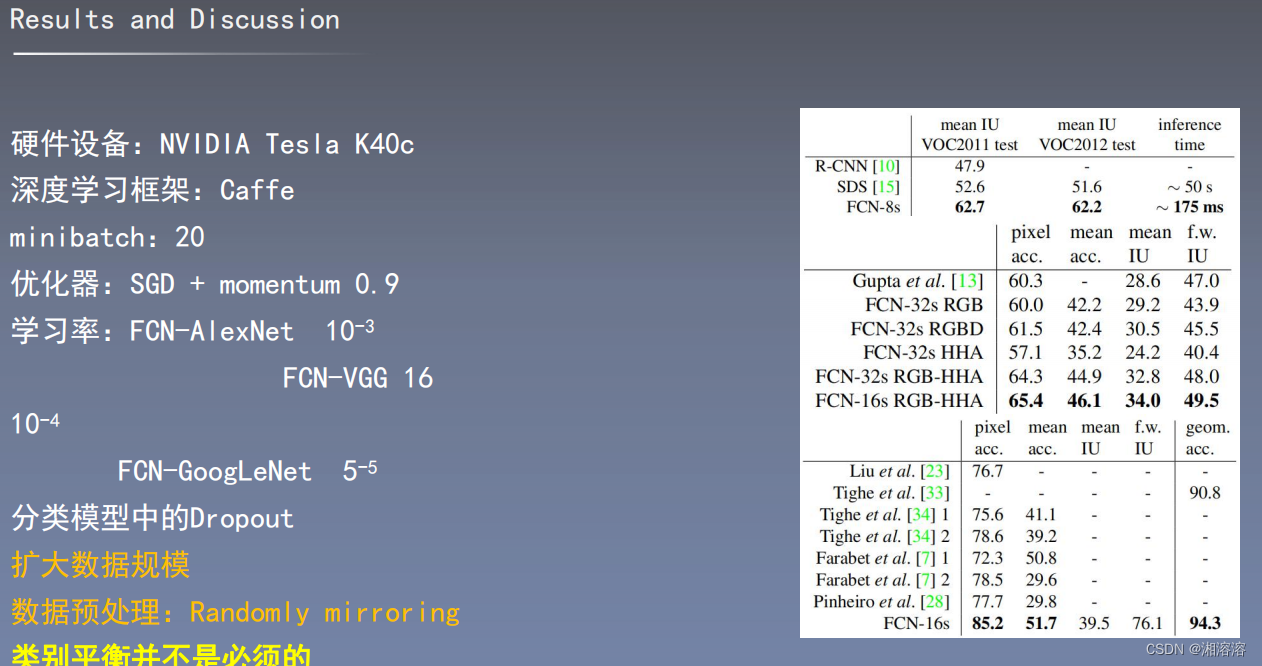

五、实验设置和结果分析

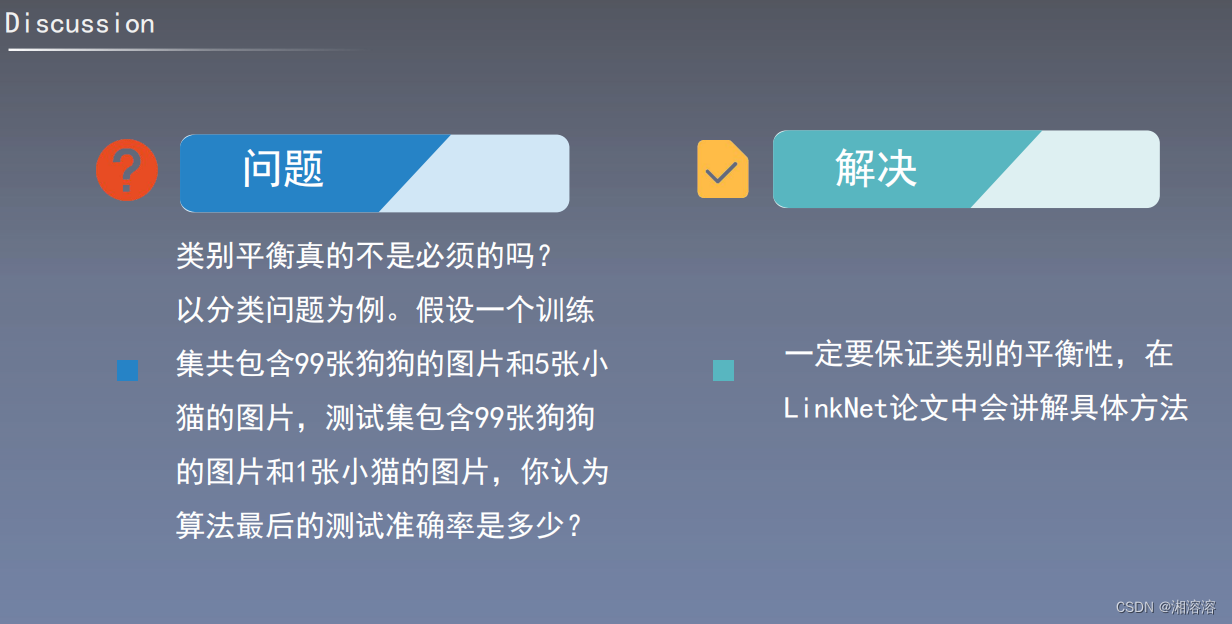

六、讨论和总结

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!