翻译: 大语言模型LLMs能做什么和不能做什么 保存笔记What LLMs can and cannot do

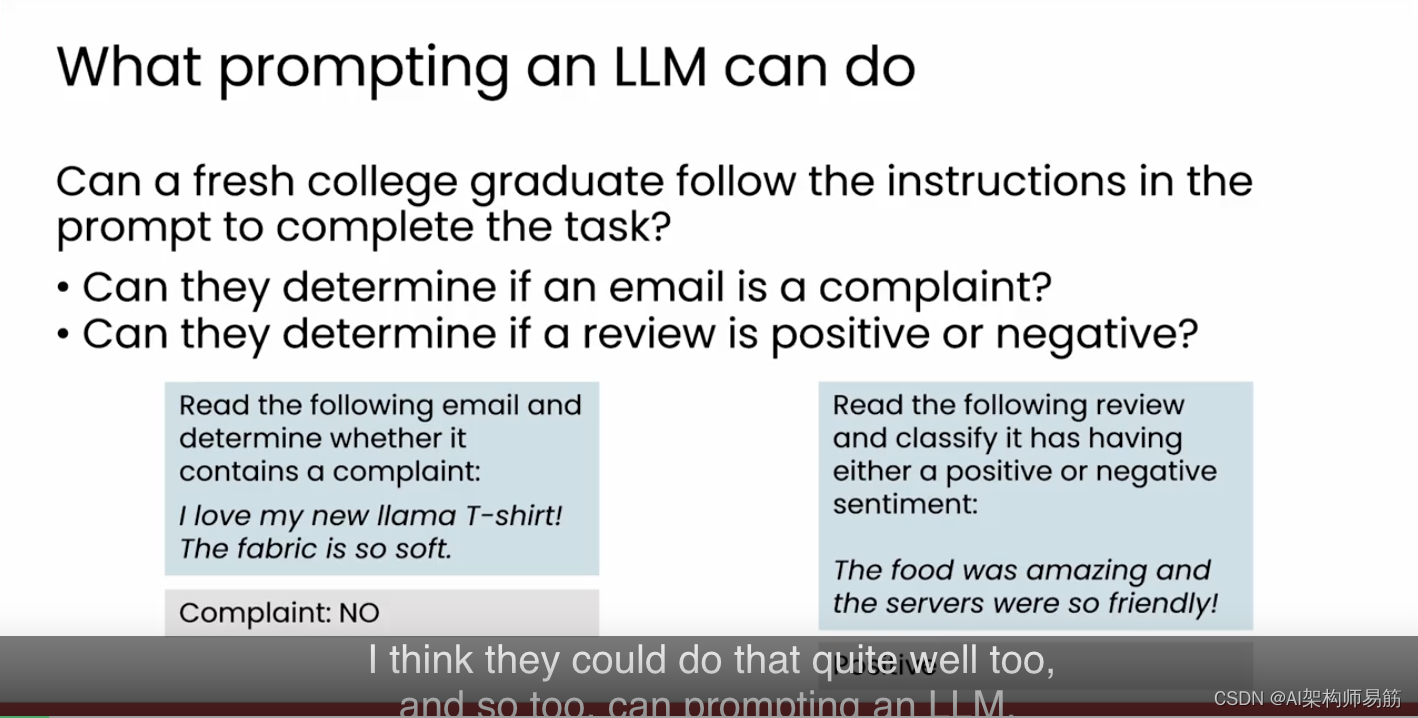

生成式 AI 是一项惊人的技术,但它并非万能。在这个视频中,我们将仔细看看大型语言模型(LLM)能做什么,不能做什么。我们将从我发现的一个有用的心理模型开始,了解它能做什么,然后一起看看 LLM 的一些具体限制。我发现理解这些限制可以降低你在尝试使用它们做它们不擅长的事情时被绊倒的机会,所以让我们深入了解一下。如果你想弄清楚引导 LLM 能做什么,这里有一个问题,我发现它提供了一个有用的心理框架。那就是我会问自己,一个刚毕业的大学生,只遵循提示中的指令,能完成你想要的任务吗?例如,一个刚毕业的大学生能遵循指令阅读一封电子邮件来判断它是否是投诉吗?嗯,我认为一个刚毕业的大学生可能做得到,LLM 也能做得相当好。或者,一个刚毕业的大学生能阅读一篇餐馆评论来判断它是正面还是负面情绪吗?我认为他们也能做得很好,LLM 也是如此。

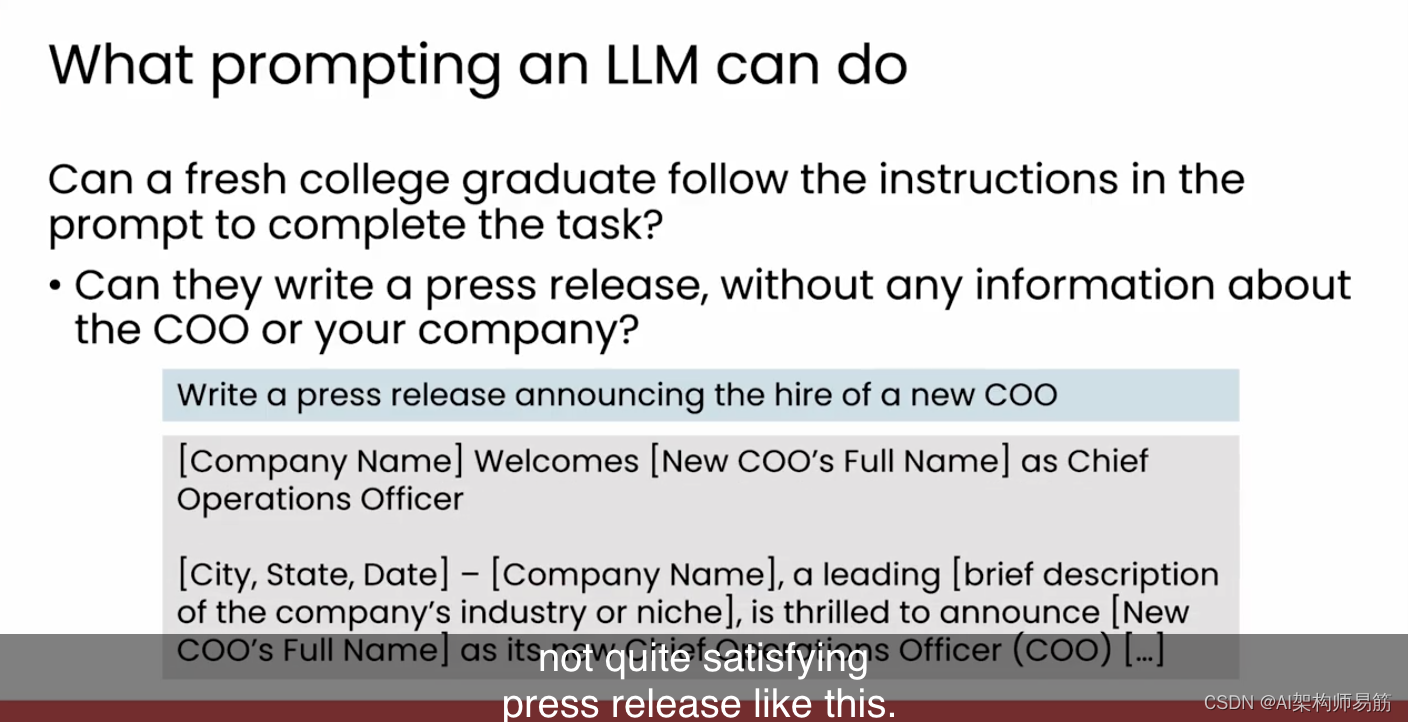

这是另一个例子,一个刚毕业的大学生能在没有关于首席运营官或你的公司的任何信息的情况下撰写新闻稿吗?嗯,这个刚毕业的大学生刚从大学毕业。他们只是刚刚认识你,对你或你的业务一无所知,所以他们最好能做的可能是写一个非常通用的、不太令人满意的新闻稿,就像这样。

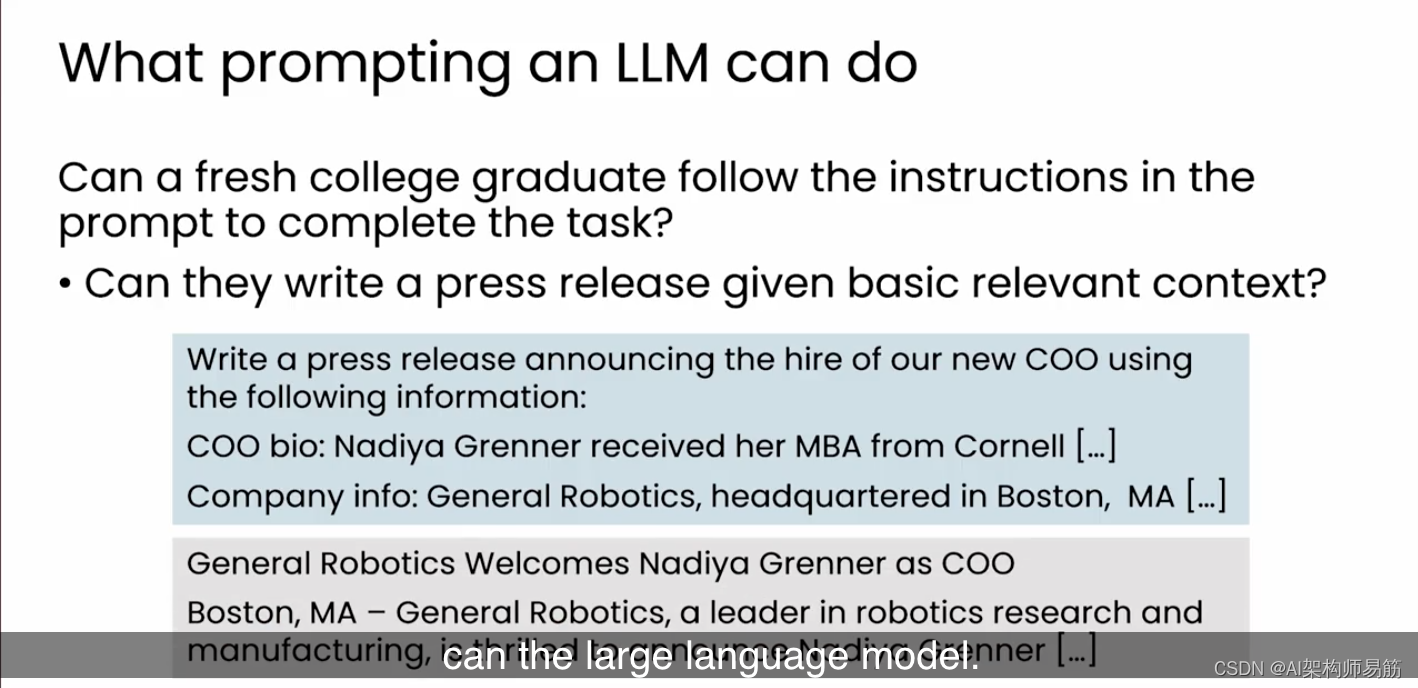

但另一方面,如果你给他们更多关于你的业务和首席运营官的背景信息,那么我们可以问,这个刚毕业的大学生在给定基本相关背景的情况下能写新闻稿吗?我认为他们可能做得相当好,大型语言模型也是如此。

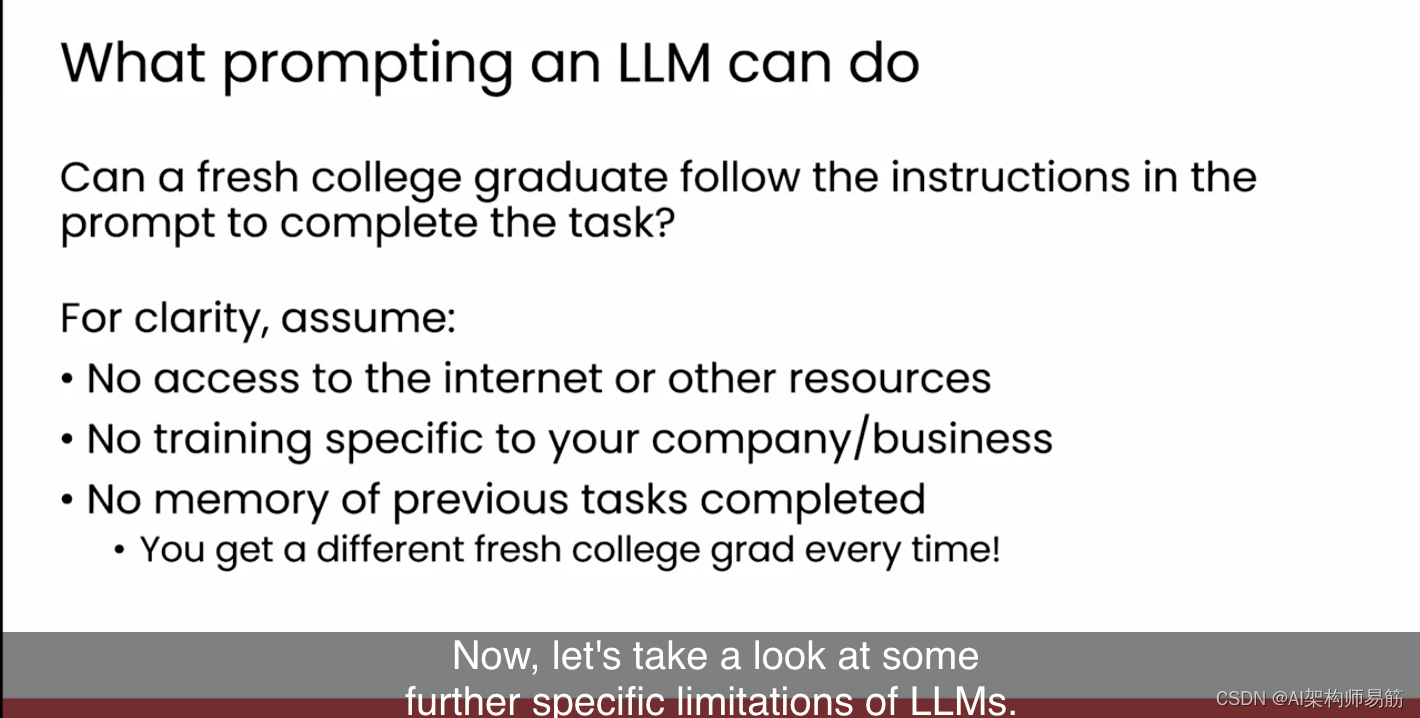

当你设想 LLM 做很多一个刚毕业的大学生可能做的事情时,想象这个刚毕业的大学生具有他们所知道的大量背景知识,互联网上的大量一般知识。但他们必须在没有访问网络搜索引擎的情况下完成这个任务,他们对你或你的业务一无所知。为了清晰,这个心理模型思维实验中,刚毕业的大学生必须在没有针对公司或你的业务的特定培训的情况下完成任务。而且,每次你引导你的 LLM 时,LLM 实际上不会记住之前的对话。因此,就好像你每次都得到一个不同的刚毕业的大学生来完成每个任务,所以你无法随着时间训练他们了解你的业务的细节或你希望他们写作的风格。这个关于刚毕业的大学生能做什么的经验法则是一个不完美的经验法则,有些大学毕业生能做的事情 LLM 不能做,反之亦然。但我发现这是一个思考 LLM 能做什么和不能做什么的有用起点。

虽然我们在这张幻灯片上专注于引导 LLM 能做的事情,但下周当我们谈论生成式 AI 项目时,我们将讨论一些稍微更强大的技术,可能能够扩展你能用生成式 AI 做的事情,超出这个刚毕业的大学生的概念。

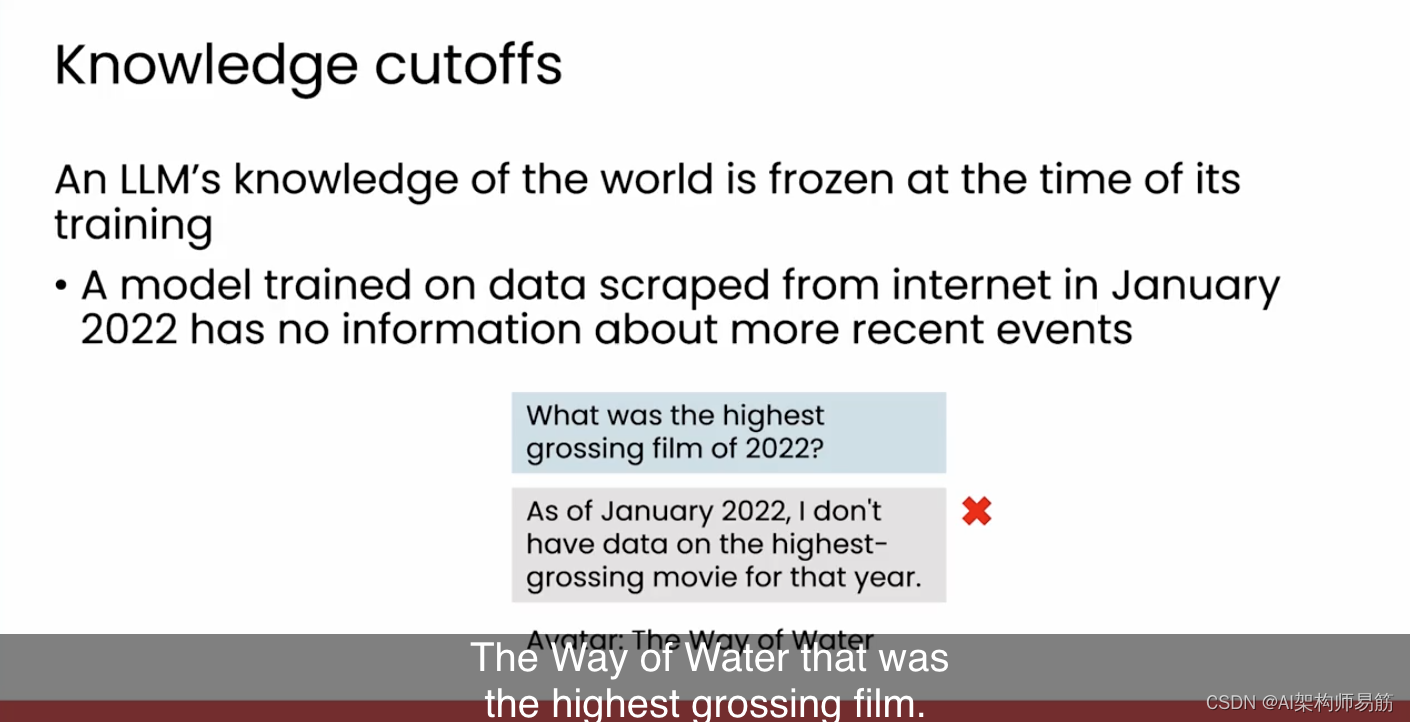

现在,让我们来看看 LLM 的一些具体限制。首先是知识截止点。LLM 对世界的了解在其训练时就被冻结了。更准确地说,一个在 2022 年 1 月之前抓取互联网数据训练的模型,将不会有关于更近期事件的信息。因此,如果你问这样一个模型,2022 年最卖座的电影是什么?它会说它不知道。即使现在我们早已过了 2022 年,我们知道最卖座的电影是《阿凡达:水之道》。

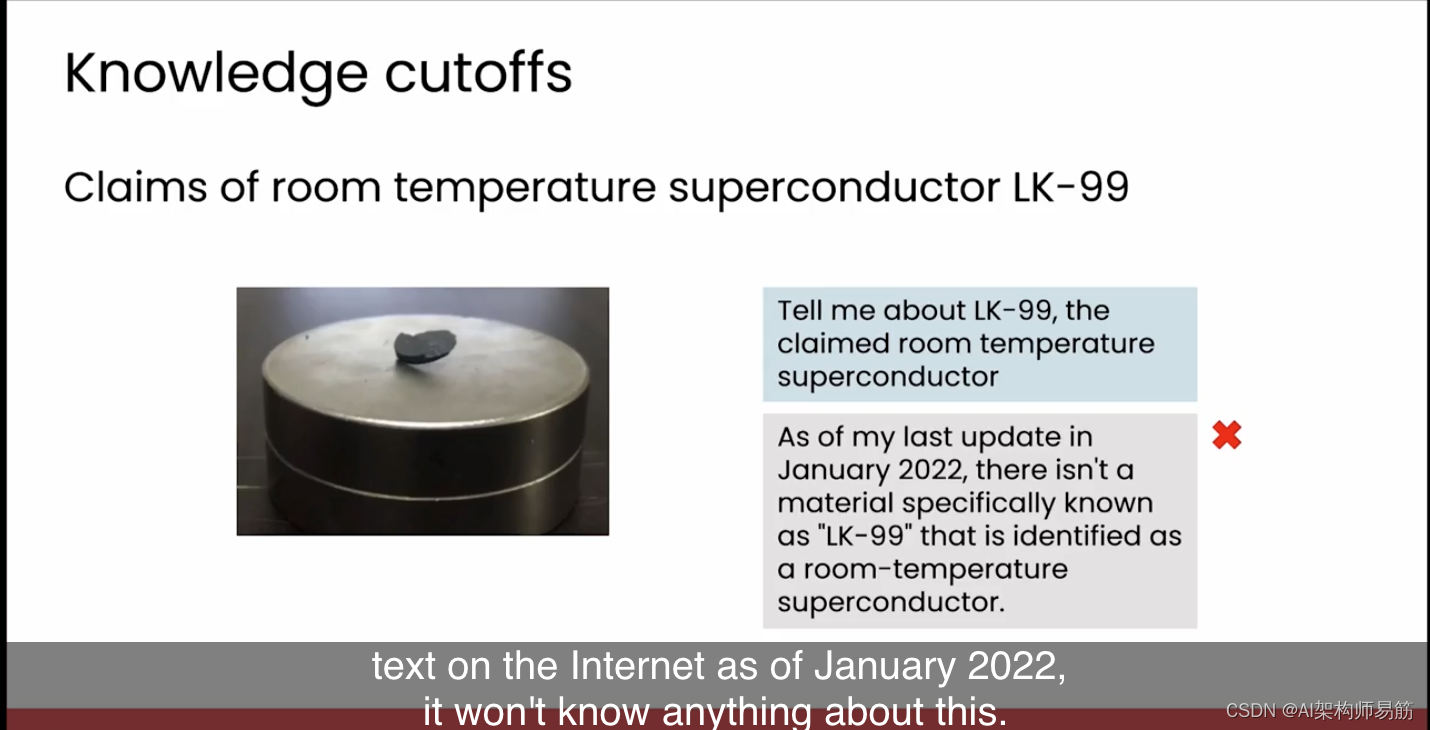

大约在 2023 年 7 月,有研究室声称发现了一种名为 LK-99 的室温超导体。你可能在一些新闻中看到了这张照片,这个说法后来被证明并不完全正确。但如果你问一个 LLM 关于 LK-99 的问题,即使它在新闻中被广泛报道,如果 LLM 只从 2022 年 1 月之前的互联网文本中学习,它就不会知道这件事。所以这就是所谓的知识截止点,LLM 只知道到某个时刻为止的世界。当它被训练时,或者互联网文本最后一次被下载用于 LLM 的训练时。

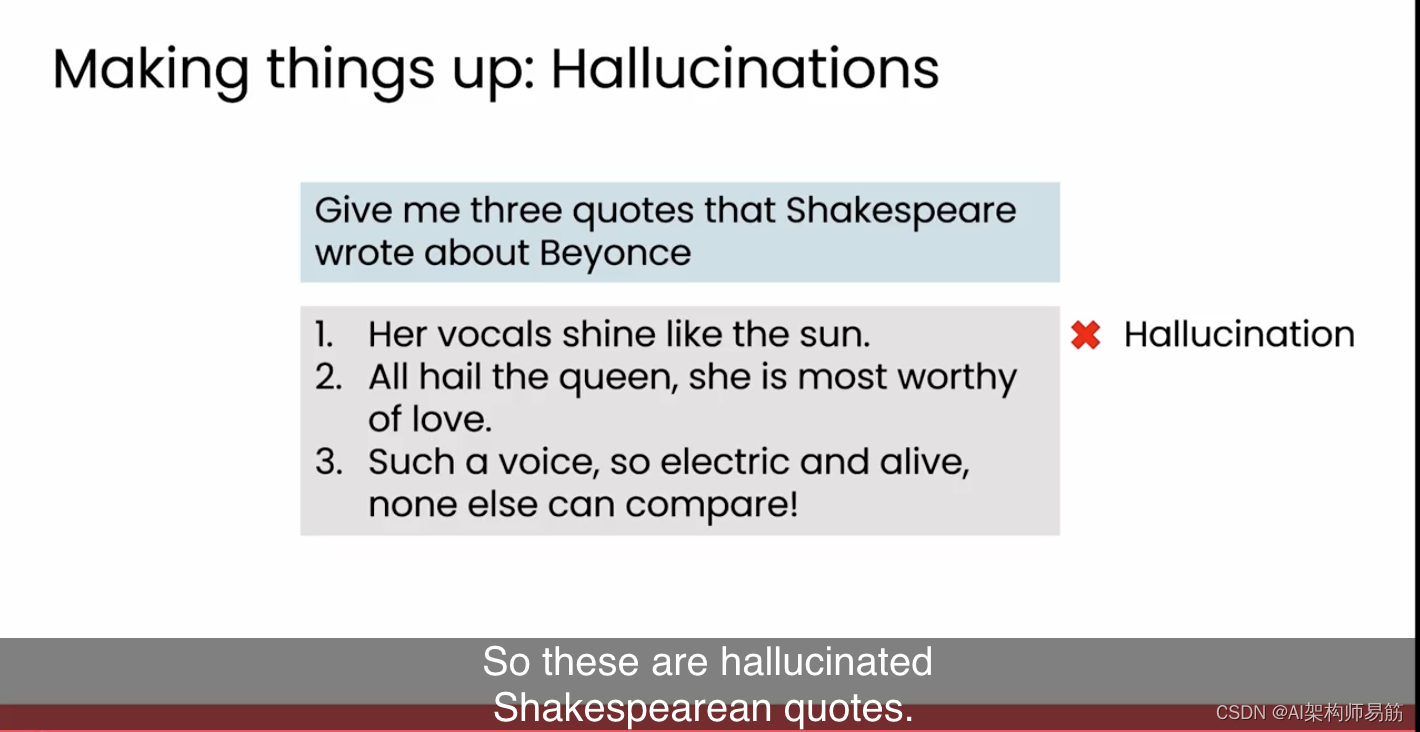

LLM 的第二个限制是它们有时会编造事情,我们称之为幻觉。我发现,如果我让 LLM 给我一些历史上著名人物的引语,它经常会编造引语。例如,如果你让它给出莎士比亚写的关于碧昂斯的三个引语。由于莎士比亚早在碧昂斯之前就已经去世,我不认为莎士比亚对碧昂斯说过任何话。但 LLM 会自信地给你回复一些引语,比如她的声音像太阳一样照耀,或者全场向女王致敬,她是最值得爱的。所以这些是幻想的莎士比亚式引语。

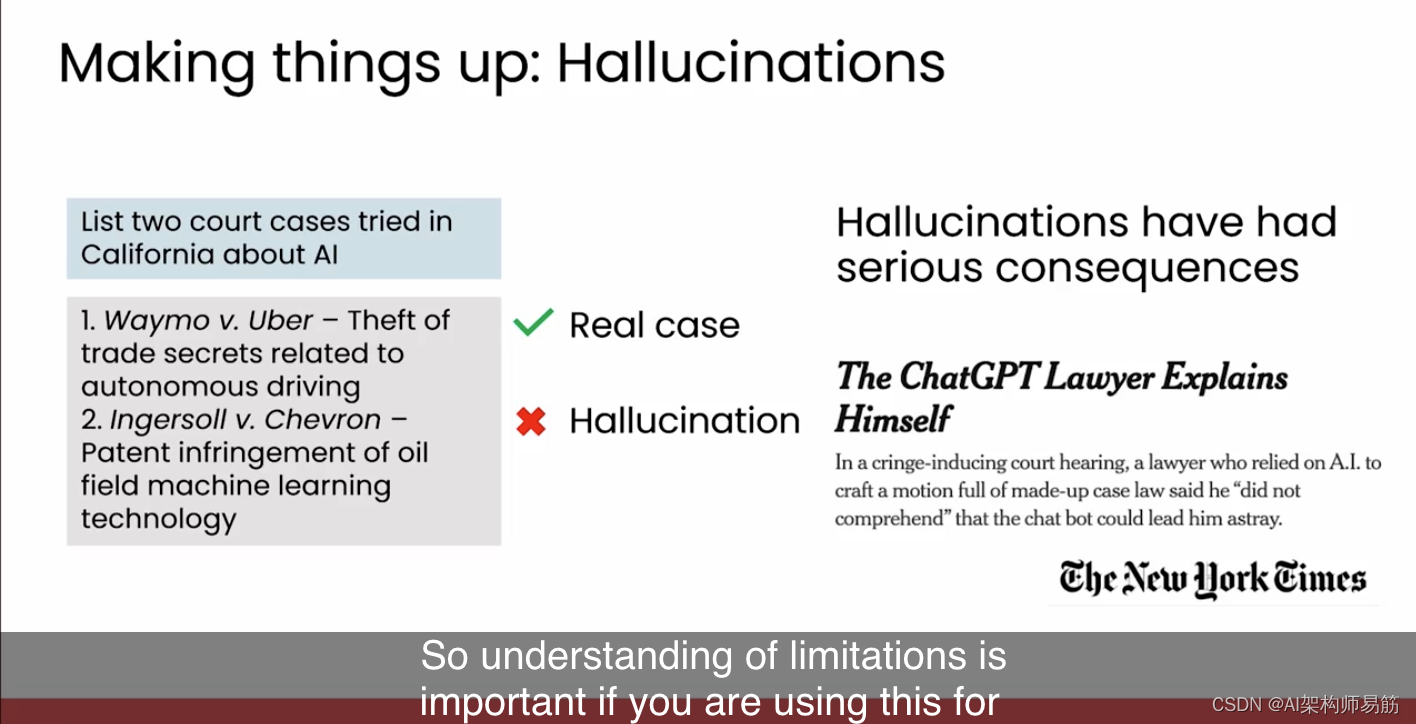

或者,如果你让它列出在加利福尼亚审理的关于 AI 的法庭案件,它可能会给出听起来很权威的答案,就像这样。在这种情况下,第一个案例是真实的,确实有 Waymo 诉 Uber 一案,但我无法找到 Ingersoll 诉 Chevron 一案,所以第二个案例是幻想的。有时 LLM 可以以非常自信、权威的语气编造事情。这可能会误导人们认为这个编造的事情可能是真实的。幻觉可能会带来严重的后果。有一位律师不幸地使用 ChatGPT 生成了一个法律案件的文本,并实际上提交给了法庭,他并不知道他提交给法庭的是一个充满编造案件的非法文件。在这个《纽约时报》的标题中,我们看到了这个让人尴尬的法庭听证会。

依赖人工智能的律师表示,她没有意识到聊天机器人可能会误导她,而这位特定的律师因为提交了包含虚构内容的联合诉讼文件而受到了处罚。

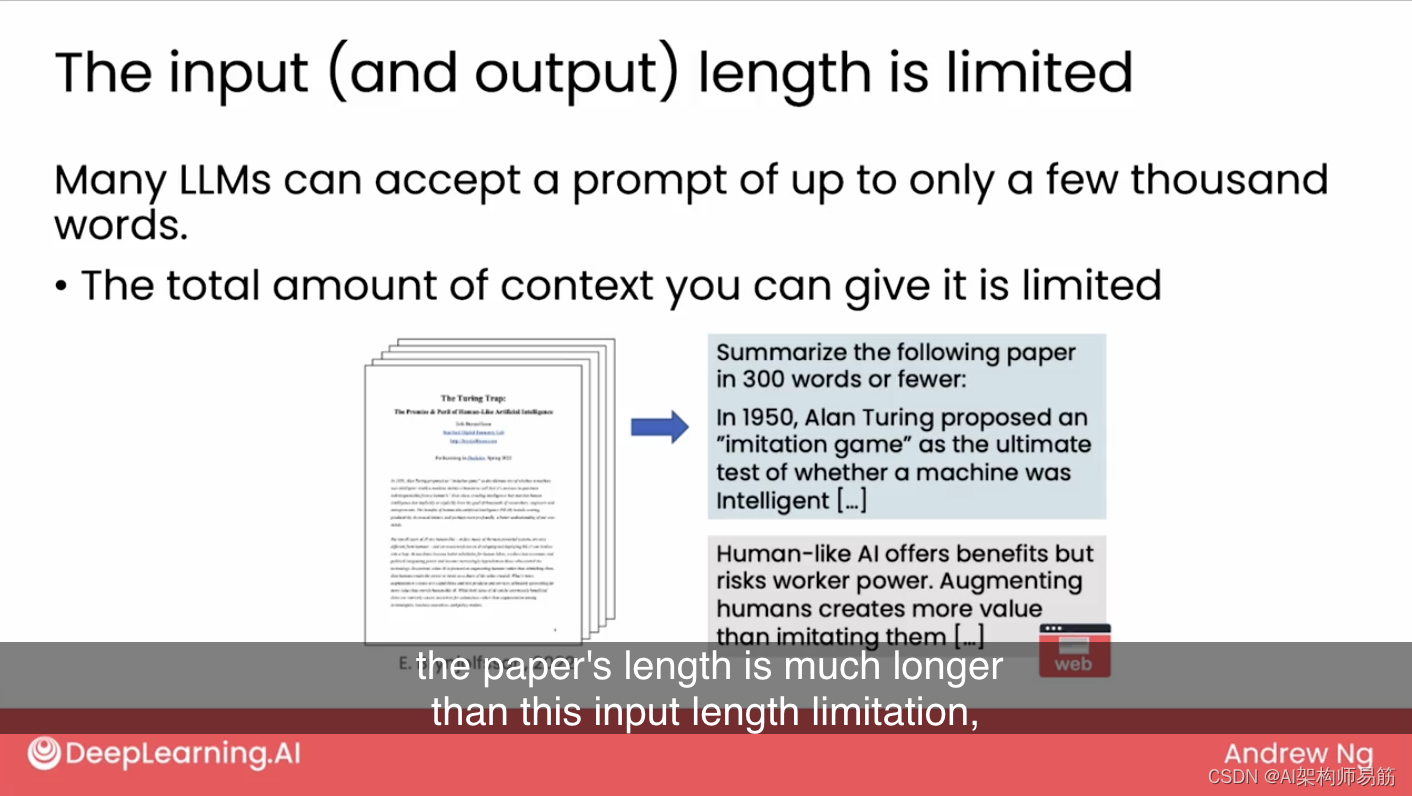

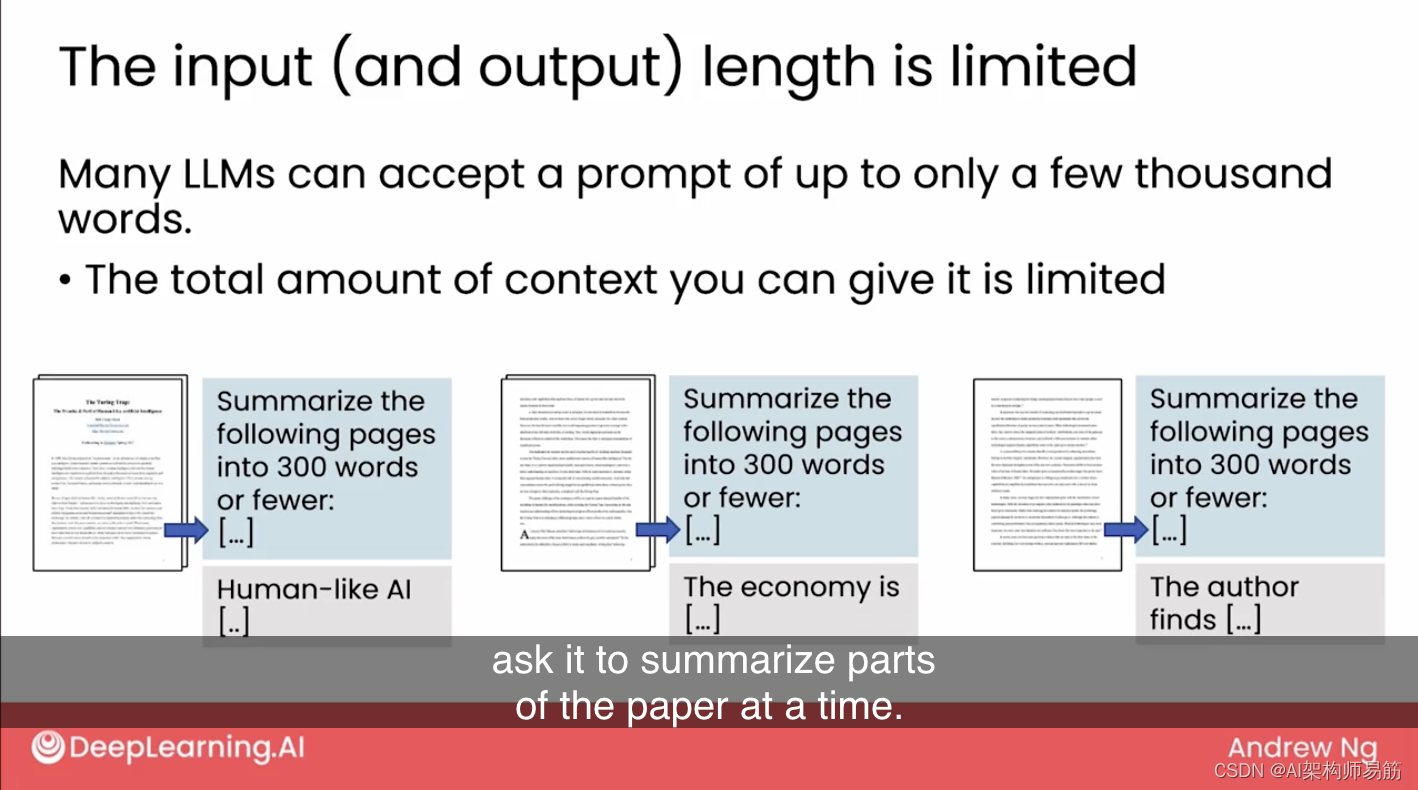

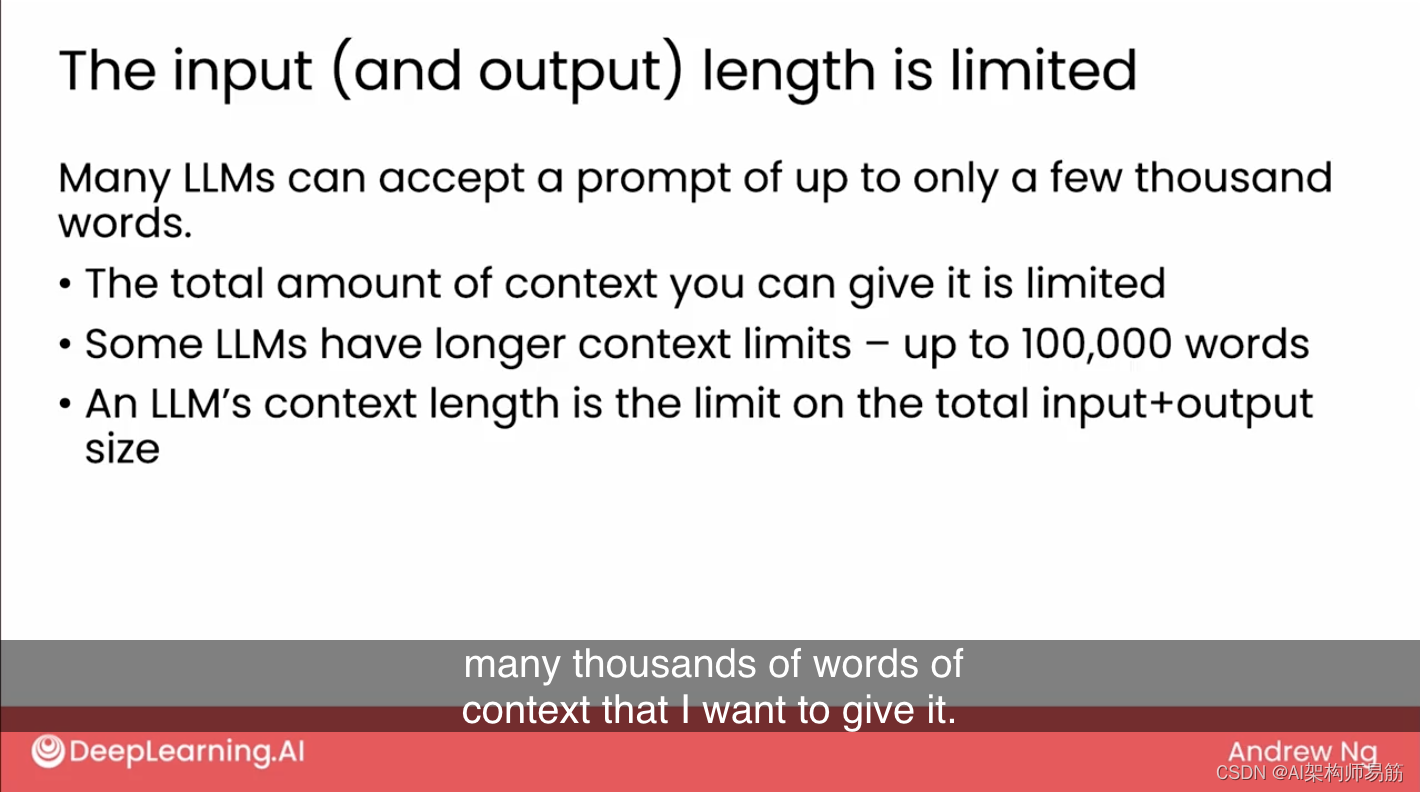

因此,如果你要将其用于具有实际后果的文件,了解其限制是很重要的。LLM 也有一个技术限制,即输入长度,也就是提示的长度是有限的,它能生成的文本的输出长度也是有限的。许多 LLM 最多只能接受几千个词的提示,因此你可以给它的上下文总量是有限的。所以,如果你让它总结一篇论文,而论文的长度远超过这个输入长度限制,LLM 可能会拒绝处理该输入。在这种情况下,你可能必须一次给它论文的一部分,并要求它一次总结论文的一部分。

或者有时你也可以找到一个输入限制长度更长的 LLM,有些可以接受多达数万个词。从技术上讲,LLM 对所谓的上下文长度有限制,而上下文长度实际上是对总输入+输出大小的限制。

当我使用 LLM 时,我很少让它生成如此多的输出以至于真正遇到输出长度的限制。但如果我有许多许多千字的上下文想给它,我有时确实会遇到输入长度的限制。

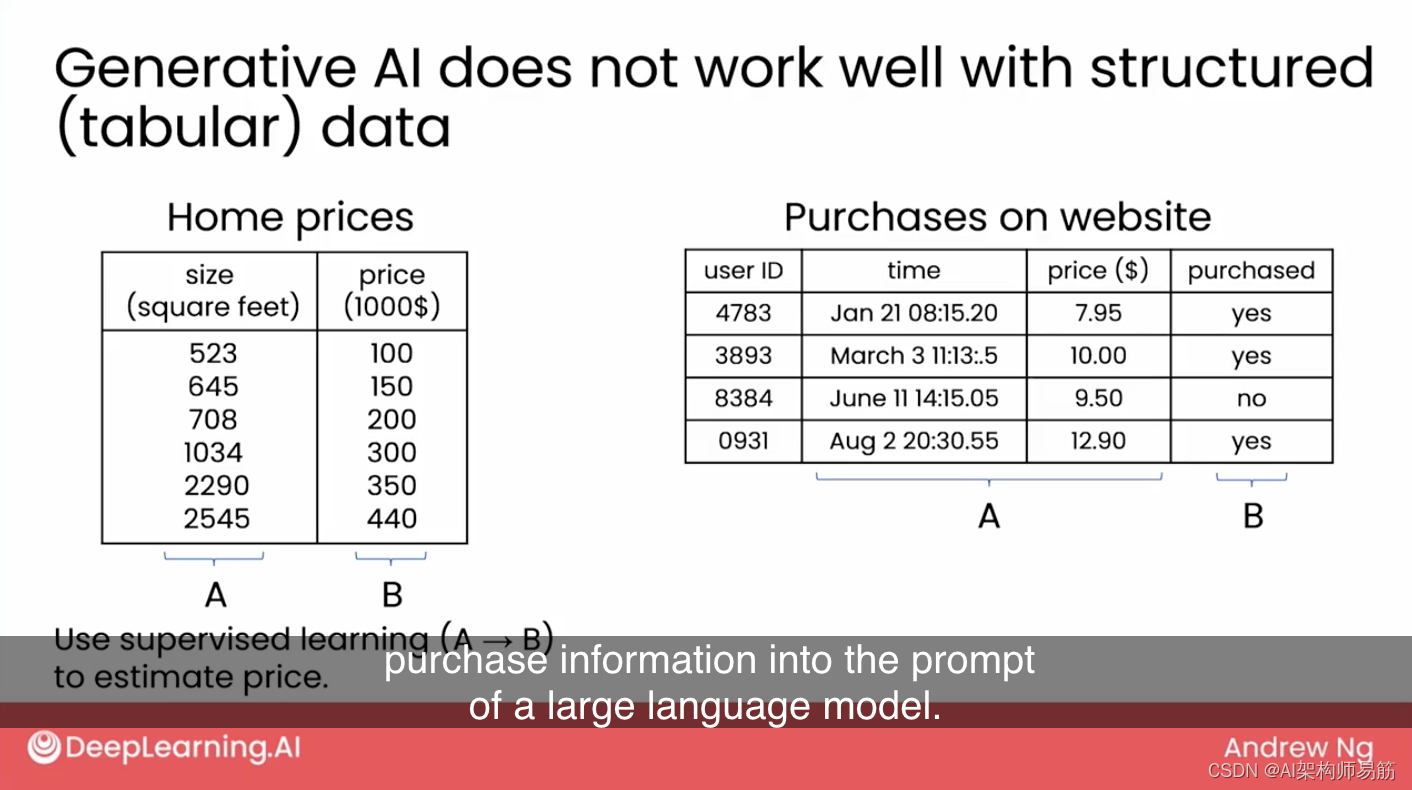

最后,生成式 AI 的一个主要限制是它们目前对结构化数据处理不好。所谓的结构化数据,我指的是表格数据,像你可能会存储在 Excel 或 Google 表格中的那种数据。例如,这里有一个带有房屋大小(平方英尺)和房价数据的房价表。如果你将所有这些数字输入到 LLM,然后问它,我有一栋 1,000 平方英尺的房子,你认为合适的价格是多少?LLM 在这方面并不擅长,相反,如果你把大小称为输入 A,价格称为输出 B,那么监督学习将是一种更好的技术,用以估算价格作为大小的函数。

这是另一个结构化数据的例子,表格数据显示不同访客可能访问你的网站的时间,你向他们提供产品的价格,以及他们是否购买了它。同样,监督学习将是一种比尝试将所有这些时间、价格和购买信息复制粘贴到大型语言模型的提示中更好的技术。

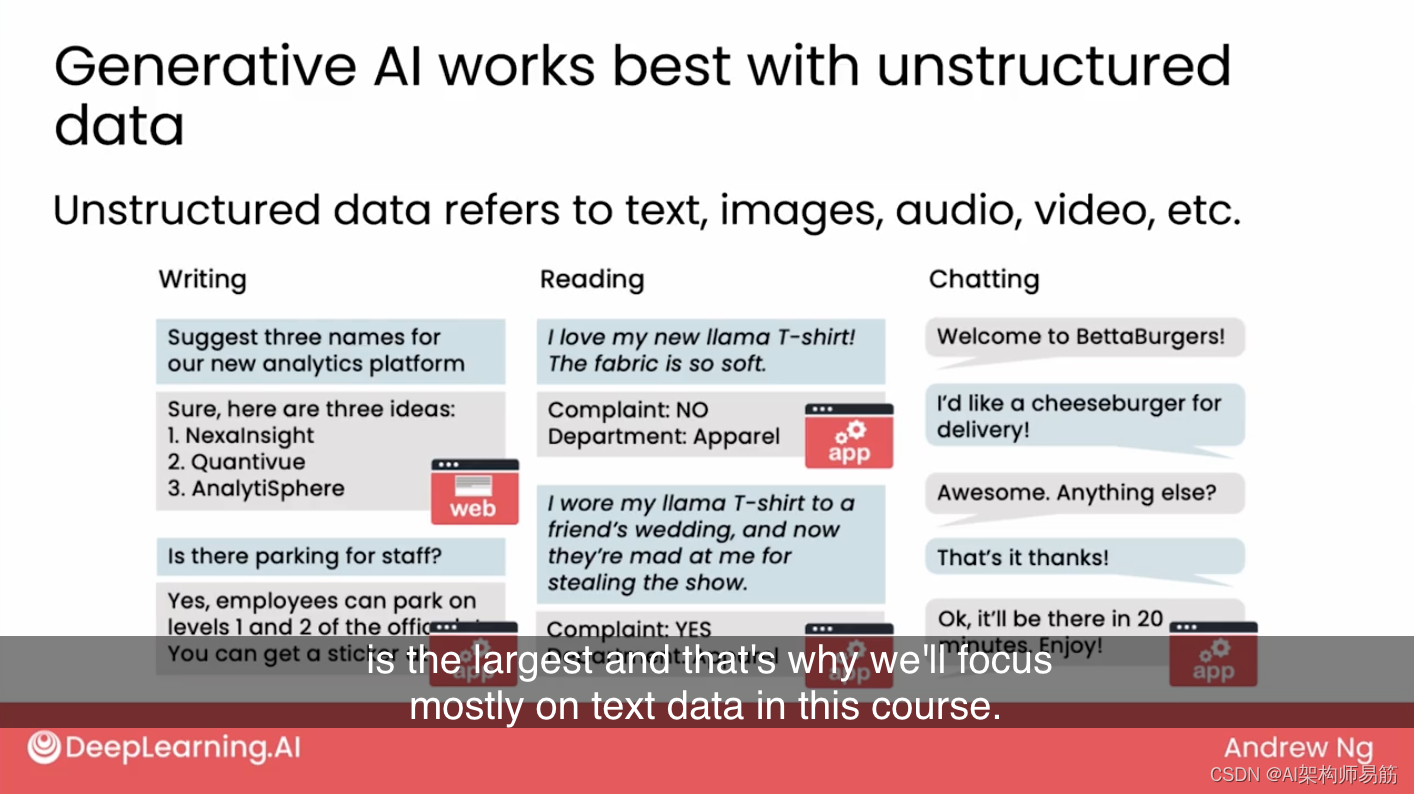

与结构化数据相比,生成式 AI 更适合处理非结构化数据。结构化数据指的是你会存储在电子表格中的表格数据,而非结构化数据指的是文本、图像、音频、视频。生成式 AI 确实适用于所有这些类型的数据,尽管影响最大,这就是为什么我们在这门课程中主要关注文本数据。

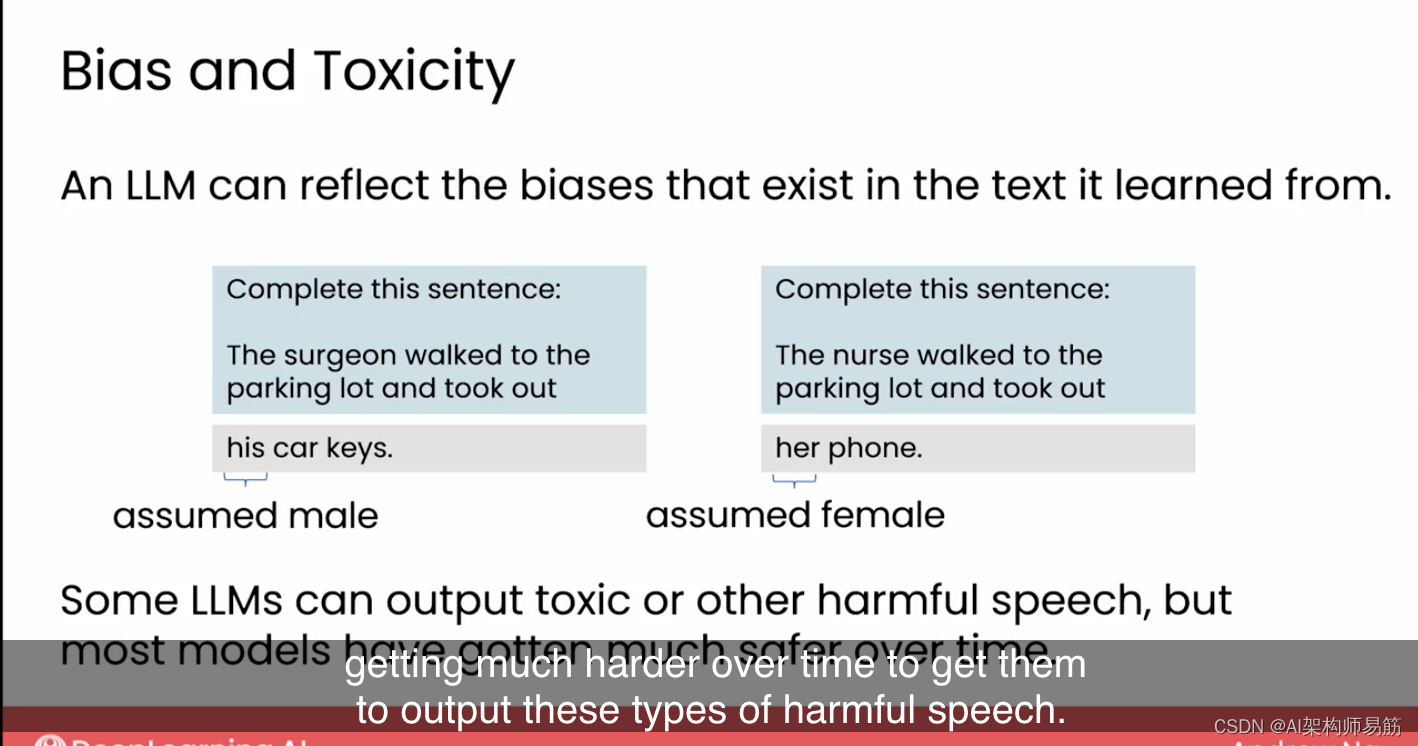

最后,大型语言模型可能会偏见输出,有时也可能输出有害或其他有害的言论。例如,大型语言模型是在互联网上的文本上训练的。不幸的是,互联网上的文本可能反映了社会中存在的偏见。所以如果你让一个 LLM 完成句子,外科医生走到停车场拿出了,LLM 可能会输出他的车钥匙,但你会说护士走到停车场拿出了,它可能会说她的手机。所以

在这种情况下,LLM 假设外科医生是男性,护士是女性,而我们清楚地知道外科医生和护士可以是任何性别。因此,如果你在可能导致此类偏见带来伤害的应用中使用 LLM,我会小心使用我们的提示方式和应用 LLM,以确保我们不会助长这种不受欢迎的偏见。最后,有些 LLM 有时也会输出有毒或其他有害的言论。例如,有些 LLM 有时会教人们如何做不受欢迎的,有时甚至是非法的行为。幸运的是,所有主要的大型语言供应商一直在努力提高这些模型的安全性,因此大多数模型随着时间的推移变得更加安全。如果你使用主要 LLM 供应商的网络界面,实际上随着时间的推移变得越来越难让它们输出这些类型的有害言论。所以这就总结了引导 LLM 能做和不能做的事情。正如我提到的,下周我们将看一些克服这些限制的技术,使 LLM 能做的事情更广泛、更强大。但首先,让我们看一些关于引导 LLM 的技巧。

参考

https://www.coursera.org/learn/generative-ai-for-everyone/lecture/VYXx5/what-llms-can-and-cannot-do

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!