LM Studio:大语言模型的部署变得前所未有的简单

LM Studio是一款面向开发者的友好工具,特别适合那些想要探索和使用大型语言模型的人。无论是出于专业开发的需要,还是仅仅为了体验和玩转各种API,LM Studio都提供了一个简便、高效的解决方案。

使用LM Studio不需要深厚的技术背景或复杂的安装过程。传统上,本地部署大型语言模型如Lama CPP或GPT-4ALL往往伴随着繁琐的安装步骤和环境配置,这对技术要求极高。然而,LM Studio的出现彻底改变了这一局面。它提供了一个简单的安装程序,用户只需几个简单的步骤就可以轻松安装和运行。

LM Studio的一个重要特点是它对各种模型的广泛支持。它不仅支持所有公开发布的大型语言模型,而且不需要用户进行额外的编译或微调。这意味着,无论用户的需求如何,LM Studio都能提供所需的模型支持。

LM Studio对GPU和Core ML的兼容性也非常出色,这使得它能够在多种平台上高效运行,包括Mac和Windows。用户只需将应用程序拖到自己的应用文件夹中,即可完成安装,操作简便。

LM Studio的界面设计直观易用。用户只需打开应用,就可以直接开始使用,无需复杂的设置。这对于那些希望节省时间,快速投入大型语言模型开发和探索的用户来说,是一个巨大的优势。

下面是安装和使用LM Studio的介绍:

一、下载LM Studio 应用

1、Windows 版本

【免费】LMStudiowindows版本安装资源-CSDN文库

2、MAC版本

【免费】LM+StudioMACOS版本安装资源-CSDN文库

二、LM Studio 应用的模型下载

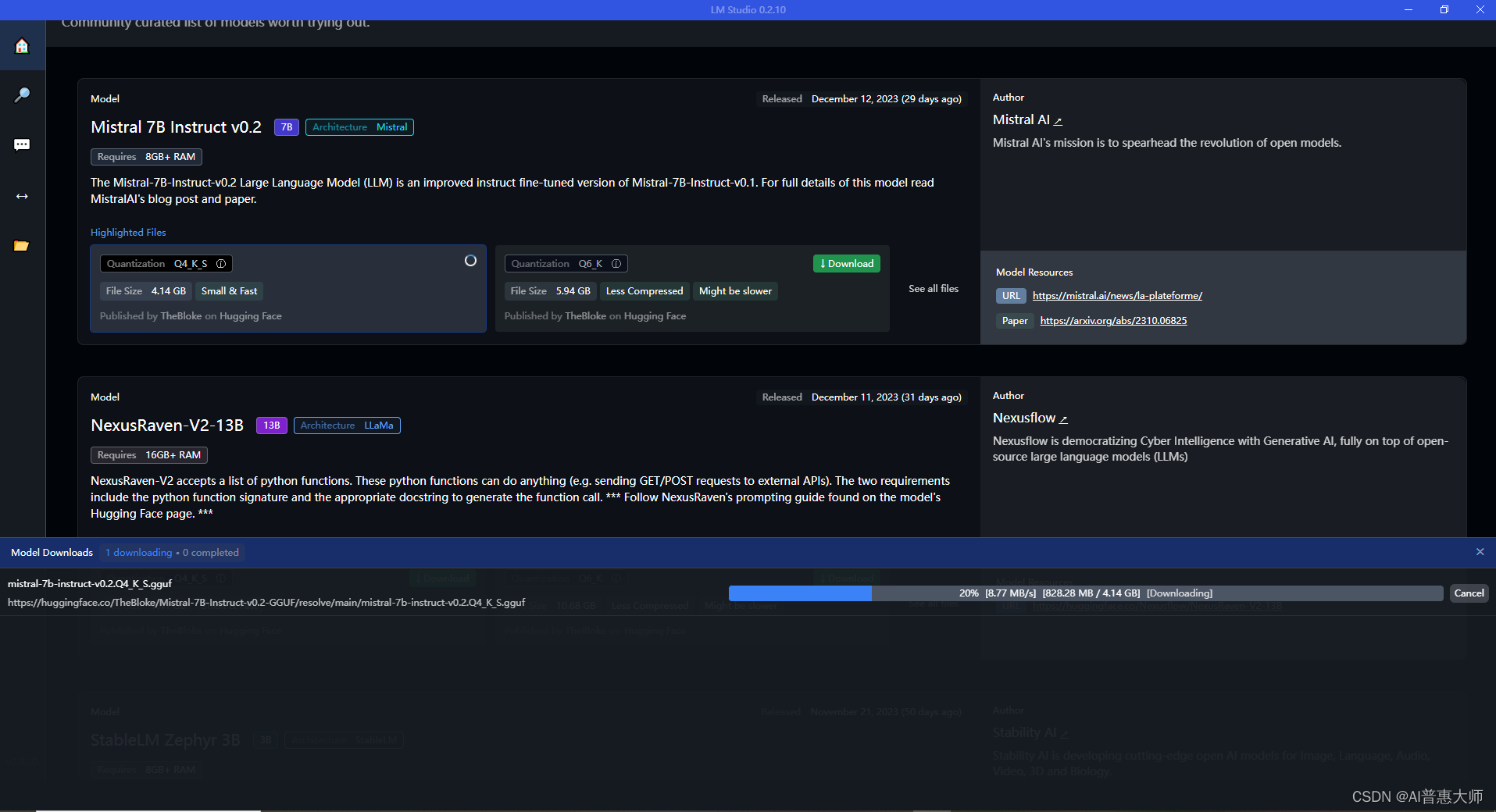

1、在主页中浏览,直接下载模型

如下图:在主界面中直接下拉,可浏览各种大语言模型,选择download 按钮可直接下载,部分模型可能需要VPN到外网才能下载。

我给大家提供了我自己的下载的模型的网盘下载链接:

链接:https://pan.quark.cn/s/c74d915d3fa2

提取码:TrAa

模型下载好之后,将目录一起复制到你的LM Studio所在的模型目录,如下图:

?

?

2、搜索模型

点击放大镜图标,可输入你想要的模型,进行搜索,如下图,我这里搜索GPT4ALL:?

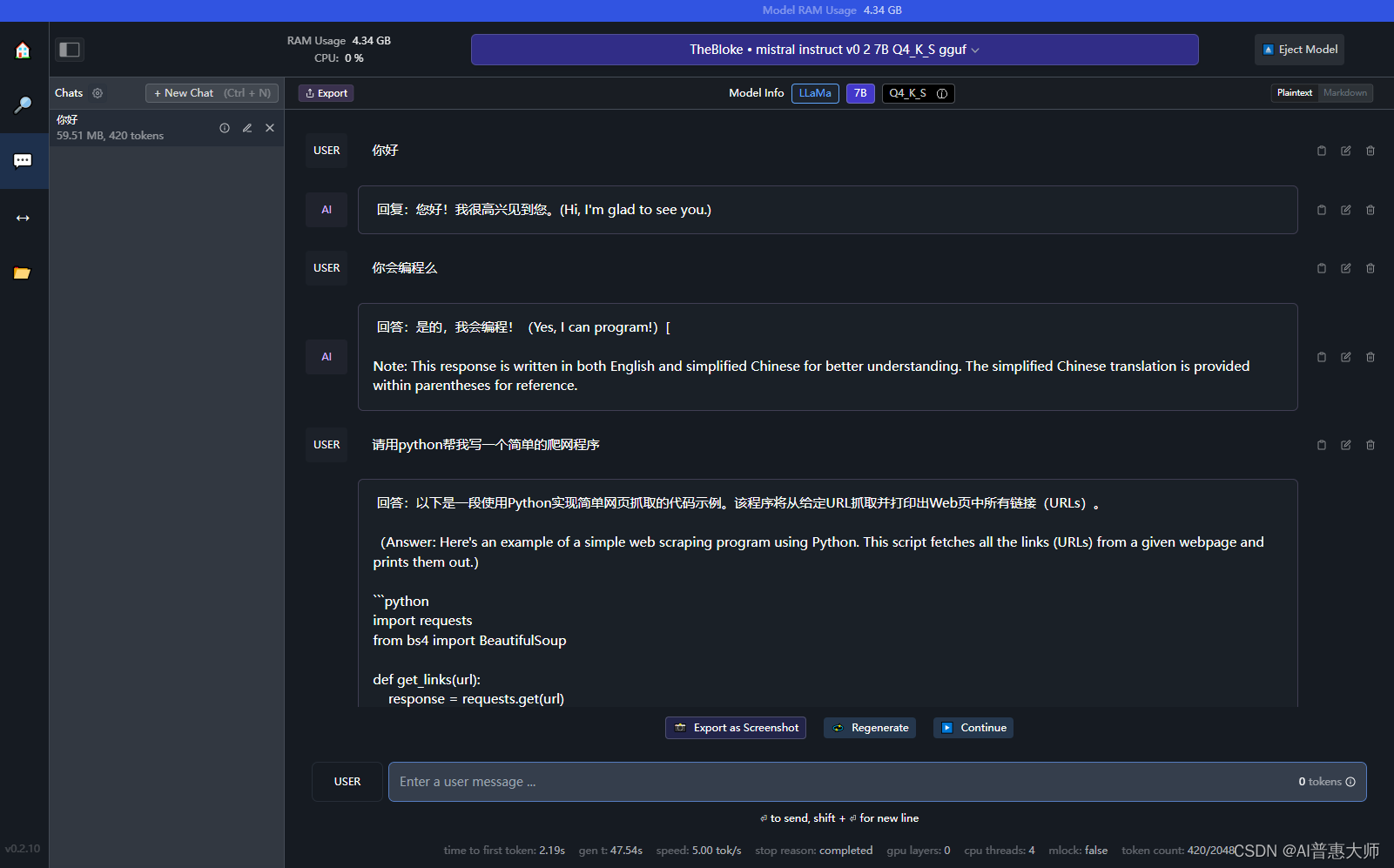

三、模型对话,类似ChatGPT

1、选择模型

在左边菜单栏选择chat图标,然后选择模型(下载之后的模型会在下拉列表中),如下图:

?

?

?2、和模型进行问答对话

直接输入你想要提问的问题,和模型进行对话

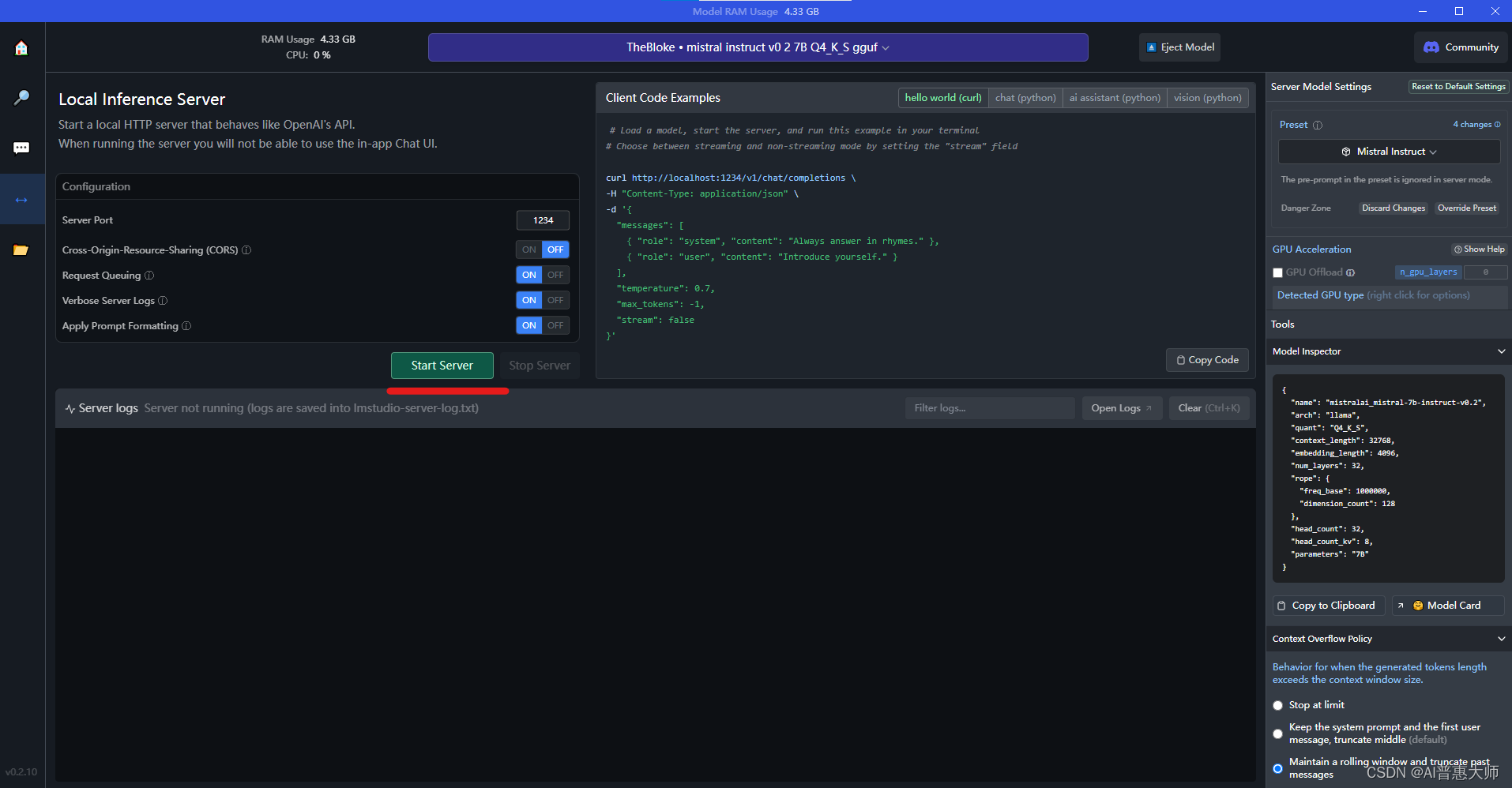

四、启用LocalServer模式

LM Studio 还支持在本地以Server的形式提供和OpenAI 一样的API接口服务,这意味着大家可以把大预言模型做为一个后端服务来进行调用,前端可以包装任意面向业务的功能。

?大家可以copy code 来测试一下访问local server的端口,用curl或python code 都可以。

总的来说,LM Studio是一个强大而用户友好的工具,它简化了大型语言模型的部署和使用过程。无论是专业开发者还是技术爱好者,都可以从这个工具中受益,更高效地探索和利用大型语言模型的强大功能。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!