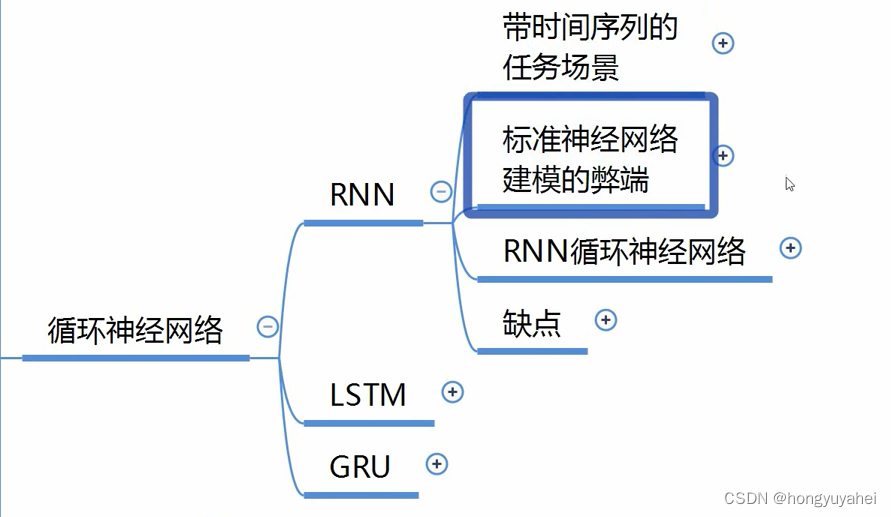

循环神经网络

2023-12-14 21:21:31

1、RNN

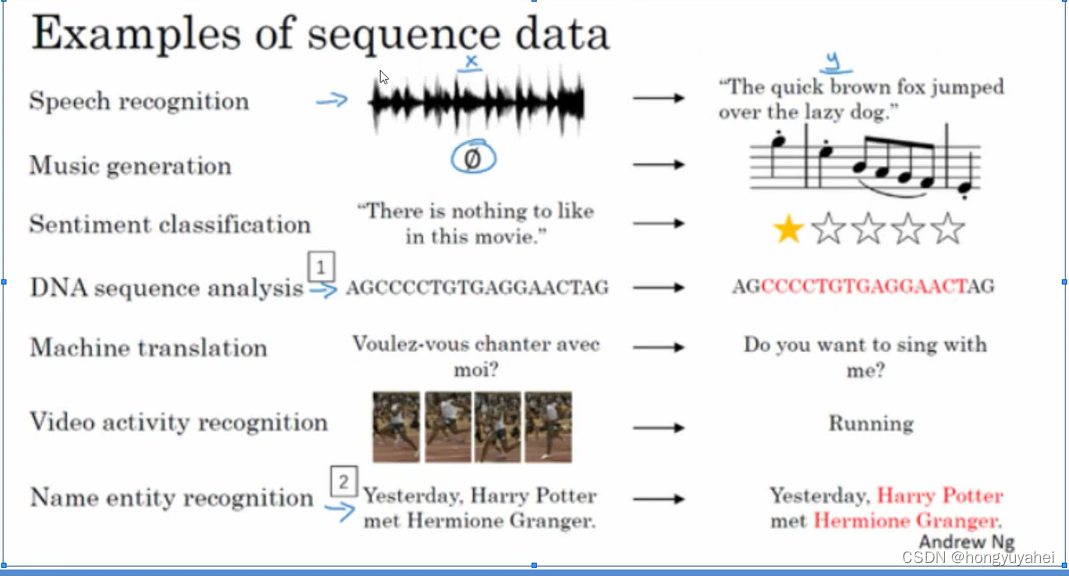

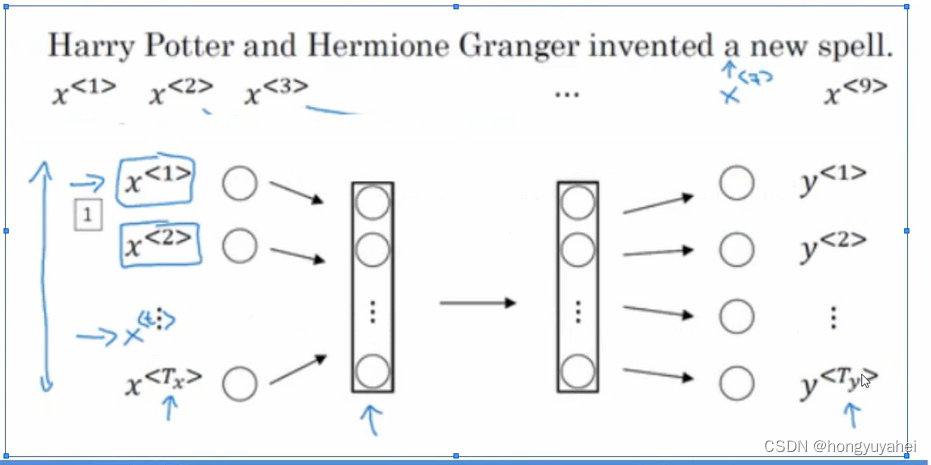

- 带时间序列的任务场景(语言识别、生成音乐、情感分析、DNA序列分析、机器翻译)

前后关联强,“前因后果”

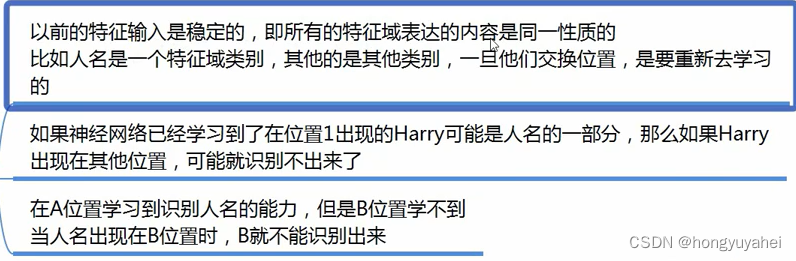

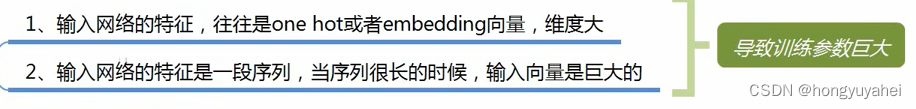

- 标准神经网络建模的弊端

1、输入和输出数据在不同例子中可能有不同的长度

2、一个像这样单纯的神经网络结构,它并不共享从文本的不同位置上学到的特征

3、参数量巨大

4、没有办法体现时序上的“前因后果”

标准神经网络建模不适合带时间序列的任务场景。

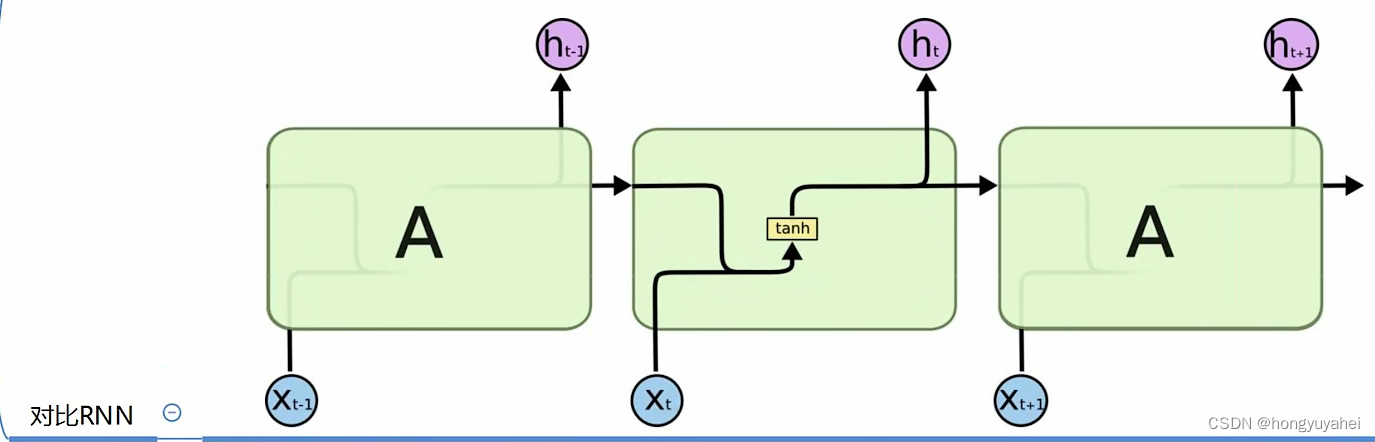

- RNN循环神经网络

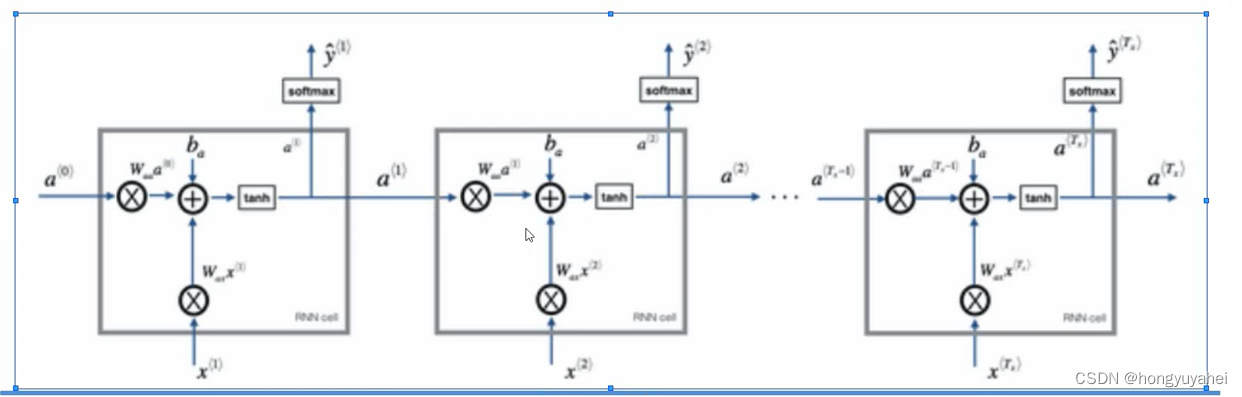

1、网络结构

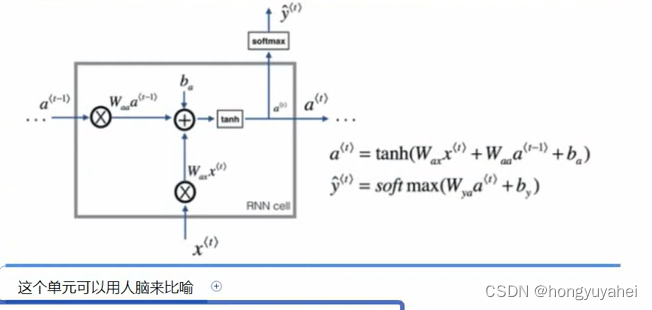

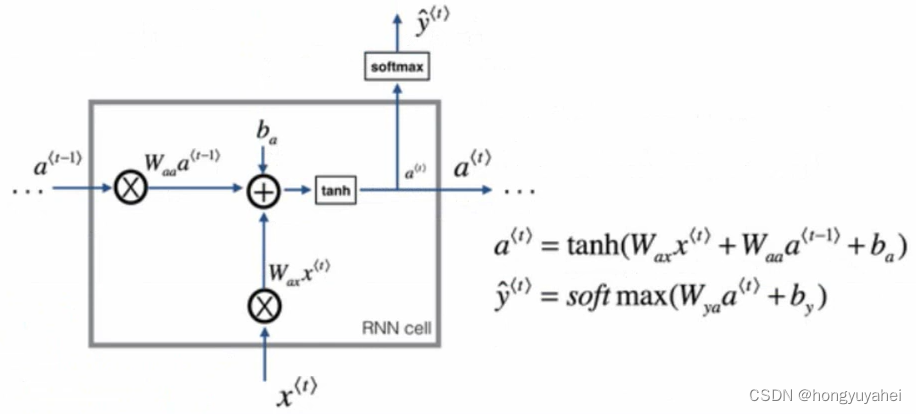

单元

2、特点

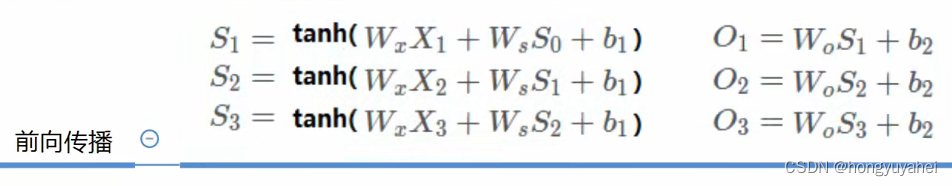

3、前向传播

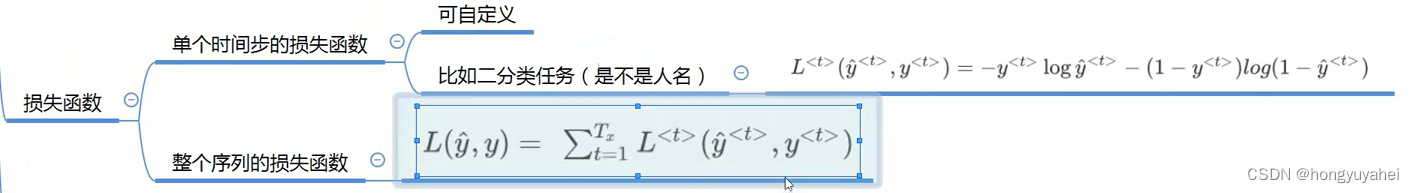

4、损失函数

整个序列的损失函数即将所有时间步的算是函数相加求和。

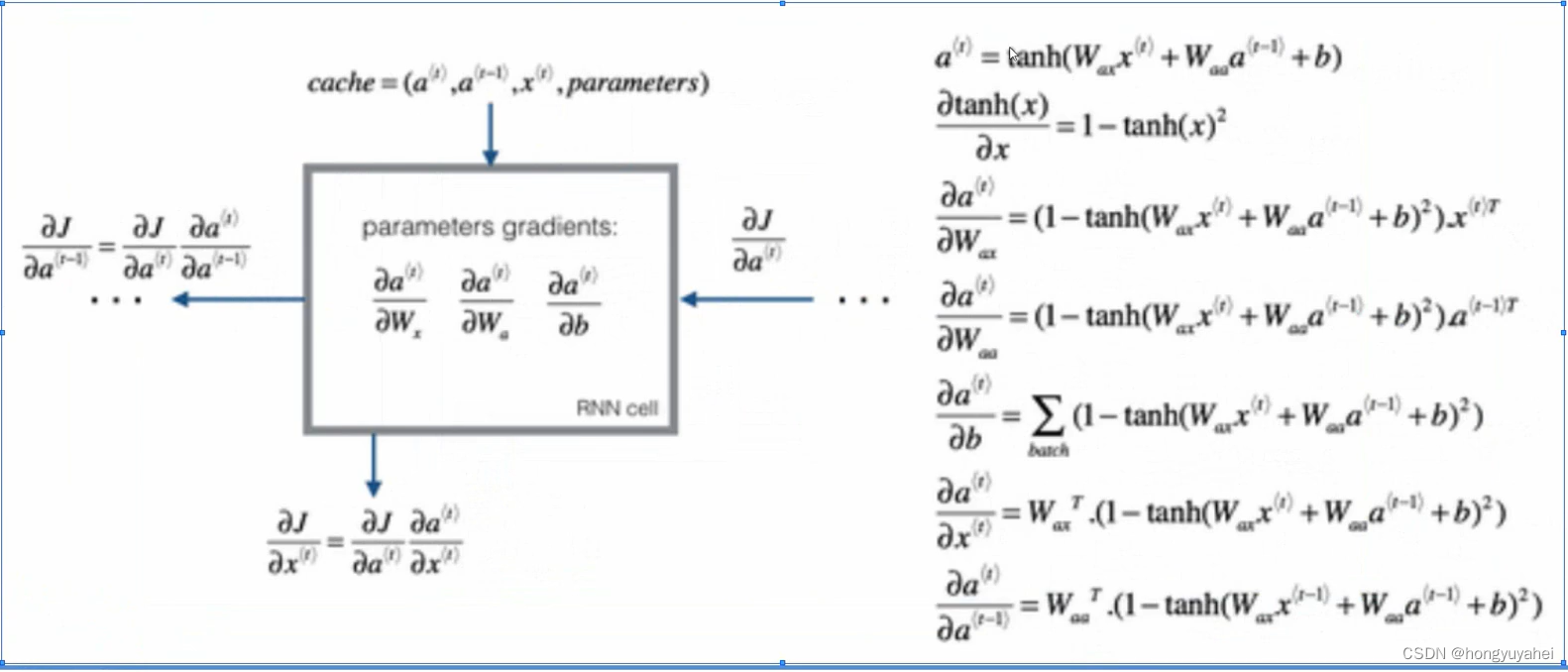

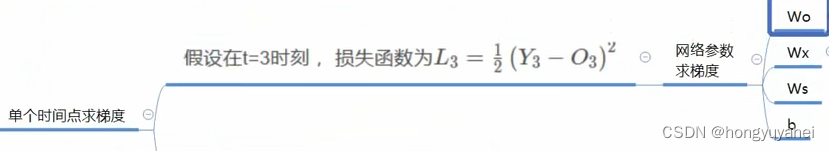

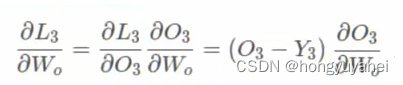

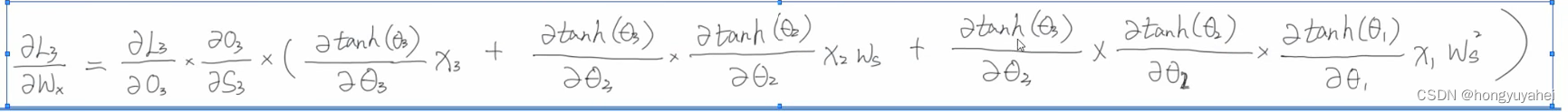

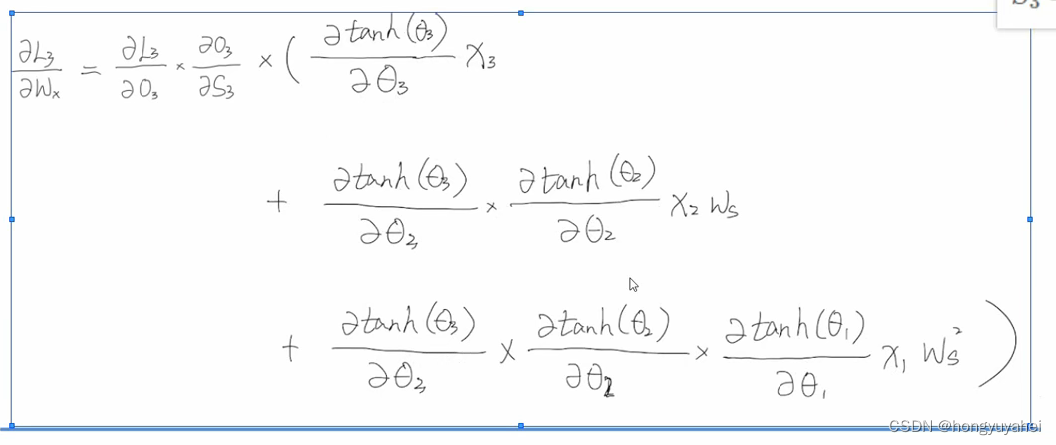

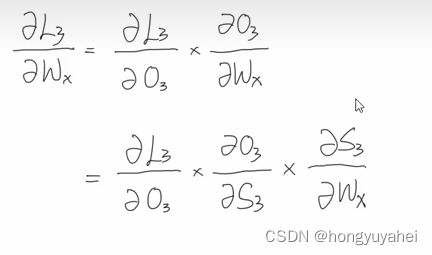

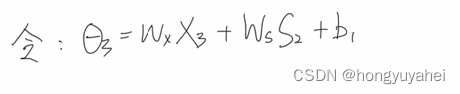

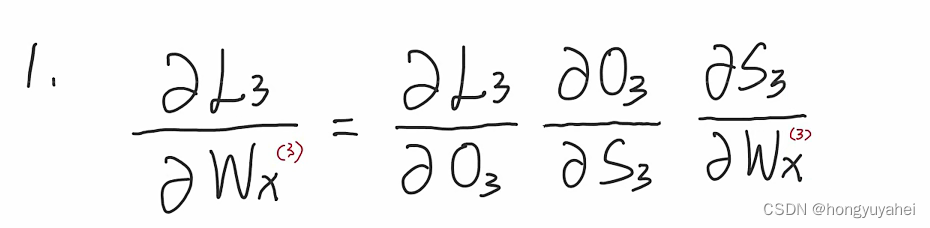

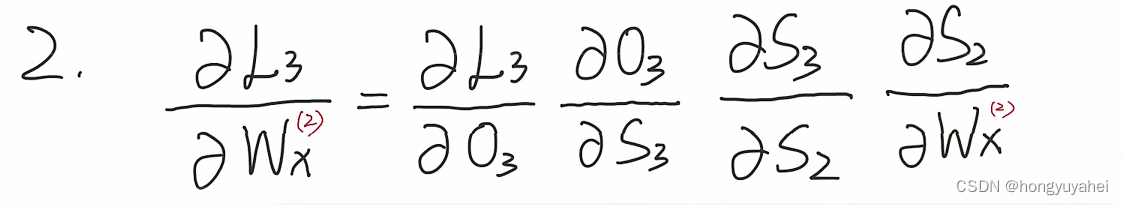

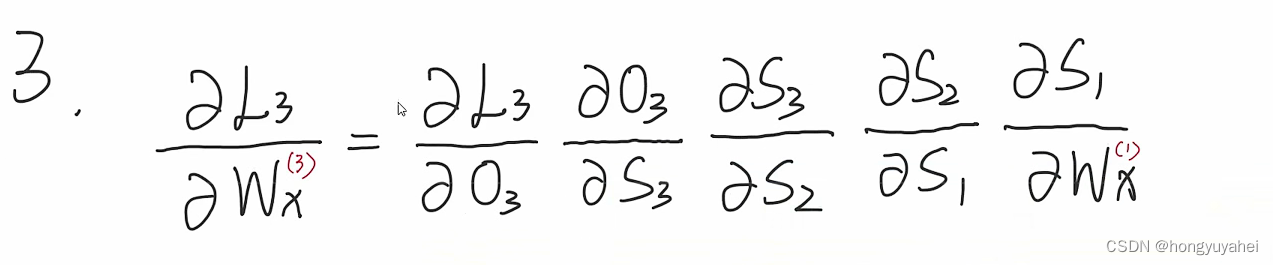

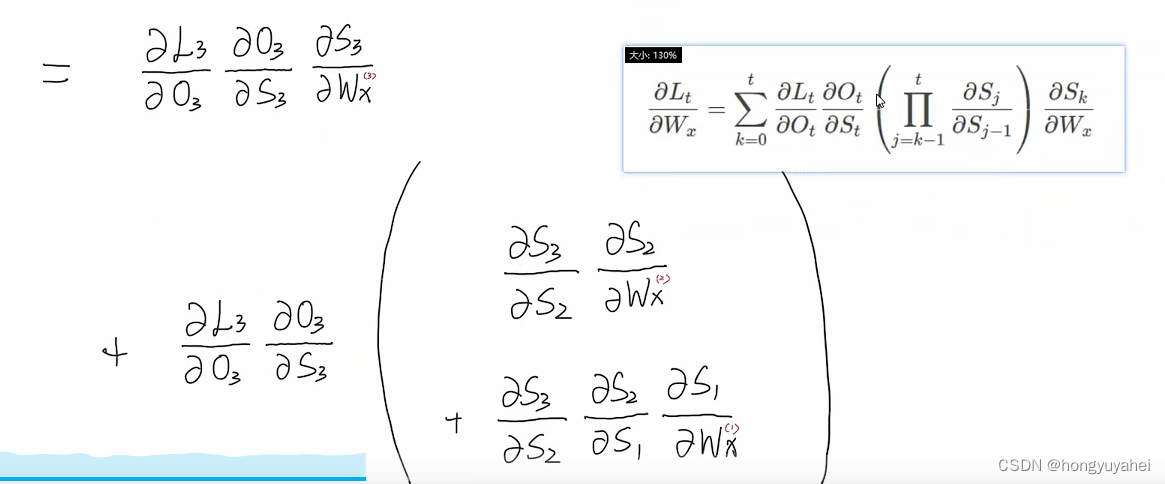

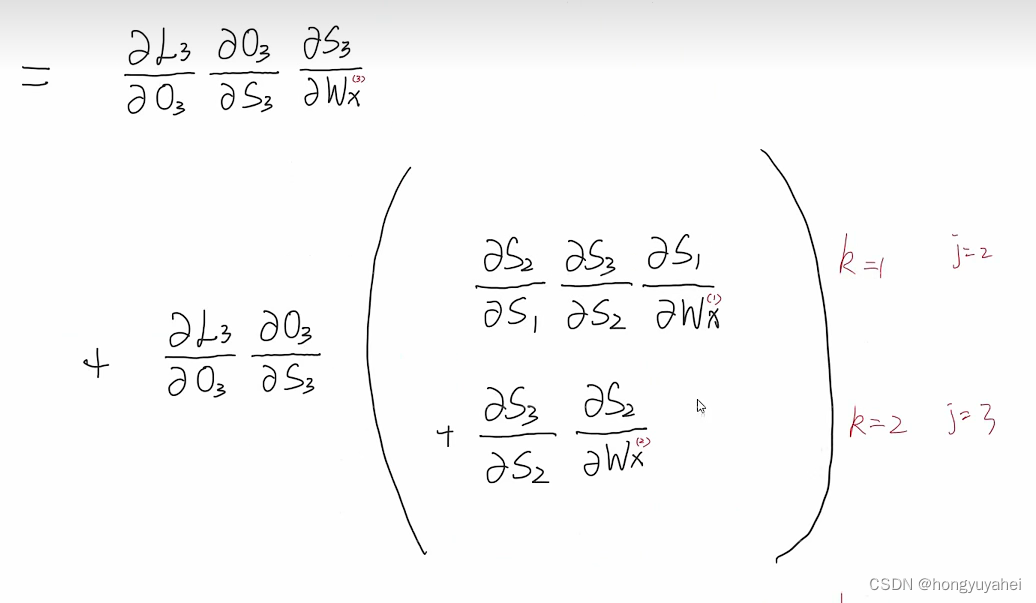

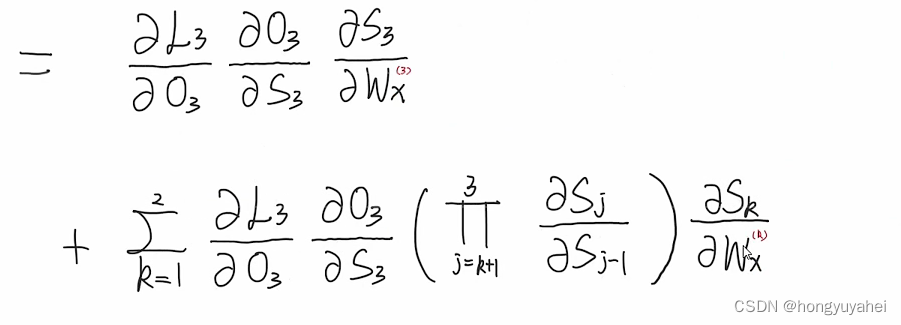

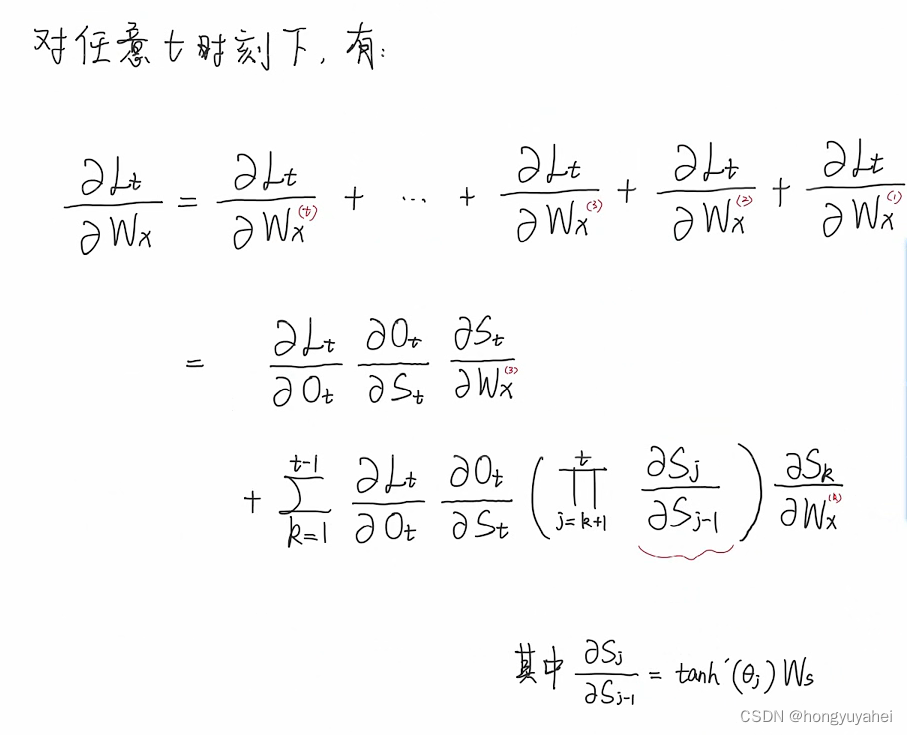

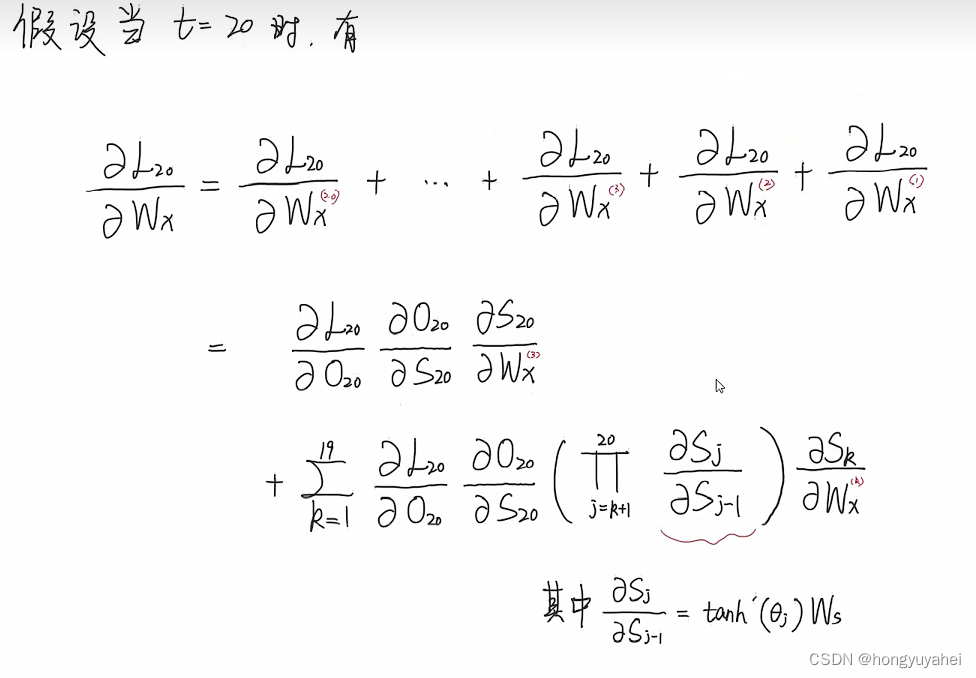

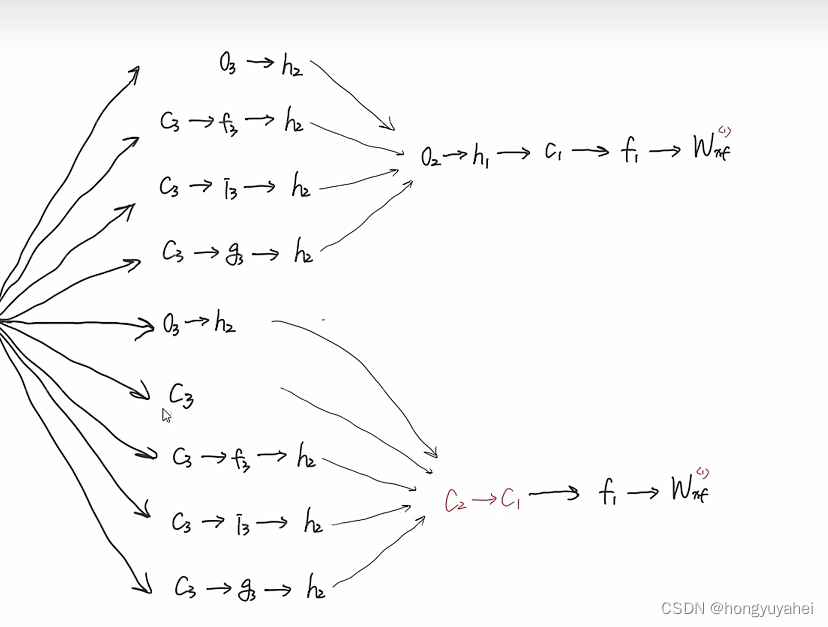

5、反向传播

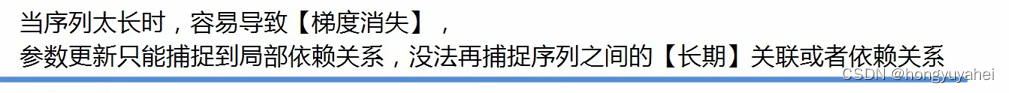

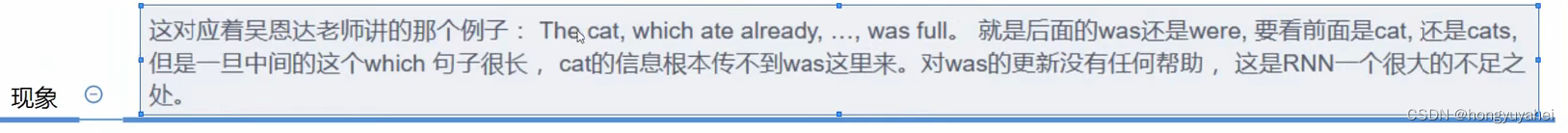

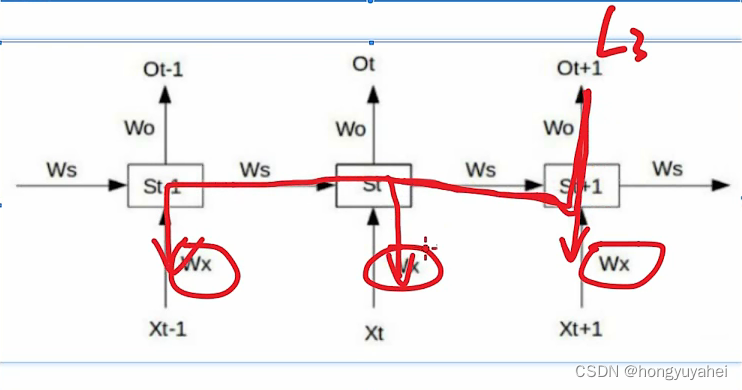

- RNN的缺点

W0:

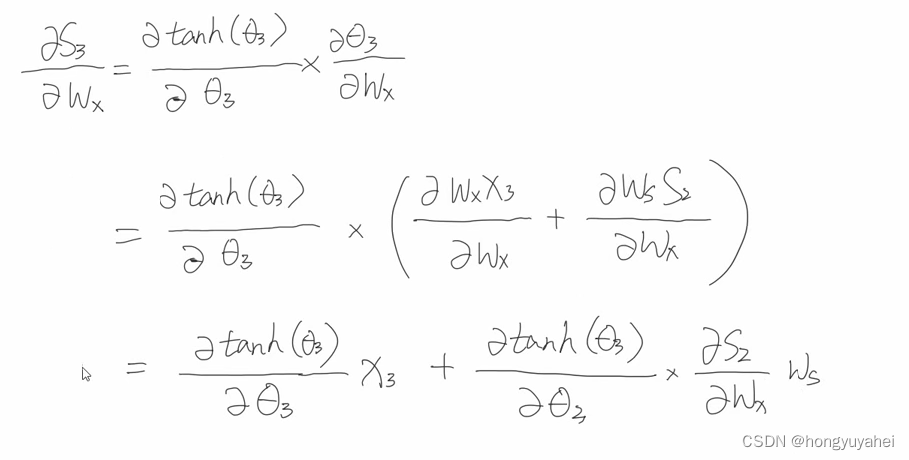

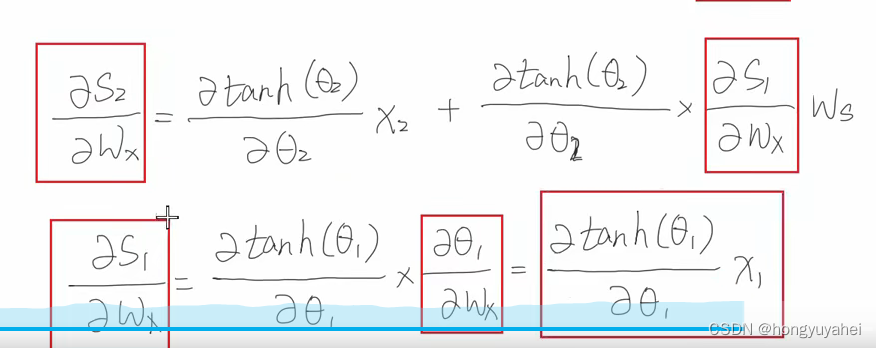

Wx:

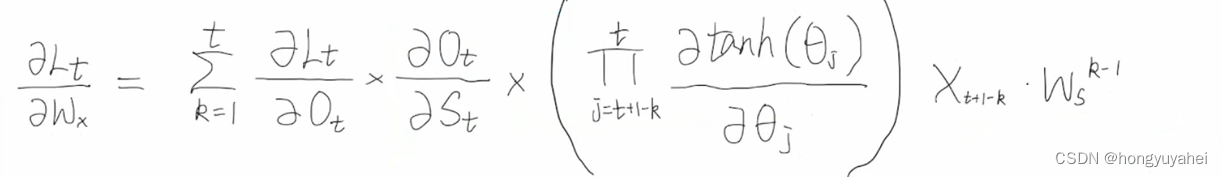

任意时刻下的梯度公式:

Ws^(k-1)是导致可能梯度爆炸和梯度消失的主要原因。

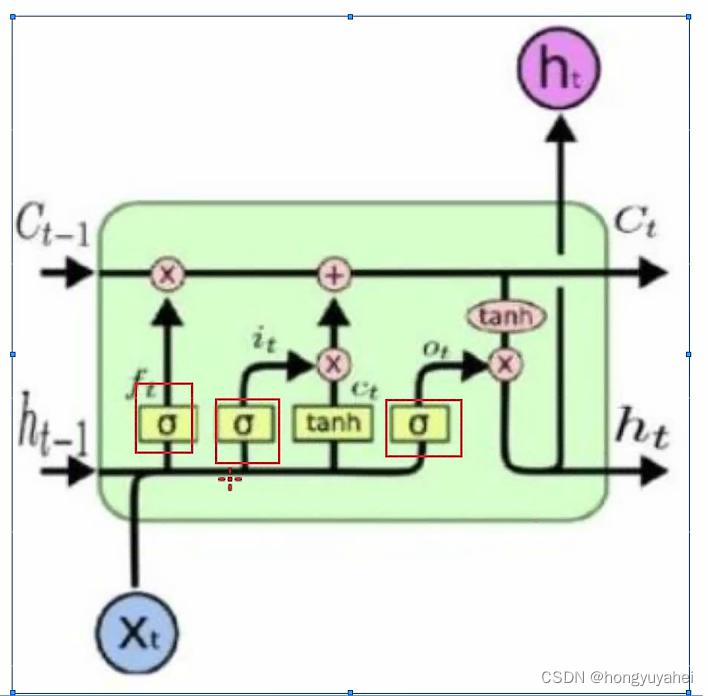

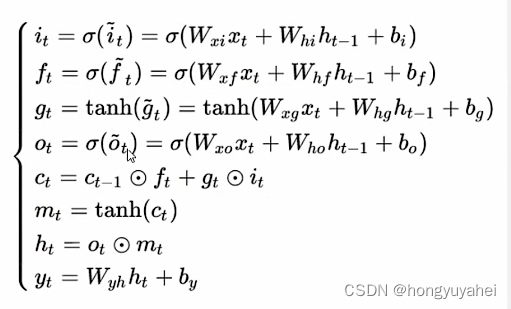

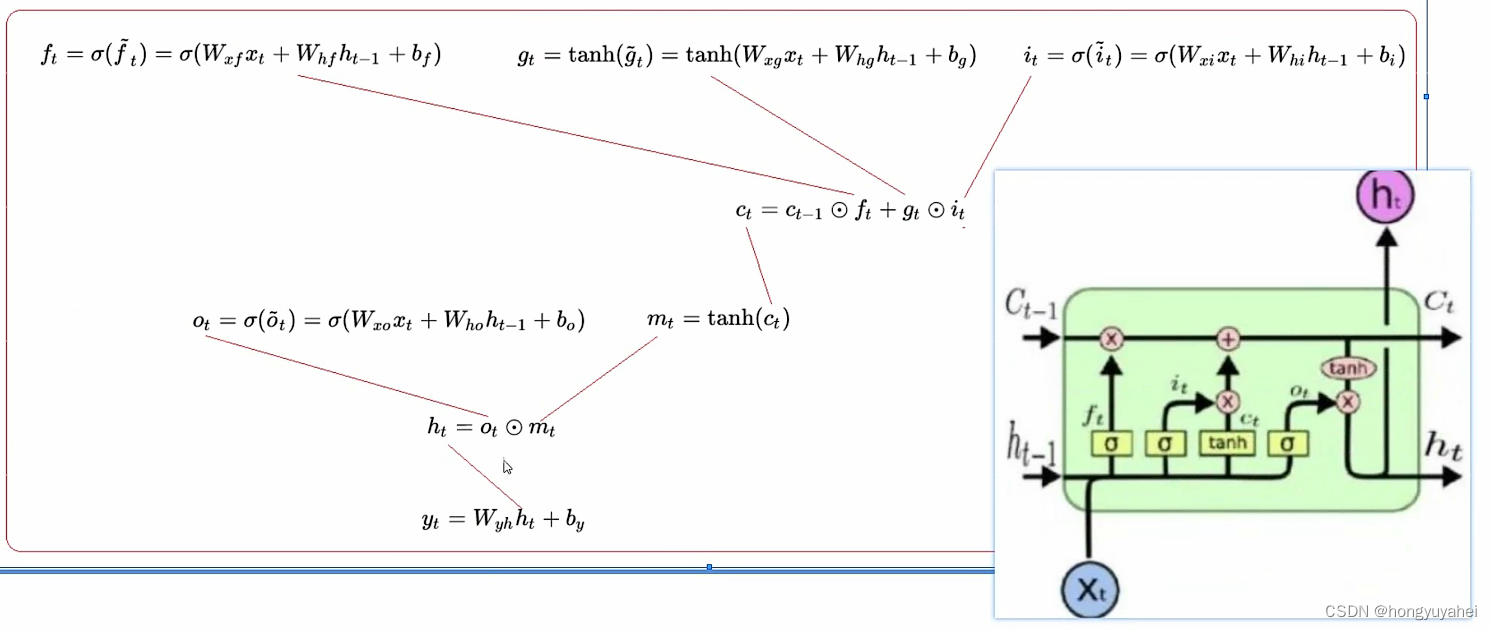

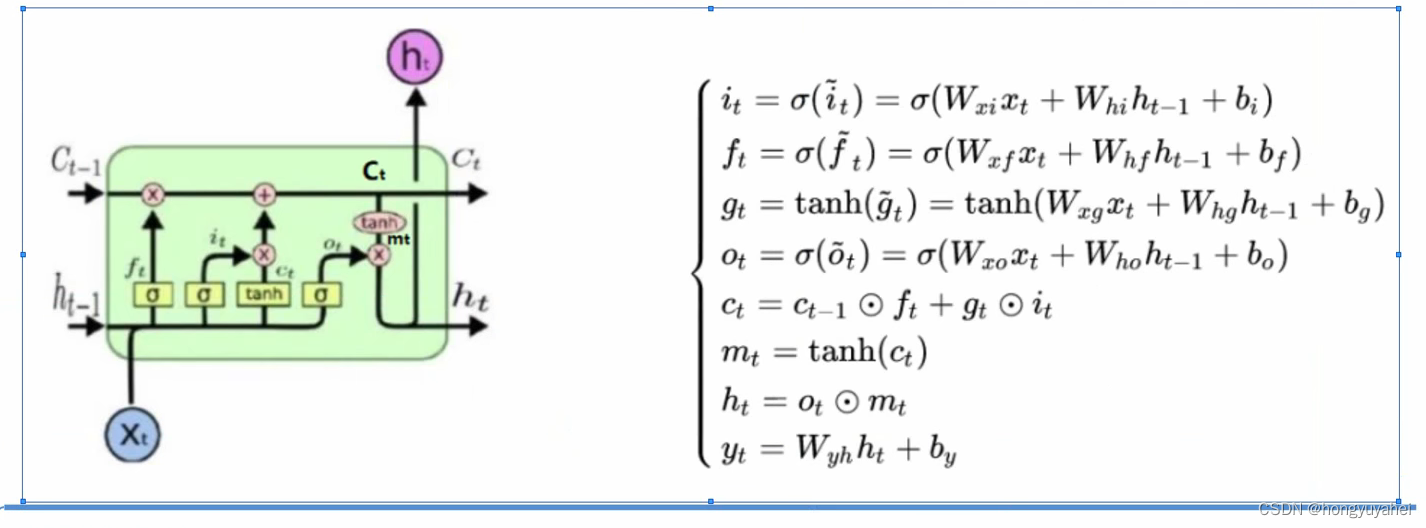

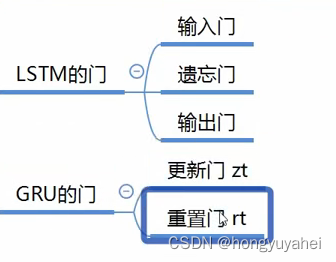

2、LSTM

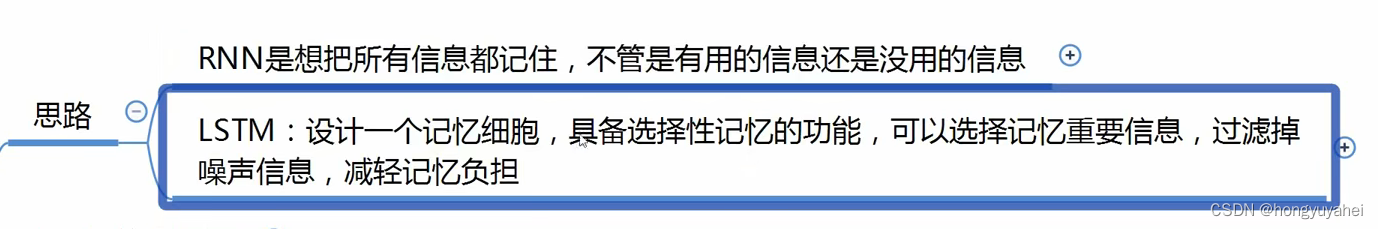

2.1 设计思路

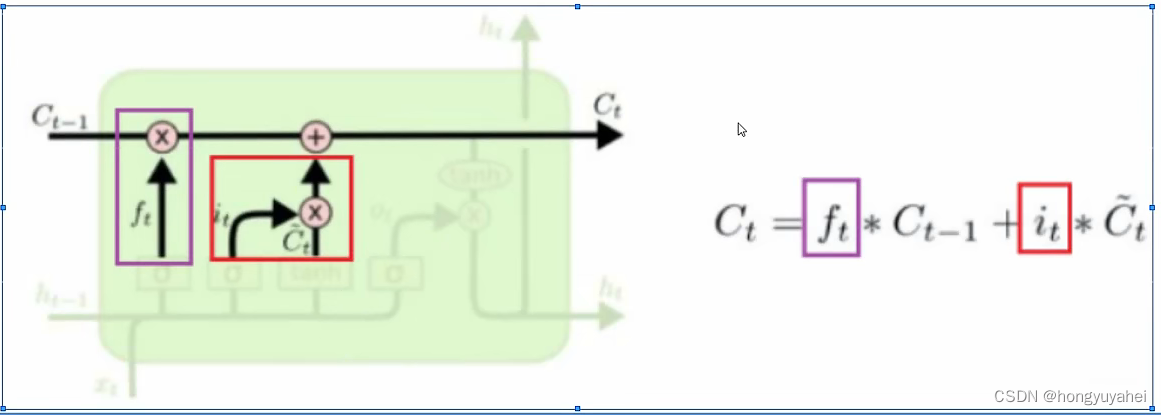

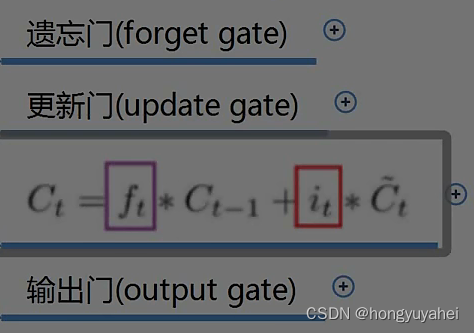

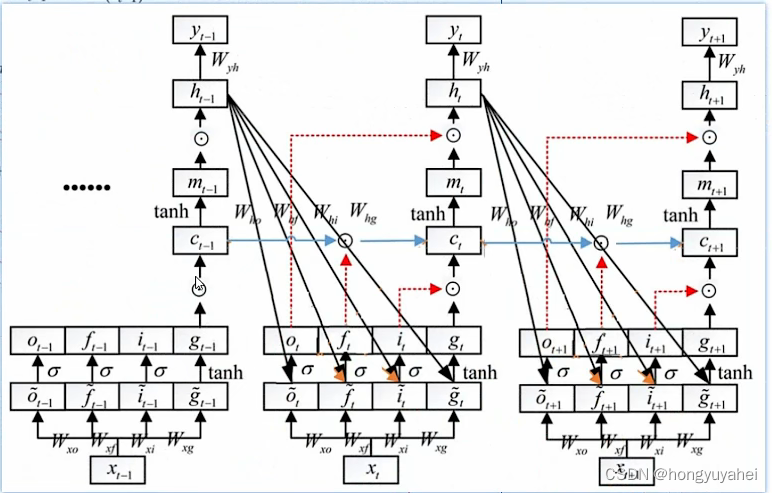

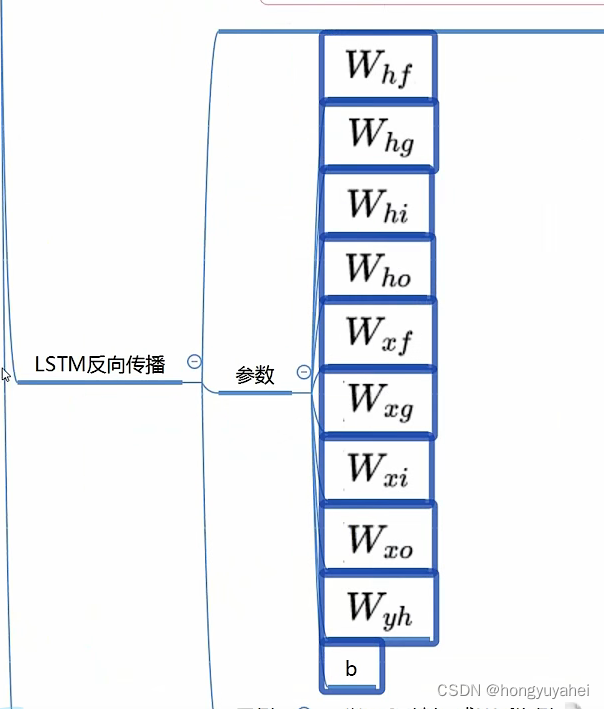

2.2 前向传播过程

2.3 结合例子理解LSTM

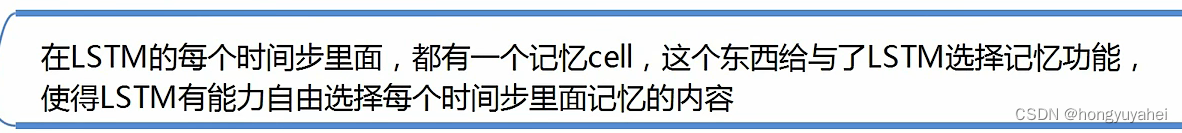

(1)记忆细胞

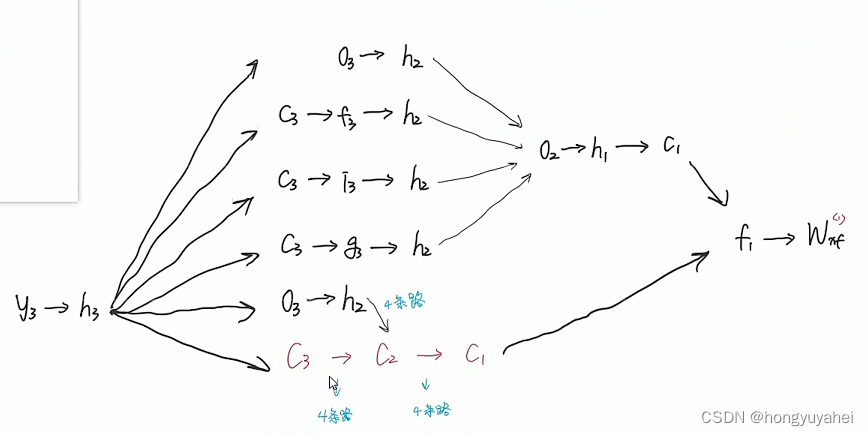

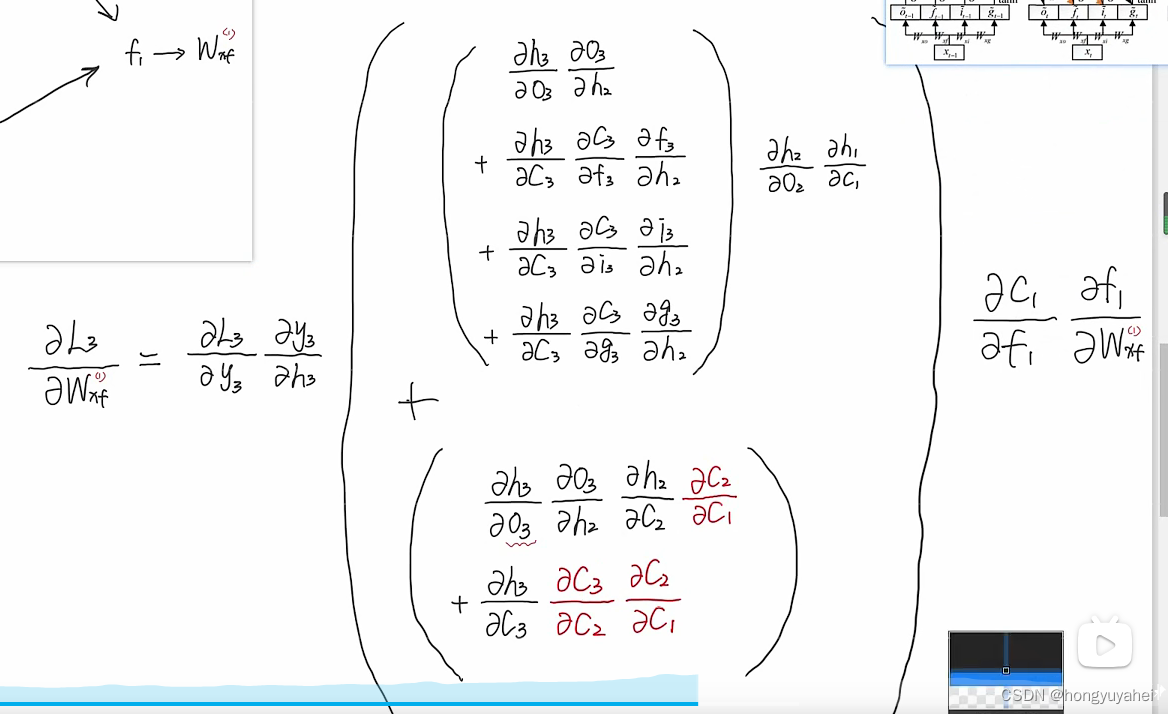

2.4 RNN梯度消失回顾(公式推导)

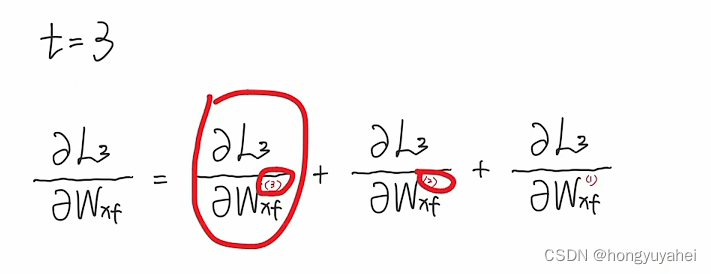

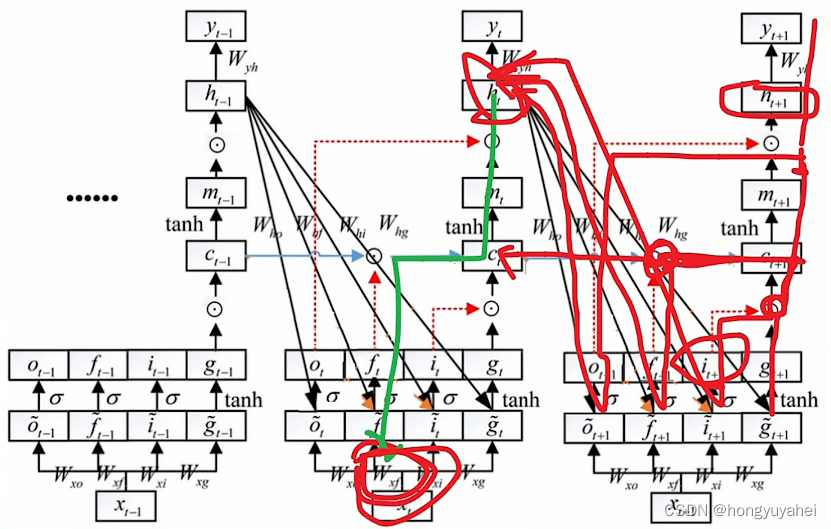

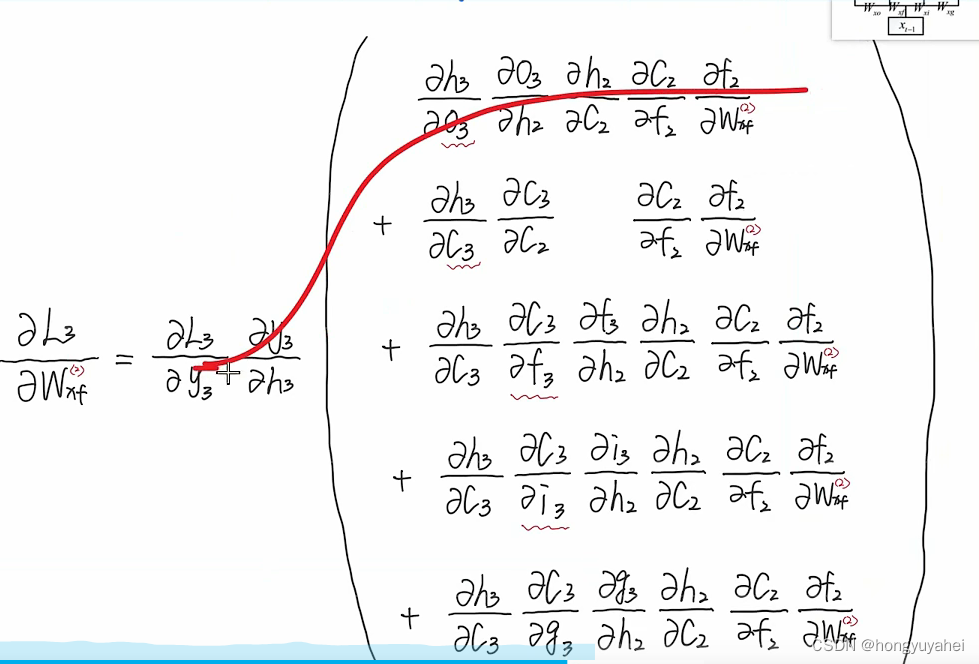

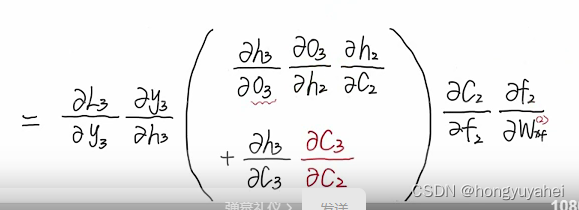

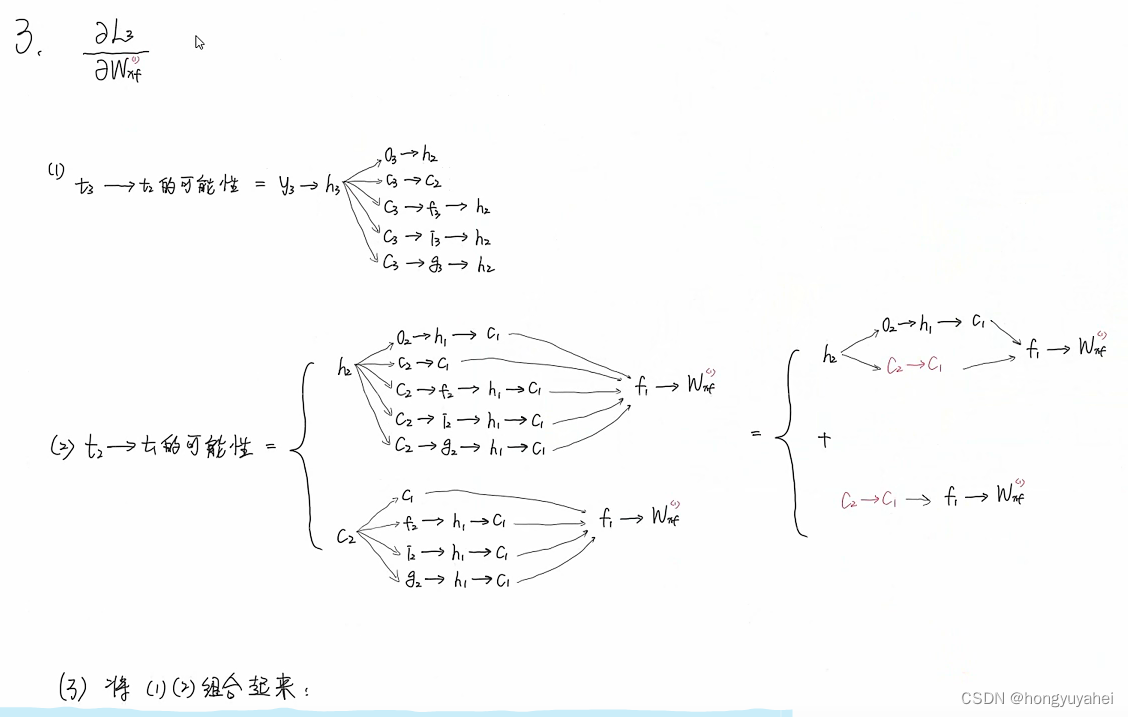

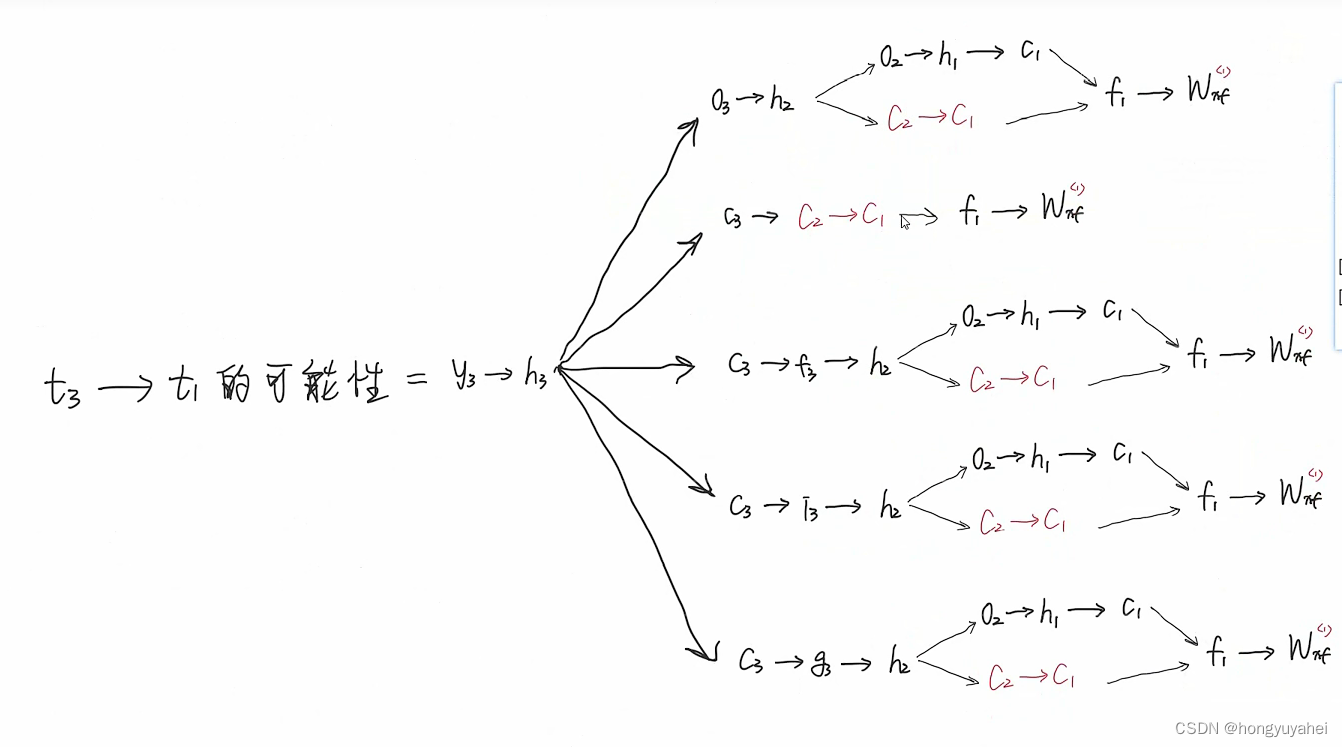

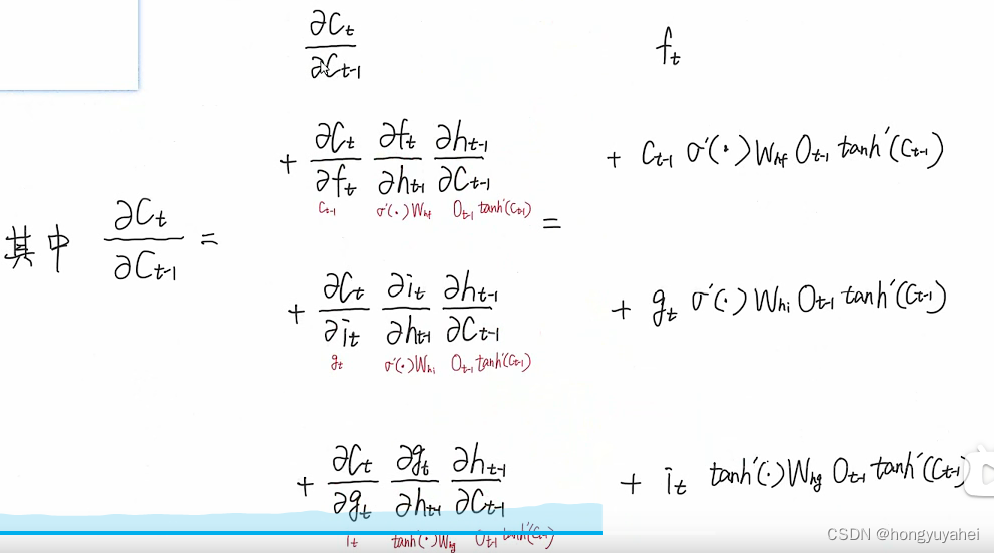

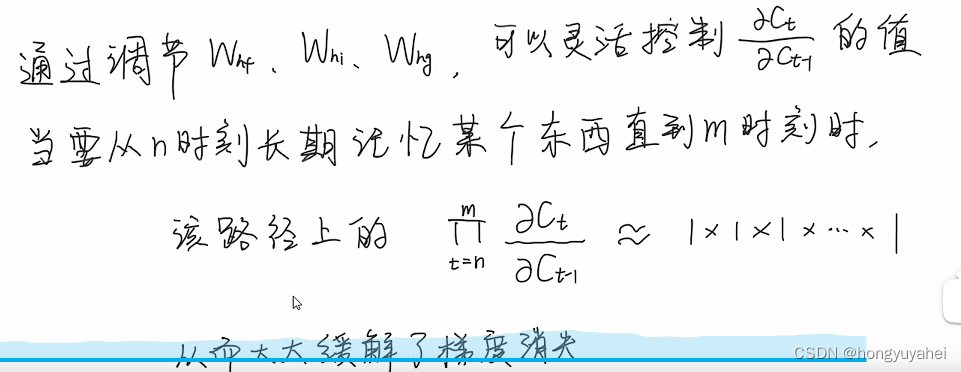

2.5 LSTM如何缓解梯度消失(公式推导)

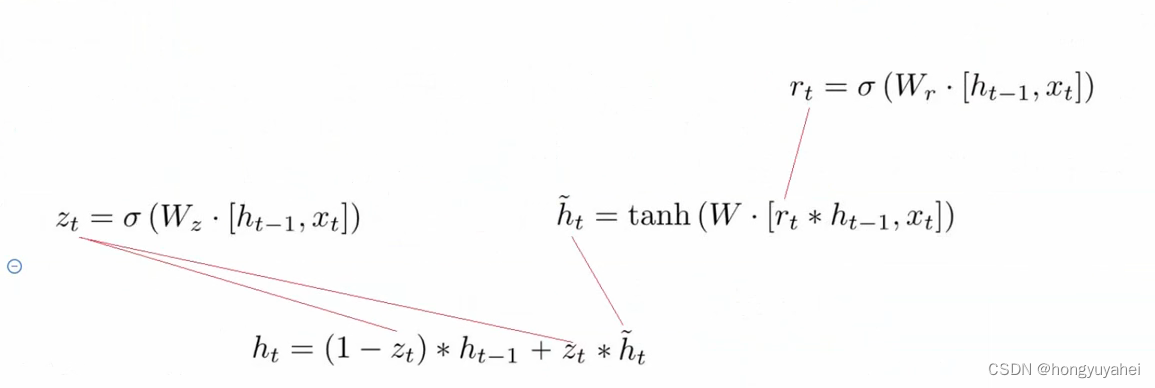

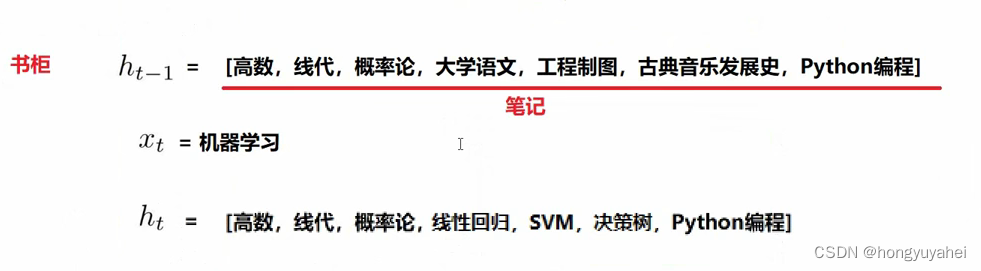

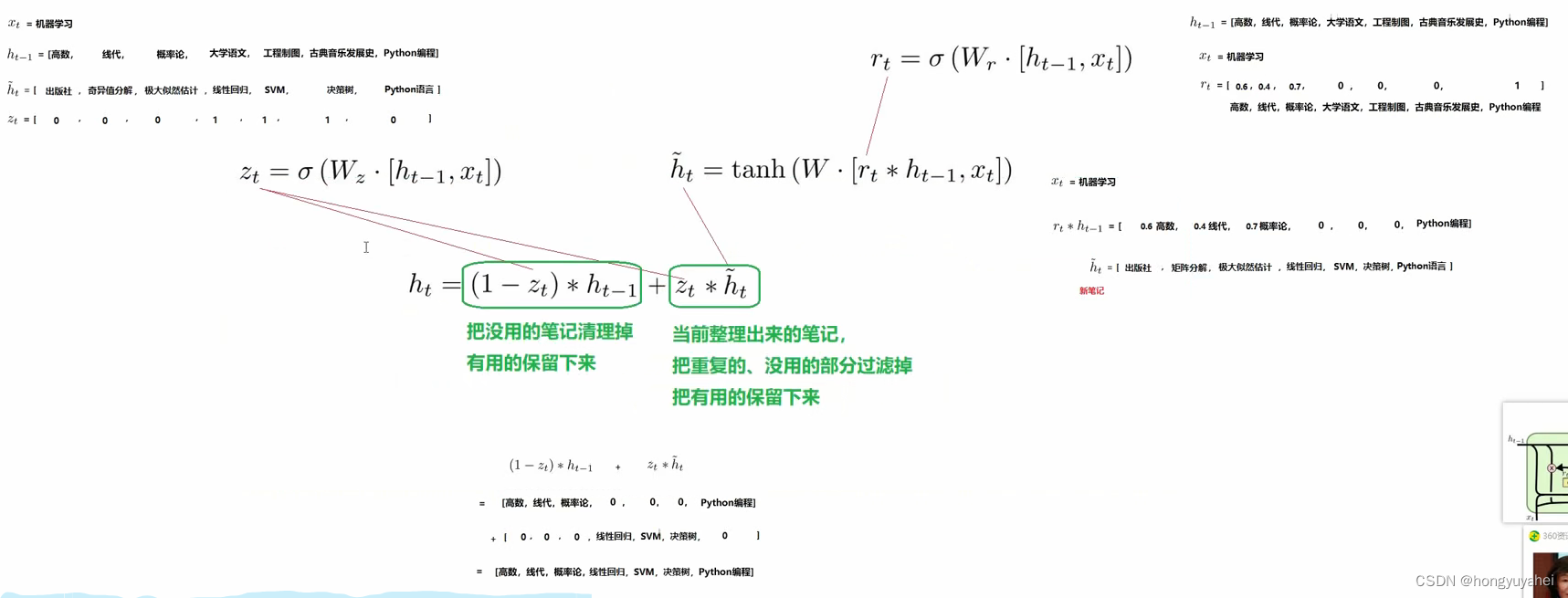

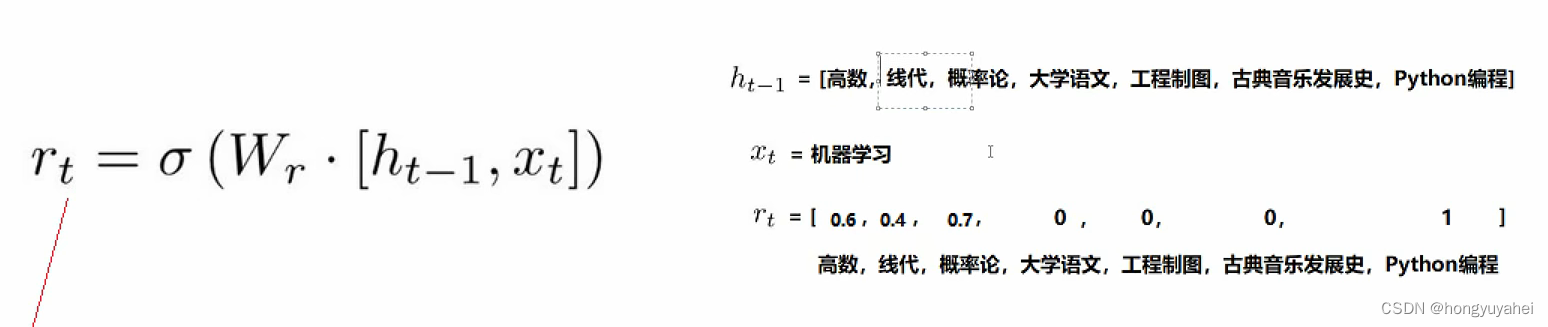

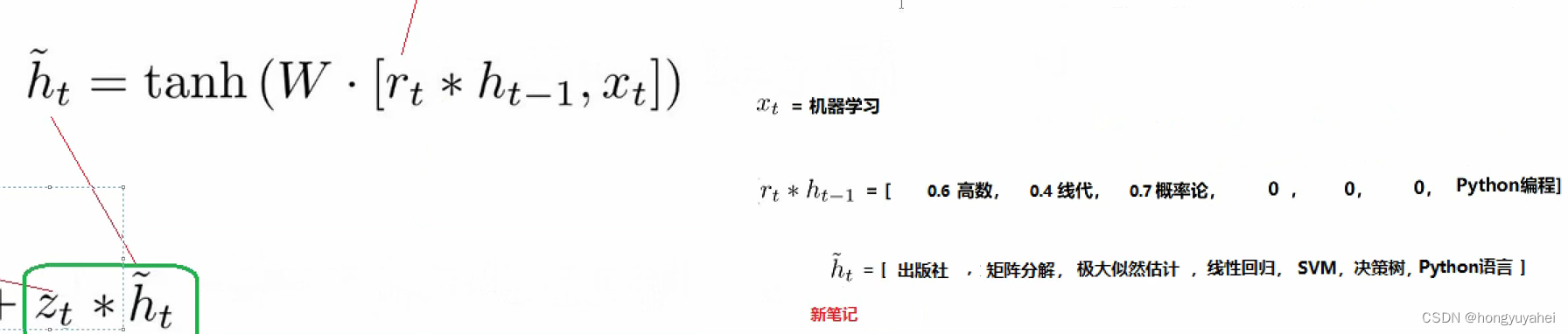

3、GRU

3.1 结构

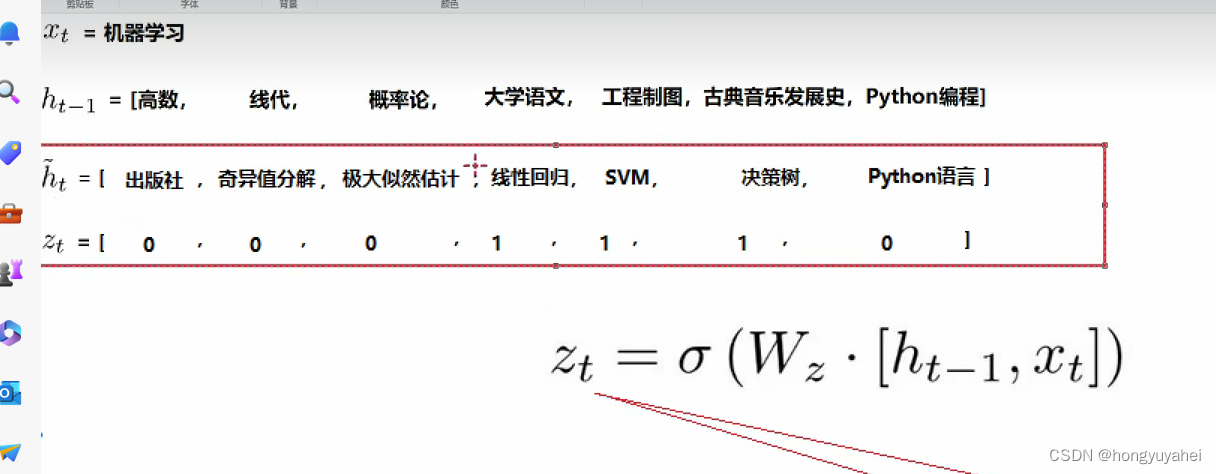

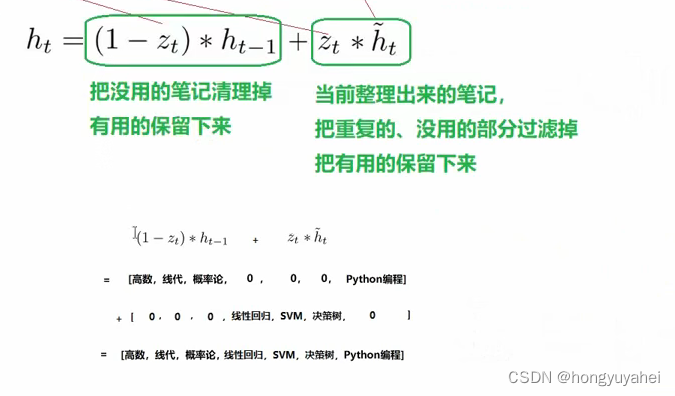

3.2 对比LSTM

3.3 举例理解

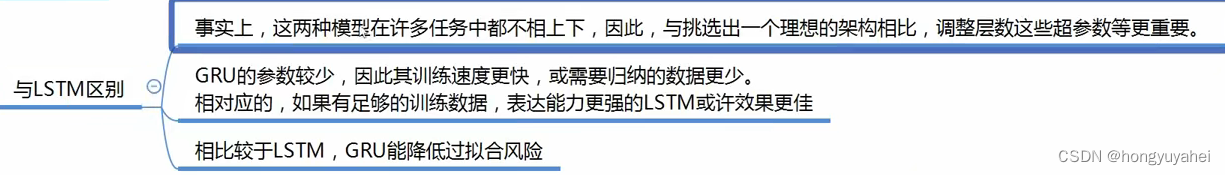

3.4 与LSTM区别

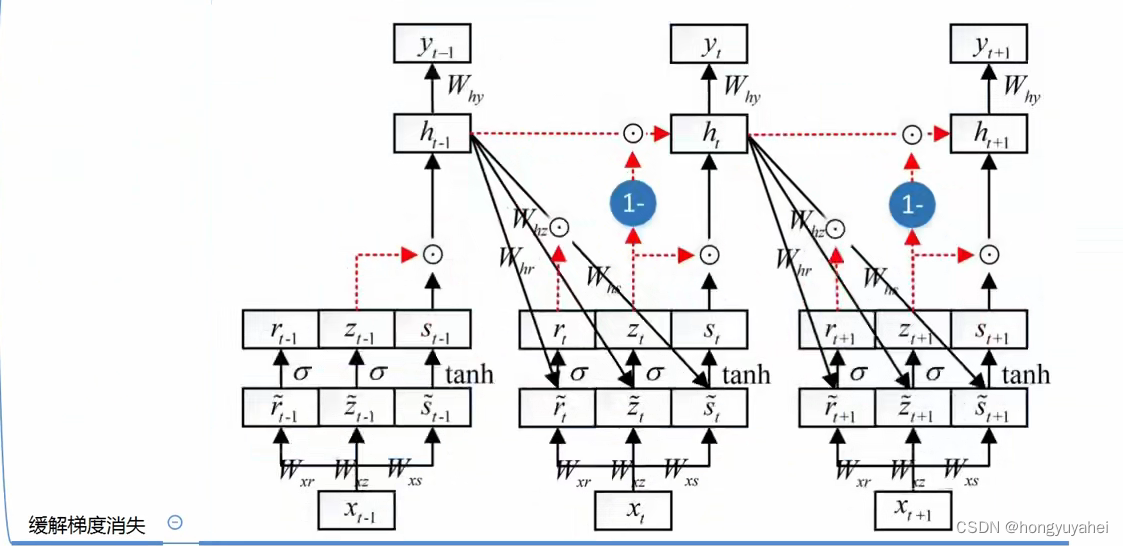

3.5 缓解梯度消失

门的设计可自由选择哪些部分记忆,哪些部分不记忆,连乘消除梯度消失,

文章来源:https://blog.csdn.net/hongyuyahei/article/details/134991488

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!