AI并行计算:CUDA和ROCm

1 介绍

1.1 CUDA

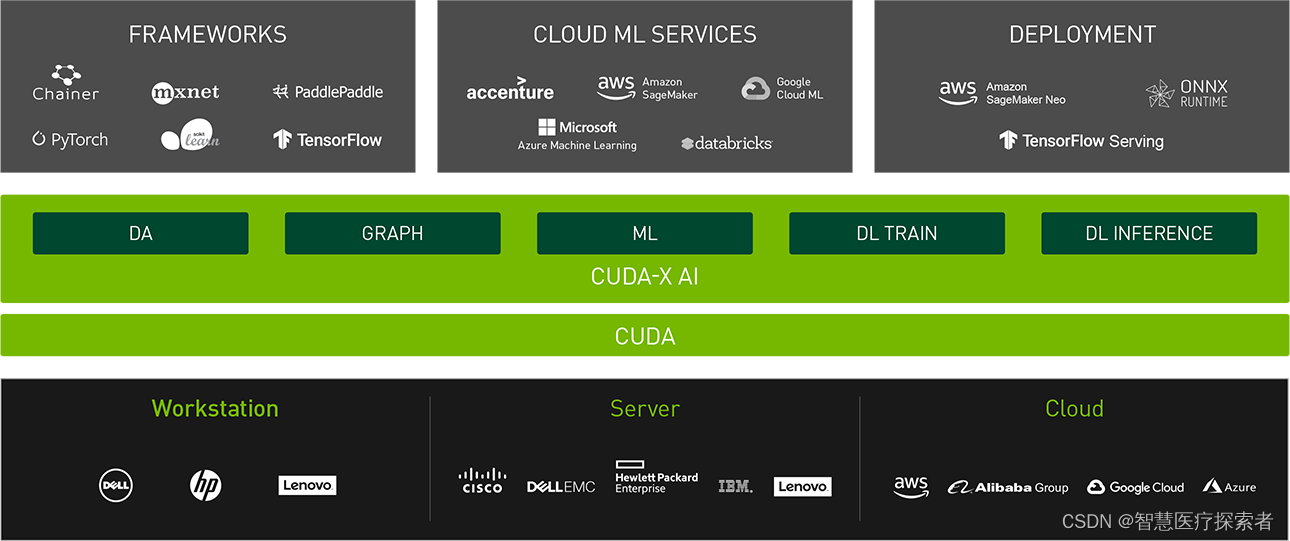

CUDA(Compute Unified Device Architecture)是Nvidia于2006年推出的一套通用并行计算架构,旨在解决在GPU上的并行计算问题。其易用性和便捷性能够方便开发者方便的进行GPU编程,充分利用GPU的并行能力,可以大幅提高程序的性能。目前CUDA已成为GPU加速计算的事实标准。

自从CUDA诞生以来,CUDA生态系统也迅速的发展,包括了大量的软件开发工具、服务和解决方案。CUDA Toolkit包括了库、调试和优化工具、编译器和运行时库。

CUDA特点:

-

专有性:CUDA仅适用于NVIDIA的GPU。

-

成熟度:CUDA拥有广泛的应用案例,被广泛应用于学术研究和工业界。

-

生态系统:CUDA有一个成熟且广泛的生态系统,包括深度学习框架(如TensorFlow和PyTorch)、科学计算库和多种工具。

1.2 ROCm

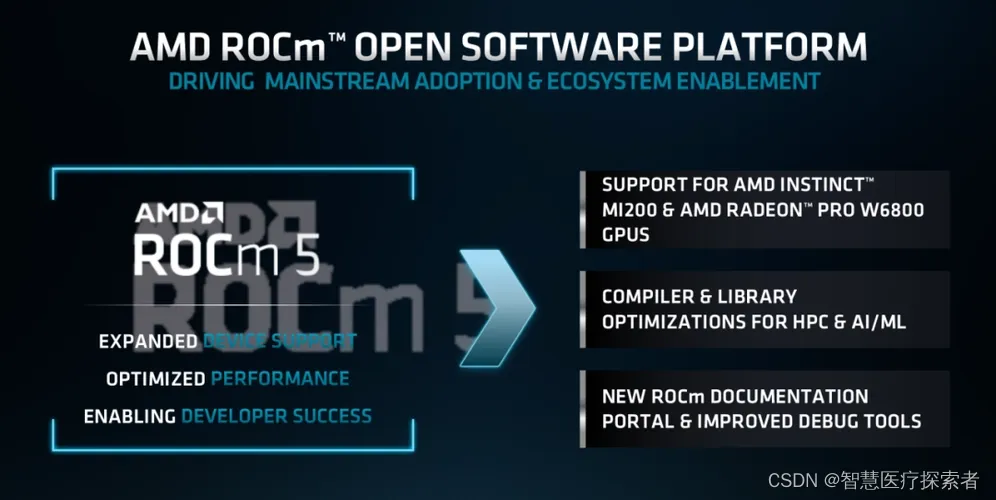

AMD ROCm是Radeon Open Compute (platform)的缩写,是2015年AMD公司为了对标CUDA生态而开发的一套用于HPC和超大规模GPU计算提供的开源软件开发平台,ROCm只支持Linux平台。

同样ROCm包含一些列的开发工具、软件框架、库、编译工具、编程模型等。

ROCm特点:

-

开放性:作为一个开源项目,ROCm旨在提供一个跨供应商的GPU计算解决方案。

-

兼容性:主要支持AMD的GPU,但也在向其他厂商的硬件开放。

-

生态系统:虽然相对较新,但正在迅速发展,支持包括TensorFlow和PyTorch在内的多个深度学习框架。

2 CUDA和ROCm对比

2.1 编程模型和API

| NVIDIA | AMD | 功能描述 |

| CUDA | HIP | 为C/C++开发GPU加速程序提供全面的环境,API、Runtime、编译器、调试工具等。 |

| OpenCL | OpenCL | 面向异构系统通用目的并行编程的开放式、免费标准,也是一个统一的编程环境,便于软件开发人员为高性能计算服务器、桌面计算系统、手持设备编写高效轻便的代码, |

| OpenACC | 并行计算指令,研究人员和技术程序员最常用的GPU并行编程模型。 | |

| OpenMP | OpenMP是一套编译器指令、库例程和环境变量的规范,可用于指定Fortran和C/C++程序中的高级并行性。 |

2.2 编译及工具链

| NVIDIA | AMD | 功能描述 |

| NVCC | ROCmCC / HCC | 编译器 |

| CUDA-GDB | ROCgdb | debug工具 |

| HIPify | 将CUDA原生代码转换为HIP原生c++代码 | |

| Nvidia Nsight | ROCm Profiling Tools | 性能分析工具 |

| nvidia-smi | rocm-msi | 系统管理界面和命令行界面的工具 |

2.3 GPU加速库

CUDA和ROCm的基础框架提供众多的支持库,包括基础数学库、AI支持库、通信库、并行库等一些列,下面将列出来做个对照:

-

数学库

| NVIDIA | AMD | 功能描述 |

| cuBLAS | rocBLAS | 基本线性代数库(basic linear algebra,BLAS) |

| cuFFT | rocFFT | 快速傅里叶变换库(Fast Fourier Transforms) |

| CUDA Math Library | 标准数学函数库 | |

| cuRAND | 随机数生成(random number generation,RNG) | |

| cuSOLVER | rocSOLVER | 密集和稀疏直接求解器 |

| cuSPARSE | rocSPARSE / rocALUTION | 稀疏矩阵BLAS |

| cuTENSOR | rocWMMA | 张量线性代数库 |

| AmgX | 用于模拟和隐式非结构化方法线性解算器 |

-

并行算法库

| NVIDIA | AMD | 功能描述 |

| Thrust | Parallel STL / rocThrust | C++并行算法和数据结构库 |

-

图像和视频库

| NVIDIA | AMD | 功能描述 |

| nvJPEG | 用于JPEG解码的高性能GPU加速库 | |

| Nvidia Performance Primitive | 提供GPU加速的图像、视频和信号处理功能 | |

| Nvidia Video Codec SDK | 硬件加速视频编码和解码的一整套API、示例和文档网址:yii666.com< |

-

通信库

| NVIDIA | AMD | 功能描述 |

| NVSHMEM | OpenSHMEM标准的GPU内存,具有扩展以提高GPU性能。 | |

| NCCL | RCCL | 多GPU、多节点通信 |

-

深度学习/人工智能库

| Nvidia | AMD |

|

|

2.4 开发工具

| Nvidia | AMD |

|

|

3 总结

CUDA和ROCm对比总结如下:

-

硬件支持: CUDA专注于NVIDIA的GPU,而ROCm更注重提供跨平台的支持,尽管目前主要针对AMD的GPU。

-

开放性: ROCm作为一个开源项目,更加开放和灵活,而CUDA是NVIDIA的专有技术。

-

生态系统和成熟度: CUDA拥有更成熟的生态系统和更广泛的应用案例。相比之下,ROCm还在发展中,但正在迅速成长。

-

性能: 性能方面,CUDA和ROCm都能提供优秀的计算能力,但具体表现会根据应用场景和硬件配置而有所不同。

CUDA和ROCm都是用于高性能计算的平台,特别是在GPU加速的情况下。它们提供了工具和库,使得开发者能够有效地利用GPU来加速计算密集型任务,选择CUDA还是ROCm主要取决于业务的特定需求、所使用的硬件以及对开放性的偏好。CUDA在高性能计算领域更加成熟和普遍,但如果你使用AMD的硬件或者更倾向于使用开源技术,ROCm是一个不断增长的选择。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!