跨模态检索论文阅读:Plug-and-Play Regulators for Image-Text Matching用于图像文本匹配的即插即用调节器

Plug-and-Play Regulators for Image-Text Matching用于图像文本匹配的即插即用调节器

利用细粒度的对应关系和视觉语义比对在图像-文本匹配中显示出巨大的潜力。通常,最近的方法首先使用跨模态注意力单元来捕捉潜在的区域-单词交互,然后整合所有比对以获得最终的相似性。然而,它们大多采用具有复杂结构或额外信息的一次性前向关联或聚合策略,而忽略了网络反馈的调节能力。在本文中,我们开发了两个简单但非常有效的调节器,它们有效地对消息输出进行编码,以自动上下文化和聚合跨模态表示。具体地说,我们提出了(i)一种递归对应调节器(RCR,Recurrent Correspondence Regulator),它通过自适应注意因子逐步促进跨模式注意单元,以获得更灵活的对应关系,和(ii)循环聚合调节器(RAR,Recurrent Aggregation Regulator),其反复调整聚合权重以越来越强调重要的比对而淡化不重要的比对。此外,有趣的是,RCRand RAR是“即插即用”的:它们都可以基于跨模态交互被整合到许多框架中,以获得显著的利益,并且它们的合作取得了进一步的改进。在MSCOCO和Flickr30K数据集上进行的大量实验验证了它们可以在多个模型上带来令人印象深刻的综合R@1增益,证实了所提出方法的通用性和泛化能力。

简介

在本文中,引入了[32]-[35]定义的调节器机制,其中可以通过自适应地优化具有合理的后向反馈的前向学习过程来改进网络,并验证了精心设计的监管操作可以在不需要额外数据和复杂结构的情况下,在获得准确的相互作用和进行跨模式的最佳聚合方面发挥巨大作用。

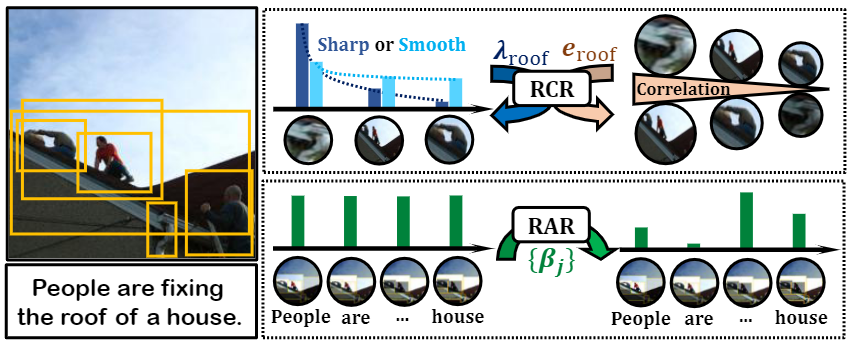

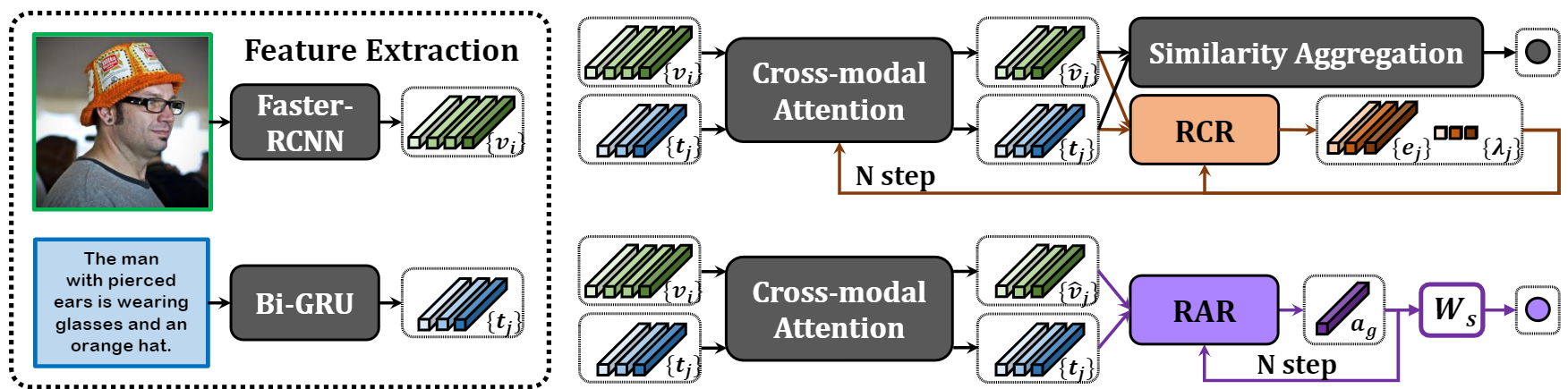

更具体地说,我们提出了一种递归相关性调节器(RCR)和递归聚合调节器(RAR)来逐步促进图像-文本匹配过程,如图1所示。RCR学习每个特定单词/区域的自适应注意因子,以迭代地细化跨模式注意单元,为不同图像-文本对中语义不同的单词/区域获得更合理的注意分布。RAR从对所有比对进行平均开始,然后在前一步中更新由聚合比对引导的聚合权重,这会越来越强调重要比对,并逐渐减少不重要比对的干扰,以预测更精确的相似性得分。所提出的RCR和RAR的一个重要而有吸引力的特性是“即插即用”:它们都可以无缝地插入到许多现有的基于跨模态交互的方法中,以实现显著的改进,并且它们的合作带来了更大的好处。此外,我们通过实验验证,即使使用最简单的框架,RCR和RAR的插件也使模型[18]能够在MSCOCO和Flickr30K上获得最先进的结果。

总之,我们的主要贡献有三个方面:

- 我们提出了一种递归通信调节器(RCR),以动态更新交叉注意力单元,从而更好地利用通信。它学习每个单词/区域的自适应注意力因素,以根据其语义和相关的图像-文本对生成更合理的注意力分布。

- 我们提出了一种递归聚合调节器(RAR)来重复校准权重,以实现更具辨别力的本地相似性聚合。它逐步重新加权由早期指南比对引导的单词/区域参与比对,以突出显示更重要的比对。

- RCR和RAR可以单独或联合应用于各种图像-文本匹配方法,以实现显著的改进,表明了所提出方法的有效性和泛化能力。

图 1. 提出的调节器的示意图。RCR 通过调整温度 λ 和信道系数 e,在单词 "roof "及其相应区域之间逐步形成合理的注意力分布,而 RAR 则不断突出每个单词所关注的重要排列,并逐步提高自身性能,以实现更全面的聚合。

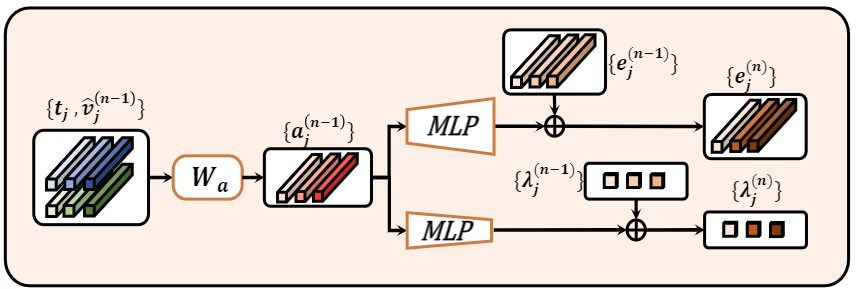

图 2. RCR 通过学习新的通道权重向量和 softmax 温度来完善跨模态交互的示意图

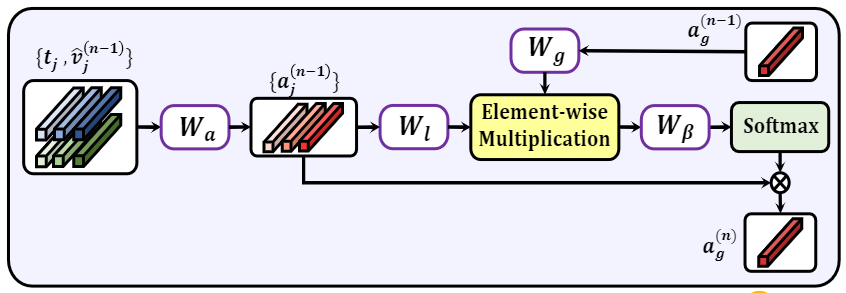

图 3. 在上一步整体配准向量的指导下更新聚合权重的 RAR 图示

相关工作

跨膜态注意力

跨模态检索吸引了众多研究人员对增强跨模态嵌入或改进注意力单元进行进一步的探索。具体而言,前一种方法试图通过丰富区域位置[22]、语义顺序[23]、场景图[36]、[37]和相互关联[20]的实例特征来促进单词-区域的对应,而后一种方法直接开发跨模态的更细粒度的交互,如关系CNN[21],焦点注意力[19]和交叉图注意力[27],[37]。特别是,一些工作[27]、[36]、[37]引入了具有明确属性和关系信息的场景图,然后在图节点之间构建了图间注意力。此外,Quet等人[38]开发了一种实现动态模态交互的漫游机制,而Zhang等人[39]利用匹配和不匹配的效果来建立全面的图像-文本关系。与之前的工作相比,RCR直接调整注意力因子,包括通道权重向量和softmax temperature,使注意力权重能够适应不同图像-文本对中具有不同单词/区域集的不同语义区域/单词。具体地说,对于正面的图像-文本对,每个单词/区域与其对应的区域/单词之间的注意力权重更精确,并通过RCR进行区分,导致图像和文本之间的距离更近。更重要的是,对于具有完全无关实例的负对,现有注意力符号所采用的配对特征之间的内积权重仍然强调跨模态的最接近内容,并在时间空间中捕捉到所谓的“区域-词相关性”,不可避免地增加了图像-文本的相似性,缩小了与正对的差距。相反,RCR通过学习到的注意力因素主动调整单词区域相关性,以针对不同的区域/单词产生适当的注意力分布,同时将注意力权重与最终的相似性测量脱钩,并在匹配和不匹配对之间产生更大的差距。

相似性聚合

现有的基于单模态表示的方法[14]、[15]、[17]、[40]-[42]将图像和文本特征映射到联合空间,并采用余弦距离作为测量,而许多方法[18]、[19]、[21]、[22],[26]基于跨模态交互,首先获得跨模态的成对特征,然后使用平均运算来融合所有单词区域对齐之间的余弦相似性。考虑到不同的实例和层次相关性在表征跨模态关系中具有不同的重要性,Chen等人[23]设计了一个自注意模块来整合区域或单词所涉及的所有余弦距离,而Jiet等人[43]探索了片段和上下文相似性得分,以在图像和文本之间产生足够的视觉语义对齐。除了更强大的距离表示外,一些方法[27]、[28]、[44]引入了基于向量的相似函数,并使用图形推理来执行匹配模式,这些方法以高复杂度为代价取得了很大的改进。请注意,Liu等人[27]不仅需要解析额外的视觉/文本图,而且无法通过使用平均池操作聚合它们来测量不同的对齐。此外,Diao等人[28]需要高质量的整体比对,以更好地指导片段比对的整合过程。相比之下,我们的RAR采用了一个循环聚合过程,没有任何额外的补充和前提,并验证了编码早期匹配信息的迭代指导比对可以获得更合适的权重,并有效地促进了各种比对的聚合过程。

即插即用方法

能够有效集成到主框架中的模块被称为“即插即用”方法。近年来,即插即用方式在各个领域引起了越来越多的关注,包括图像恢复[45]-[48]、视觉字幕[49]、[50]、视觉问答[51]、[52]和视频文本匹配[53]、[54]。通过将特定问题与总体优化目标脱钩,它们大大简化了每个模块的集成过程,并提高了新框架的灵活性和可推广性,从而加速了其他更复杂应用程序的开发。值得注意的是,与我们最相关的方法是GPO[17],它试图改进单模态特征编码器,并学习最佳池策略,将单模态实例特征集成到整体嵌入中,而我们的调节器旨在推广各种跨模态交互方法,并促进模式注意力和相似性聚合。

方法

在本节中,我们将详细介绍基于SCAN[18]的跨模态注意力单位提出的递归对应调节器(RCR)和递归聚合调节器(RAR)。这两个调节器可以有效地探索网络本身的调节能力,进而通过利用精心设计的对齐反馈显著促进学习过程。为了简单起见,我们采用T2I注意力来描述所提出的调节策略,这些策略可以以同样的方式应用于I2T注意力。

对于词与区域的交互作用,1)现有的大多数方法都是用固定和统一的因子计算一次性的前向程序,这显然缺乏适应各种语义的词语的调节能力。相比之下,RCR 首先生成构建的对齐方式,记录上一步中每个词与所有相关区域之间的丰富相关性,进而重新权衡每个词的权重向量和温度值,完善相应的注意力分布。2) 早期的研究总是倾向于将单词与可比空间中潜在的 "最近 "区域对齐,即使是负面的图像-文本对。我们认为,正面图像中的词语应更多地关注特定的相关区域,而负面图像中的词语则应关注 "完全不相关 "的区域。从上述角度来看,递归聚合器可以动态更新信道测量值,完善词-区域相关性的数值,从而扩大匹配和未匹配词对之间的差距,提高复杂匹配模式的建模能力。

RAR 并非如公式 (5) 所述对所有单词特征和出席图像特征之间的所有余弦相似度进行平均,而是更进一步,通过迭代聚合所构建的配准来识别跨模态的更全面的内容。具体来说,RAR 从平均聚合开始,在每个调节步骤中,它都会尝试从上一步的上下文信息输出中学习,并平衡每个基于单词的排列的重要性,而无需手动调整。可以观察到,RAR 越来越重视来自重要词语的排列,并逐渐降低不重要词语的聚合权重。通过这种方法,网络可以不断调整所有排列的比例,并分配更合理的聚合权重,从而使整体排列更具区分度,图像-文本匹配的距离度量也更合适。

RCR 和 RAR 的特性

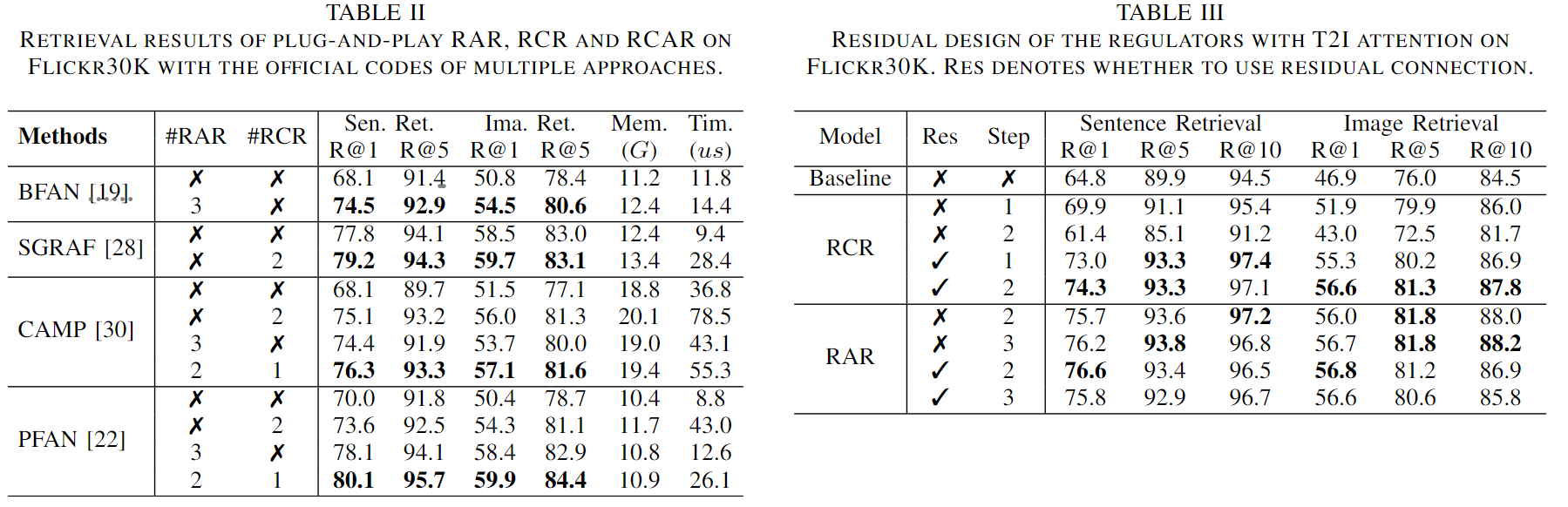

多种模型上的即插即用。RCR 和 RAR 最吸引人的特性是 “即插即用”。为了证明它们的巨大适用性,我们将这两个调节器应用到了许多基于跨模态交互的现有方法中:

堆叠交叉注意(SCAN)[18] 首先计算所有区域-单词的相似性,并将每个区域/单词与其对应的单词/区域对齐。通过平均所有基于区域/单词的余弦距离得出最终的相似度。

双向聚焦注意力(BFAN)[19] 通过为每个区域-词对重新分配更精细的注意力权重来扩展通用注意力,并通过基于区域和基于词的分数相加来计算匹配结果。

位置聚焦注意力(PFAN)[22] 通过引入额外的位置信息来增强区域特征,以促进区域-单词的对应,并将所有区域/单词注意力的余弦相似度整合为预测值。

跨模态自适应信息传递(CAMP)[30] 通过内积探索区域-单词亲和矩阵,并转移跨模态内容以改进区域和单词表征,然后将其汇总为整体图像和文本特征,计算最终的相似度。

相似性图推理和注意力过滤(SGRAF)[28] 采用余弦相似性乘以固定温度作为区域-单词注意力权重,然后通过复杂图和注意力模块将层次相似性特征映射为匹配得分。

图 4. 我们的调节器即插即用的操作说明。在独立应用中,RCR 可促进区域与词的对应,并保留原始的相似性计算,而 RAR 可促进更准确的相似性预测,并保留原始的跨模态交互。

图 4 展示了我们如何将 RCR 或 RAR 插入上述匹配方法。具体来说,跨模态注意力利用余弦度量或内积作为区域-单词亲和力权重,并输出每个区域/单词及其相关单词/区域。利用这些配对特征,RCR 首先构建配对向量,然后通过式(7)(8)学习相应的权重向量和温度系数,进而通过式(9)-(11)完善区域-词特征距离并优化跨模态交互。除了一组配准向量外,RAR 还能通过式(14)-(16)在一个引导向量和所有配准向量之间逐步生成更合适的权重,并促进更合理的相似性聚合处理。事实证明,这种简单的信息反馈为许多跨模态交互作品带来了显著的改进,甚至比相关的复杂作品性能更优越。

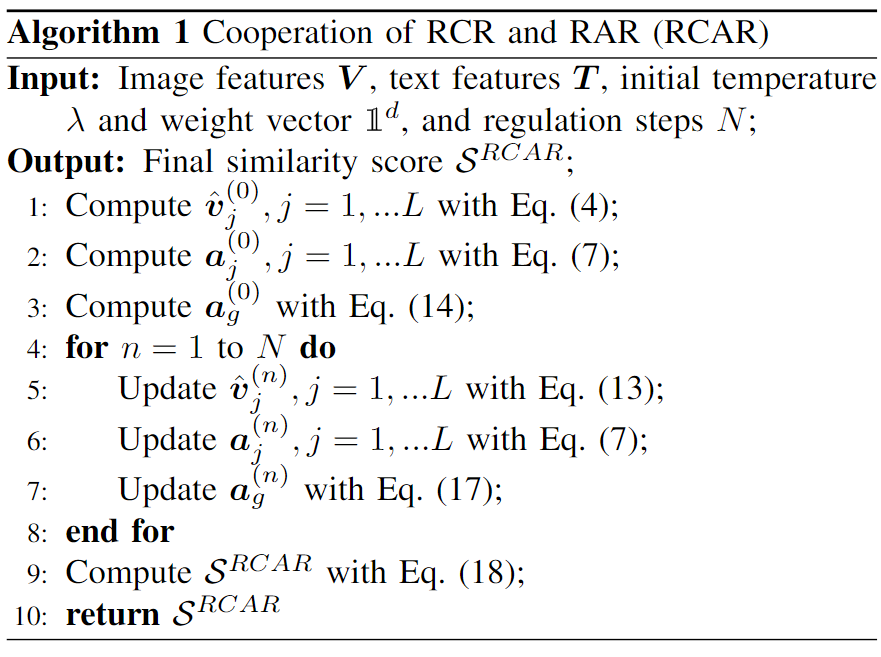

RCR 和 RAR 的协作

RCR 和 RAR 可以相互配合,其中 RCR 负责调整跨模态交互,而 RAR 则完善配准聚合以实现进一步改进。在算法 1 中,我们介绍了一种简便的组合,即 RCAR,它可以逐一执行这两种规则。需要注意的是,它们之间的合作非常灵活,更多变体及实验结果可参见实验部分。

实验

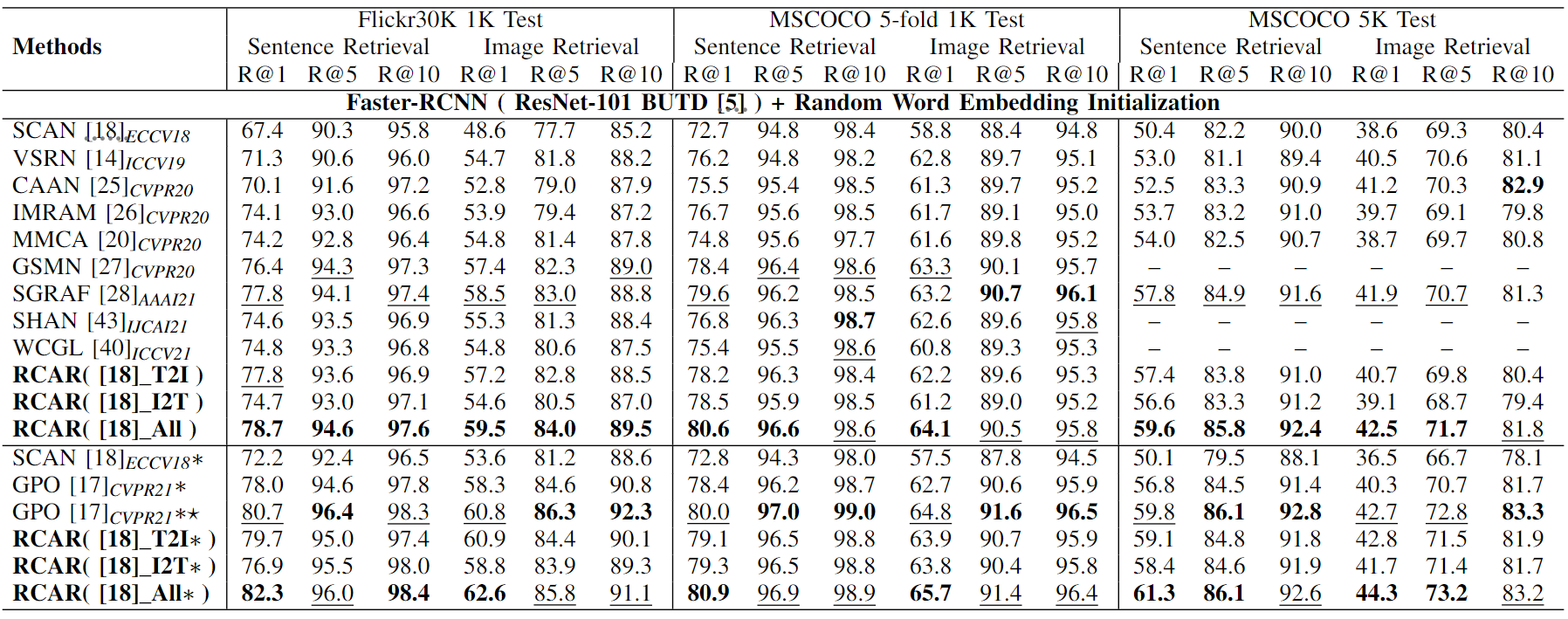

表1.按时间顺序排列的检索结果。最好的两个结果用粗体和下划线标出。? 采用热身策略和文字大小增强,而 ? 表示输入图像分辨率较高的集合模型

表1.按时间顺序排列的检索结果。最好的两个结果用粗体和下划线标出。? 采用热身策略和文字大小增强,而 ? 表示输入图像分辨率较高的集合模型

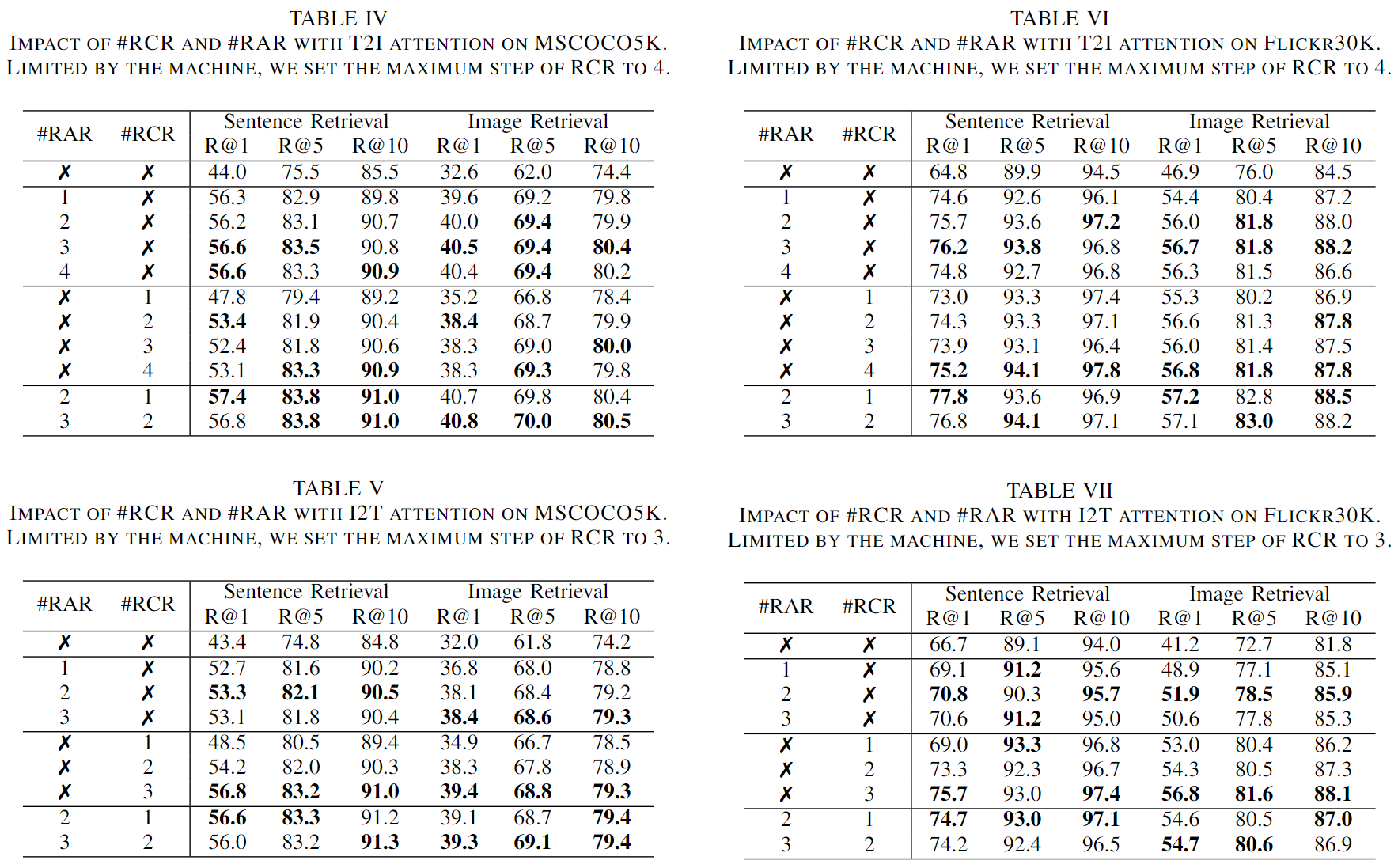

我们将早期和学习到的排列作为当前的指导向量,以建立残差版本的 RAR。RAR 的目的是构建更好的引导,并在整个过程中为基于词的原始配准分配适当的聚合权重。因此,我们可以发现,具有残差结构的 RAR 在每一步都使用相同的词对齐的情况下,并不能带来显著的改进。#RAR 和 #RCR 的超参数调整。表四、表五、表六和表七展示了不同步骤对调节器的评估结果。我们在不使用任何调节器的情况下设定了基线,即只利用跨模态注意力[18],并通过公式(5)预测所有余弦距离的平均值来得出最终得分。

-

聚合调节器。RAR 保留原始的跨模态注意力单元,并根据公式(18)和公式(7)构建的排列计算相似度。对于 MSCOCO 5K 测试集,基于 T2I 注意力,RAR 最多能将句子和图像检索的 R@1 提高 12.6% 和 7.9%,基于 I2T 注意力,RAR 最多能将句子和图像检索的 R@1 提高 9.9% 和 6.4%。对于 Flickr30K 1k 测试集,它还能提高双向 R@1,在 T2I 和 I2T 注意力下分别持续提高 9.8/7.5% 和 2.4/7.7% 以上。由此可见,RAR 可以生成更准确、更可信的图像-文本相似度测量结果。

-

对应调节器。RCR 会更新区域-词之间的交互作用,迭代更新针对跨模态实例的聚合特征,并通过式(5)保持原始预测过程。与基础模型相比,RCR 在 MSCOCO5K 上可以获得 R@1 的稳定增长,最大增幅为 9.4/5.8%(T2I)和 13.4/7.4%(I2T),同时在 Flickr30K 上的增幅为 10.4/9.9%(T2I)和 9.0/15.6%(I2T),验证了 RCR 能够利用更精细、更恰当的词-区域关联。

-

协作调节器。如算法 1 所述,我们采用了 RAR 和 RCR 的一比一组合,这表明前者总是比后者多走一步。与两步 RAR 和一步 RCR 相比,N =2 RCAR 可以在两个方向上大幅提高 R@1,这表明 RCR 和 RAR 具有良好的兼容性。事实上,它们之间的合作非常灵活。以表 VI 中对 Flickr30K 的 T2I 关注为例,另一种策略是先执行 2 步 RCR,然后再执行 3 步 RAR,这样在句子和图像检索上分别获得了 77.5%和 57.8%的 R@1(算法 1 的 R@1 为 77.8%和 57.2%)。此外,我们还可以观察到,#RCR 和 #RAR 越大并不一定越好,这可能是由于递归结构的原因,一定步数的递归会使网络性能达到饱和。

-

计算成本。单 SCAN [18] 的模型大小为 12.2M,而 RAR、RCR 或 RCAR 的每一步都会带来近 0.13M 、0.95M 或 1.12M 的额外参数。使用 NVIDIA GeForce RTX 3090,T2I-SCAN 的推理时间为每对图像-文本 3.05 us,RAR/RCR/RCAR 每一步带来的额外成本为 0.51/4.72/5.91 us,而 I2T-SCAN 的预测时间为 4.25 us,额外成本为 1.19/8.21/10.54 us。从这些实验中,我们建议独立应用时采用 step=2-3,合作时采用 step=2(RAR)+1(RCR),因为它们在准确性和复杂性之间实现了更好的权衡,并在表 II 中证明了多种最先进方法的普遍有效性和广泛适用性。

结论和未来工作

在本文中,我们提出了两种调节器,称为递归对应调节器(RCR)和循环聚合调节器(RAR)显著促进图像文本匹配过程。具体而言,RCR试图通过学习更有针对性的注意力因素来动态地促进跨模态注意力单元,而RAR旨在从整体信息反馈中逐步整合合理的聚类权重。即插即用特性使他们能够无缝集成到许多基于跨模式交互的现有方法中,以实现显著的改进,并可以通过协作方式获得更多好处。在MSCOCO和Flickr30K上进行的大量实验证明了我们提出的方法的巨大优势和广泛适用性。除了上述观察结果之外,我们还试图将我们的调节器应用于另一个分支[9]、[13]、[14]、[17],这些分支专注于单模态表示,而没有跨模态交互。有趣的是,两步RCR和三步RAR可以改善R@1通过逐步更新区域中的最后一个自注意层并将所有实例特征分别聚合为一个整体特征,SAEM[13]在两个方向上分别增加了2.8/4.1%和3.7/2.5%,反映了我们的调节器的巨大潜力。更高效的框架和应用场景是我们未来的研究方向之一。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!