nn.functional 和 nn.Module

2023-12-17 19:18:54

前面我们介绍了Pytorch的张量的结构操作和数学运算中的一些常用API。

利用这些张量的API我们可以构建出神经网络相关的组件(如激活函数,模型层,损失函数)。

Pytorch和神经网络相关的功能组件大多都封装在 torch.nn模块下。

这些功能组件的绝大部分既有函数形式实现,也有类形式实现。

其中nn.functional(一般引入后改名为F)有各种功能组件的函数实现。例如:

(激活函数)

* F.relu

* F.sigmoid

* F.tanh

* F.softmax

(模型层)

* F.linear

* F.conv2d

* F.max_pool2d

* F.dropout2d

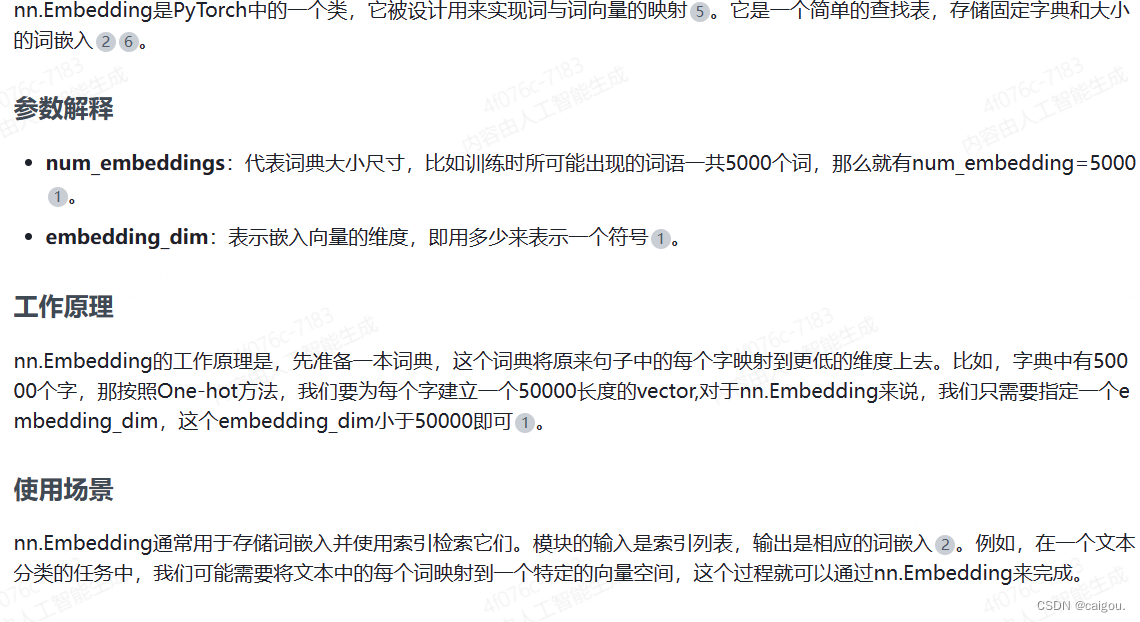

* F.embedding

(损失函数)

* F.binary_cross_entropy

* F.mse_loss

* F.cross_entropy

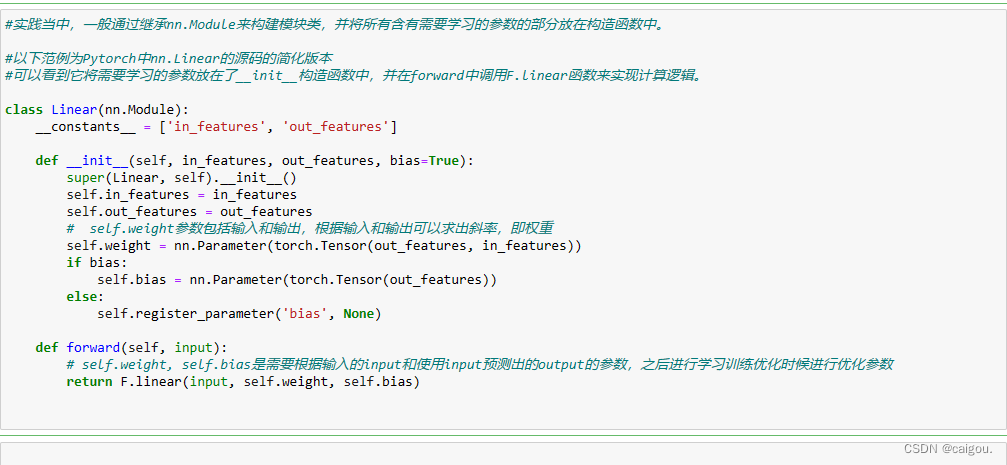

为了便于对参数进行管理,一般通过继承 nn.Module 转换成为类的实现形式,并直接封装在 nn 模块下。例如:

(激活函数)

* nn.ReLU

* nn.Sigmoid

* nn.Tanh

* nn.Softmax

(模型层)

* nn.Linear

* nn.Conv2d

* nn.MaxPool2d

* nn.Dropout2d

* nn.Embedding

(损失函数)

* nn.BCELoss

* nn.MSELoss

* nn.CrossEntropyLoss

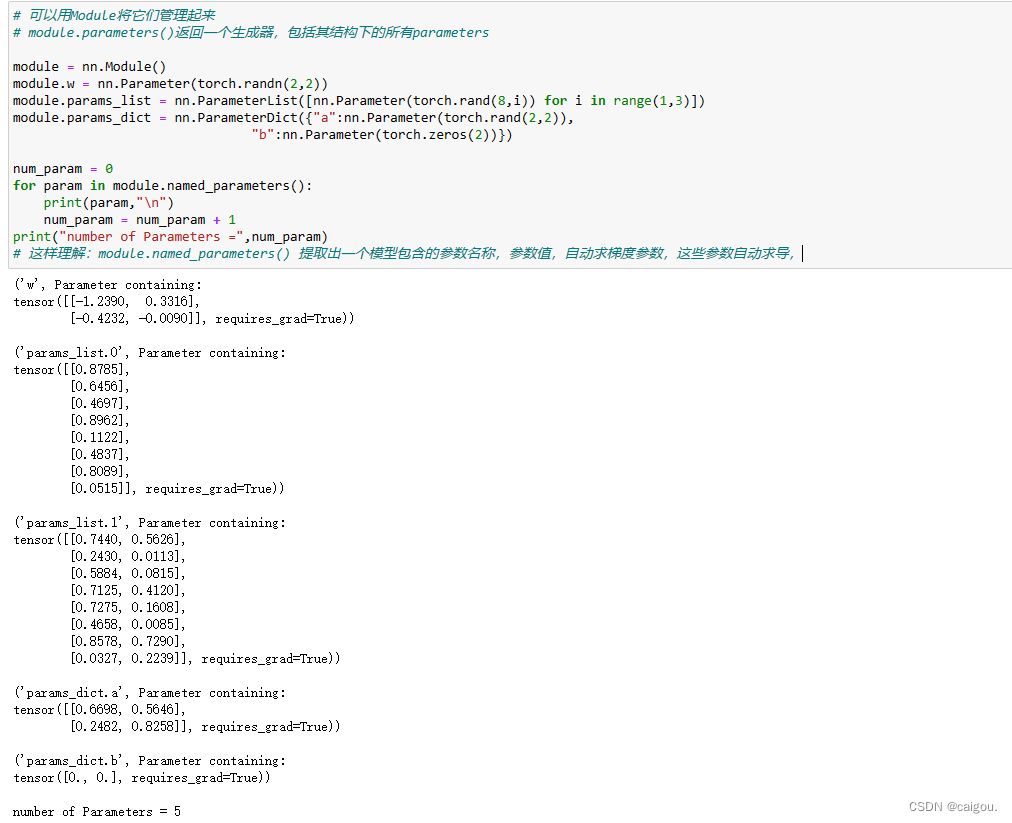

实际上nn.Module除了可以管理其引用的各种参数,还可以管理其引用的子模块,功能十分强大。

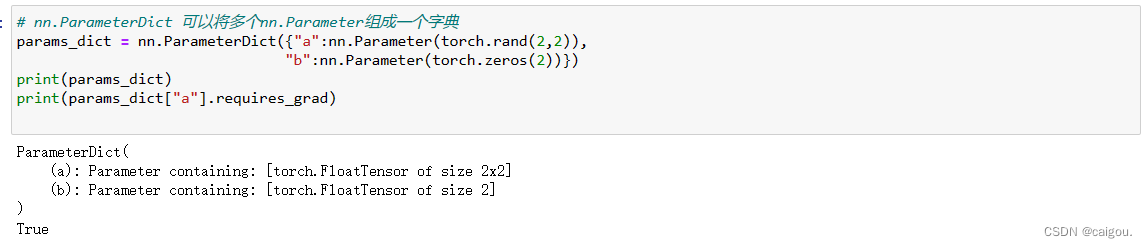

在Pytorch中,模型的参数是需要被优化器训练的,因此,通常要设置参数为 requires_grad = True 的张量。

同时,在一个模型中,往往有许多的参数,要手动管理这些参数并不是一件容易的事情。

Pytorch一般将参数用nn.Parameter来表示,并且用nn.Module来管理其结构下的所有参数。

?

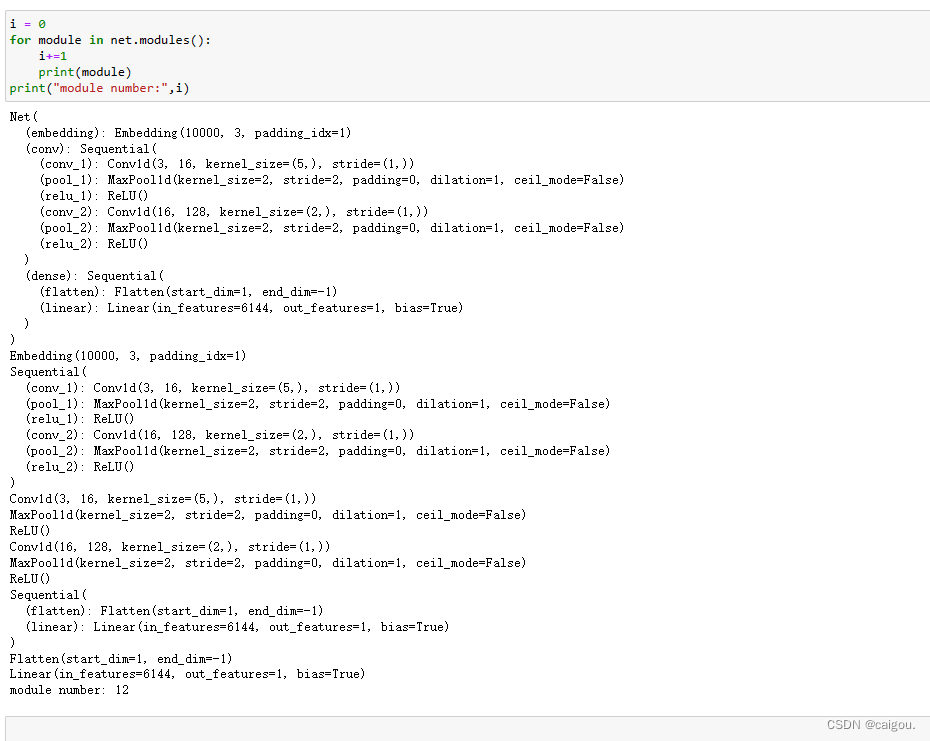

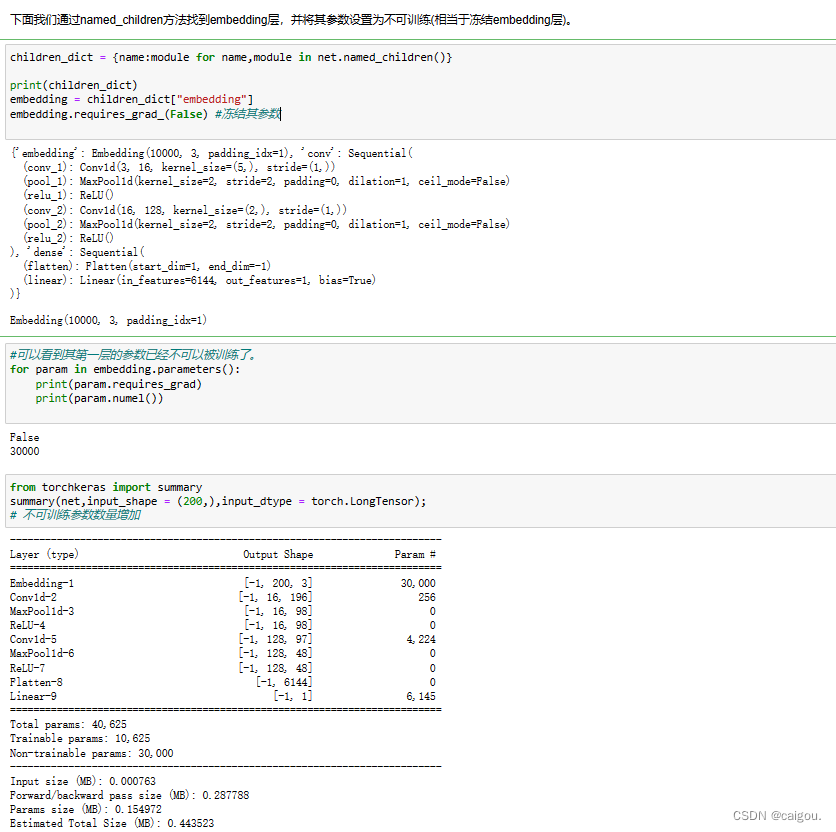

# Net模型继承自nn.module,用nn.module的children(),named_children(),.modules()方法,获取模型结构,并管理每一层的parameters,是否可训练等?

文章来源:https://blog.csdn.net/m0_56294205/article/details/135011472

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!