深度学习|3.6 激活函数 3.7 为什么需要非线性激活函数

2024-01-03 13:45:06

激活函数

主要有sigmoid函数、tanh函数、relu函数和leaky relu函数

tanh函数相比sigmoid函数是具有优势的,因为tanh函数使得输出值的平均值为0,而sigmoid函数使得输出值的平均值为1/2,对下一层来说tanh输出的0更好进行处理。

激活函数tanh和sigmoid函数的不同和缺点

两者在趋近正负无穷时,函数值的变化量基本忽略不计。

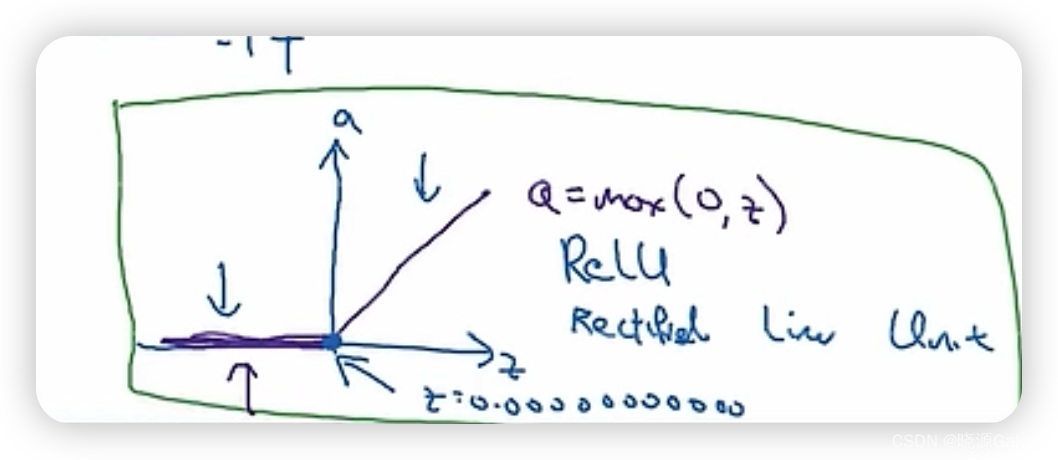

relu函数

relu函数的缺点是,当x小于0时,函数值为一个常数,对应地,其导数为0。

文章来源:https://blog.csdn.net/Fangyechy/article/details/135303138

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!