机器学习——主成分分析(PCA)

今天由我来向大家何为PCA算法及如何实现,PCA算法是无监督方法的典型,在此之前我们先来了解有监督学习、无监督学习以及半监督学习的区别。

一、有监督学习、无监督学习、半监督学习的区别?

1. 有监督学习

监督学习是从标记的训练数据来推断一个功能的机器学习任务。利用一组已知类别的样本调整分类器的参数,使其达到所要求性能的过程。在监督学习中训练数据既有特征(feature)又有标签(label),通过训练, 让机器可以自己找到特征和标签之间的联系。

2.无监督学习

现实生活中常常会有这样的问题:缺乏足够的先验知识,因此难以人工标注类别或进行人工类别标注的成本太高。很自然地,我们希望计算机能代我们完成这些工作,或至少提供一些帮助。根据类别未知(没有被标记)的训练样本解决模式识别中的各种问题,称之为无监督学习。

3. 半监督学习

半监督学习(Semi-Supervised Learning, SSL)是模式识别和机器学习领域研究的重点问题, 是监督学习与无监督学习相结合的一种学习方法。半监督学习使用大量的未标记数据,以及同时使用标记数据, 来进行模式识别工作。当使用半监督学习时, 将会要求尽量少的人员来从事工作,同时,又能够带来比较高的准确性,因此,半监督学习正越来越受到人们的重视。?

二、PCA算法

2.1PCA算法简介?

PCA 是 Principal Component Analysis 的缩写,中文称为主成分分析法。它是一种维数约减(Dimensionality Reduction)算法,即把高维度数据在损失最小的情况下转换为低维度数据的算法。显然,PCA 可以用来对数据进行压缩,可以在可控的失真范围内提高运算速度,提高机器学习的效率,使较为复杂的数据简单化。

所谓损失最小就是从高维向低维映射的时候误差最小,低维空间的描述是向量组,k维空间就用k个向量来描述这个空间。

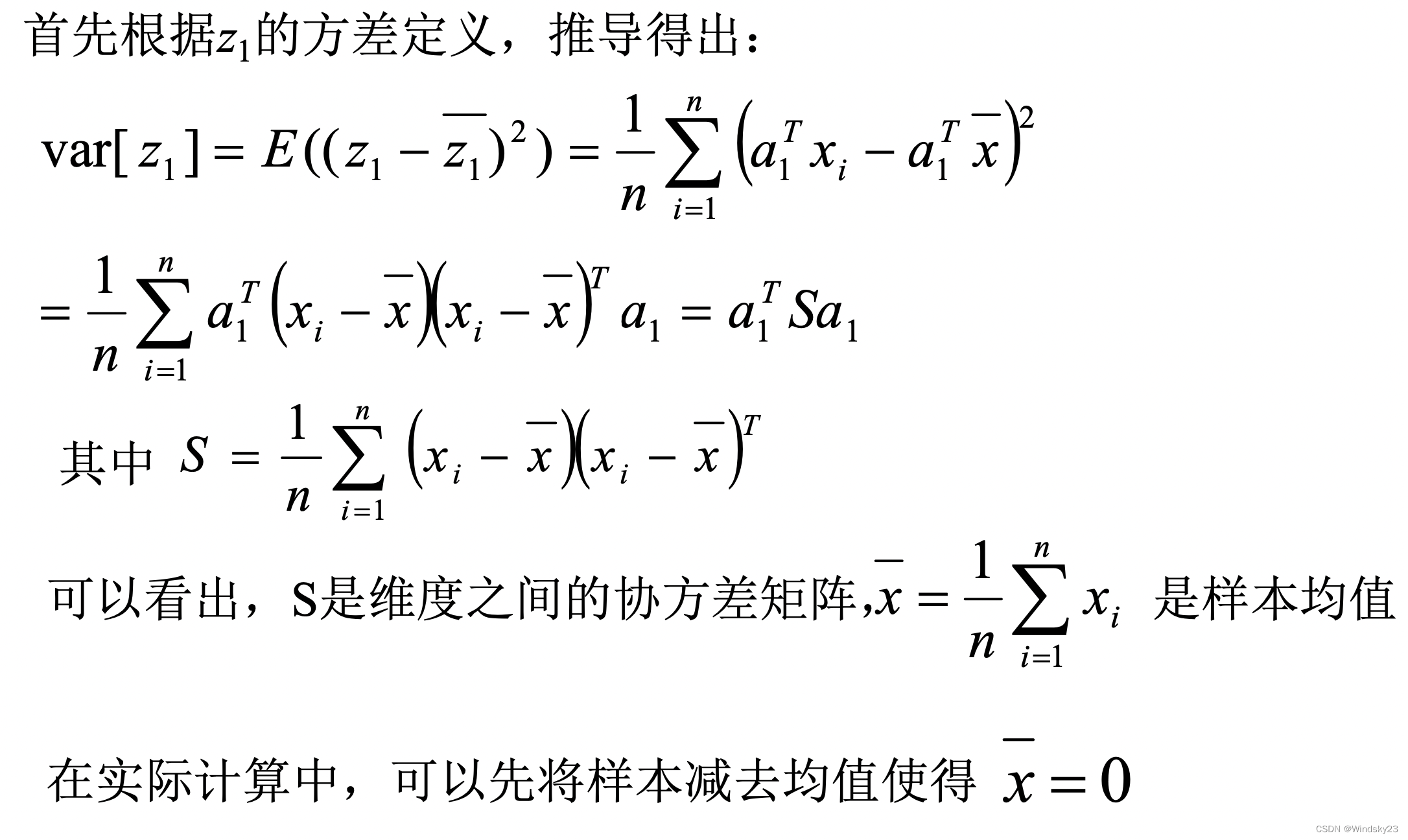

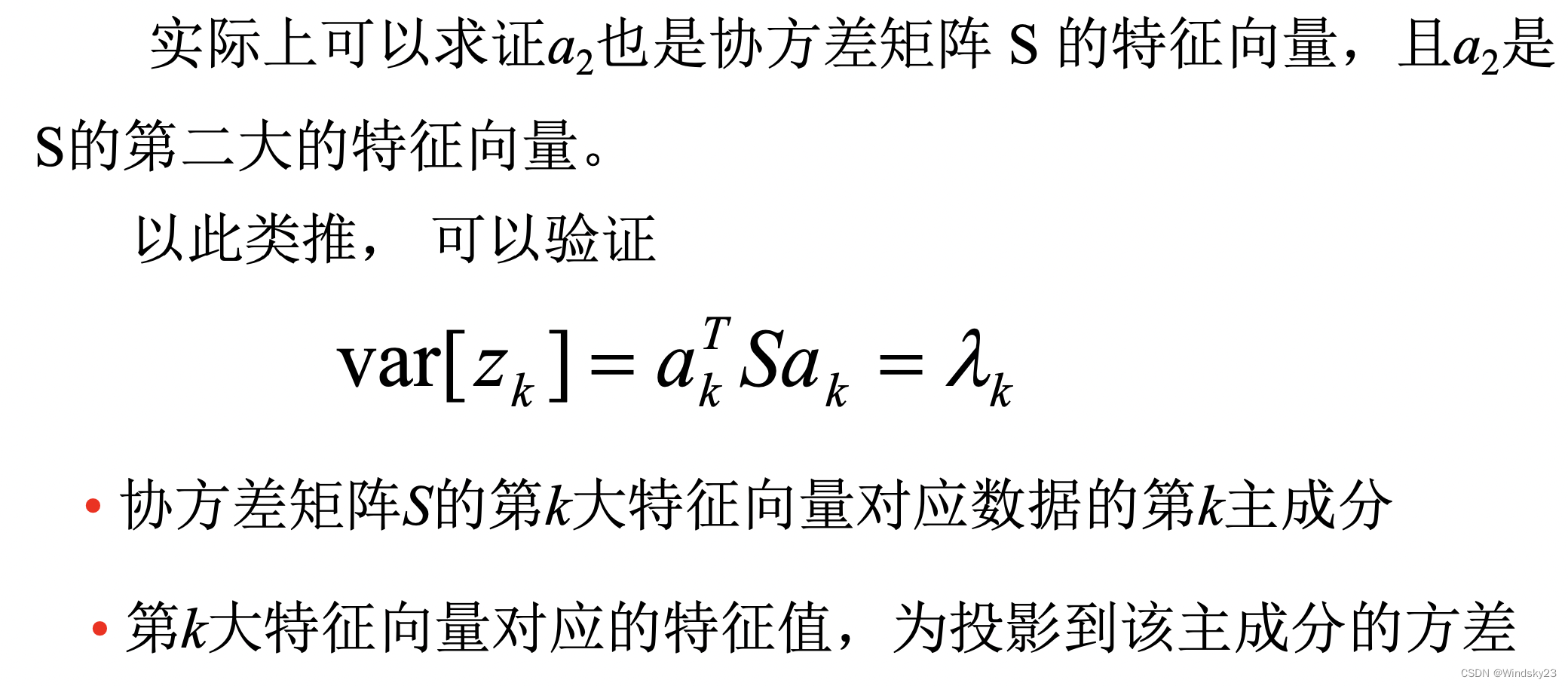

2.2PCA代数定义?

?

?

?

?

?

?

?

?

?

?

?

2.3PCA算法流程?

2.4PCA算法的优缺点

优点

- 降低数据的复杂型,识别最重要的多个特征

- 使得数据集更易使用

- 降低算法的计算开销

- 去除噪声

- 使得结果更容易理解

- 仅仅需要方差衡量信息量,不受数据集以外的因素影响

- 各主成分之间正交,可以消除原始数据成分间的相互影响的因素

- 计算方法简单,主要运算是特征值分解,易于实现

缺点

- 不一定需要,且可能损失有用信息

- 主成分各特征维度的含义具有一定的模糊性,不如原始样本特征的解释性强

- 方差小的非主成分也可能含有对样本差异的重要信息,因降维丢弃可能对后续数据处理有影响

- PCA原理主要是为了消除变量之间的相关性,并且假设这种相关性是线性的,对于非线性的依赖关系则不能得到很好的结果

- PCA假设变量服从高斯分布,当变量不服从高斯分布(如均匀分布)时,会发生尺度缩放与旋转

- 对降维最终得到的数目,也就是潜在的隐变量的数目,不能很好地估计

?

2.5PCA算法原理?

PCA算法的原理是将高维数据集映射到低维空间中,同时保留数据集的主要信息。具体来说,PCA通过计算协方差矩阵和特征向量来确定数据集的主方向,然后将数据集投影到主方向上。在新的低维空间中,每个特征值都是线性无关的,并且是数据变化的主要方向,因此,它们可以更好地表示数据集。?

2.6PCA算法功能?

PCA算法在机器学习中有许多用途,如:

? ? ? ? 1. 降维

? ? ? ? PCA可以将高维数据集降到更低的维度,减少数据存储和处理的开销。

? ? ? ? 2. 压缩

? ? ? ? PCA可以将数据集表示为比原始数据集更紧凑的形式,可以用于数据压缩。

? ? ? ? 3. 特征提取

? ? ? ? PCA可以从原始数据集中提取最重要的特征,这些特征可以用于构建更好的模型。

? ? ? ? 4. 去噪

? ? ? ? PCA可以帮助我们去除噪声,并且使数据集更具可分性。

三、PCA实现人脸识别?

3.1人脸图像矢量化

# 图片矢量化

def img2vector(image):

img = cv2.imread(image, 0) # 读取图片

rows, cols = img.shape #获取图片的像素

imgVector = np.zeros((1, rows * cols))

imgVector = np.reshape(img, (1, rows * cols))#使用imgVector变量作为一个向量存储图片矢量化信息,初始值均设置为0

return imgVector3.2训练图片?

# 读入人脸库,每个人随机选择k张作为训练集,其余构成测试集

def load_orl(k):#参数K代表选择K张图片作为训练图片使用

'''

对训练数据集进行数组初始化,用0填充,每张图片尺寸都定为112*92,

现在共有40个人,每个人都选择k张,则整个训练集大小为40*k,112*92

'''

train_face = np.zeros((40 * k, 112 * 92))

train_label = np.zeros(40 * k) # [0,0,.....0](共40*k个0)

test_face = np.zeros((40 * (10 - k), 112 * 92))

test_label = np.zeros(40 * (10 - k))

# sample=random.sample(range(10),k)#每个人都有的10张照片中,随机选取k张作为训练样本(10个里面随机选取K个成为一个列表)

sample = random.permutation(10) + 1 # 随机排序1-10 (0-9)+1

for i in range(40): # 共有40个人

people_num = i + 1

for j in range(10): # 每个人都有10张照片

image = orlpath + '/s' + str(people_num) + '/' + str(sample[j]) + '.pgm'

# 读取图片并进行矢量化

img = img2vector(image)

if j < k:

# 构成训练集

train_face[i * k + j, :] = img

train_label[i * k + j] = people_num

else:

# 构成测试集

test_face[i * (10 - k) + (j - k), :] = img

test_label[i * (10 - k) + (j - k)] = people_num

return train_face, train_label, test_face, test_label测试集和训练集的像素和标签?

?

?

3.3PCA降维?

# 定义PCA算法

def PCA(data, r):#降低到r维

data = np.float32(np.mat(data))

rows, cols = np.shape(data)

# print(rows, cols)

data_mean = np.mean(data, 0) # 对列求平均值

A = data - np.tile(data_mean, (rows, 1)) # 将所有样例减去对应均值得到A

u, s, VT = np.linalg.svd(A) #利用svd求解右奇异向量即需要将原始数组映射的向量空间矩阵

V_r = VT[:, 0:r] # 按列取前r个特征向量

#将原始数据乘上新的空间向量得到降维后的矩阵

final_data = A * V_r

return final_data, data_mean, V_r?3.4不同维度可视化人脸识别

#可视化函数

def compare_images(original, reconstructed, index, title1='Original Image', title2='Reconstructed Image'):

original_image = original[index].reshape(112,92)

reconstructed_image = reconstructed[index].reshape(112,92)

plt.figure(figsize=(8,4))

plt.subplot(1,2,1)

plt.imshow(original_image, cmap='gray')

plt.title(title1)

plt.subplot(1,2,2)

plt.imshow(reconstructed_image, cmap='gray')

plt.title(title2)

plt.show()

#人脸识别函数

def face_recongize():

#首先获取数据集

train_face, train_label, test_face, test_label = load_orl(7)

#选择要对比的测试图像的索引(例如,第一张图像)

compare_indices = range(1)

for r in range(10, 81, 10): # 最多降到40维,即选取前40个主成分(因为当k=1时,只有40维)

print("当降维到%d时" % (r))

# 利用PCA算法进行训练

data_train_new, data_mean, V_r = PCA(train_face, r)

# print(data_train_new.shape)

num_train = data_train_new.shape[0] # 训练脸总数

num_test = test_face.shape[0] # 测试脸总数

temp_face = test_face - np.tile(data_mean, (num_test, 1))

data_test_new = temp_face * V_r # 得到测试脸在特征向量下的数据

data_test_new = np.array(data_test_new) # mat change to array

# print(data_test_new.shape)

data_train_new = np.array(data_train_new)

#将降维后的测试数据重构回原始图像空间

reconstructed_test_faces = np.dot(data_test_new, V_r.T) + data_mean

#对选定的测试图像进行降维前后对比

for i in compare_indices:

compare_images(test_face,reconstructed_test_faces,i)

# 测试准确度

true_num = 0

for i in range(num_test):

testFace = data_test_new[i, :]

# print(testFace.shape)

diffMat = data_train_new - np.tile(testFace, (num_train, 1)) # 训练数据与测试脸之间距离

print(diffMat.shape)

sqDiffMat = diffMat ** 2

sqDistances = sqDiffMat.sum(axis=1) # 按行求和

sortedDistIndicies = sqDistances.argsort() # 对向量从小到大排序,使用的是索引值,得到一个向量

indexMin = sortedDistIndicies[0] # 距离最近的索引

if train_label[indexMin] == test_label[i]:

true_num += 1

accuracy = float(true_num) / num_test

print('当每个人选择7张照片进行训练时,The classify accuracy is: %.2f%%' % (accuracy * 100))

# print(test_face.shape)

# print(reconstructed_test_faces.shape)

face_recongize()返回降维后前后图像对比及像素?

?

?

3.5不同维度人脸识别准确率?

#人脸识别

def face_rec():

#k=int(input("每个人选择几张照片进行训练:"))

#x_value=[]

#y_value=[]

for r in range(10,41,10):#最多降到40维,即选取前40个主成分(因为当k=1时,只有40维)

print("当降维到%d时"%(r))

x_value=[]#绘图x轴 k取值

y_value=[]#绘图y轴 识别率

for k in range(1,10):

train_face,train_label,test_face,test_label=load_orl(k)#得到数据集

#利用PCA算法进行训练

data_train_new,data_mean,V_r=PCA(train_face,r)

num_train = data_train_new.shape[0]#训练脸总数

num_test = test_face.shape[0]#测试脸总数

temp_face = test_face - np.tile(data_mean,(num_test,1))##去平均后测试行组成的大矩阵(40*(10-k),112*92)

data_test_new = temp_face*V_r#得到测试脸在特征向量下的数据

data_test_new = np.array(data_test_new) # mat change to array

data_train_new = np.array(data_train_new)

#测试准确度

true_num = 0

for i in range(num_test):

testFace = data_test_new[i,:]

diffMat = data_train_new - np.tile(testFace,(num_train,1))#训练数据与测试脸之间距离

sqDiffMat = diffMat**2

sqDistances = sqDiffMat.sum(axis=1)#按行求和

sortedDistIndicies = sqDistances.argsort()#对向量从小到大排序,使用的是索引值,得到一个向量

indexMin = sortedDistIndicies[0]#距离最近的索引

if train_label[indexMin] == test_label[i]:

true_num += 1

else:

pass

accuracy = float(true_num)/num_test

x_value.append(k)

y_value.append(round(accuracy,2))

print ('当每个人选择%d张照片进行训练时,The classify accuracy is: %.2f%%'%(k,accuracy * 100))

#绘图

if r==10:

y1_value=y_value

plt.plot(x_value,y_value,marker="o",markerfacecolor="red")

for a, b in zip(x_value, y_value):

plt.text(a,b,(a,b),ha='center', va='bottom', fontsize=10)

plt.title("降到10维时识别准确率",fontsize=14)

plt.xlabel("K值",fontsize=14)

plt.ylabel("准确率",fontsize=14)

plt.show()

#print ('y1_value',y1_value)

if r==20:

y2_value=y_value

plt.plot(x_value,y2_value,marker="o",markerfacecolor="red")

for a, b in zip(x_value, y_value):

plt.text(a,b,(a,b),ha='center', va='bottom', fontsize=10)

plt.title("降到20维时识别准确率",fontsize=14)

plt.xlabel("K值",fontsize=14)

plt.ylabel("准确率",fontsize=14)

plt.show()

#print ('y2_value',y2_value)

if r==30:

y3_value=y_value

plt.plot(x_value,y3_value,marker="o",markerfacecolor="red")

for a, b in zip(x_value, y_value):

plt.text(a,b,(a,b),ha='center', va='bottom', fontsize=10)

plt.title("降到30维时识别准确率",fontsize=14)

plt.xlabel("K值",fontsize=14)

plt.ylabel("准确率",fontsize=14)

plt.show()

#print ('y3_value',y3_value)

if r==40:

y4_value=y_value

plt.plot(x_value,y4_value,marker="o",markerfacecolor="red")

for a, b in zip(x_value, y_value):

plt.text(a,b,(a,b),ha='center', va='bottom', fontsize=10)

plt.title("降到40维时识别准确率",fontsize=14)

plt.xlabel("K值",fontsize=14)

plt.ylabel("准确率",fontsize=14)

plt.show()

#print ('y4_value',y4_value)

#各维度下准确度比较

L1,=plt.plot(x_value,y1_value,marker="o",markerfacecolor="red")

L2,=plt.plot(x_value,y2_value,marker="o",markerfacecolor="red")

L3,=plt.plot(x_value,y3_value,marker="o",markerfacecolor="red")

L4,=plt.plot(x_value,y4_value,marker="o",markerfacecolor="red")

#for a, b in zip(x_value, y1_value):

# plt.text(a,b,(a,b),ha='center', va='bottom', fontsize=10)

plt.legend([L1,L2,L3,L4], ["降到10维", "降到20维","降到30维","降到40维"], loc=4)

plt.title("各维度识别准确率比较",fontsize=14)

plt.xlabel("K值",fontsize=14)

plt.ylabel("准确率",fontsize=14)

plt.show()

返回不同维度下人脸识别准确率

?

?

四、问题及总结?

问题

报错:UserWarning: Glyph 20934 (\N{CJK UNIFIED IDEOGRAPH-51C6}) missing from current font.

原因是未安装对应的字体库,需进行如下处理

1、下载SimHei字体

https://link.zhihu.com/?target=https%3A//github.com/yuehuhu/some-useful/raw/master/ttf/SimHei.ttf

2、修改matplotlibrc文件

font.family : sans-serif

# 去掉前面的#

font.sans-serif : SimHei, Bitstream Vera Sans, Lucida Grande, Verdana, Geneva, Lucid, Arial, Helvetica, Avant Garde, sans-serif

# 去掉前面的#,并在冒号后面添加SimHei

axes.unicode_minus : False

# 去掉前面的#,并将True改为False

3、删除matplotlib的系统缓存并重启

rm -rf ~/.matplotlib/*

总结?

PCA算法是一种广泛使用的算法,用于降维、特征提取和数据压缩等。它可以使数据集更易于处理,并提供更好的可视化效果。但是,PCA也有一些限制,例如不能更好地理解非线性数据集。这次实验让我对主成分分析有了一定的了解和认识,能运用其解决实际问题,但还不能熟练使用,要继续加强对机器学习相关知识的学习。总的来说是一次收获满满的实验。?

?

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!