【大模型实践】Langchain-Chatchat安装体验(一)

本文介绍Langchain-Chatchat的安装方法,参考官方文档。

关于Langchain-Chatchat:

🤖? 一种利用?langchain?思想实现的基于本地知识库的问答应用,目标期望建立一套对中文场景与开源模型支持友好、可离线运行的知识库问答解决方案。

💡 受?GanymedeNil?的项目?document.ai?和?AlexZhangji?创建的?ChatGLM-6B Pull Request?启发,建立了全流程可使用开源模型实现的本地知识库问答应用。本项目的最新版本中通过使用?FastChat?接入 Vicuna, Alpaca, LLaMA, Koala, RWKV 等模型,依托于?langchain?框架支持通过基于?FastAPI?提供的 API 调用服务,或使用基于?Streamlit?的 WebUI 进行操作。

? 依托于本项目支持的开源 LLM 与 Embedding 模型,本项目可实现全部使用开源模型离线私有部署。与此同时,本项目也支持 OpenAI GPT API 的调用,并将在后续持续扩充对各类模型及模型 API 的接入。

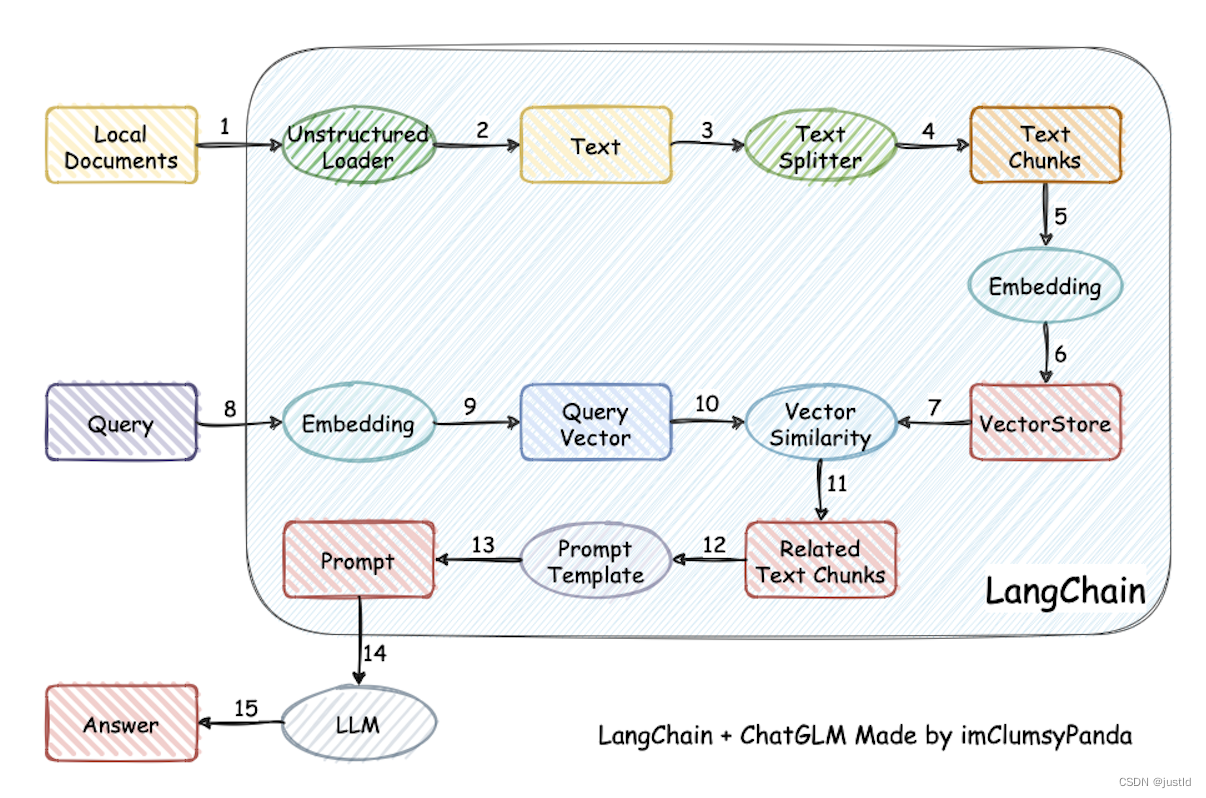

?? 本项目实现原理如下图所示,过程包括加载文件 -> 读取文本 -> 文本分割 -> 文本向量化 -> 问句向量化 -> 在文本向量中匹配出与问句向量最相似的?

top k个 -> 匹配出的文本作为上下文和问题一起添加到?prompt中 -> 提交给?LLM生成回答。

其原理如下图:

从文档处理角度来看,实现流程如下:

本文介绍使用conda安装的方法,其他配置如下表:

| ubuntu | 20.04 |

| 显卡 | RTX4090 |

一、环境搭建

使用conda创建虚拟环境:

conda create -n lang python=3.10

conda activate lang安装torch、torchvision(这里根据自己的情况选择合适的版本,因为requirements.txt要求torch=2.1.0,所以安装了2.1.0,我用的cuda11.8):

pip install torch==2.1.0 torchvision==0.16.0 torchaudio==2.1.0 --index-url https://download.pytorch.org/whl/cu118安装依赖:

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install -r requirements_api.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install -r requirements_webui.txt -i https://pypi.tuna.tsinghua.edu.cn/simple二、下载权重并完成初始化

安装lfs:

git lfs install下载chatglmv3-6b模型(huggingface被墙了,这里从modelscope下载):

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git进入chatglm3-6b文件夹:

cd chatglm3-6b/下载权重:

git lfs pull返回上级目录:

cd ..下载Embedding模型bge-large-zh:

git clone https://www.modelscope.cn/AI-ModelScope/bge-large-zh.git进入bge-large-zh文件夹:

cd bge-large-zh下载权重:

git lfs pull下载完毕后,返回上级目录并初始化数据库和配置文件(初始化数据库比较慢):

cd ..

python copy_config_example.py

python init_database.py --recreate-vs三、启动

完成配置以后,启动:

python startup.py -a打开成功:

可以成功对话:

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!