TTS | 2019~2023年最新增强/生成情绪的语音合成调研(20231211更新版)

本博客主要是?增强/生成情绪的语音合成调研,论文按照时间顺序排列,且有些论文为期刊会议论文,有的是arxiv论文,在本文中,标识如下:

【🔊ICML 】【?Interspeech 】【🫧ICASSP】

2019.09.30_Determination of representative emotional style of speech based on k-means algorithm

论文地址:Determination of representative emotional style of speech based on k-means algorithm (jask.or.kr)

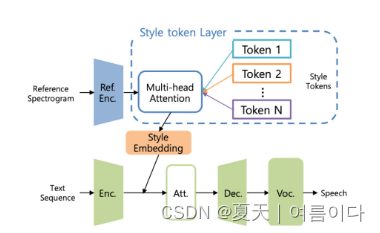

将GST引入端到端的语音合成模型中,GST-Tacotron 框架如下

添加情感表示的框架

[?Interspeech 2021]2021.04.03_Reinforcement Learning for Emotional Text-to-Speech Synthesis with Improved Emotion Discriminability

近年来,情感文本到语音合成 (ETTS) 取得了很大进展。然而,生成的声音通常无法通过其预期的情感类别在感知上识别。为了解决这个问题,我们提出了一种新的ETTS交互式训练范式,表示为i-ETTS,它试图通过与语音情感识别(SER)模型的交互来直接提高情感的可判别性。此外,我们制定了强化学习的迭代训练策略,以确保i-ETTS优化的质量。实验结果表明,所提出的i-ETTS通过更准确地呈现语音风格,优于最先进的基线。据我们所知,这是情感文本到语音合成中强化学习的首次研究。

?

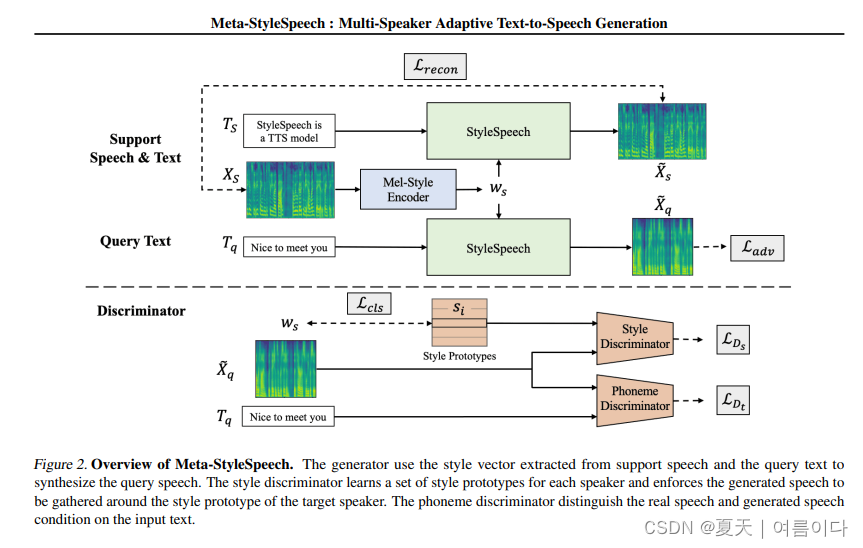

[ 🔊ICML 2021 ]2021.06.06_Meta-StyleSpeech : Multi-Speaker Adaptive Text-to-Speech Generation

论文地址:Meta-StyleSpeech : Multi-Speaker Adaptive Text-to-Speech Generation (arxiv.org)

随着神经文本转语音 (TTS) 模型的快速发展,个性化语音生成现在对许多应用的需求量很大。为了实现实际适用性,TTS 模型应该仅使用来自给定说话者的几个音频样本来生成高质量的语音,这些样本的长度也很短。然而,现有方法要么需要对模型进行微调,要么在不进行微调的情况下实现低适应质量。在这项工作中,我们提出了一种新的TTS模型StyleSpeech,它不仅可以合成高质量的语音,还可以有效地适应新的说话者。具体来说,我们提出了风格自适应层归一化(SALN),它根据从参考语音音频中提取的风格来对齐文本输入的增益和偏置。借助 SALN,我们的模型可以有效地合成目标说话人的语音,即使是从单个语音音频中也是如此。此外,为了增强 StyleSpeech 对新说话者语音的适应能力,我们通过引入两个使用风格原型训练的判别器并执行情景训练,将其扩展到 Meta-StyleSpeech。实验结果表明,我们的模型生成高质量的语音,通过单个短时(1-3秒)语音音频准确地跟随说话者的声音,性能明显优于基线。

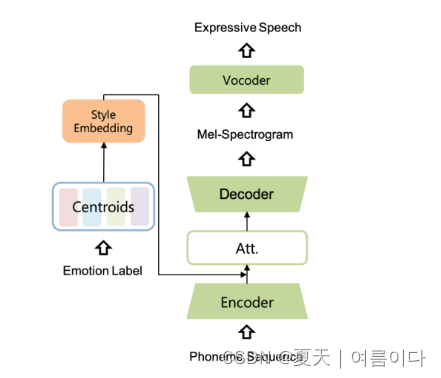

[ ?Interspeech 2021]2021.06.17_EMOVIE: A Mandarin Emotion Speech Dataset with a Simple Emotional Text-to-Speech Model

最近,人们对神经语音合成的兴趣越来越大。虽然深度神经网络在文本转语音(TTS)任务中取得了最先进的结果,但由于高质量情感语音数据集的稀缺性和先进的情感TTS模型的缺乏,如何生成更具情感性和表现力的语音正成为研究人员面临的新挑战。在本文中,我们首先简要介绍并公开发布了一个普通话情感语音数据集,该数据集包含9,724个样本,其中包含音频文件及其情感人工标记注释。之后,我们提出了一种简单而有效的情感语音合成架构,称为EMSpeech。与那些需要额外参考音频作为输入的模型不同,我们的模型可以仅从输入文本中预测情感标签,并根据情感嵌入生成更具表现力的语音。在实验阶段,我们首先通过情绪分类任务来验证数据集的有效性。然后,我们在提议的数据集上训练我们的模型,并进行一系列主观评估。最后,通过在情感语音合成任务中表现出可比的性能,我们成功地证明了所提模型的能力。

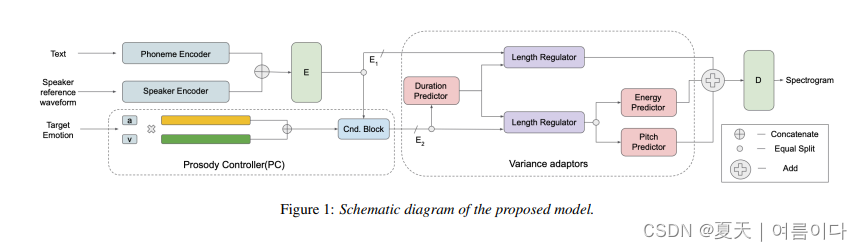

[ ?Interspeech 2021]2021.11.Emotional Prosody Control for Speech Generation

机器生成的语音的特点是其有限或不自然的情绪变化。当前的文本转语音系统生成具有平坦情感的语音、从预定义集合中选择的情感、从训练数据中的韵律序列中学习的平均变化或从源风格传输的平均变化。我们提出了一种文本到语音(TTS)系统,用户可以从连续且有意义的情感空间(Arousal-Valence space)中选择生成语音的情感。所提出的TTS系统可以从任何说话者的文本中生成语音,并可以很好地控制情绪。我们表明,该系统可以处理训练期间看不见的情绪,并且可以根据他/她的语音样本扩展到以前看不见的说话者。我们的工作将最先进的 FastSpeech2 骨干网的视野扩展到多扬声器设置,并为其提供令人垂涎的连续(和可解释)情感控制,而不会对合成语音的质量造成任何可观察到的下降。?

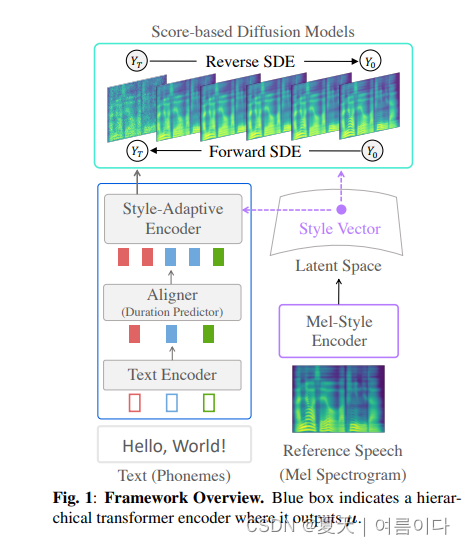

[ 🫧ICASSP2023 ]2022.11.17_?Grad-StyleSpeech: Any-speaker Adaptive Text-to-Speech Synthesis with Diffusion Models

Demo:

?近年来,由于神经生成建模的进步,文本转语音 (TTS) 合成技术取得了重大进展。然而,现有的任何说话人自适应TTS方法在模仿目标说话人的风格方面都取得了不理想的性能,因为它们在模仿目标说话人的风格方面精度不理想。在这项工作中,我们提出了 Grad-StyleSpeech,这是一个基于扩散模型的任意说话人自适应 TTS 框架,该模型可以生成高度自然的语音,与目标说话人的声音具有极高的相似性,给定几秒钟的参考语音。在英语基准测试中,Grad-StyleSpeech 明显优于最近的说话人自适应 TTS 基线。音频示例可在此?https URL?中找到。

?2022.11.26_CONTEXTUAL EXPRESSIVE TEXT-TO-SPEECH

论文地址:2211.14548.pdf (arxiv.org)

代码未开源

富有表现力的文本转语音 (TTS) 的目标是以高表现力合成具有所需内容、韵律、情感或音色的自然语音。以前的大多数研究都试图从给定的风格和情绪标签中生成语音,通过将风格和情绪分类为固定数量的预定义类别来过度简化问题。在本文中,我们引入了一种新的任务设置,即上下文TTS(CTTS)。CTTS的主要思想是,一个人说话的方式取决于她所处的特定语境,其中语境通常可以表示为文本。因此,在CTTS任务中,我们建议利用这样的上下文来指导语音合成过程,而不是依赖风格和情感的明确标签。为了完成这项任务,我们构建了一个合成数据集并开发了一个有效的框架。实验表明,我们的框架可以在合成数据集和真实场景中基于给定的上下文生成高质量的表达语音。

[ ?Interspeech 2021]2021.12.07_Multi-speaker Emotional Text-to-speech Synthesizer

我们提出了一种方法来训练我们的多说话人情感文本到语音合成器,它可以表达 10 个说话者的 7 种不同情绪的语音。在学习之前,将删除音频样本中的所有静音。这导致我们的模型可以快速学习。应用课程学习来有效地训练我们的模型。我们的模型首先使用大型单说话人中立数据集进行训练,然后使用所有说话人的中性语音进行训练。最后,我们的模型使用来自所有说话者的情感语音数据集进行训练。在每个阶段,每个说话者-情感对的训练样本以小批量出现的概率相等。通过这个过程,我们的模型可以合成所有目标说话者和情绪的语音。我们的合成音频集可在我们的网页上找到。

[ ?Interspeech 2022 ]2022.07.13_Text-driven Emotional Style Control and Cross-speaker Style Transfer in Neural TTS

近年来,富有表现力的文本转语音功能已显示出改进的性能。然而,合成语音的风格控制往往局限于离散的情感类别,需要目标说话人在目标风格中记录的训练数据。在许多实际情况下,用户可能没有记录目标情绪的参考语音,但仍然有兴趣通过输入所需情感风格的文本描述来控制语音风格。在本文中,我们提出了一种基于文本的接口,用于多说话人TTS中的情感风格控制和跨说话人风格迁移。我们提出了一种双模态风格编码器,该编码器使用预训练的语言模型对文本描述嵌入和语音风格嵌入之间的语义关系进行建模。为了进一步改善在不相交的多风格数据集上的交叉说话人风格迁移,我们提出了一种新的风格损失。实验结果表明,我们的模型即使在看不见的风格下也能产生高质量的表达性语音。?

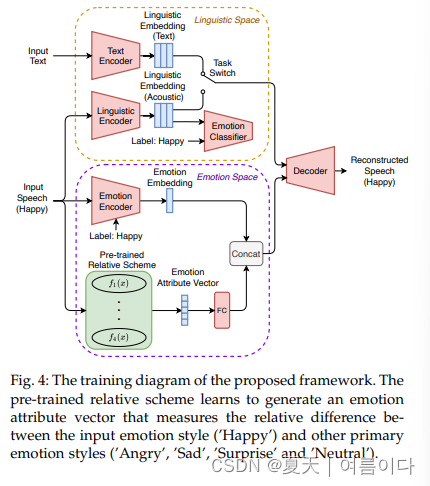

2022.12.28_Speech Synthesis with Mixed Emotions

?情感语音合成旨在合成具有各种情感效果的人声。目前的研究主要集中在模仿属于特定情绪类型的平均风格上。在本文中,我们试图在运行时生成具有混合情绪的语音。我们提出了一种新的公式来测量不同情绪的语音样本之间的相对差异。然后,我们将我们的公式合并到序列的情感文本到语音框架中。在训练过程中,该框架不仅明确表征了情绪风格,还通过量化与其他情绪的差异来探索情绪的序数性质。在运行时,我们通过手动定义情感属性向量来控制模型以产生所需的情感混合。客观和主观评价验证了拟议框架的有效性。据我们所知,这项研究是第一个关于建模、综合和评估言语中混合情绪的研究。

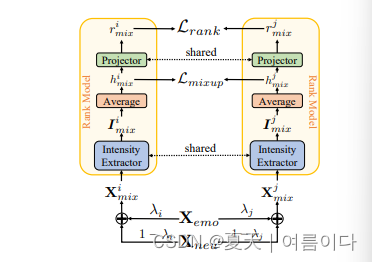

[ 🫧ICASSP 2023 ]2023.03.02_Fine-grained Emotional Control of Text-To-Speech: Learning To Rank Inter- And Intra-Class Emotion Intensities

论文地址:2303.01508.pdf (arxiv.org)

Demo:https: //wshijun1991.github.io/ICASSP2023_DEMO

最先进的文本转语音 (TTS) 模型能够产生高质量的语音。然而,生成的语音在情感表达中通常是中性的,而人们往往希望对单词或音素进行细粒度的情感控制。尽管仍然具有挑战性,但最近提出了第一个TTS模型,该模型能够通过手动分配情绪强度来控制语音。不幸的是,由于忽略了班级内的距离,强度差异往往无法识别。在本文中,我们提出了一种细粒度的可控情绪TTS,它同时考虑了类间和类内的距离,并能够合成具有可识别强度差异的语音。我们的主观和客观实验表明,我们的模型在可控性、情感表达性和自然性方面超过了两个最先进的可控TTS模型。

2.1.秩模型

?

?

Xemo是非自然情绪分类的样本,Xneu是自然的,

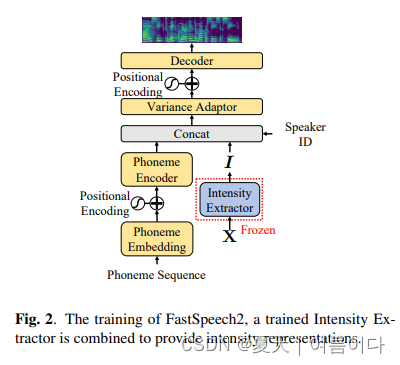

2.2.TTS模型

?

?

使用fastspeech2的结构

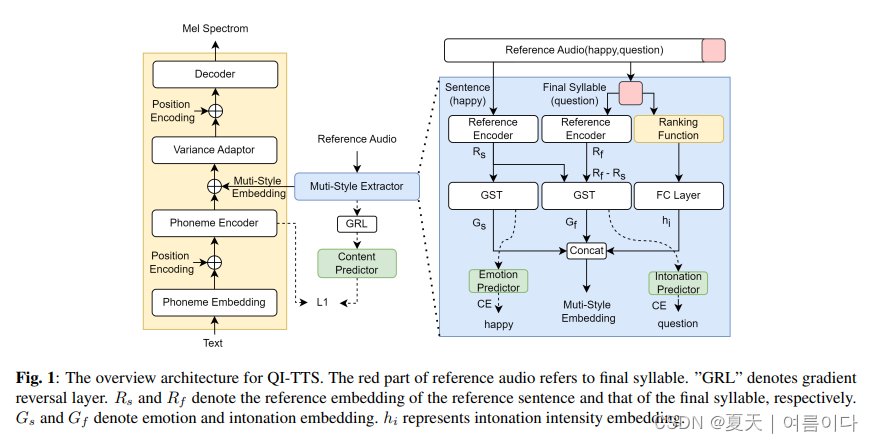

[ 🫧ICASSP 2023 ]2023.03.14_QI-TTS: Questioning Intonation Control for Emotional Speech Synthesis

最近的表达性文本转语音 (TTS) 模型侧重于合成情感语音,但忽略了一些细粒度的风格,例如语调。在本文中,我们提出了QI-TTS,旨在更好地传递和控制语调,以进一步传递说话者的提问意图,同时从参考语音中传递情感。我们提出了一个多样式提取器,从两个不同的层次提取样式嵌入。句子级别代表情感,而最后一个音节级别代表语调。对于细粒度的语调控制,我们使用相对属性来表示音节级别的语调强度。实验验证了QI-TTS在改善情感语音合成中语调表现力的有效性。

[ 🫧ICASSP 2023 ]2023.03.15_Cross-speaker Emotion Transfer by Manipulating Speech Style Latents

?论文地址:[2303.08329] Cross-speaker Emotion Transfer by Manipulating Speech Style Latents (arxiv.org)

近年来,情感文本转语音取得了长足的进步。但是,它需要大量的标记数据,不容易访问。即使可以获取情感语音数据集,在控制情感强度方面仍然存在局限性。在这项工作中,我们提出了一种在潜在风格空间中使用向量算术进行交叉说话者情感传递和操纵的新方法。通过仅利用少数标记样本,我们从阅读式语音中生成情感语音,而不会丢失说话者身份。此外,使用标量值可以很容易地控制情绪强度,为用户提供了一种直观的方式来操纵语音。实验结果表明,所提方法在表现力、自然性和可控性方面具有较好的性能,保留了说话人的身份。

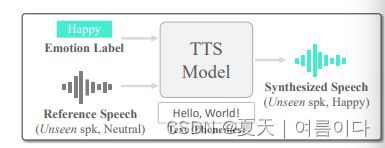

2023.05.23_ZET-Speech: Zero-shot adaptive Emotion-controllable Text-to-Speech Synthesis with Diffusion and Style-based Models

Demo:ZET-Speech

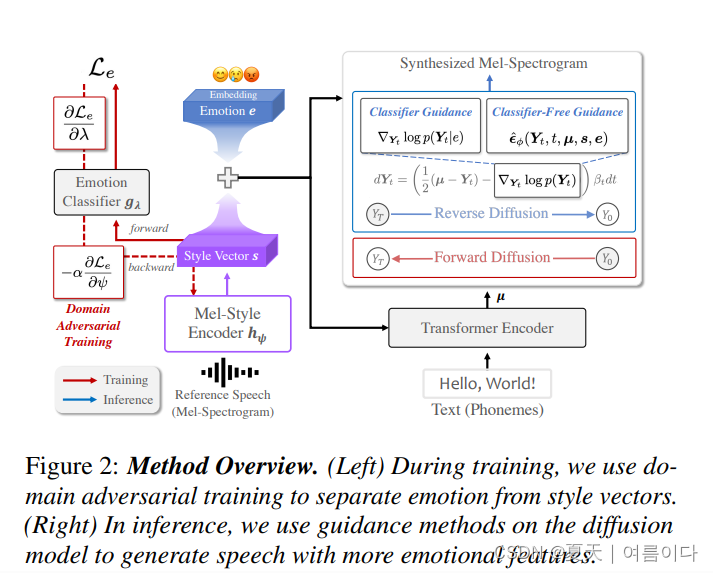

情感文本转语音 (TTS) 是开发需要自然和情感语音的系统(例如类人对话代理)中的一项重要任务。然而,现有方法的目的只是在培训期间为看到的说话者产生情感 TTS,而没有考虑对看不见的说话者的泛化。在本文中,我们提出了 ZET-Speech,这是一种零样本自适应情绪可控 TTS 模型,允许用户仅使用简短的中性语音片段和目标情绪标签来合成任何说话者的情感语音。具体而言,为了实现零样本自适应TTS模型来合成情感语音,我们提出了基于扩散模型的领域对抗学习和引导方法。实验结果表明,ZET-Speech成功地将自然和情感语音与看得见和看不见的说话者所需的情感相结合。示例位于此 https URL。

?

?

论文架构

?

?

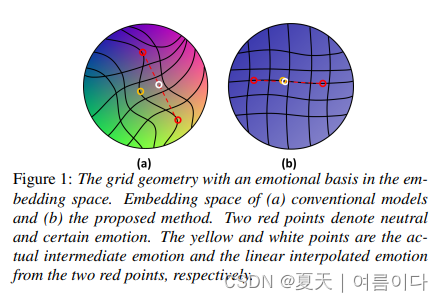

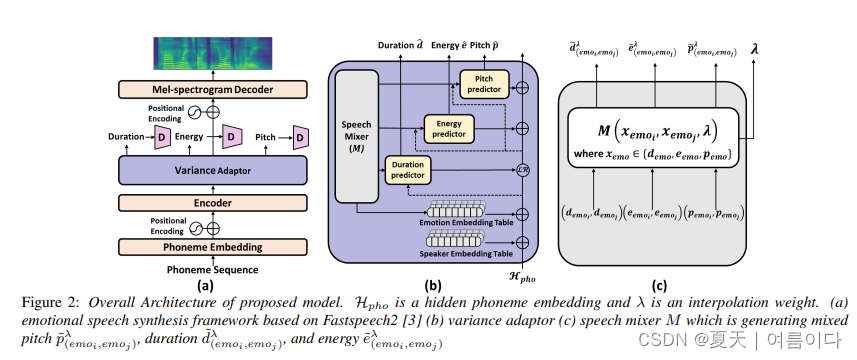

2023.05.29.v2_Semi-supervised learning for continuous emotional intensity controllable speech synthesis with disentangled representations

??最近的文本转语音模型已经达到了生成类似于人类所说的自然语音的水平。但在表现力方面仍然存在局限性。现有的情感语音合成模型在情感潜在空间中使用具有缩放参数的插值特征表现出可控性。然而,由于情绪、说话者等特征的纠缠,现有模型产生的情感潜在空间难以控制持续的情感强度。在本文中,我们提出了一种使用半监督学习来控制情绪连续强度的新方法。该模型使用从语音信息的音素级序列生成的伪标签来学习中等强度的情绪。根据所提出的模型构建的嵌入空间满足了具有情感基础的均匀网格几何形状。实验结果表明,所提方法在可控性和自然性方面具有较好的优点。?

? ?

?

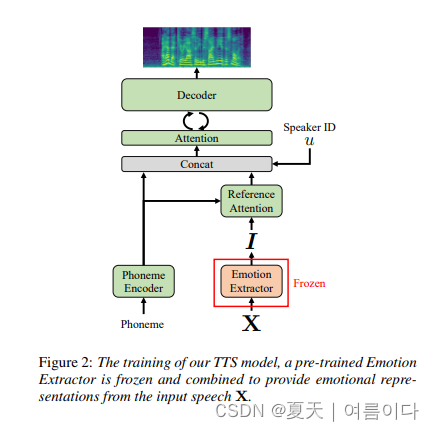

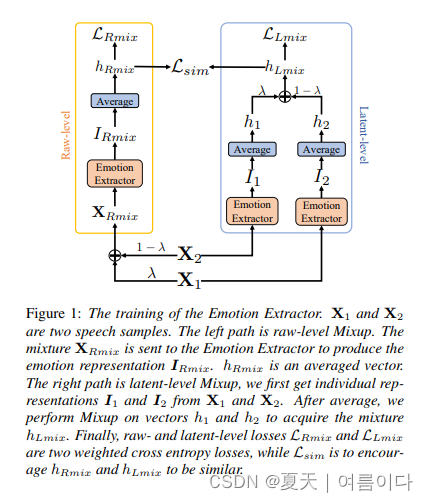

?[ ?Interspeech 2023 ]2023.06.09_Learning Emotional Representations from Imbalanced Speech Data for Speech Emotion Recognition and Emotional Text-to-Speech

有效的言语情感表征在言语情感识别 (SER) 和情感文本转语音 (TTS) 任务中起着关键作用。然而,与中性风格语音相比,情感语音样本的获取更加困难和昂贵,这导致了一个大多数相关作品不幸忽略的问题:数据集不平衡。模型可能会过度拟合大多数中性类,并且无法产生稳健有效的情感表征。在本文中,我们提出了一个情感提取器来解决这个问题。我们使用增强方法来训练模型,并使其能够从不平衡的数据集中提取有效且可推广的情感表征。我们的实证结果表明:(1)对于SER任务,所提出的Emotion Extractor在三个不平衡数据集上都超过了最先进的基线;(2)我们的情感提取器生成的表征有利于TTS模型,并使其能够合成更具表现力的语音。

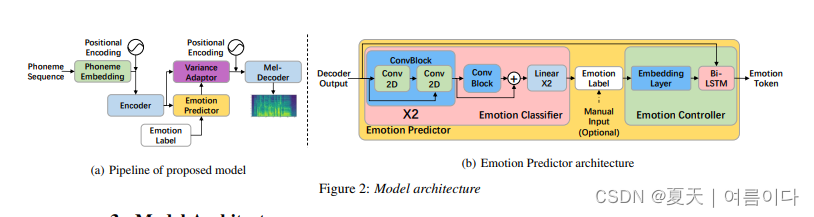

2023.06.28_EmoSpeech: Guiding FastSpeech2 Towards Emotional Text to Speech

最先进的语音合成模型试图尽可能接近人声。因此,情绪建模是文本转语音 (TTS) 研究的重要组成部分。在我们的工作中,我们选择了 FastSpeech2 作为起点,并提出了一系列用于合成情感语音的修改。根据自动和人工评估,我们的模型 EmoSpeech 在生成语音的 MOS 分数和情感识别准确性方面都超过了现有模型。我们为构成 EmoSpeech 的 FastSpeech2 架构的每个扩展提供了详细的消融研究。文本中情感的不均匀分布对于更好的综合语音和语调感知至关重要。我们的模型包括一个调节机制,通过允许情绪以不同的强度水平影响每部手机来有效地处理这个问题。人工评估表明,所提出的修改生成的音频具有更高的 MOS 和情感表现力。

论文使用了:

- 用离散标签表示一个或多个情绪

- 有参考语音的情感状态

- 目标情绪状态作为表单条件数据的上下文

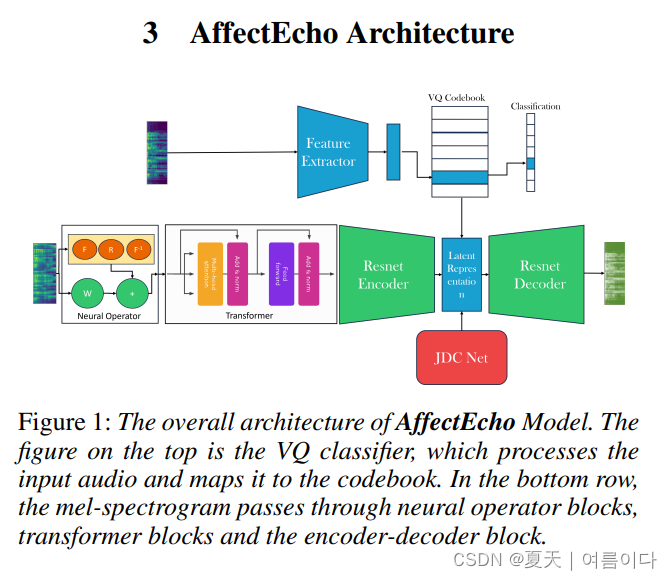

2023.08.16_AffectEcho: Speaker Independent and Language-Agnostic Emotion and Affect Transfer for Speech Synthesis

情感是一种情感特征,包括效价、唤醒和强度,是实现真实对话的关键属性。虽然现有的文本转语音 (TTS) 和语音转语音系统依赖于强度嵌入向量和全局风格标记来捕获情感,但这些模型将情感表示为风格的组成部分,或者在离散类别中表示它们。我们提出了 AffectEcho,一种情绪翻译模型,它使用矢量量化代码本在具有五个影响强度级别的量化空间中对情绪进行建模,以捕捉同一情绪中复杂的细微差别和细微差异。量化的情感嵌入是从口语样本中隐式派生的,无需使用单热向量或显式强度嵌入。实验结果表明,我们的方法在控制生成语音的情绪方面是有效的,同时保留了每个说话者独特的身份、风格和情感节奏。我们展示了从双语(英语和中文)语音语料库中学习到的量化情感嵌入的语言独立情感建模能力,以及从参考语音到目标语音的情感迁移任务。我们在定性和定量指标上都取得了最先进的结果。

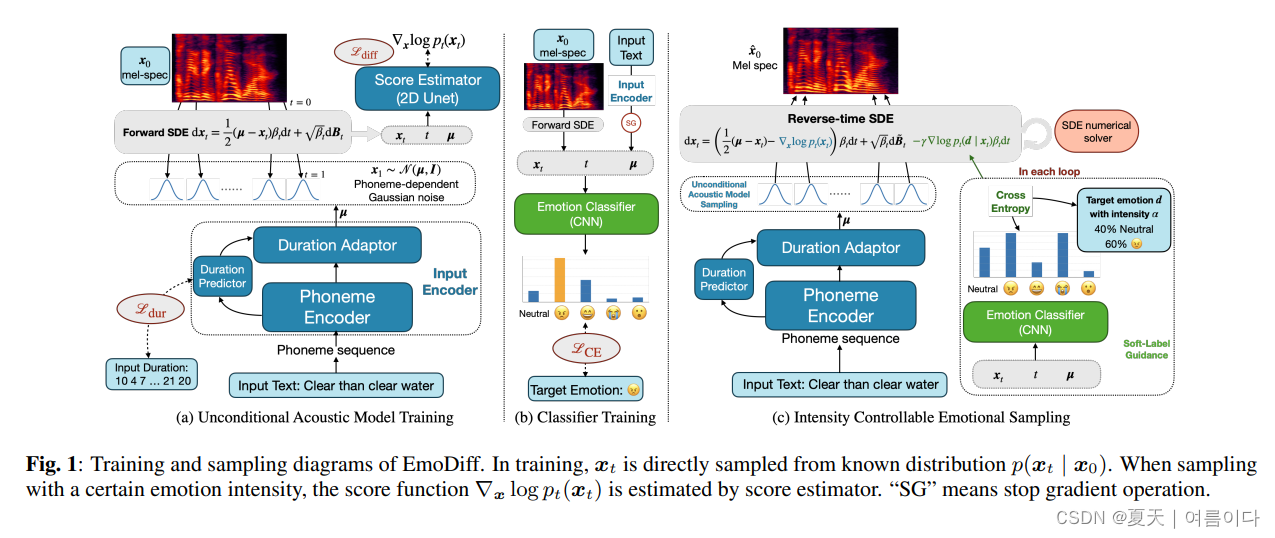

2023.11.16_EMODIFF: INTENSITY CONTROLLABLE EMOTIONAL TEXT-TO-SPEECH WITH SOFT-LABEL GUIDANCE

?尽管当前的神经文本转语音 (TTS) 模型能够生成高质量的语音,但强度可控的情感 TTS 仍然是一项具有挑战性的任务。大多数现有方法需要外部优化才能进行强度计算,从而导致结果欠佳或质量下降。在本文中,我们提出了EmoDiff,这是一种基于扩散的TTS模型,其中情绪强度可以通过源自分类器引导的软标签引导技术来操纵。具体来说,EmoDiff 不是使用指定情绪的 one-hot 向量进行引导,而是使用软标签进行引导,其中指定情绪和 \textit{Neutral} 的值设置为α和1?α分别。这α这里代表情绪强度,可以从 0 到 1 中选择。我们的实验表明,EmoDiff 可以在保持高语音质量的同时精确控制情绪强度。此外,通过反向去噪过程中的采样,可以产生具有特定情感强度的多样化语音。

?

?

参考文献

【1】?Emotional Speech Synthesis | Papers With Code

【2】keonlee9420/StyleSpeech: PyTorch Implementation of Meta-StyleSpeech : Multi-Speaker Adaptive Text-to-Speech Generation (github.com)?【3】arxiv-sanity (arxiv-sanity-lite.com)

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!