【无标题】

2023-12-24 17:09:32

?报错:RuntimeError: CUDA out of memory. Tried to allocate 560.00 MiB (GPU 0; 23.70 GiB total capacity; 3.57 MiB already allocated; 516.56 MiB free; 4.00 MiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. ?See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

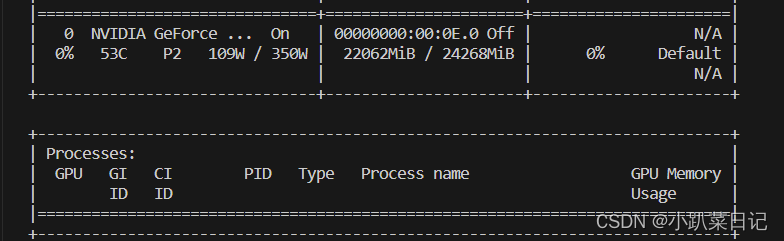

查看显存:

nvidia-smi 显存被占用,但是看不到进程名

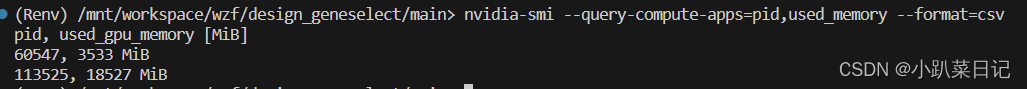

1.使用下面的命令,查看详细的pid进程号和占用的显存

nvidia-smi --query-compute-apps=pid,used_memory --format=csv ?

?

?2.sudo kill pid,kill指定pid进程,本文案例为60547,则为以下命令

sudo kill 60547

或者直接执行以下命令

fuser 命令来查找哪些进程正在使用 /dev/nvidia* 文件

awk?命令来处理 fuser 的输出,遍历每一行输出,以 "kill -9 " 开头,后面跟着每个进程的PID

执行前面生成的命令

sudo fuser -v /dev/nvidia* |awk '{for(i=1;i<=NF;i++)print "kill -9 " $i;}' | sudo sh

参考:

文章来源:https://blog.csdn.net/qq_55736201/article/details/135182452

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!