灵巧手操作模仿学习:DexMV

2023-12-19 22:08:27

DexMV: Imitation Learning for Dexterous Manipulation from Human Videos解析

Manipulation from Human Videos解析)

论文链接:https://arxiv.org/abs/2108.05877

项目网址:https://yzqin.github.io/dexmv/

论文代码:https://github.com/yzqin/dexmv-sim

论文出处:2022 ECCV

论文单位:加州大学圣迭戈分校

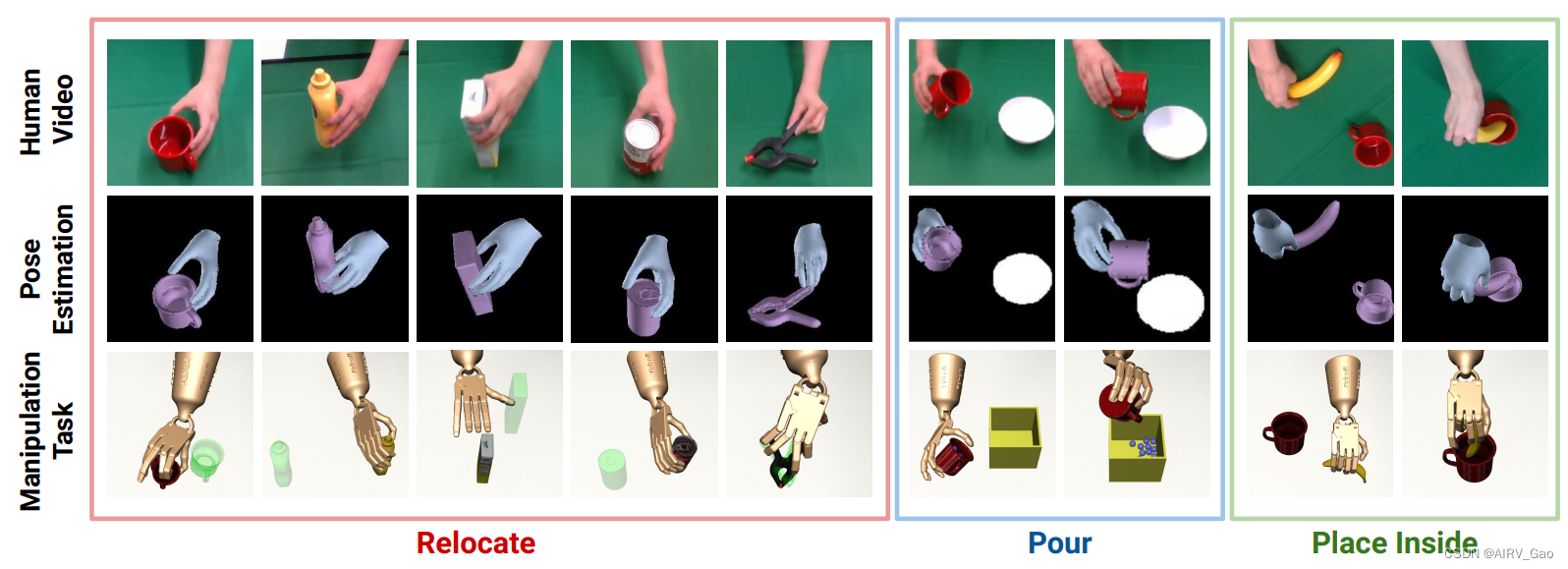

图1. 我们记录了关于操作任务的人类视频(第一行),并从视频(第二行)中执行3D手-对象姿态估计来构建演示。我们有一个配对的模拟系统,为多指机器人(第三排)提供相同的灵巧操作任务,包括:relocate, pour, 和 place inside,我们可以使用模仿学习(imitation learning) with 推断演示(inferred demonstrations) 来解决这些问题。

摘要

-

虽然计算机视觉在理解 手-物交互(hand-object interactions) 方面取得了重大进展,但对于机器人来说,进行复杂的灵巧操作仍然是非常具有挑战性的。

-

本文提出了一种新的模仿学习平台和 pipeline DexMV (Dexterous Manipulation from Videos)。

-

我们设计了一个平台,其中包括:

(i) 一个模拟系统,用于多手指机械手的复杂灵巧操作任务;

(ii)一个计算机视觉系统,用于记录大规模演示人手执行相同任务。 -

在我们的新 pipeline 中,我们从视频中提取3D手和物体的姿势,并提出了一种新的演示翻译方法,将人体运动转换为机器人演示。

-

然后,我们应用和比较基准多个模仿学习算法的演示。

-

我们表明,这些演示确实可以在很大程度上提高机器人的学习能力,并解决单独强化学习无法解决的复杂任务。

1. 简介

-

灵巧地操纵物体是人类与物理世界互动的主要手段。人类在各种各样的日常任务中进行着灵

文章来源:https://blog.csdn.net/gaoqing_dream163/article/details/135017632

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!