【机器学习】决策树

2023-12-23 22:45:40

参考课程视频:https://www.icourse163.org/course/NEU-1462101162?tid=1471214452

1 概述

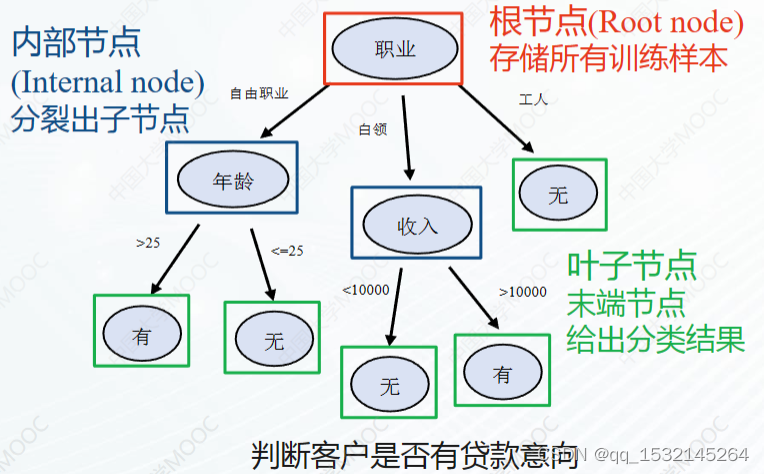

样子:

2 分裂

2.1 分裂原则

信息增益

信息增益比

基尼指数

3 终止 & 剪枝

3.1 终止条件

- 无需分裂

- 当前节点内样本同属一类

- 无法分裂

- 当前节点内所有样本的特征向量完全相同

- 采用任何特征都无法将当前样本集分为多个子类

- 无数据可分

- 当前节点内没有样本

3.2 剪枝

剪枝的目的:解决决策树过拟合现象(决策树规模大),提高决策树的泛化性能。

剪枝方法

- 前剪枝(预剪枝)

- 在决策树的生成过程中同步进行剪枝

- 在节点进行分裂前,对比节点分裂前后决策树的泛化性能指标,若泛化性能在分裂后得到提升,执行分裂;否则不执行分裂。

- 后剪枝

- 在决策树完全生成后逐步剪去叶子节点

- 常采用启发式方法从最深层的叶子节点或具有最高不纯度的

叶子节点开始剪枝 - 通过对比剪枝前后的泛化指标,决定是否剪去该叶子节点。

前剪枝 & 后剪枝 策略对比:

| 策略 | 时间 | 拟合风险 | 泛化能力 |

|---|---|---|---|

| 前剪枝 | 训练时间较少、测试时间较少 | 过拟合风险较低 、欠拟合风险较高 | 泛化能力一般 |

| 后剪枝 | 训练时间较长、测试时间较少 | 过拟合风险较低、欠拟合风险稳定 | 泛化能力较好 |

通常后剪枝比前剪枝保留的决策树规模更大。

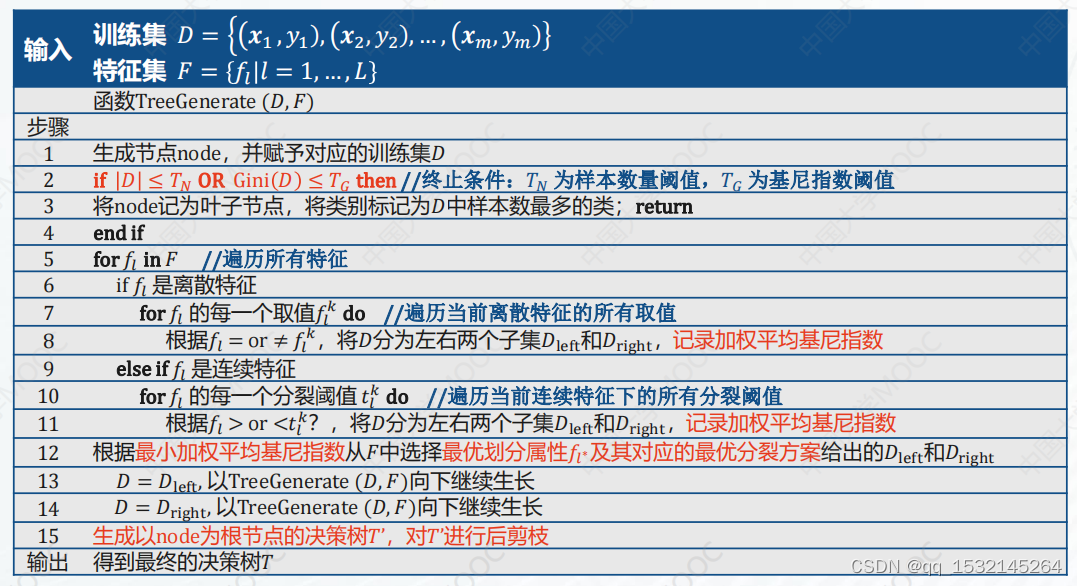

4 决策树算法

4.1 经典决策树算法

ID3

C4.5

CART(Classification And Regression Tree)

4.2 算法对比分析

| 算法 | 特征选择 | 剪枝 | 处理数据类型 | 树类型 |

|---|---|---|---|---|

| ID3 | 信息增益 | 无 | 离散 | 多叉树 |

| C4.5 | 信息增益比 | 前剪枝 | 离散、连续 | 多叉树 |

| CART | 基尼指数 | 后剪枝 | 离散、连续 | 二叉树 |

总结:

- CART的功能更全:分类、回归

- CART具有更好的泛化性能:二叉树,后剪枝。

- CART训练时间较长,计算开销较大。

- 信息增益、信息增益比和基尼指数各有利弊。

文章来源:https://blog.csdn.net/qq_1532145264/article/details/135149213

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!