LoRA模型原理

2023-12-22 07:06:24

1、LoRA基础原理

LoRA(Low-Rank Adaptation) ,也叫低秩适配器,是一种用于迁移学习的方法;

通过低秩适应矩阵来调整源领域和目标领域之间的特征表示;

形象的解释是:

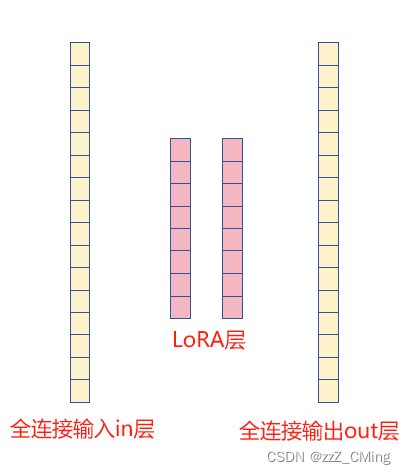

在LLM大模型的训练中,两个全连接层的神经元个数可能非常大,比如上图的全连接in层、out层各有10,000个神经元,那么在全参数训练中就有10,000 * 10,000个参数需要迭代;

而插入的 LoRA 层是一个维度非常小的低秩矩阵,比如维度是32 * 32,那现在的计算参数就等于10,000 * 32 * 2 + 32 * 32,大大缩小了训练参数的个数;

LoRA 层就好比是“中介”,将买家与卖家(in层与out层)各自的需求进行汇总,在“中介”内部完成信息交换,加快匹配速度。

2、LoRA层的参数解析

from peft import LoraConfig, get_peft_model

config = LoraConfig(

r=64,

target_modules=target_modules,

lora_alpha=16,

lora_dropout=0.05,

fan_in_fan_out=False,

bias="none",

modules_to_save=None,

)

常用参数解析:

- r (

int) :低秩矩阵的维度,通常是4、8、16、32、64; - target_modules (

Union[List[str],str]):添加lora的目标模块名称; - lora_alpha (

int):缩放参数,控制低秩矩阵的适应程度——越小的值对模型参数进行压缩的越强烈,可能会影响模型性能;越大的值,则减轻了对模型参数的压缩,可能保留了更多的模型性能。不同的模型可能有不同的默认值和具体用法; - lora_dropout (

float):防止过拟合的dropout; - fan_in_fan_out (

bool):是否将层的存储形式替换成 (fan_in, fan_out) 的样子,默认为False; - bias (

str):是否添加偏置。参数选择为:[“none”,“all”,“lora_only”]。如果为"all"或"lora_only",则相应的偏差将在训练期间更新; - modules_to_save (

List[str]):要在训练过程中保存的模块列表,默认为None 表示不保存;

除此之外还有以下不常用的参数:

- layers_to_transform (

Union[List[int],int]): - layers_pattern (

str): - rank_pattern (

dict): - alpha_pattern (

dict):

文章来源:https://blog.csdn.net/zzZ_CMing/article/details/135141992

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!