“机器人V2.0时代已来”-任务规划难题迎刃而解,世界因机器人改变而翻转!

01-VILA背景简介

2022年,Michael Ahn, Anthony Brohan等人提出“Do as i can, not as i say: Grounding language in robotic affordances”算法。本文指出虽然大型语言模型可以编码关于世界的丰富语义知识,而这些知识对旨在对用自然语言表达的高级、时间扩展指令采取行动的机器人非常有用,但是语言模型的一个显著弱点是缺乏上下文基础,这使得在给定的现实世界上下文中很难利用它们进行决策。例如,要求语言模型描述如何清洁泄漏可能会产生合理的叙述,但它可能不适用于需要在特定环境中执行此任务的特定代理,如机器人。作者建议通过预先训练的行为来提供这种基础,这些行为用于调节模型,以提出既可行又适合上下文的自然语言动作。机器人可以充当语言模型的“手和眼睛”,而语言模型提供有关任务的高级语义知识。

2023年,Wenlong Huang, Fei Xia等人提出“ Grounded decoding: Guiding text generation with grounded models for robot control”算法。大型语言模型(LLM)的最新进展表明,通过使用自回归模型进行预训练,可以学习和利用互联网规模的知识。不幸的是,将这种模型应用于具有具体代理的环境(如机器人)是具有挑战性的,因为它们缺乏物理世界的经验,无法解析非语言观察结果,并且不知道机器人可能需要的奖励或安全约束。另一方面,从交互数据中学习的基于语言的机器人策略可以提供必要的基础,使代理能够正确地位于现实世界中,但由于可用于训练它们的交互数据的广度有限,这种策略受到缺乏高级语义理解的限制。因此,如果我们想利用语言模型中的语义知识,同时仍将其置于具体环境中,就必须构建一个既可能根据语言模型,又可以根据环境的基础模型实现的动作序列。作者将其定义为一个类似于概率滤波的问题:解码一个在语言模型下具有高概率和在一组基础模型目标下具有高可能性的序列。

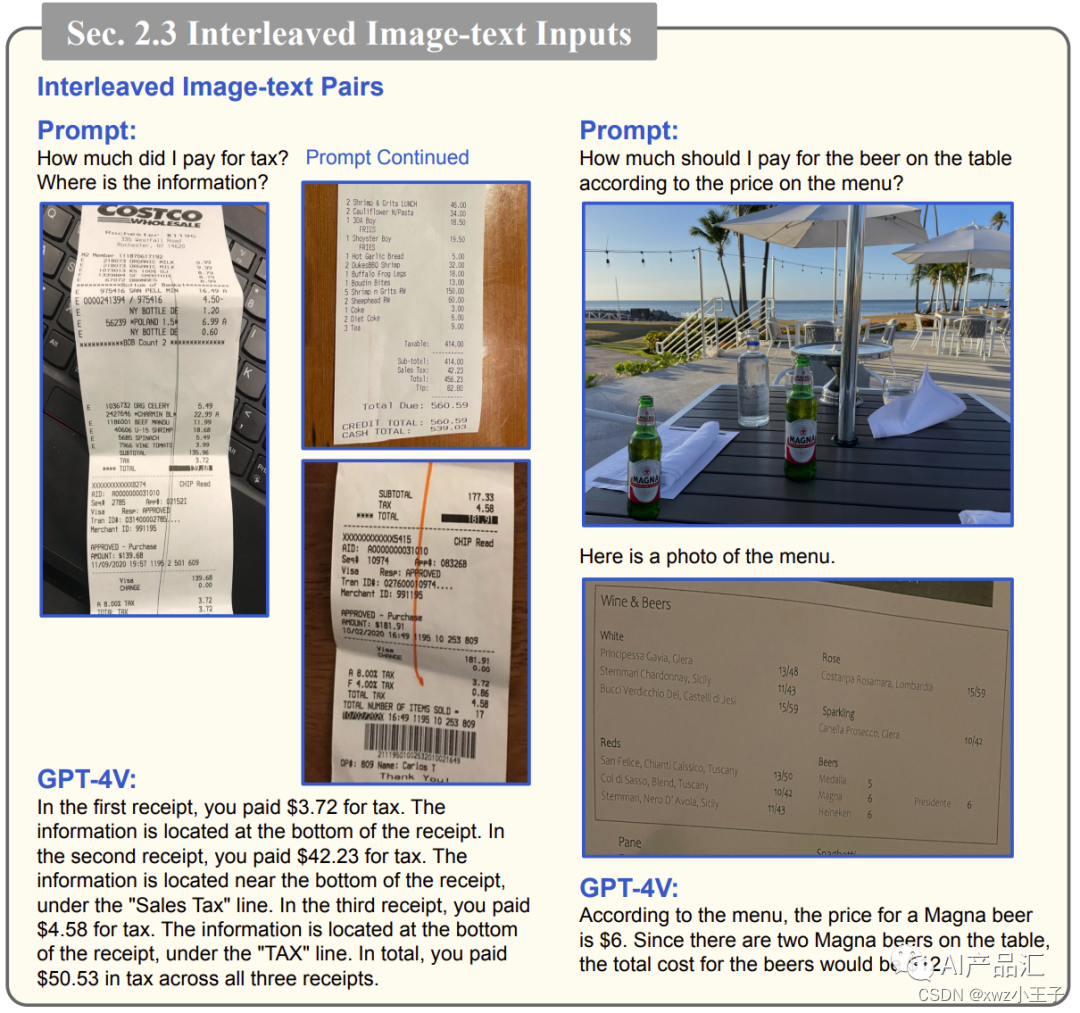

2023年Zhengyuan Yang等人提出“The Dawn of LMMs: Preliminary Explorations with GPT-4V(ision)”算法。本文分析了最新的模型GPT-4V来加深大家对LMM的理解。分析的重点是GPT-4V可以执行的有趣任务,包括测试样本,以探测GPT-4V功能的质量和通用性、其支持的输入和工作模式,以及提示模型的有效方法。在探索GPT-4V的方法中,作者策划和组织了一系列精心设计的定性样本,涵盖各种领域和任务。对这些样本的观察结果表明,GPT-4V在处理任意交织的多模式输入方面前所未有的能力及其能力的通用性使GPT-4V成为一个强大的多模式通才系统。此外,GPT-4V理解输入图像上绘制的视觉标记的独特能力可以产生新的人机交互方法,如视觉参考提示。

02-VILA算法简介

对于现实场景中的机械臂而言,学习并理解任务规划能力是一件比较复杂的任务。最近的进展表明,大型语言模型(LLM)拥有广泛的知识,可用于机器人任务,特别是在推理和规划任务中。然而,由于LLM缺乏世界基础和依赖外部可供性模型来感知环境信息而受到限制。作者认为,任务规划器应该是一个固有的、统一的多模式系统。

本文介绍了机器人视觉语言规划(ViLa),它是一种简单有效的远程机器人任务规划方法,它利用视觉语言模型(VLM)生成一系列可操作的步骤。ViLa将感知数据直接集成到其推理和规划过程中,从而能够深入理解视觉世界中的常识知识,包括空间布局和对象属性。它还支持灵活的多模式目标规范,并自然地包含视觉反馈。ViLa可以在现实世界和模拟环境中解决各种复杂的长期任务。真实模拟环境中进行大量评估结果表明,ViLa优于现有的基于LLM的规划者,突出了其在一系列开放世界操作任务中的有效性。

03-VILA算法流程

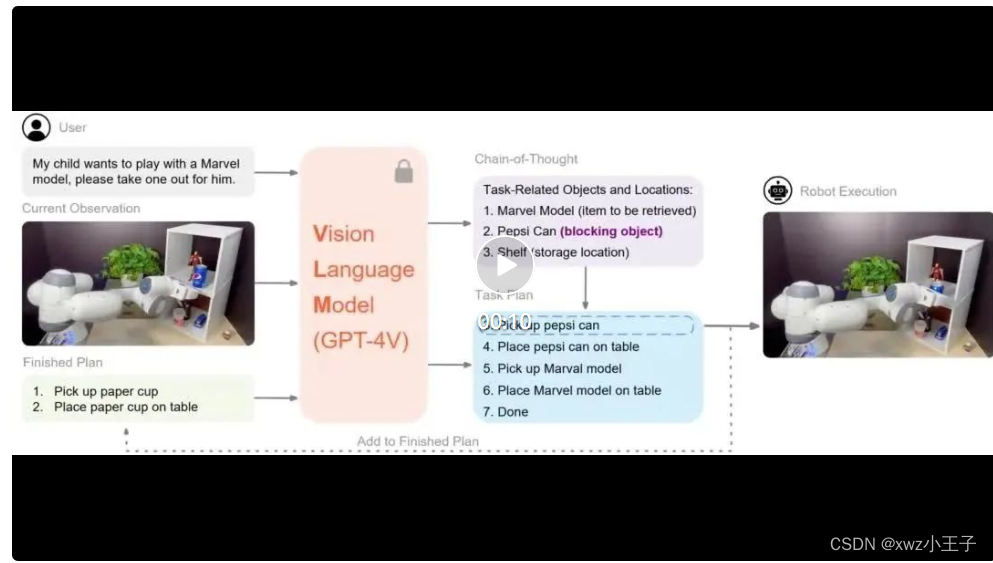

上图展示了VILA算法的整体流程,详细的步骤如下所述:

首先,将用户的指令和当前的视觉观察图像送入GPT-4V大模型中,作者利用VLM(GPT-4V)通过思维链推理来理解环境场景;

然后,利用GPT-4V生成一系列可操作的步骤,如图中的任务相关的目标与位置信息;

接着,这个计划的第一步由一个基本策略执行,在该策略的基础上生成接下来的任务规划策略,如图中的3~7所示;

最后,将已执行的步骤添加到完成的计划中,从而实现动态环境中的闭环规划方法,具体的操作步骤由机械臂来执行。

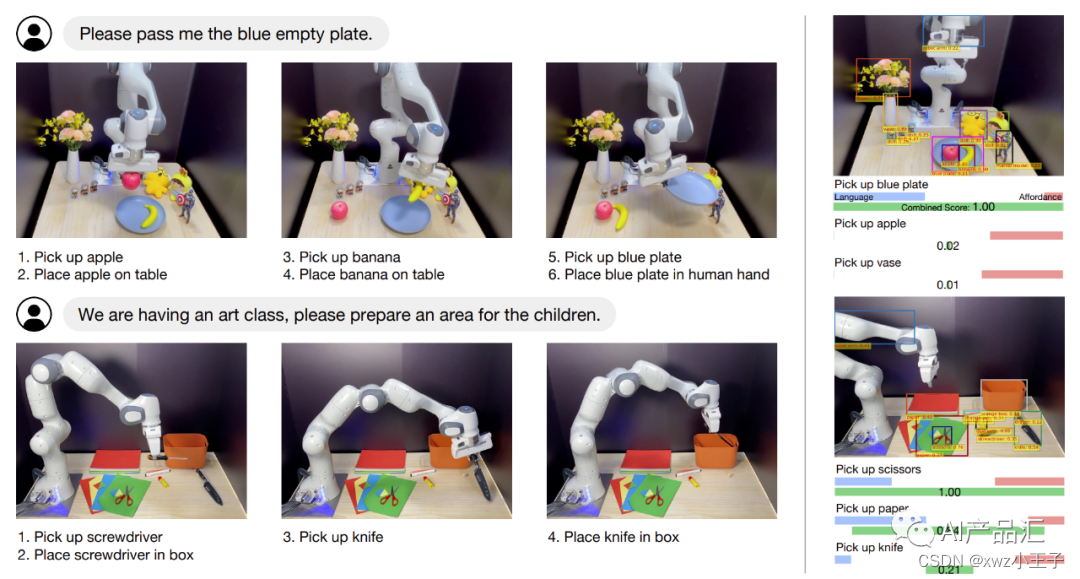

上图展示了VILA的执行说明(左)和SayCan的决策过程说明(右)。在“拿来空盘子”任务中,机器人必须首先针对蓝色盘子中的苹果和香蕉执行重新定位操作;然而,SayCan的第一步是直接拿起蓝色的盘子。在准备艺术课任务中,当剪刀应该放在桌子上时,SayCan错误地拿起剪刀并将其放在盒子里。

04-VILA算法应用场景

04.01-理解视觉世界中的常识

ViLa擅长了解空间布局或对象属性的复杂任务。这种常识性知识几乎渗透到机器人领域的每一项感兴趣的任务中,但以前基于LLM的规划者在这方面一直做不到。

04.02-理解各种视觉目标

ViLa支持灵活的多模式目标规范方法。它不仅能够利用语言指令,而且能够利用各种形式的目标图像,甚至能够融合语言和图像,来有效地定义目标。

04.03-理解视觉反馈

ViLa以直观自然的方式有效利用视觉反馈知识,在动态环境中实现稳健的闭环规划。

04.04-模拟仿真实验

上图展示了ViLa可以按照高级语言指令指定的某些所需配置重新排列表上的对象。

05-VILA算法性能评估

05.01-主观效果评估

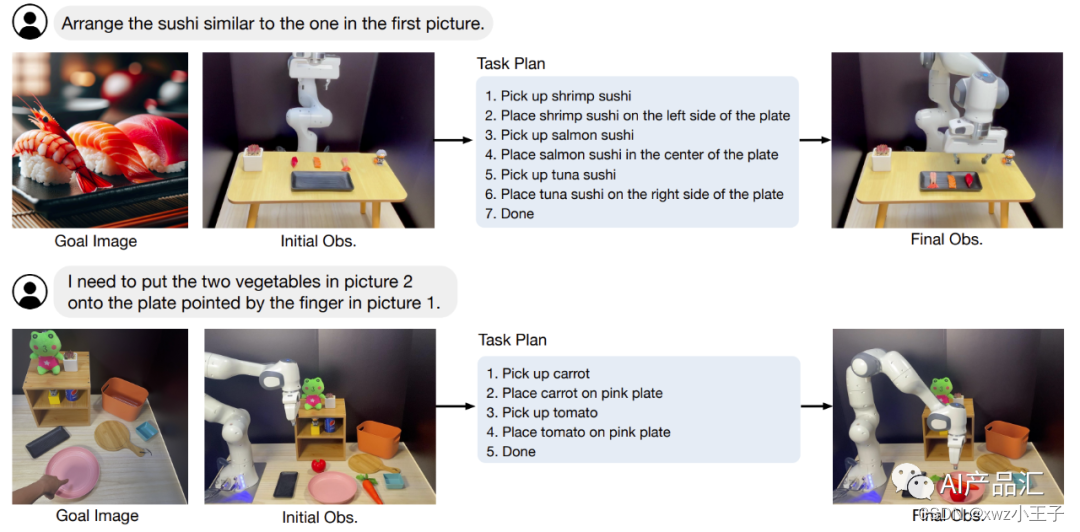

上图展示了VILA在图像目标条件任务上的执行效果。在“排列寿司”任务中,VILA根据参考图像生成排列寿司的计划。在“挑选蔬菜”任务中,场景涉及一张桌子,桌子上有一个粉色盘子、一个黑色寿司盘子、一块披萨盘子和一个绿色小吃盘子。在这里,VILA从进球图像中的手指推断出蔬菜应该放在粉红色的盘子上。

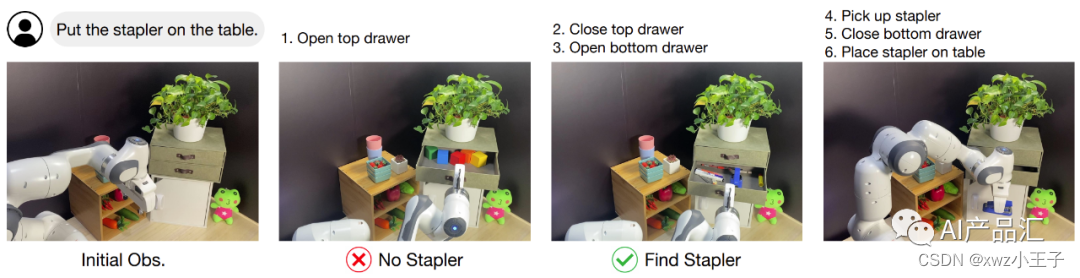

上图展示了VILA在“查找装订器”任务上的执行效果。通过在每个步骤结合视觉反馈和重新规划,当VILA在顶部抽屉中没有找到缝合器时,它能够继续探索底部抽屉,从而成功地定位缝合器。

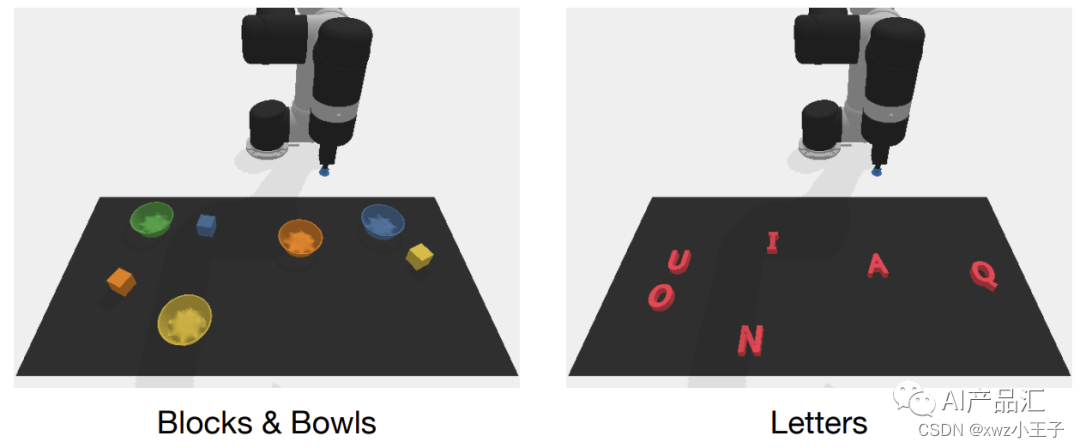

上图展示了VILA算法在基于RAVENS的模拟环境中的执行效果。作者设计了16个不同的任务,分为两类:方块和保龄球(左)和字母(右)。更详细的效果请看效果展示部分。

05.02-客观指标评估

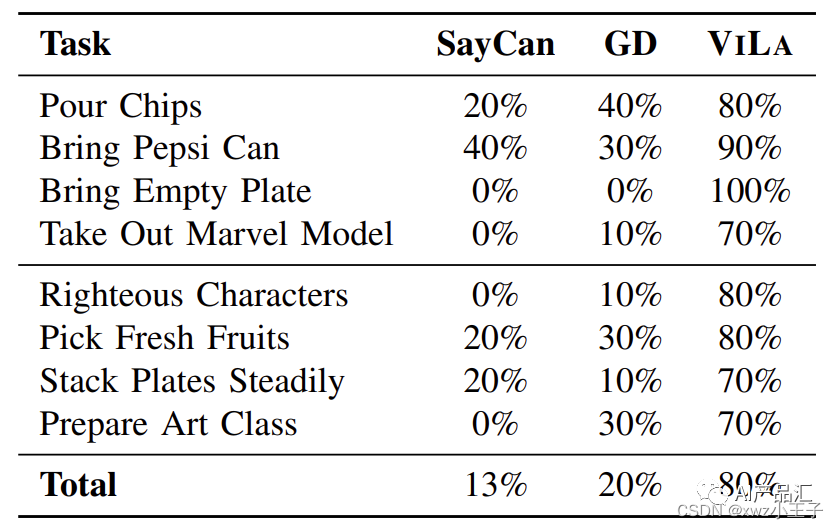

上表展示了多个STA算法在需要丰富的常识性知识的评估任务上面的效果。tong通过观察与分析,我们可以发现:VILA在需要了解空间布局(上半部分)和对象属性(下半部分)的任务中表现出卓越的性能。

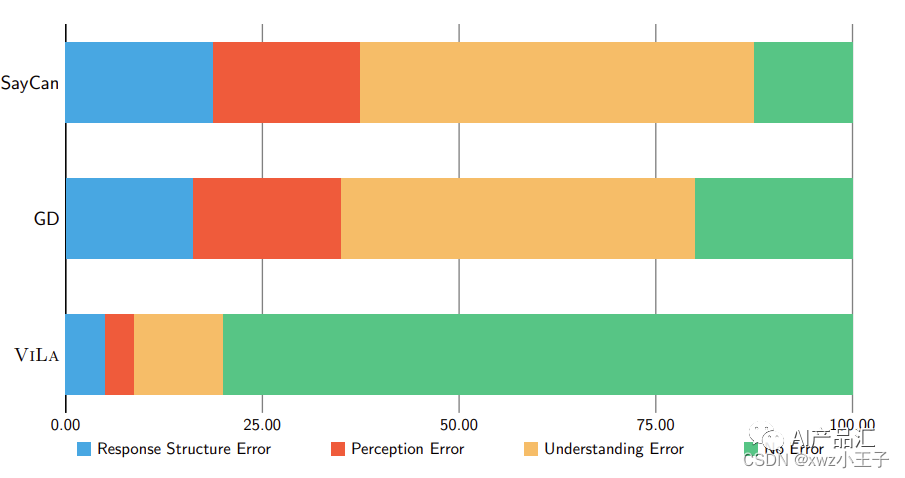

上图展示了VILA和基线算法的一些错误类型。通过利用基于视觉世界的常识性知识,VILA显著减少了理解错误的比例。

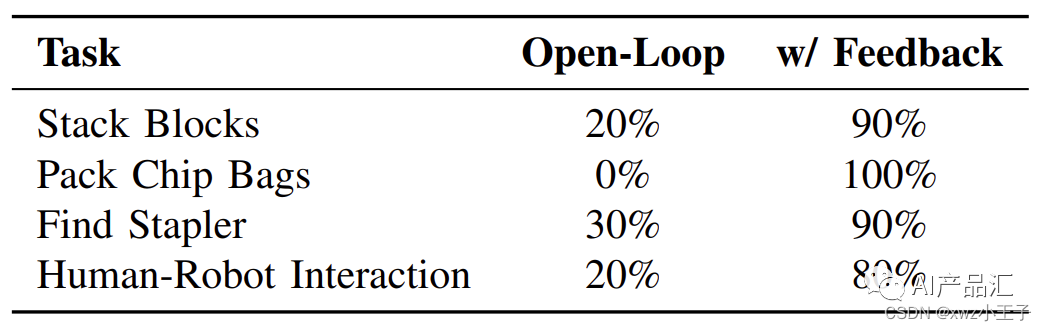

上表展示了开环VILA与闭环VILA在多个不同任务上面的执行效果。通过利用视觉反馈,闭环VILA的效果显著优于开环变体。

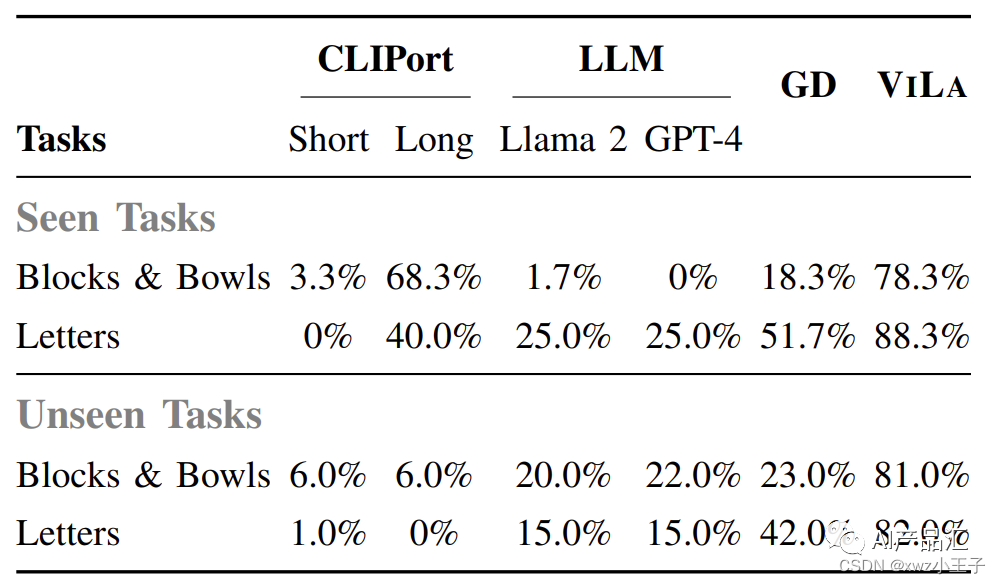

上表展示了多个STA算法在在见过和未见过的模拟环境中的平均成功率。

通过观察与分析,我们可以得出以下的初步结论:VILA在可见和不可见任务中始终优于其它基线方法。

06-VILA算法效果展示

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!