Llama2-Chinese-7b-Chat安装部署

2023-12-13 13:08:14

前言

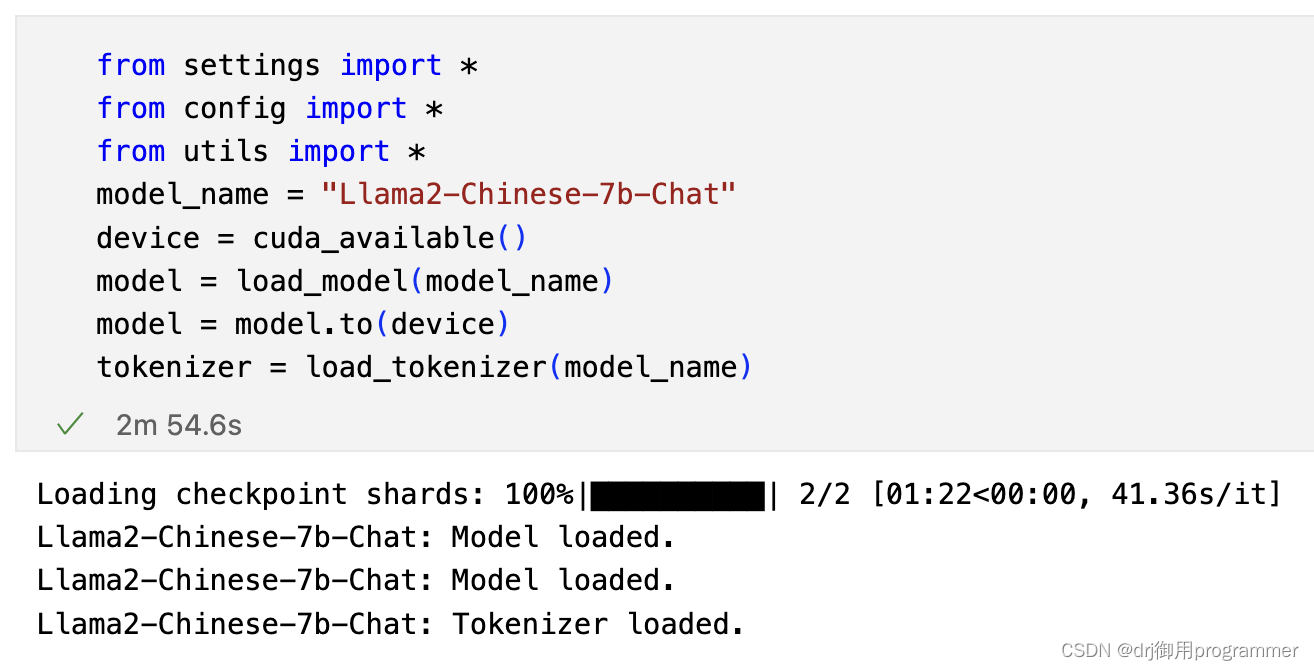

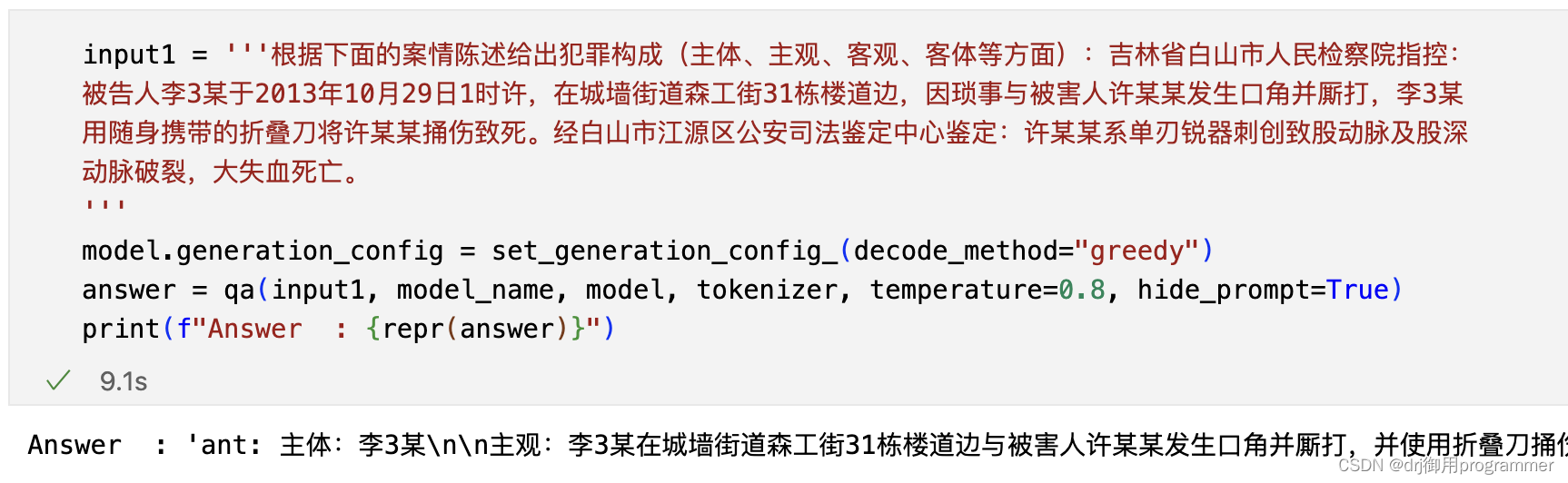

本文主要介绍如何使用Llama2-Chinese-7b-Chat,最后的效果如图所示:

一、文件介绍 📁

?? 下载地址:https://pan.baidu.com/s/1smUeYoocrPzwPdjyKpawYg?pwd=22vx 提取码: 22vx

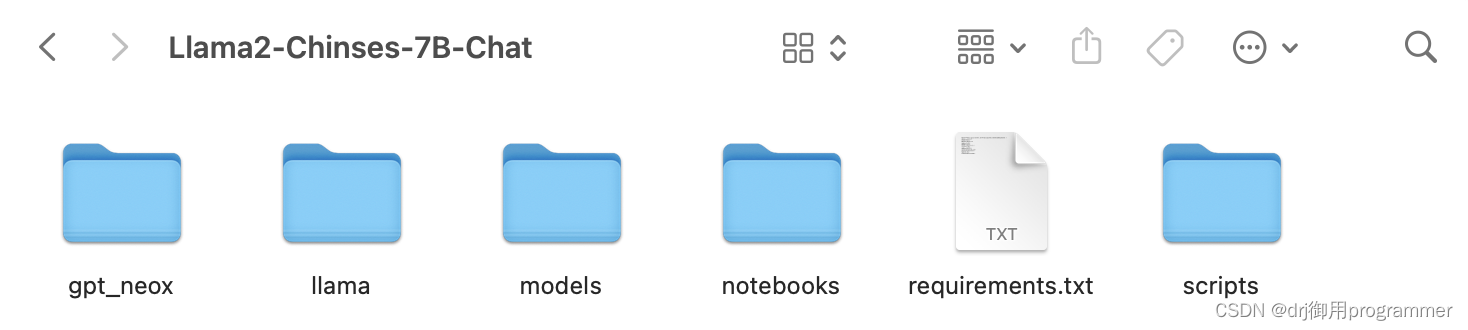

📁 Llama2-Chinses-7B-Chat文件夹中的具体内容如下图所示:

二、环境配置 ?

使用的是服务器,版本为NVIDIA GeForce RTX 4090,内存为24GB。

选择的Python版本为3.8.16,Anaconda版本为4.9.2。

| 库名 | 版本 |

|---|---|

| transformers | 4.30.2 |

| torch | 1.13.1+cu117 |

| baukit | 0.01 |

| pandas | 1.5.3 |

详情可见requirements.txt。环境配置步骤如下代码所示:

conda create -n test python=3.8.16 -y

source activate test

pip install -r requirements.txt

cd Llama2-Chinses-7B-Chat

三、Llama2-Chinese-7b-Chat下载 ?

Llama2-Chinese-7b-Chat的下载地址是Llama2-Chinese-7b-Chat,可以通过下面的代码进行快速下载?,但是需要事先安装好git lfs。

cd ..

cd models

url="https://huggingface.co/FlagAlpha/Llama2-Chinese-7b-Chat"

folder="Llama2-Chinese-7b-Chat"

rm -rf "$folder"

while true; do

git lfs clone $url

if [ $? -eq 0 ]; then

echo "$url weight successfully downloaded."

break

else

echo "$url download failed; retrying..."

fi

rm -rf "$folder"

sleep 10s

done

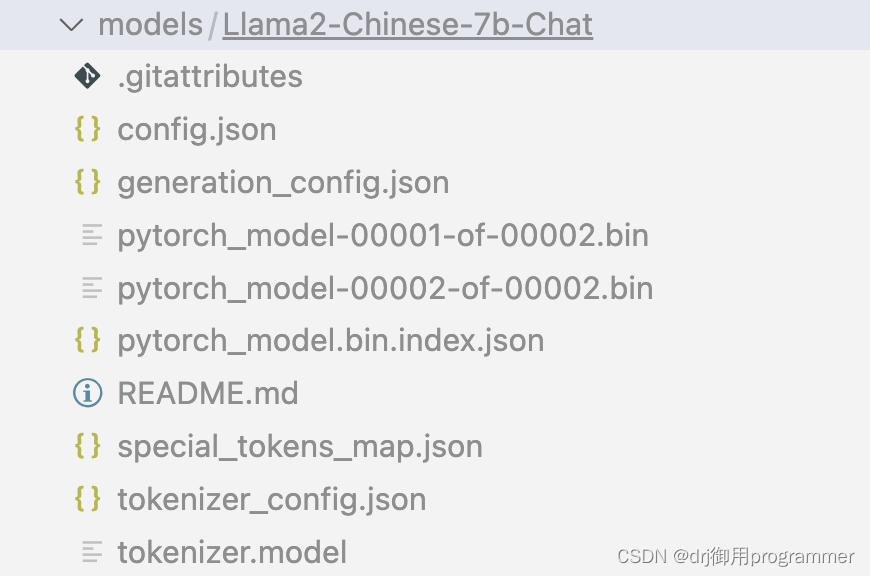

可以直接进入scripts文件夹sh download_models.sh进行安装。下载之后的models目录如下图所示。

—

—

总结

Llama2-Chinese-7b-Chat对于中文的问题回答能力优秀,希望大家可以通过我的分享来测试它??????

文章来源:https://blog.csdn.net/weixin_45734379/article/details/134964837

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!