chatglm3本地部署(综合Demo版本)教程

2023-12-25 12:32:07

1.下载代码

我是在本地c盘中,创建了一个glm3文件夹,然后把代码拉到这个文件夹里,所以在clone之前,需要在cmd中,把路径切换到glm3文件夹下,然后执行如下代码。

git clone https://github.com/THUDM/ChatGLM3

2.模型下载

https://modelscope.cn/models/ZhipuAI/chatglm3-6b/files

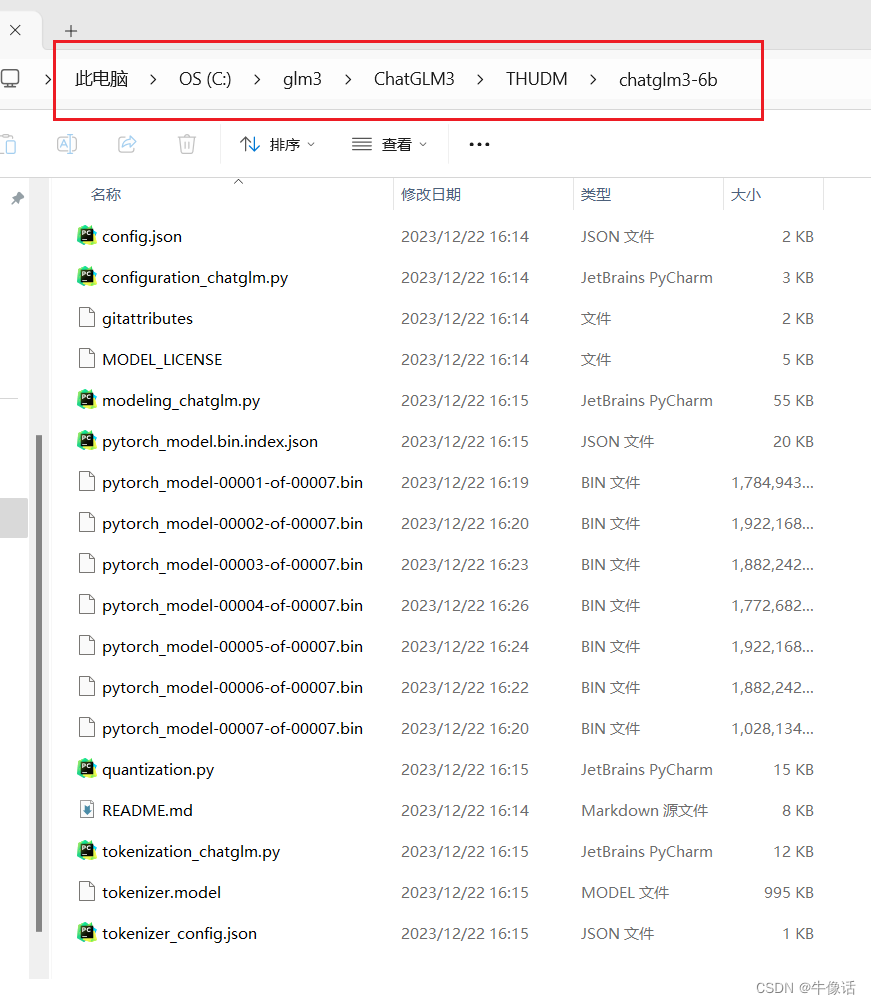

所有内容都需要下载,下载完成后,放入如下地址

3.环境配置

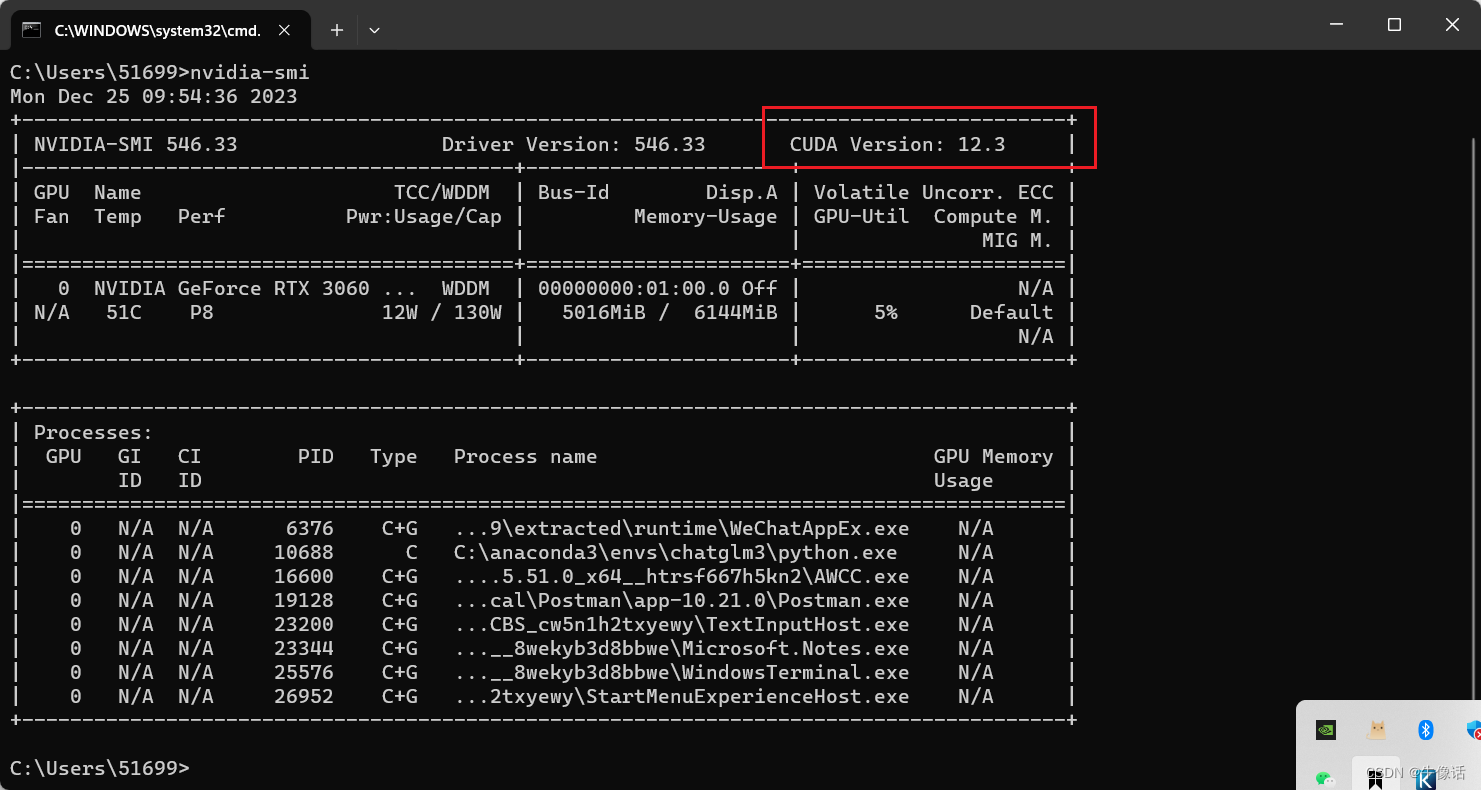

首先检查自己gpu的cuda版本,在cmd中使用nvidia-smi命令

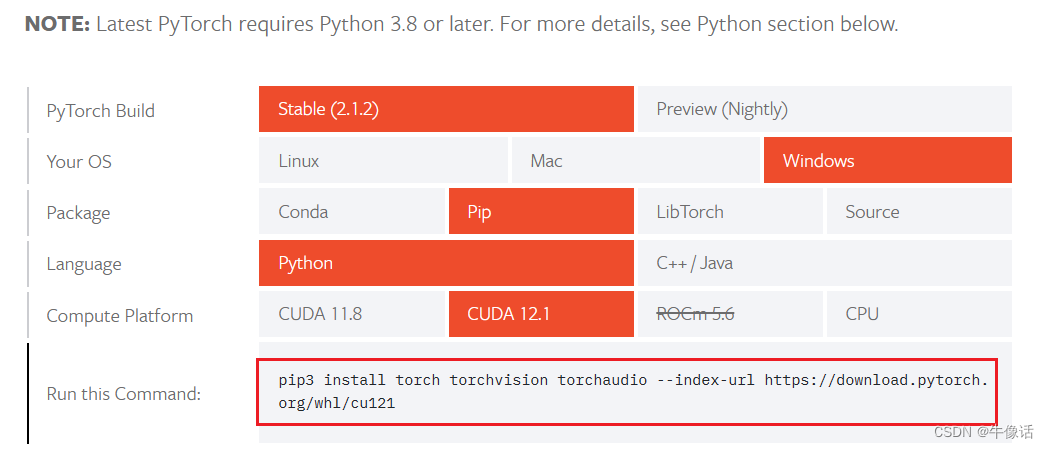

我的是12.3,然后到https://pytorch.org/get-started/locally/中,选取适合自己的torch版本,我的选择如下图

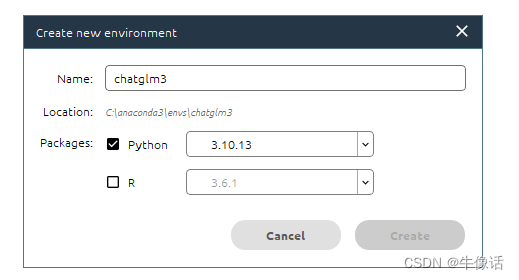

接着使用Anaconda Navigator创建一个conda环境

没有Anaconda Navigator 的,可以使用命令行创建一个

conda create -n chatglm3 python==3.10.13

激活conda环境

activate chatglm3

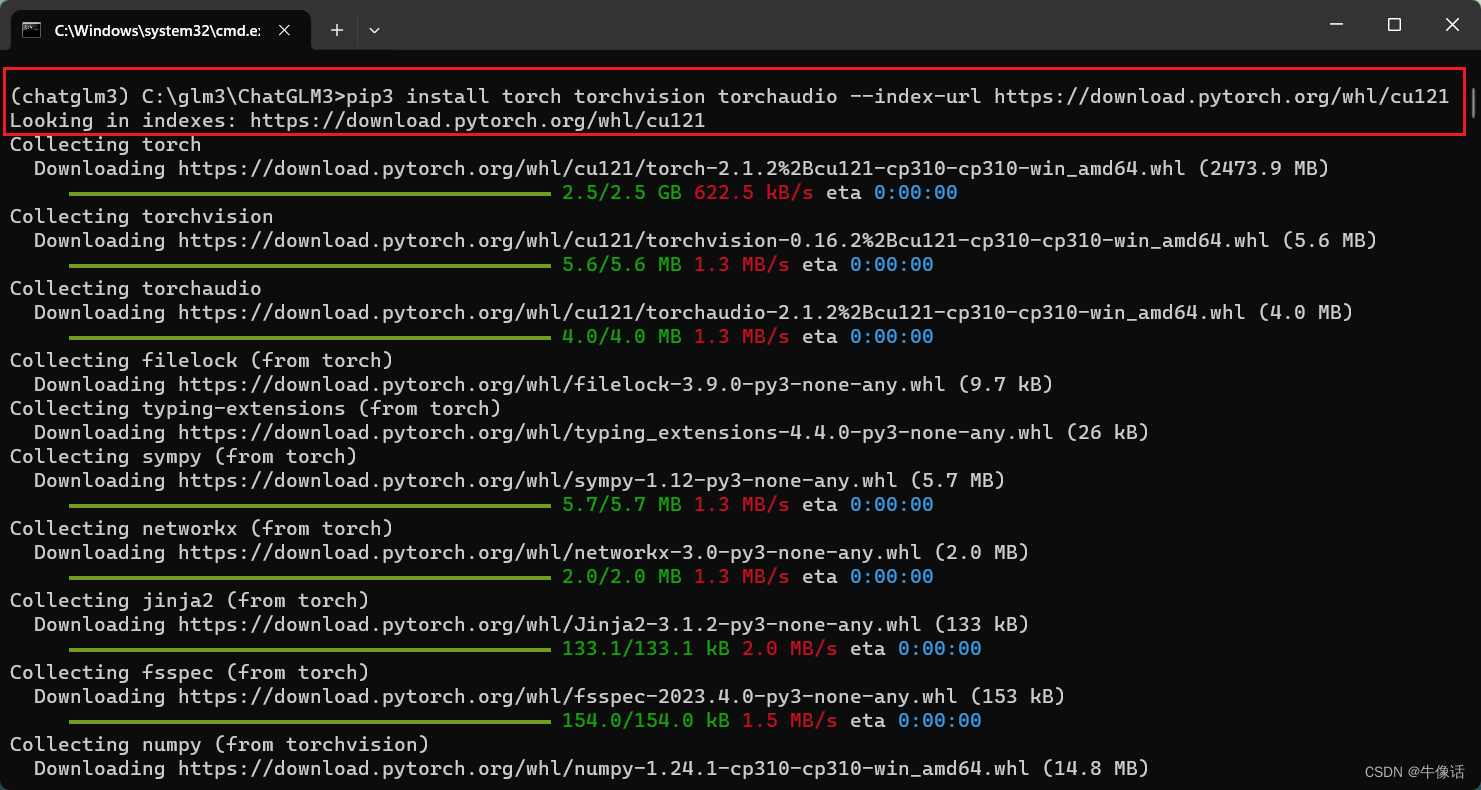

使用上面torch官网图中红框里的代码,安装torch

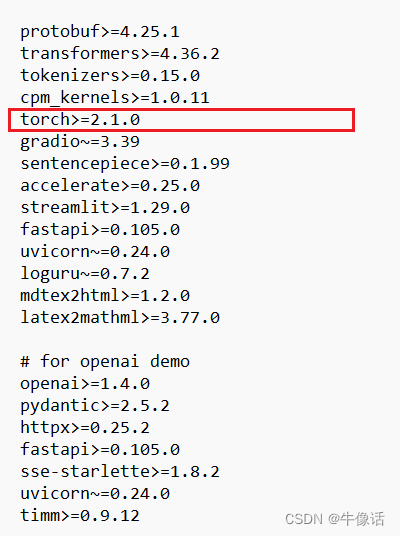

接下来打开ChatGLM3中的requirements.txt文件,找到里面的torch信息,删除红框中的这一行,因为直接使用这里面的torch,下载的是cpu版本,所以我们上面就自己手动下载了GPU版本。

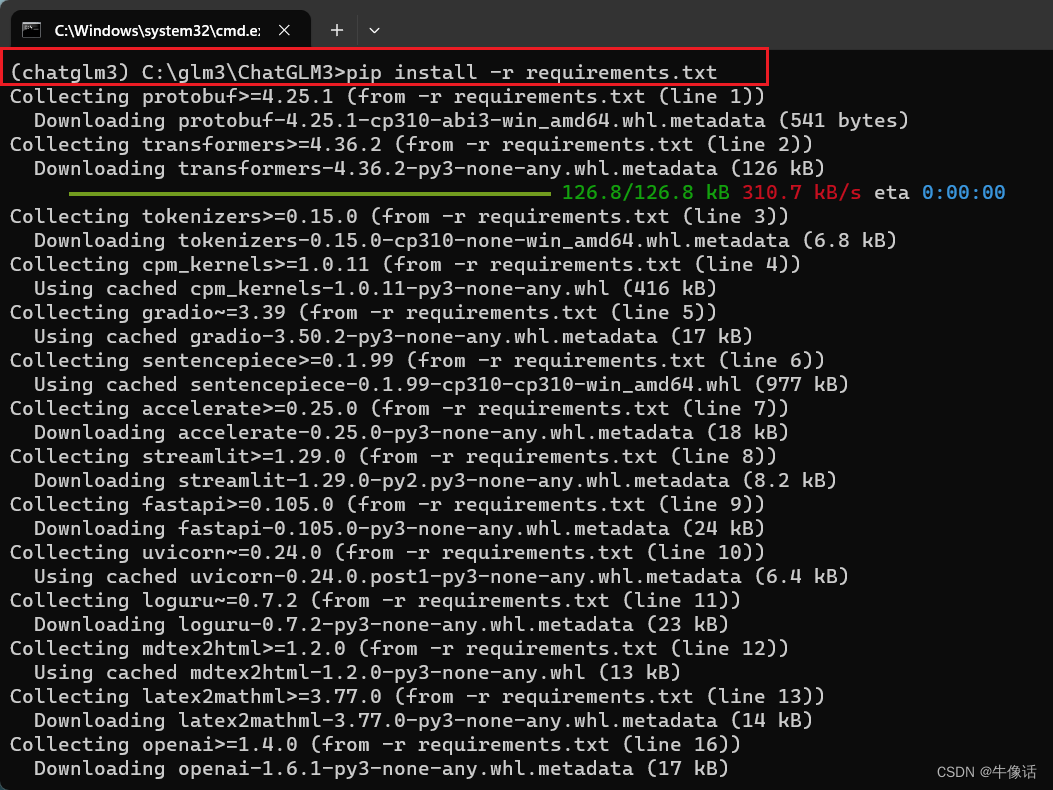

删除完成后在ChatGLM3目录下,执行

pip install -r requirements.txt

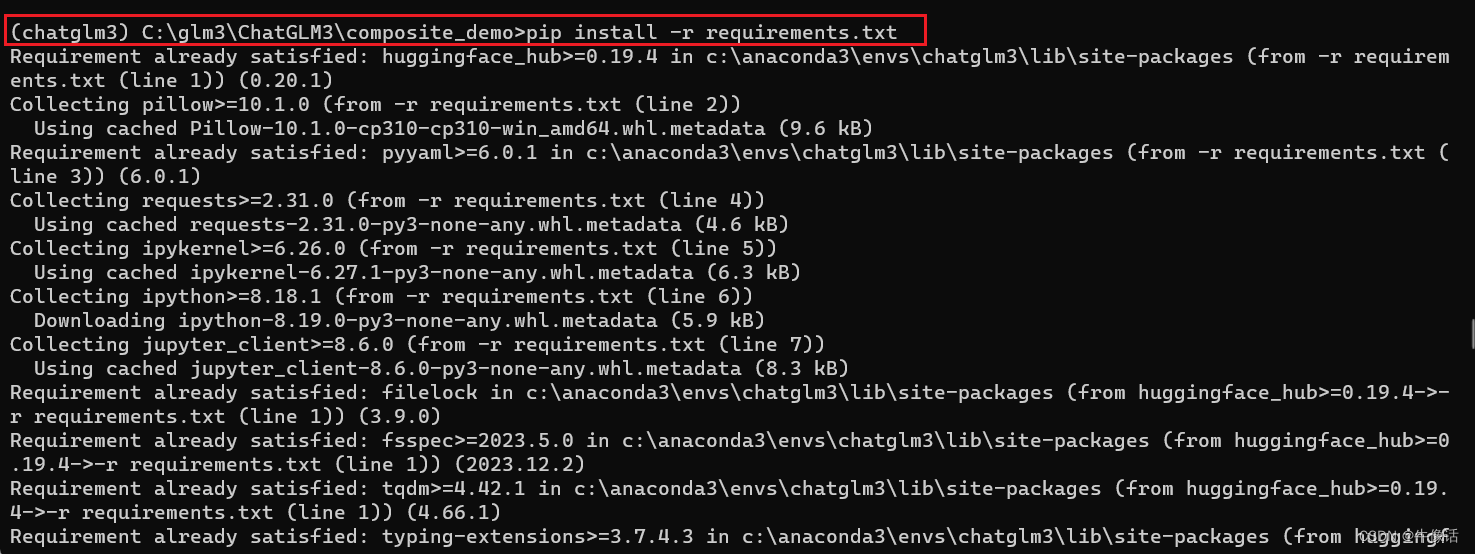

其实到这里,已经可以运行普通的demo了,但是我们的目标是运行综合Demo,所以我们需要进到composite_demo目录下,然后安装里面的包。

pip install -r requirements.txt

然后执行

ipython kernel install --name chatglm3-demo --user

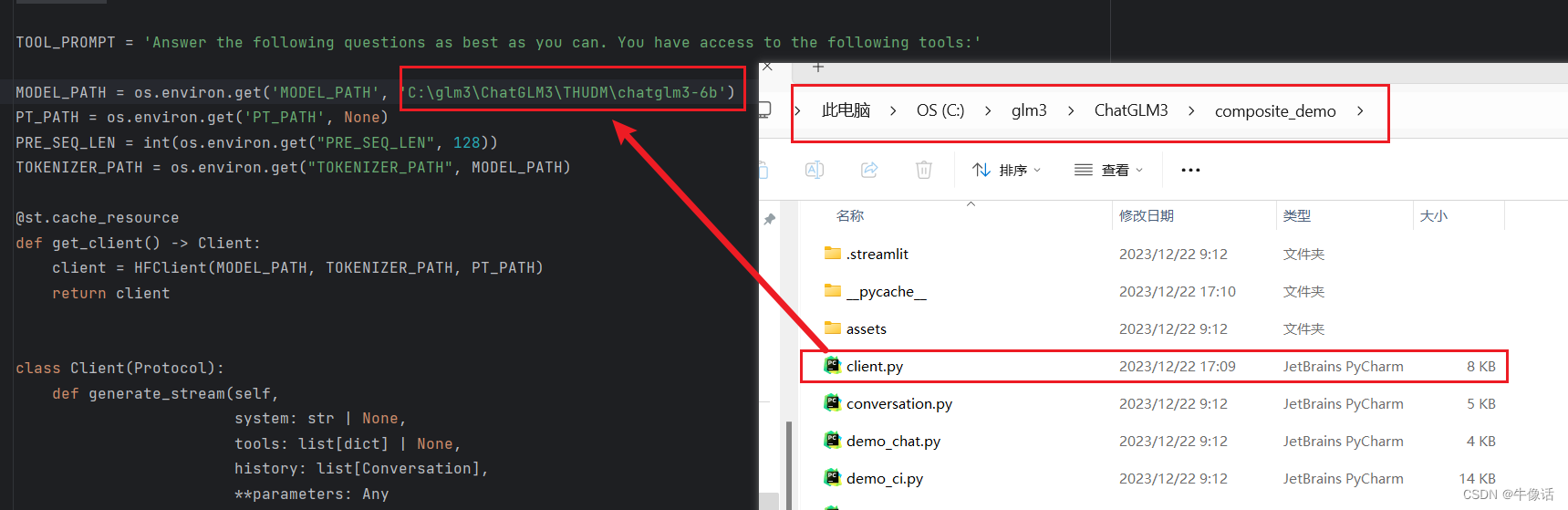

接着需要修改一下client里地址,把地址改成本地模型所在地址,也就是上面下载模型放的位置。

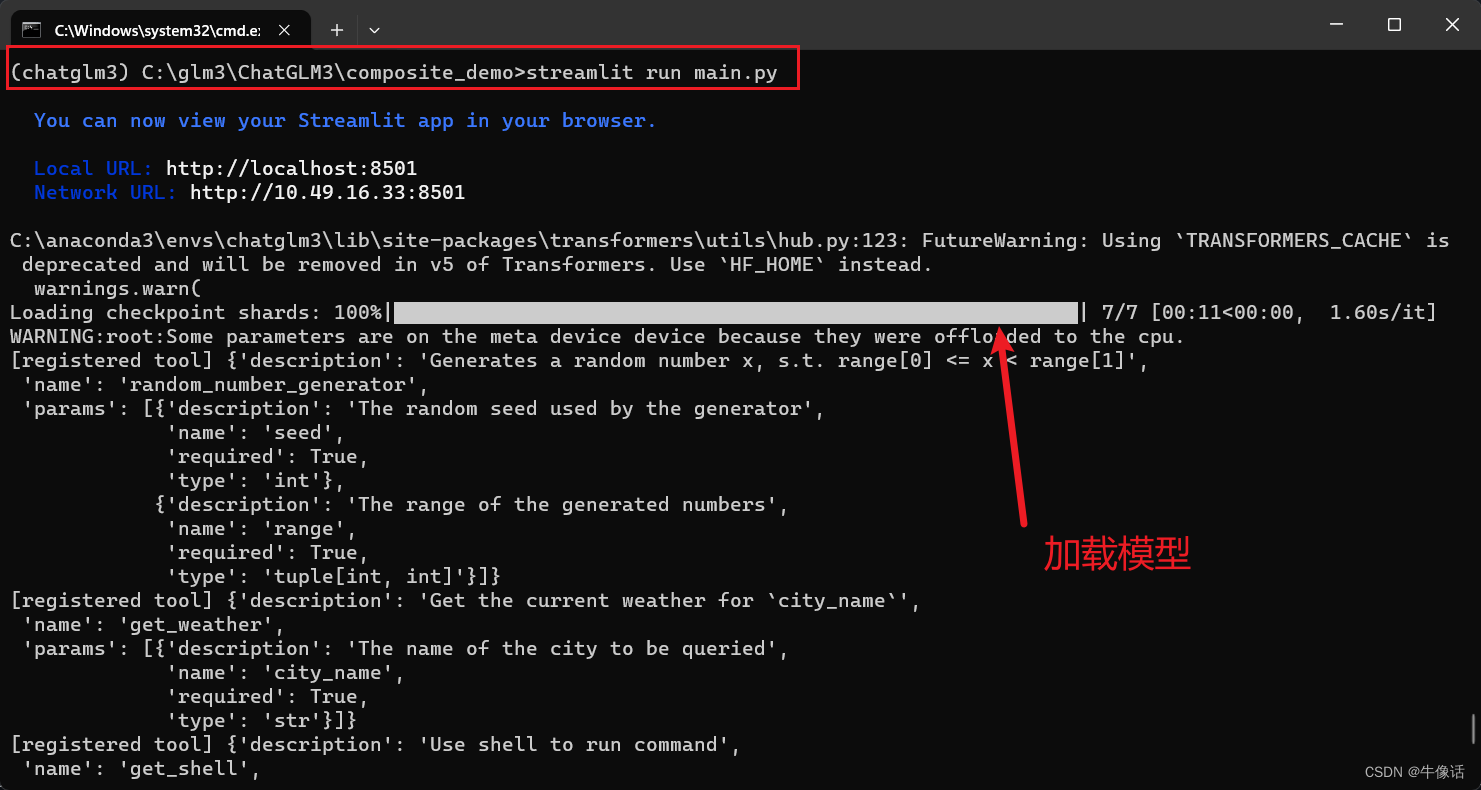

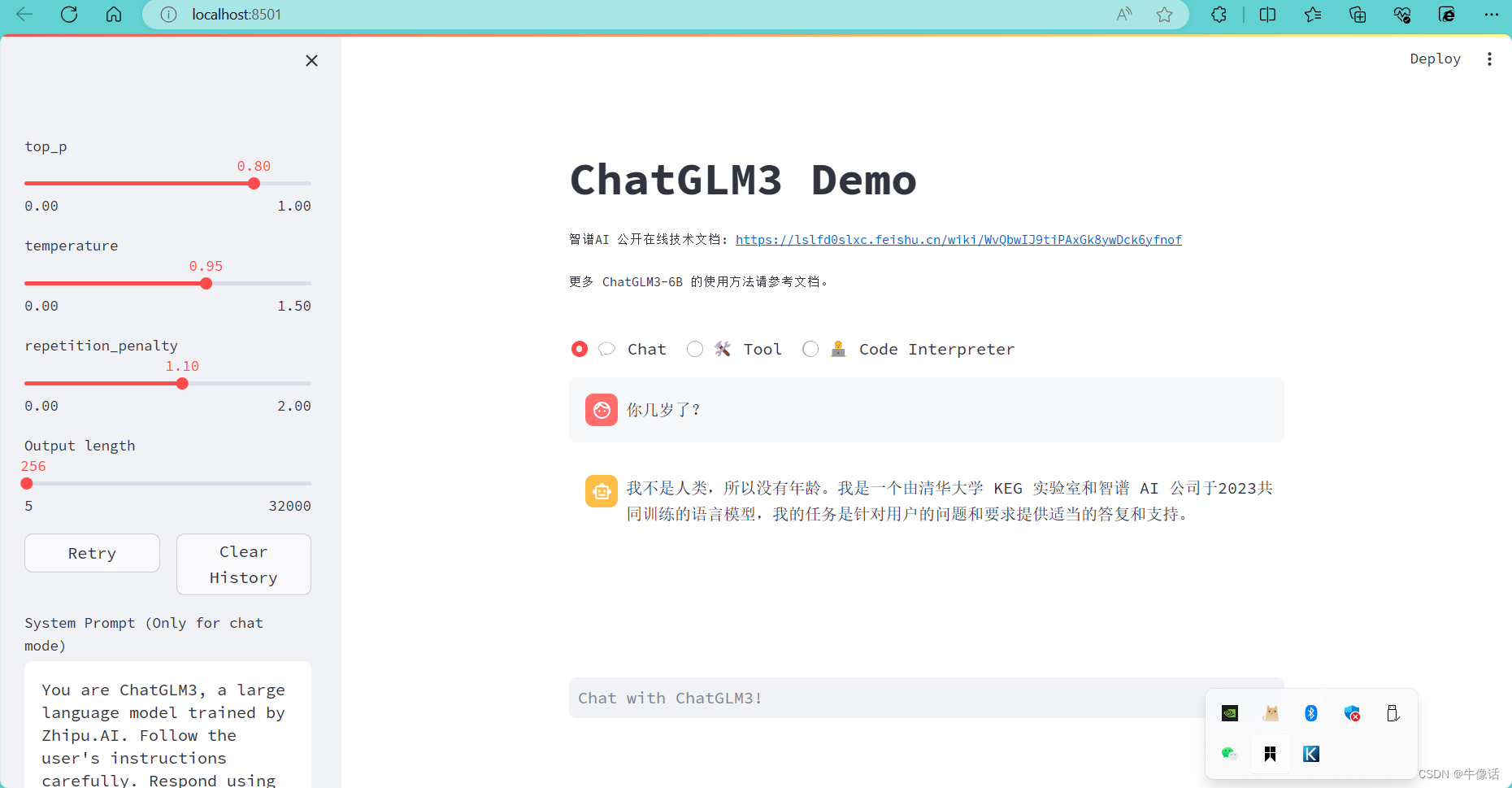

一切都没有问题的话,最后执行

streamlit run main.py

访问控制台中的地址

文章来源:https://blog.csdn.net/weixin_42596778/article/details/135192585

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!