软件工程期末复习+数据仓库ETL

一、软件工程

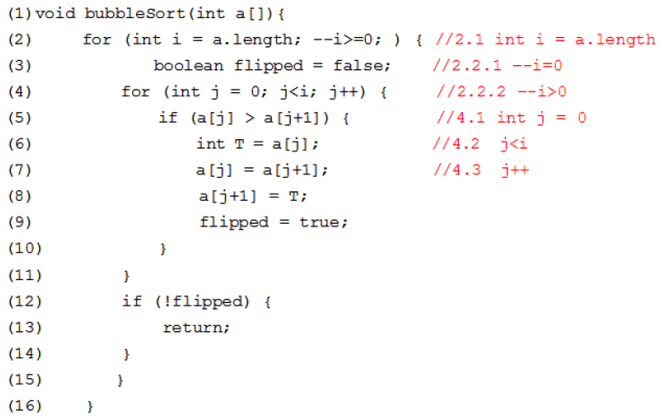

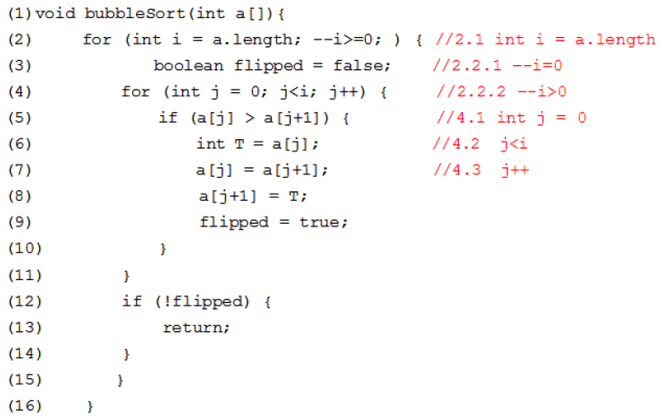

请用基本路径测试方法为下列程序设计测试用例,并写明中间过程:

第1步:画出流程图

1.菱形用于条件判断。用在有分支的地方。

2.矩形表示一个基本操作。

3.圆形是连接点

第2步:计算程序环路复杂性

流图G的环路复杂度V(G)定义为:V(G)=E-N+2 (E为流图中的边数量,N为流图中的节点数量)。

V(G)也可以定义为:V(G)=P+1 其中:P为流图中的判断节点数量。

第3步:给出独立路径集

需要注意的是:路径集对每个循环至多只执行一次,所以第2次不会进入已经进入过的循环中。

(1)2.1 - 2.2.1 - 2.2.2 - 15 - 16

表示不满足i-1后大于等于0,即i-1后小于0,于是直接15,16退出。

(2)2.1 - 2.2.1 - 3 - 4.1 - 4.2 - 12 - 13 - 16

表示i-1后等于0,即i原本为1,即数组中只有1个数,i-1后i值为0,因为j=0,所以不满足j<i,直接退出循环,直接进入12,13,16退出

(3)2.1 - 2.2.1 - 2.2.2 - 3 - 4.1 - 4.2 - 5 - 10 - 4.3 - 4.2 - 12 - 13 - 16

(4)2.1 - 2.2.1 - 2.2.2 - 3 - 4.1 - 4.2 - 5 - 10 - 4.3 - 4.2 - 12 - 2.2.1 - 2.2.2 - 15 - 16

(5)2.1 - 2.2.1 - 2.2.2 - 3 - 4.1 - 4.2 - 5 - 6,7,8,9 - 10 - 4.3 - 4.2 - 12 - 13 - 16

(6)2.1 - 2.2.1 - 2.2.2 - 3 - 4.1 - 4.2 - 5 - 6,7,8,9 - 10 - 4.3 - 4.2 - 12 - 2.2.1 - 2.2.2 - 15 - 16

第4步:测试用例

(1)输入空值

(2)输入只有一个元素的数组,比如数组[3]

(3)输入升序排序的数组,比如数组[2,3,6,9]

(4)同样也是输入升序排序的数组,比如数组[2,3,6,9]

(5)输入数组[1,5,2]

(6)输入降序排序的数组,比如数组[9,5,3,2]

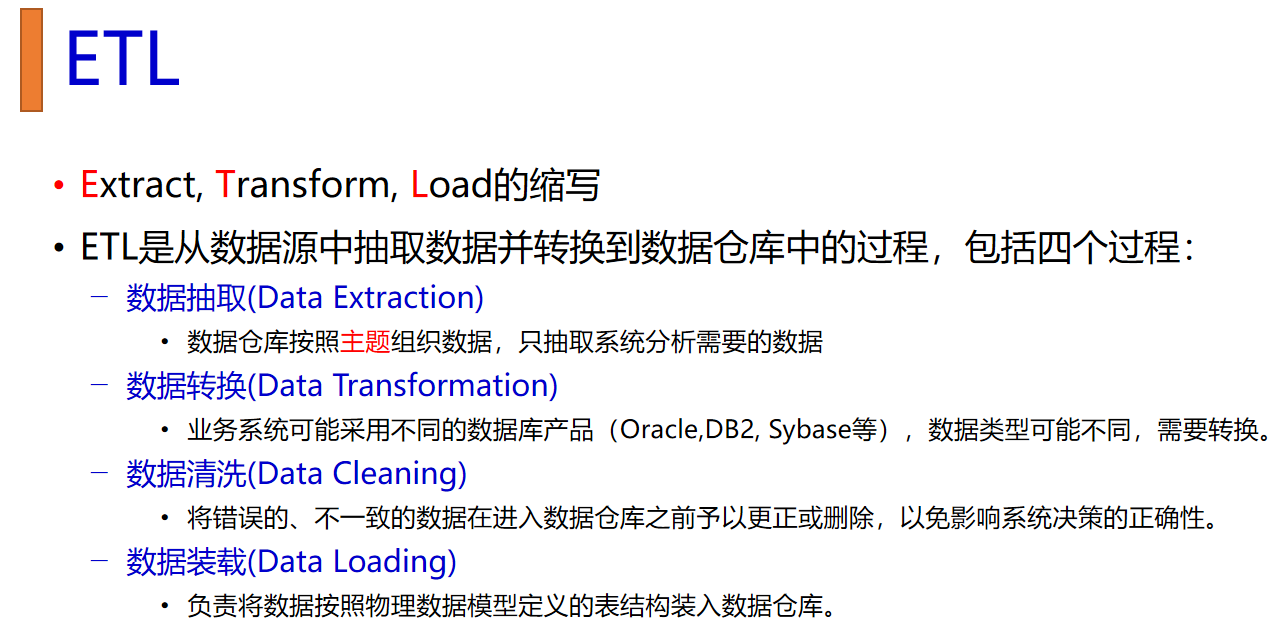

二、数据仓库

要解决的几个问题:

1.如何从数据库中抽取数据

如果你需要导入的数据量很小(如只有两张表,每张表大约一千行数据),你可能不需要使用Sqoop。Sqoop更适合批量数据传输和数据仓库场景,对于少量数据的导入,可以考虑以下几种简单的替代方法:

直接导出/导入:

使用MySQL的导出工具(例如mysqldump)导出表为SQL文件,然后在Hive命令行界面中运行这些SQL语句。

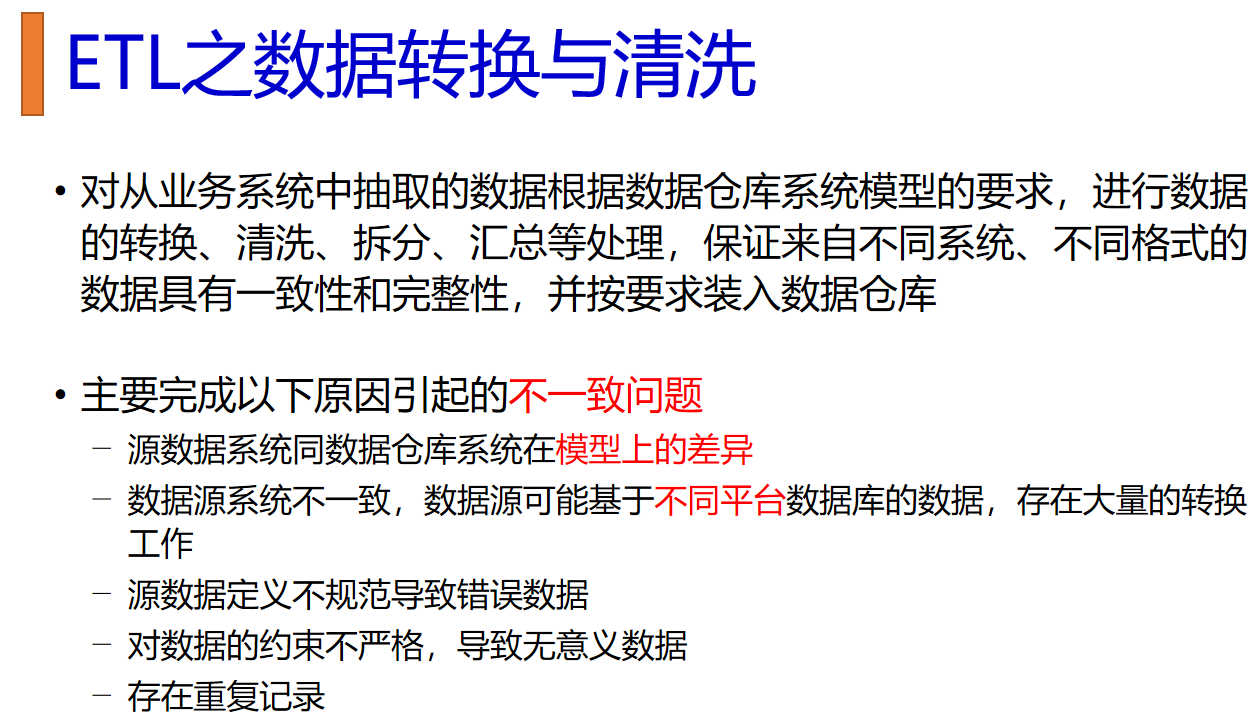

或者,如果数据表结构不复杂,可以将MySQL表数据导出为CSV文件,然后在Hive中创建表,并使用LOAD DATA LOCAL INPATH命令加载CSV文件。2.如何进行数据转换,是否需要数据转换,需要使用什么工具,在哪个步骤中进行转换(是当数据在数据库中,还是要通过别的工具,还是要在数据仓库中转换??)

使用Hive SQL:

你可以编写Hive SQL脚本来进行数据转换。例如,通过CREATE TABLE AS SELECT (CTAS) 语句创建新表,并在这个过程中对数据进行转换。

通过Hive的内置函数或自定义函数(UDF)对数据进行转换。

使用INSERT OVERWRITE 语句将转换后的数据写入到新的表或分区中。

使用ETL工具:

你可以使用ETL(Extract, Transform, Load)工具,如Apache NiFi, Talend, Informatica等,来在数据进入Hive之前进行转换。

这些工具可以帮助你从多种源提取数据,应用复杂的转换逻辑,然后将其加载到Hive数据仓库中。

在Hadoop生态系统中进行转换:

使用如Apache Spark, Apache Pig等其他Hadoop生态系统工具来进行数据的预处理和转换,然后再将数据加载到Hive。编写转换脚本: 可以在IDEA中编写Hive SQL脚本、Spark程序(使用Scala或Python)或其他任何数据处理脚本,这些脚本可以用来进行数据转换。

连接数据库和数据仓库: IDEA支持数据库插件,如Database Navigator或DataGrip功能,可以连接到Hive或其他数据库系统,从而可以直接运行SQL脚本来进行数据转换。3.如何进行数据清洗,是否需要数据清洗,需要使用什么工具,在哪个步骤中进行清洗(是当数据在数据库中,还是要通过别的工具,还是要在数据仓库中转换??)

数据探索与评估: 在开始清洗之前,首先需要对数据进行探索和评估,确定需要进行哪些清洗操作。这一步骤可以通过SQL查询、数据可视化工具或者数据探索工具来完成。

数据清洗操作: 包括但不限于去除重复数据、填充或删除缺失值、标准化数据格式、校验和更正数据错误等。在Hive中,这通常通过编写HiveQL脚本来完成。在数据库中清洗: 如果原始数据已经在Hive或其他数据库中,可以直接在数据库中使用SQL脚本进行清洗。

使用ETL工具: 可以使用ETL工具(如Apache NiFi、Talend、Informatica等)来设计数据清洗流程。

在数据仓库中转换: 有时候,数据在加载到数据仓库之后进行清洗和转换,尤其是在使用Hive这样的大数据平台时。

使用IDEA进行数据清洗: 可以在IntelliJ IDEA中编写HiveQL脚本或Spark程序来进行数据清洗,然后将这些脚本运行在Hive上。4.如何进行数据装载,如何将数据库中的数据导入数据仓库?是通过某种工具,还是通过IDEA这类编译器编写代码脚本的方式?

使用HiveQL命令:可以使用Hive提供的HiveQL命令来装载数据,这些命令可以在Hive的CLI(命令行界面)、通过Beeline客户端、或者在任何支持Hive连接的IDE中执行。例如,可以使用LOAD DATA命令来将数据从本地文件系统或者Hadoop的HDFS导入Hive表中。

-- 将本地文件系统中的数据导入Hive表

LOAD DATA LOCAL INPATH '/path/to/local/data.txt' INTO TABLE your_table;

-- 将HDFS中的数据导入Hive表

LOAD DATA INPATH '/path/to/hdfs/data.txt' INTO TABLE your_table;

关于使用IDEA进行数据装载,IntelliJ IDEA是一个集成开发环境,它支持连接Hive,并可以执行HiveQL脚本。你可以通过在IDEA中配置Hive连接,然后在SQL脚本编辑器中编写并执行HiveQL命令来进行数据装载。以下是在IDEA中进行数据装载的基本步骤:

在IDEA中安装Database Navigator插件或使用已内置的数据库支持功能。

配置Hive连接:你需要提供Hive服务器的JDBC URL、用户名和密码。

打开IDEA的数据库视图,右键点击创建的Hive连接,选择"Console"打开一个新的查询窗口。

在查询窗口中编写上述提到的LOAD DATA命令,并执行。5.如何在数据仓库中建表,导入的数据在数据仓库中是一种怎么样的组织形式?

创建表的步骤:

打开Hive的CLI(命令行界面),Beeline客户端,或者任何支持Hive连接的IDE(如IntelliJ IDEA)。

使用CREATE TABLE语句定义表的结构,包括列名和数据类型。

可以指定表的存储格式(如TEXTFILE、SEQUENCEFILE、ORC、PARQUET等)和位置(HDFS上的路径)。

可以为表设置分区(PARTITIONED BY)和桶(CLUSTERED BY)等属性来优化查询性能和数据组织。

CREATE TABLE IF NOT EXISTS my_table (

id INT,

name STRING,

age INT,

created_at TIMESTAMP

)

COMMENT 'This is a sample table'

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

STORED AS TEXTFILE

LOCATION '/user/hive/warehouse/my_database/my_table';

TEXTFILE:默认格式,以纯文本形式存储数据,字段通常由特定分隔符(如逗号或制表符)分隔。

SEQUENCEFILE:二进制格式,适用于键值对数据,可以压缩。

ORC (Optimized Row Columnar):高效的列存储格式,适合大型数据集,支持高度压缩和快速读取。

PARQUET:另一种列式存储格式,广泛用于Hadoop生态系统。

6.如何对数据仓库中的数据进行可视化?是通过某种工具还是?

BI工具集成:

有许多商业智能(BI)工具可以连接到Hive并对其数据进行可视化,这些包括但不限于:

Tableau

Power BI

QlikView

Looker

Apache Superset

这些工具通常提供了一个用户友好的界面,通过JDBC或ODBC驱动与Hive进行交互,并且允许用户创建图表、报表和仪表板。

数据分析平台:

一些数据分析平台如Zeppelin或Jupyter Notebook可以与Hive直接交互,允许用户写Hive查询并利用Python、R等语言中的可视化库(如matplotlib、seaborn、ggplot2等)来展示结果。

Hadoop生态集成工具:

Hue:Hue是一个开源的SQL助手,为Hive提供了一个易于使用的Web界面,可以执行查询并查看结果。Hue也有基本的图表和可视化功能。

Apache Drill:可以通过SQL查询Hive和其他数据源,并且与BI工具集成,提供数据可视化能力。

自定义应用程序:

可以使用各种编程语言(如Java、Python、Scala等)通过Hive的JDBC或Thrift API连接到Hive,执行查询并获取数据。然后,可以使用图形库(如Python中的matplotlib或JavaScript中的D3.js)来创建自定义的可视化。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!