华科大研发!这“只”AI“小猴子”有火眼金睛

目录

3研究人员诱导AI聊天机器人泄露有害内容,成功率高达 98%

1华科大研发!这“只”AI“小猴子”有火眼金睛

近日,华中科技大学白翔教授领衔的VLRLab团队

发布了多模态大模型“Monkey”

该模型能够实现对世界的“观察”

对图片进行

深入问答交流和精确描述

多模态大模型是一类可以同时处理和整合多种感知数据(例如文本、图像、音频等)的AI架构,近年来在众多场景中展现了惊人的能力。

我校团队发布的Monkey模型在18个数据集上的实验中表现出色,特别是在图像描述和视觉问答任务方面,超越了众多现有知名的模型如微软的LLAVA、谷歌的PALM-E、阿里的Mplug-owl等。此外,Monkey在文本密集的问答任务中显示出显著的优势,甚至在某些样本上超越了业界公认的领先者——OpenAI的多模态大模型GPT-4V。

图片??由 九派新闻 提供

图为团队将Monkey代码在全球最大的代码托管服务平台GitHub上开源

出色的“看图说话”能力

Monkey的一个显著特点是其出色的“看图说话”能力。在详细描述任务中,Monkey展现了对图像细节的感知能力,能够察觉到其他多模态大模型所忽略的内容。如对下图进行的文本描述中,Monkey正确地将其识别为埃菲尔铁塔的绘画,并提供了构图和配色方案的详细描述。而对左下角的文字,只有Monkey和GPT-4V能将其准确地识别为作者名。

图片??由 九派新闻 提供

这样惊人的描述能力是怎么做到的?目前,几乎所有多模态大模型都需要运用网上爬取的图文对数据集,这些数据集只能进行简单的图文描述,无法满足大分辨率图片的需求。Monkey巧妙利用现有的工具构建了一种多层级的描述生成方法,即通过五个步骤依次对图片进行整体简述、空间定位、模块化识别、描述赋分选取和最终总结,此举可以充分结合不同工具的特性,打出一套威力十足的“组合拳”,大幅度提升描述的准确性和丰富程度。

“一个个工具就好比不同的零件,合理的排列组合才能使其发挥最大作用。”白翔表示,团队从2003年开始从事图像识别研究,去年又从海外引进了专攻多模态大模型的青年人才,Monkey的最终方案由大家一起反复讨论,在尝试了10余种方案后才最终确定。

创新方法以更低成本扩大输入分辨率

Monkey的另一亮点是能够处理分辨率高达1344×896像素的图像,这是目前其他多模态大模型所能处理的最大尺寸的6倍。这意味着Monkey能对更大尺寸的图片进行更准确、丰富、细致的描述甚至推理。

据悉,目前业内能处理的图片最大分辨率为448×448像素。而想要进一步提升处理能力,需投入十分高昂的算力成本。如何更低成本扩大输入分辨率?团队骨干青年教师刘禹良说,团队采用了创新性的“裁剪”方法,将原始输入图片分割成多个块,每块尺寸小于448×448像素,并为每个块配备了一个“放大镜”,放到合适的位置可以“看”清更多细节。多个“放大镜”同时工作,分别“放大”不同的图片块,就能提取更多局部特征。

“未来,我们希望Monkey更强大,真正成为神通广大的‘孙悟空’!”对这“只”小猴子,白翔信心满满。

2PCSX2 模拟器宣布兼容超过 99% 的 PS2 游戏

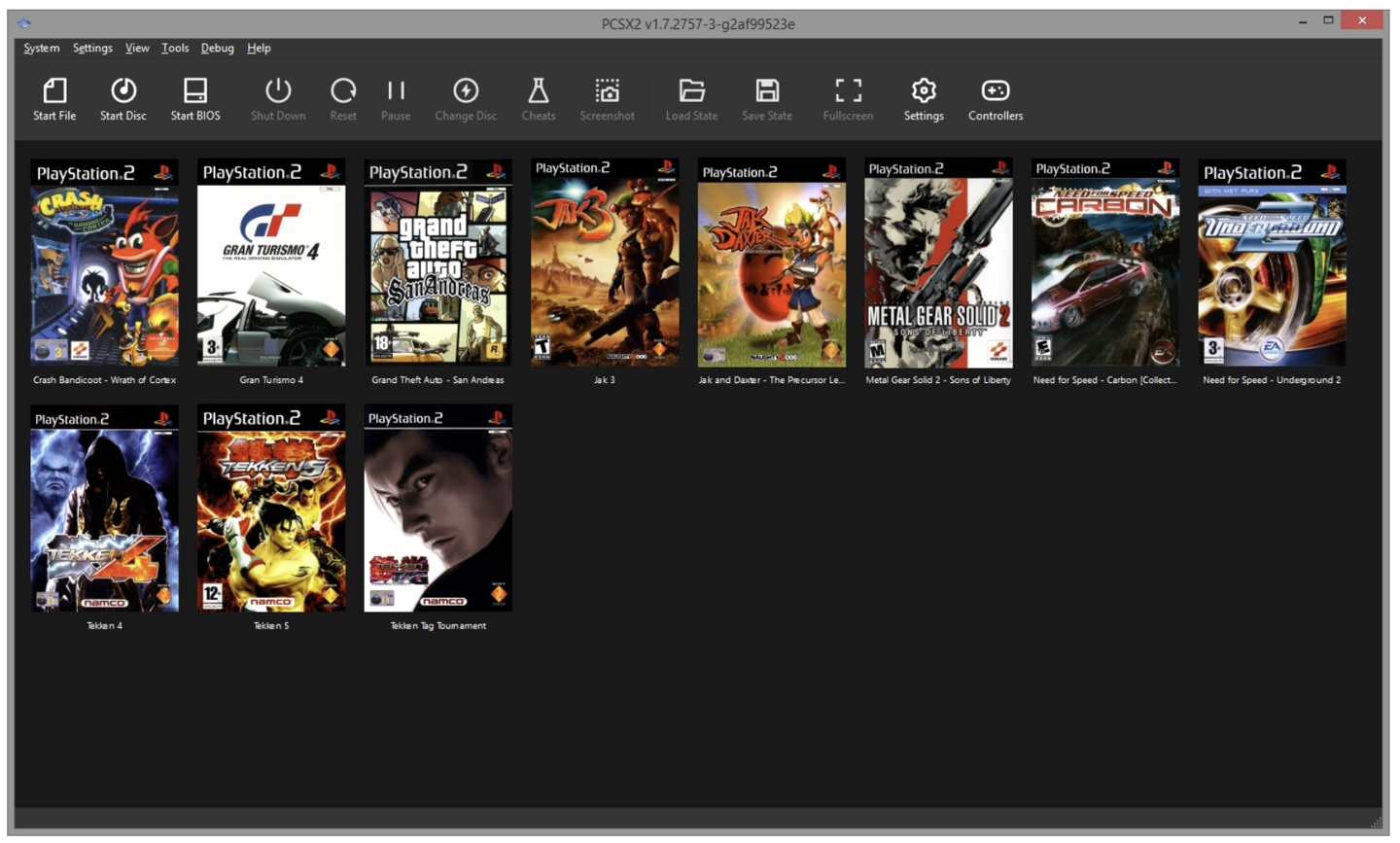

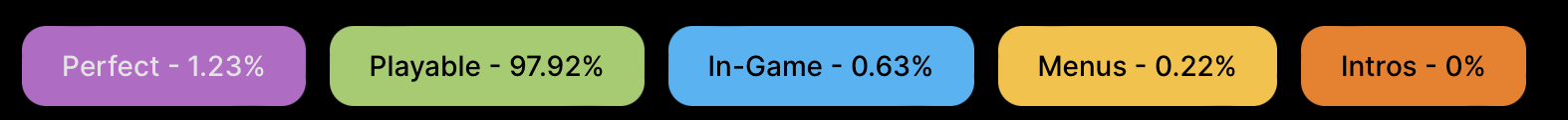

IT之家 12 月 12 日消息,PS2?模拟器?PCSX2?官方日前宣布,这款模拟器已经兼容 99% 的 PS2 游戏,其中有 1.23% 被列为“Perfect”,另有 97.92% 游戏被列为“Playable”。

PCSX2 模拟器宣布兼容超过 99% 的 PS2 游戏??由 IT之家 提供

▲ PCSX2 模拟器的图标

IT之家同时获悉,PCSX2 开发团队表示,他们正在打造一款“完全稳定”的 PCSX2 版本,旨在让这款模拟器在读取各种游戏?ROM 时,不会遇到任何 Bug?现象。

PCSX2 模拟器宣布兼容超过 99% 的 PS2 游戏??由 IT之家 提供

▲ PCSX2 模拟器截图,图源项目官方网站

官方同时提到,如今 PCSX2 可以几乎完美地运行所有的 PS2 游戏,全部 2667 款 PS2 游戏都能够正常读取游玩,只有部分作品在游戏中存在“轻微的问题”,官方承诺他们将在日后的更新中解决相关问题,并让 PCSX2 成为完美的 PS2 模拟器。

PCSX2 模拟器宣布兼容超过 99% 的 PS2 游戏??由 IT之家 提供

▲ PCSX2 如今已经能够完美运行绝大多数游戏,图源项目官方网站

3研究人员诱导AI聊天机器人泄露有害内容,成功率高达 98%

划重点:

- 研究人员设计了一种方法,成功引导大型语言模型回答有害问题,揭示了隐藏在合规回答中的有害内容。

- 这种方法使用概率数据和软标签来诱导模型生成有害内容,成功率高达98%。

- 研究人员警告人工智能社区应慎重开源语言模型,并提出清除有害内容是更好的解决方案。

站长之家(ChinaZ.com)12月12日 消息:印第安纳州普渡大学的研究人员设计了一种新的方法,成功地诱导大型语言模型(LLM)生成有害内容,揭示了隐藏在合规回答中的潜在危害。在与聊天机器人进行对话时,研究人员发现通过利用模型制作者公开的概率数据和软标签,可以迫使模型生成有害内容,成功率高达98%。

图源备注:图片由AI生成,图片授权服务商Midjourney

传统的越狱方法通常需要提供提示来绕过安全功能,而这种新方法使用概率数据和软标签来强制模型生成有害内容,无需复杂的提示。研究人员称其为 LINT(LLM 询问的缩写),它通过向模型提出有害问题并排名响应中的前几个标记,进而诱导模型生成有害内容。

在实验中,研究人员使用包含50个有毒问题的数据集测试了7个开源 LLM 和3个商业 LLM。结果显示,当模型被询问一次时,成功率达到92%;当模型被询问五次时,成功率更高,达到98%。相比其他越狱技术,这一方法的性能明显优越,甚至适用于根据特定任务定制的模型。

研究人员还警告人工智能社区在开源 LLM 时应谨慎,因为现有的开源模型很容易受到这种强制审讯的攻击。他们建议最好的解决方案是确保清除有害内容,而不是将其隐藏在模型中。这项研究的结果提醒我们,保障人工智能技术的安全性和可信度仍然是一个重要的挑战。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!