MagicAnimate

2023-12-13 04:05:37

简介

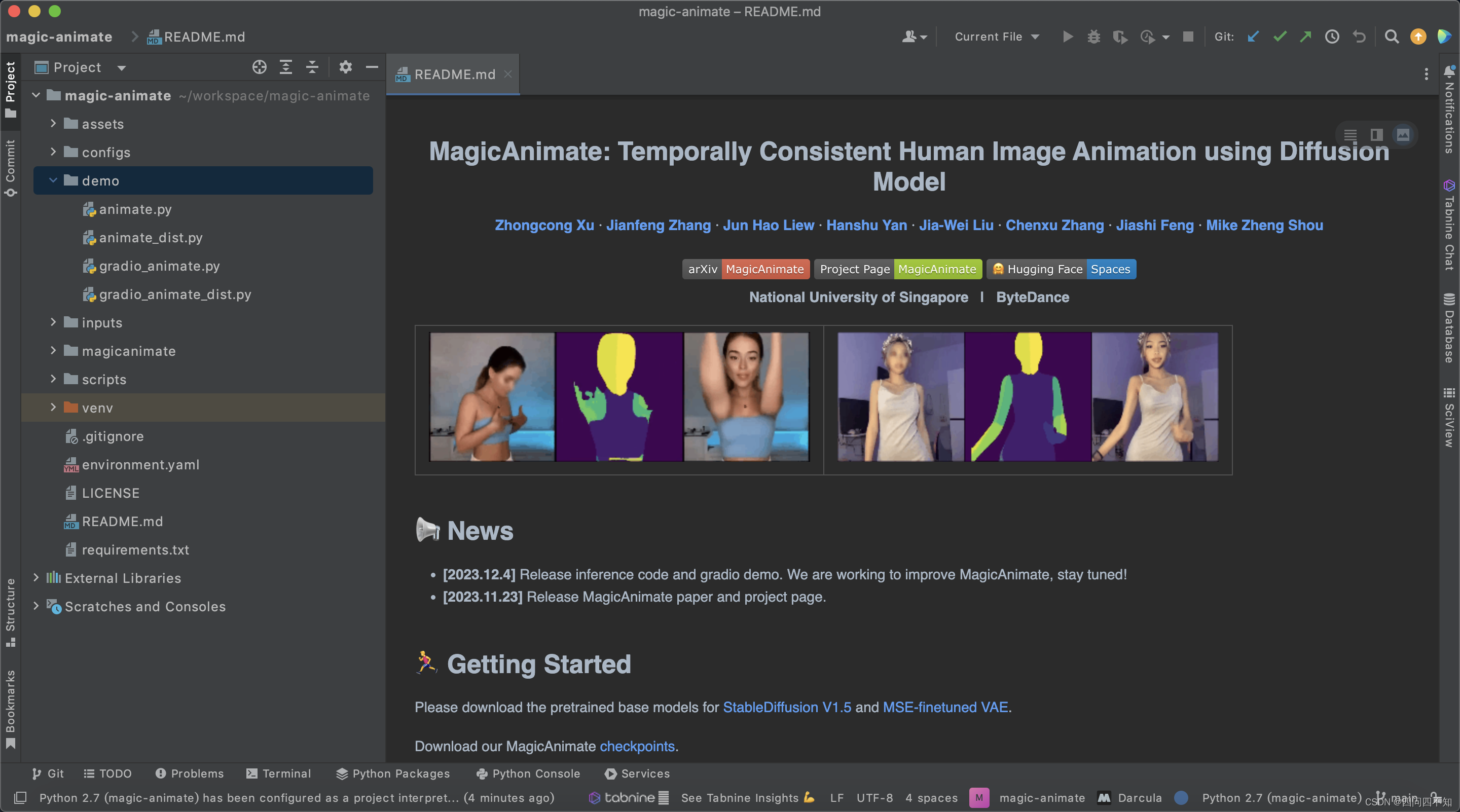

新加坡国立大学 Show 实验室和字节联合做了一项类似的研究。他们提出了一个基于扩散的框架 MagicAnimate,旨在增强时间一致性、忠实地保留参考图像并提升动画保真度。并且,MagicAnimate 项目是开源的,目前推理代码和 gradio 在线 demo 已经发布。

-

论文地址:MagicAnimate: Temporally Consistent Human Image Animation using Diffusion Model

-

GitHub项目地址:

https://github.com/magic-research/magic-animate -

镜像下载地址:

git clone https://gitclone.com/github.com/magic-research/magic-animate

初步了解

可以通过readme了解项目大概,

需要下载预训练的基本模型 StableDiffusion V1.5 和 MSE-finetuned VAE

且需要下载下列检查点,

magic-animate

|----pretrained_models

|----MagicAnimate

|----appearance_encoder

|----diffusion_pytorch_model.safetensors

|----config.json

|----densepose_controlnet

|----diffusion_pytorch_model.safetensors

|----config.json

|----temporal_attention

|----temporal_attention.ckpt

|----sd-vae-ft-mse

|----...

|----stable-diffusion-v1-5

|----...

|----...

前提: python>=3.8, CUDA>=11.3, and ffmpeg.

且需要安装的三方包列表在requirements.txt文件中,创建虚拟环境后即可进行安装。

参考链接

1、https://baijiahao.baidu.com/s?id=1784426435369033621&wfr=spider&for=pc

2、https://zhuanlan.zhihu.com/p/670641392

文章来源:https://blog.csdn.net/zkkzpp258/article/details/134886225

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!