(超详细)YOLOV5改进-添加SimAM注意力机制

2024-01-10 12:43:09

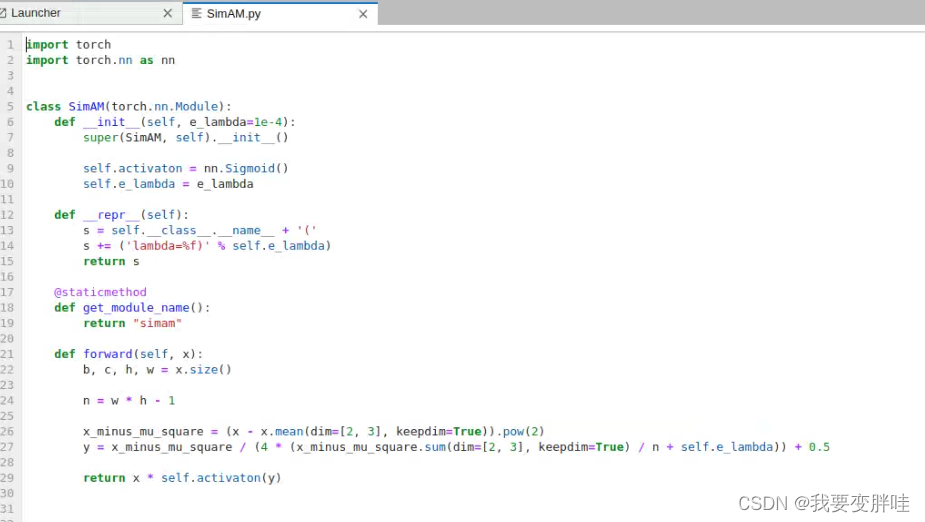

1、在yolov5/models下面新建一个SimAM.py文件,在里面放入下面的代码

代码如下:

import torch

import torch.nn as nn

class SimAM(torch.nn.Module):

def __init__(self, e_lambda=1e-4):

super(SimAM, self).__init__()

self.activaton = nn.Sigmoid()

self.e_lambda = e_lambda

def __repr__(self):

s = self.__class__.__name__ + '('

s += ('lambda=%f)' % self.e_lambda)

return s

@staticmethod

def get_module_name():

return "simam"

def forward(self, x):

b, c, h, w = x.size()

n = w * h - 1

x_minus_mu_square = (x - x.mean(dim=[2, 3], keepdim=True)).pow(2)

y = x_minus_mu_square / (4 * (x_minus_mu_square.sum(dim=[2, 3], keepdim=True) / n + self.e_lambda)) + 0.5

return x * self.activaton(y)

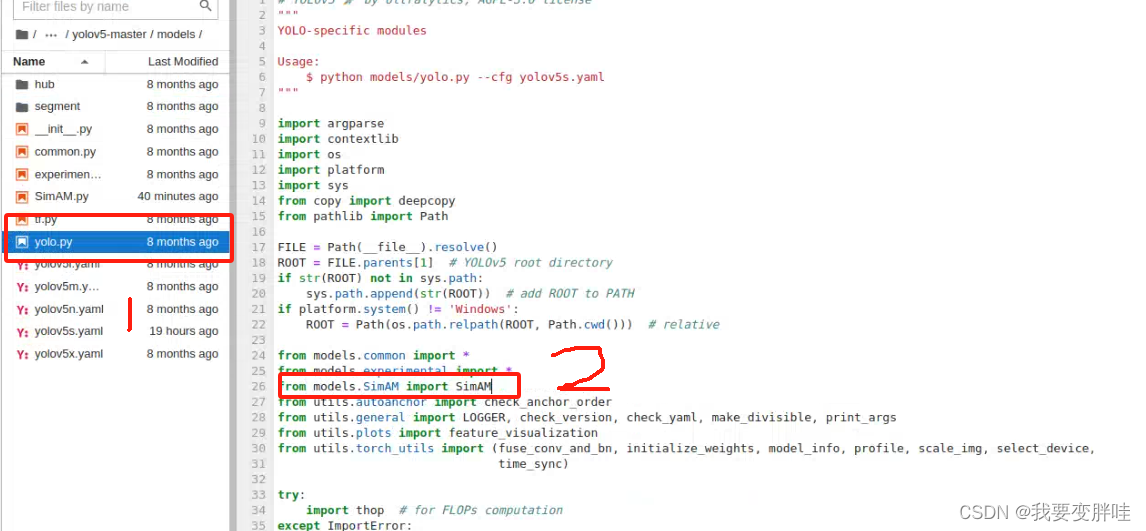

2、找到yolo.py文件,进行更改内容

在26行加一个from models SimAM import SimAM, 保存即可

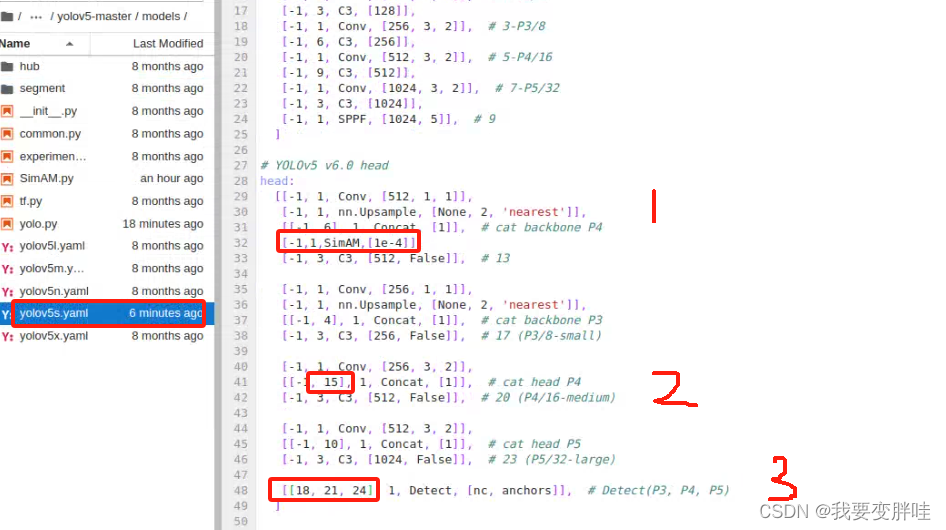

3、找到自己想要更改的yaml文件,我选择的yolov5s.yaml文件(你可以根据自己需求进行选择),将刚刚写好的模块SimAM加入到yolov5s.yaml里面,并更改一些内容。更改如下

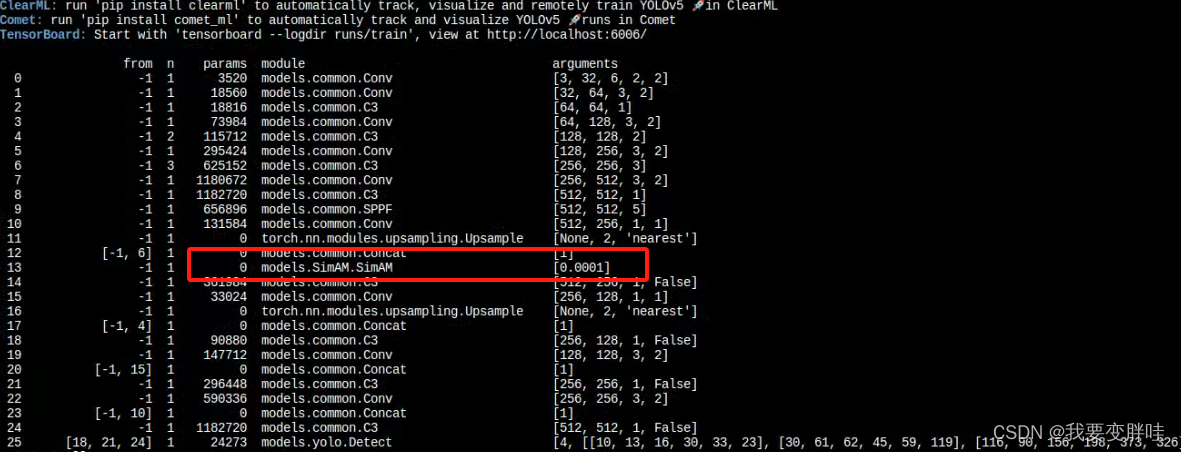

运行一下,发现出来了SimAM

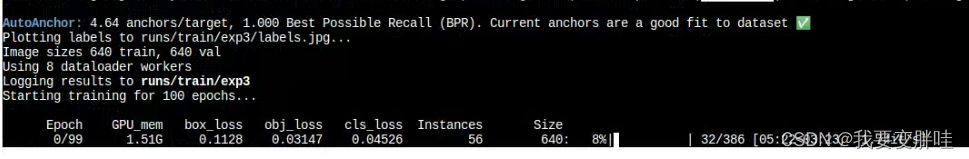

结果还没出来呢,还在跑,

跑100个epoch,还不知道跑到啥时候哈哈哈哈!结果后放!

文章来源:https://blog.csdn.net/qq_44421796/article/details/135497544

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!